teoricas

Anuncio

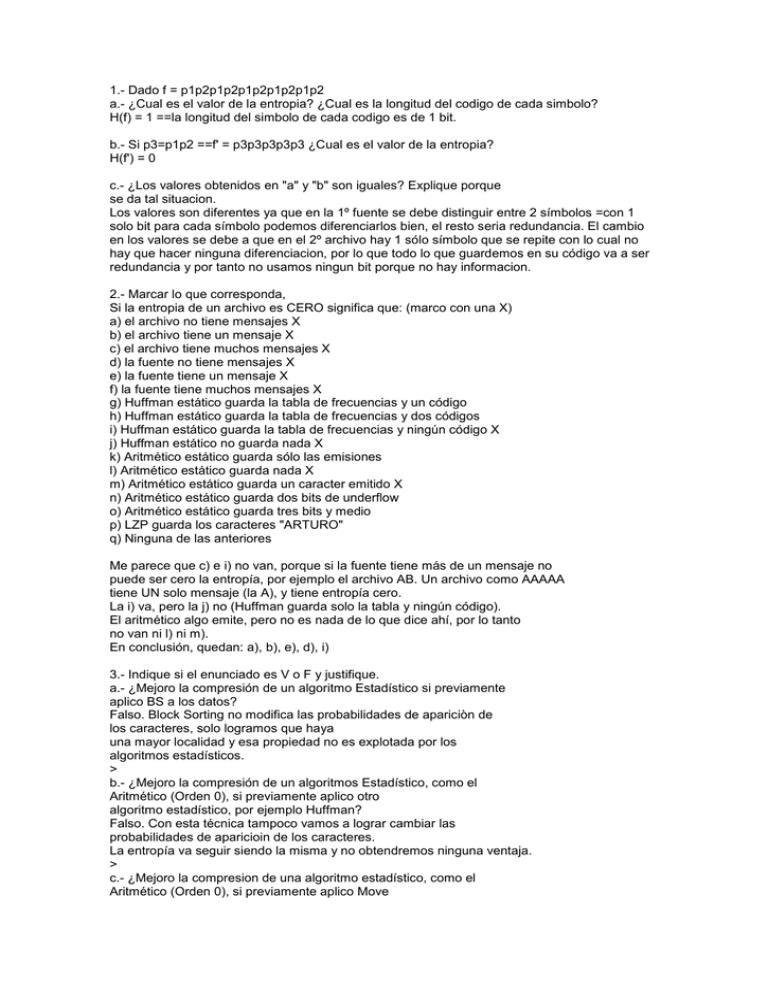

1.- Dado f = p1p2p1p2p1p2p1p2p1p2 a.- ¿Cual es el valor de la entropia? ¿Cual es la longitud del codigo de cada simbolo? H(f) = 1 ==la longitud del simbolo de cada codigo es de 1 bit. b.- Si p3=p1p2 ==f' = p3p3p3p3p3 ¿Cual es el valor de la entropia? H(f') = 0 c.- ¿Los valores obtenidos en "a" y "b" son iguales? Explique porque se da tal situacion. Los valores son diferentes ya que en la 1º fuente se debe distinguir entre 2 símbolos =con 1 solo bit para cada símbolo podemos diferenciarlos bien, el resto seria redundancia. El cambio en los valores se debe a que en el 2º archivo hay 1 sólo símbolo que se repite con lo cual no hay que hacer ninguna diferenciacion, por lo que todo lo que guardemos en su código va a ser redundancia y por tanto no usamos ningun bit porque no hay informacion. 2.- Marcar lo que corresponda, Si la entropia de un archivo es CERO significa que: (marco con una X) a) el archivo no tiene mensajes X b) el archivo tiene un mensaje X c) el archivo tiene muchos mensajes X d) la fuente no tiene mensajes X e) la fuente tiene un mensaje X f) la fuente tiene muchos mensajes X g) Huffman estático guarda la tabla de frecuencias y un código h) Huffman estático guarda la tabla de frecuencias y dos códigos i) Huffman estático guarda la tabla de frecuencias y ningún código X j) Huffman estático no guarda nada X k) Aritmético estático guarda sólo las emisiones l) Aritmético estático guarda nada X m) Aritmético estático guarda un caracter emitido X n) Aritmético estático guarda dos bits de underflow o) Aritmético estático guarda tres bits y medio p) LZP guarda los caracteres "ARTURO" q) Ninguna de las anteriores Me parece que c) e i) no van, porque si la fuente tiene más de un mensaje no puede ser cero la entropía, por ejemplo el archivo AB. Un archivo como AAAAA tiene UN solo mensaje (la A), y tiene entropía cero. La i) va, pero la j) no (Huffman guarda solo la tabla y ningún código). El aritmético algo emite, pero no es nada de lo que dice ahí, por lo tanto no van ni l) ni m). En conclusión, quedan: a), b), e), d), i) 3.- Indique si el enunciado es V o F y justifique. a.- ¿Mejoro la compresión de un algoritmo Estadístico si previamente aplico BS a los datos? Falso. Block Sorting no modifica las probabilidades de apariciòn de los caracteres, solo logramos que haya una mayor localidad y esa propiedad no es explotada por los algoritmos estadísticos. > b.- ¿Mejoro la compresión de un algoritmos Estadístico, como el Aritmético (Orden 0), si previamente aplico otro algoritmo estadístico, por ejemplo Huffman? Falso. Con esta técnica tampoco vamos a lograr cambiar las probabilidades de aparicioin de los caracteres. La entropía va seguir siendo la misma y no obtendremos ninguna ventaja. > c.- ¿Mejoro la compresion de una algoritmo estadístico, como el Aritmético (Orden 0), si previamente aplico Move To Front? Verdadero. Puede ser que se modifique la entropía ya que la probabilidad de aparición de alguno de los nros sea muchísimo mayor que la de los otros. > 4.- a) ¿Por qué usamos la base 2 en el logaritmo que define la cantidad de información? Usamos base 2 porque usamos un sistema binario pra representar la información que tenemos. > b) ¿Por qué la entropía es generalmente no luna? Si es nula ¿por qué razón es? La entropía es generalmente no luna porque en una fuente la mayoría de las veces tenemos mas de un símbolo, por lo tanto, aunque sea poca, algo de información necesitamos para diferenciarlos. Para que la entropía sea nula pueden darse 2 situaciones mutuamente excluyentes: 1) que la fuente no contenga mensajes, es decir, un archivo vacío. Con lo cual, las frecuencias de todos los símbolos va a ser igual a 0. 2)que la fuente contenga un mensaje (o varios mensajes) compuesto por la repetición de un mismo símbolo y, por lo tanto, con probabilidad de aparición 1 ==log2(1) = 0 ==H(f) = 0.> > c) ¿Cuál es el número mínimo (e inteligente) de preguntas que hay que hacer para pasar de la incertidumbre a la certeza en un sistema de n estados equiprobables?¿Y si no son equiprobables? La verdad no entiendo a que se refiere la pregunta... podrias aclararme a que apunta? Si no es mucha joda me darias la respuesta? > 5.- Si tengo 3 archivos comprimidos con PPMC, uno tiene 5 instancias inicializadas en el 2º orden (es el mayor contexto utilizado), otro tiene 3 y el 3º tiene 2. ¿Cuál fué comprimido con mejor resultado? Explique su respuesta y de un ejemplo del mejor caso donde muestre como comprime. ¿Si en lugar de PPMC hablamos de un LZ77, que valor deberían tener sus parámetros para que funcione de la mejor manera posible con el ejemplo que propuso? Funcionará mejor el que menos instancias tenga inicializadas en el 2º contexto (en este caso el 3º archivo) porque eso quiere decir (suponiendo que la longitud de los archivos es igual para todos) que se repite un mismo para de caracteres "n" veces, y esto es mojor que que se repita un trio o una quintupla de caracteres porque de ser asi el algoritmo "aprende" mas lento. por ejemplo podemos tener: f1 = abcdeabcde f2 = abcabcabca f3 = ababababab > PPMC va a "aprender" mucho mas rápido con el último archivo y lo va a comprimir mejor porque hay menos contextos de orden 2. Para que f3 también se el que mejor funcione con LZ77 las ventanas tendrían que ser de 2 caracteres y la longitud mínima de match también de 2 caracteres. A raíz de esto, a los 2 primeros archivos no se los podrá comprimir, mientras que al último si, y de buena manera, ya que al principio emitirá los caracteres a y b y luego siempre pares de posición - longitud. > 6.- Responder V o F, justificando en ambos casos: a.- En la compresión por Huffman estático, si un símbolo tiene código de longitud 1 necesariamente el resto de los símbolos tienen códigos de longitud 2 o más. Verdadero. Como Huffman genera códigos prefijos, si hay 1 código de longitud 1 los otros deben ser sí o sí de longitud 2 o más porque sino obligatoriamente los códigos de longitud mayor a 1 empezarán con alguno de los códigos de longitud 1 y así se dejarían de generar códigos prefijos. La única excepción es cuando solo se deben codificar sólo 2 símbolos. > b.- La compresión aritmética de un archivo siempre es mejor que a la compresión del mismo por Huffman. Verdadero. La compresión aritmética es la que mas cerca esta de acercarse al valor de la entropía, por lo tanto, siempre comprime mejor que Huffman. > 7.- Responder V o F, justificando la respuesta. a.- BS rompe con los contextos de la fuente. Verdadero. No nos quedamos con la fuente original sino con la última columna luego de ordenar alfabéticamente las filas de la matriz resultante. > b.- Cuando los símbolos a codificar tiene un código de la misma longitud, el código Huffman es el más eficiente de los códigos de descodificación única. No entiendo bien esta pregunta. Podrías explicarmela? > c.- Todo código fuente de longitud fija es unívocamente decodificable. Verdadero. No hay ambiguedades entre los códigos y ningún código está compuesto por la concatenación de uno o más códigos pertenecientes al mismo conjunto. > 8.- En uno de los examenes vi que pedían estimar la cantidad de bits utilizados para la compresión de un archivo con PPMC de orden 2. ¿Como se realiza dicha estimación? > 9.- Este ejercicio lo encontre en un parcial que tomaron en febrero y la verdad no lo entiendo, no se a que apunta... > Debido a un error de programación, se comprimió un archivo de 4 caracteres con la siguiente tabla de frecuencias: A: 15, C: 5, R: 5, U: 5 El número obtenido por la compresión es:80/144 = 0.5 periódico a) ¿Cuál es el archivo descomprimido? b) ¿Cuál es la relación entre la probabilidad de cada caracter y los bits utilizados para su compresión? > Podría usarse Huffman estático para realizar la descompresión???? La verdad es lo único que se me ocurre porque es el único método que guarda la tabla de frecuencias... Supongo que sí podes usar H.E. para descomprimir, usando la tabla que te dan. Tenés que tener en cuenta que son 4 caracteres nada mas los que tenes que descomprimir (ahi dice que por un error se uso una tabla que tiene un total de 30).