Desarrollo de modelos predictivos y una aplicación móvil para la

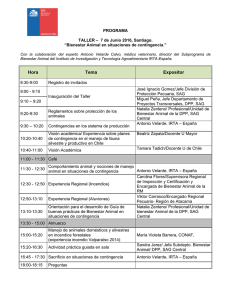

Anuncio