APÈNDIX (*).- AMPLIACIÓ D´ALGUNS CONCEPTES

Anuncio

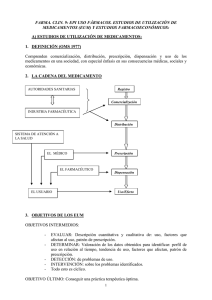

APÈNDIX (*).- AMPLIACIÓ D´ALGUNS CONCEPTES FONAMENTALS QUE S´HAN MENCIONAT A LES CLASSES.- D´aquest document acostumo a posar algunes preguntes a examen referides sobre tot a les definicions i manera de calcular-los. INDEX.- EN RELACIÓ A LA UTILITZACIÓ DE MESURES TERAPÈUTIQUES: 1.-DOSI DIÀRIA DEFINIDA 2.-EFECTIVITAT 3.-NOMBRE DE PACIENTS A TRACTAR EN RELACIÓ A LA RELLEVÀNCIA D´UN TEST DIAGNÒSTIC 4.- VALIDES 5.-BIAIX (“SESGO”) 6.-FIABILITAT (*) A partir de: Graf von Schulenburg JM, kielhorn A., Antoñanzas F. Manual de Economia de la Salud. Glxo Smith Kline. Madrid 2002. EN RELACIÓ A LA UTILITZACIÓ DE MESURES TERAPÈUTIQUES: 1.-DOSI DIÀRIA DEFINIDA El método de la Dosis Diaria Definida (DDD) y el sistema de clasificación Anatómica Terapéutica y Química (“ATC’) fueron establecidos en Noruega a comienzo de los años setenta como útiles de trabajo para la investigación de la utilización de fármacos y para comparar su consumo. Con la DDD se puede calcular aproximadamente el número de personas que están sometidas a la acción de un determinado fármaco o de un tipo de fármaco. En el sistema de clasificación ‘ATC” se clasifican los fármacos en cinco grupos, en función del órgano o del sistema corporal en el que actúan y de acuerdo con sus propiedades terapéuticas, farmacológicas y químicas. La OMS ha adoptado los sistemas DDD y “ATC” como idóneos para el estudio global del consumo de fármacos. La utilización de un fármaco se suele expresar en función de la DDD por 1000 habitantes y día; así se pueden establecer comparaciones entre diversos paises o regiones. En el ámbito hospitalario, la utilización de fármacos se expresa como DDD por 100 camas y día, y en función del índice de ocupación. En el ejemplo anterior, se ha empleado la DDD para comparar el consumo de antibióticos, analgésicos y antihipertensivos en cuatro países europeos. En los resultados se pone de manifiesto que Francia es el país donde el consumo de todos ellos es mayor y, además, que el de antihipertensivos es mayor que el de antibióticos y el de analgésicos. La DDD resulta útil para describir y comparar las pautas de consumo de fármacos, para obtener datos básicos para el cálculo de los índices de reacciones farmacológicas adversas, para llevar a cabo desde una perspectiva epidemiológica la detección sistemática de problemas relativos a la utilización de los fármacos y para comprobar los efectos que se logran mediante actividades informativas y legislativas. Esta metodología resulta útil en los casos en que, en diversos niveles de la cadena sanitaria, se realizan trabajos en los que se emplean datos estadísticos de fácil obtención sobre fármacos. Como unidad de medida normalizada, gracias a la DDD se pueden realizar comparaciones entre fármacos de la misma clase terapéutica y entre diferentes ámbitos de la atención sanitaria o zonas geográficas y determinar las tendencias a lo largo del tiempo. Además, resulta relativamente sencilla de calcular y barata en términos de consumo de recursos administrativos. No obstante, el método de la DDD tiene importantes inconvenientes. La DDD no es la dosis recomendada, sino una unidad técnica comparativa. Y dado que se basa en el empleo que tienen los medicamentos en los paises nórdicos, la DDD puede ser mayor o menor, en comparación con la de otros países. Además, a muchos fármacos que no se utilizan en los países nórdicos no se les ha asignado la correspondiente DDD, si bien la OMS, a través de su Centro de Metodología Estadística de Oslo, ha dado normas para determinarla en estos casos. Igualmente, surgen problemas cuando las dosis son muy distintas (como sucede con las de los antibióticos) o cuando se emplea un fármaco para más de una indicación principal (así, por ejemplo, se utilizan pequeñas dosis de ácido acetilsalic(lico para evitar acontecimientos cardíacos, dosis moderadas para el tratamiento del dolor y dosis elevadas para el de enfermedades inflamatorias). En esta metodología tampoco se tienen en cuenta las dosis que se emplean en niños, lo cual puede inducir a que se infravalore la utilización de fármacos en estapoblación. Además, en las DDD tampoco se tiene en cuenta el grado de cumplimiento del tratamiento por parte del paciente. El sistema “AIC” y el método de la DDD se deben emplear únicamente para estudiar la utilización de fármacos , y no a efectos de precios y de financiación pública ni para valorar la eficacia de los fármacos . Mediante la DDD no es posible inferir el grado de equivalencia terapéutica entre los fármacos de un mismo grupo “ATC”, ni la duración y la eficacia de un tratamiento o los resultados sanitarios que con él se logran. No obstante, en algunos países (como Dinamarca, Holanda, Portugal, España y Suiza) se han utilizado inadecuadamente estos sistemas - tanto por parte de las autoridades sanitarias y de los comités de selección de fármacos, así como en los formularios de los hospitales - a la hora de tomar decisiones para la fijación de precios o la financiación pública y para llevar a cabo la sustitución de un fármaco por otro de la misma clase. Bibliografía ATC index with 000s. Oslo: World Health Organization Collaborating Centre for Druq Statistics Methodology, 1999 Guidelines for ATC classification and 000 assignment. Oslo: World Health Organization Collaborating Centre for Druq Statistics Methodology, 1998 Speight TM, Holtord NHG. Avery’s drug treatment. 4th edn. Auckland: Adis International Ltd. 1997 Strom B (ed.j. Pharmacoepidemiology. 2nd edn. Chichester: John Wiley a Sons, 1994: 386-7 2.- EFECTIVITAT.- Efectividad: trata de responder a la pregunta: “¿esta medida diagnóstica o terapeutica es útil en la práctica clínica? ¿ Contnbuye a un empleo más eficiente de recursos? Para que se demuestre la efectividad es necesario que existan pruebas de que la intervención resulta más beneficiosa que nociva cuando se lleva a cabo en la circunstancia clínica específica de un determinado paciente. En general, en los ensayos clinicos con distribución aleatoria que se realizan con anterioridad al registro de un producto, se estudia la eficacia de un fármaco para el tratamiento de una enfermedad, en vez de su efectividad. Estos ensayos clínicos suelen ltevarse a cabo en situaciones clínicas atípicas, en comparación con aquéllas en que, en definitiva, se va a emplear el fármaco. El cumplimiento del tratamiento es más estricto en los ensayos clínicos, en los cuales sólo participan pacientes que cumplen unos requisitos concretos (ya sean relativos a la edad, a la enfermedad, etc.), con lo cual la probabilidad de que en ellos se pueda demostrar el beneficio que reporta el fármaco que se está estudiando es mayor, si bien no son reflejo del uso que de él se vaya a hacer en la vida real. La efectividad de una intervención médica en la práctica clínica suele diferir de su eficacia en ensayos clínicos, ya que puede suceder que sólo se cumpla parcialmente el tratamiento, o que no se cumpla; además, el método de selección de pacientes es menos estricto, éstos pueden padecer enfermedades concurrentes y, finalmente, hay que tener en cuenta los efectos que ejerce la medicación concomitante. La efectividad de un tratamiento se puede determinar en estudios de farmacovigilancia, se puede inferir de los resultados obtenidos en los estudios previos a la comercialización del producto (tratando de corregir cualquier sesgo que se haya podido introducir en el diseño del estudio) o bien puede valorarla un grupo de médicos que cuente con gran experiencia acerca del tratamiento. Bibiliografía Gold MR, Siegel JE, Russell IB, et al. Cost-effectiveness in health and medicine. New York: Oxford University Press, 1996 Sloan FA (cdi. Valuing health care -costs, benefits, and effectiveness of pharmaceuticals and other medical technoloçjies. Cambridge: Cambridge University Presa, 1995 Strom B (ed.). PharmacoepidemiOlOgy. 2nd edn. Chichester: John Wiley Et Sons, 1994: 386-7 3.- NOMBRE NECESSARI DE PACIENTS A TRACTAR.- Número necesario de pacientes que han de recibir tratamiento: Cantidad de pacientes a quienes es necesario administrar tratamiento médico con el fin de evitar un resultado final adverso. Matemáticamente se expresa como el inverso de la disminución del riesgo absoluto (es decir, como 1/disminución del riesgo absoluto). Fórmula Disminución del riesgo absoluto (acontecimientos adversos en el grupo de control) — (acontecimientos adversos en el grupo de tratamiento) Disminución del riesgo relativo ((acontecimientos adversos en el grupo de control) — (acontecimientos adversos en el grupo de tratamiento)]/(acontecimientos adversos en el grupo de control) Número necesario de acientes 1/disminución del riesgo absoluto Explicación El número de pacientes a quienes un especialista necesita tratar para evitar que se produzca otro resultado adverso es una medida de la magnitud de los posibles beneficios que reporta un determinado tratamiento. Por ejemplo, en un estudio sobre pacientes diabéticos cuyo seguimiento se ha realizado durante 6,5 años, el 9.6% de los que recibieron el tratamiento habitual sufrieron algún tipo de neuropatía, mientras que, por el contrario, esto sucedió sólo al 2,8% de los que recibieron tratamiento intensivo. La diferencia tuvo significación estadística, pero, en cuanto a la significación clínica se refiere, la diferencia puede expresarse como la disminución del riesgo relativo o del riesgo absoluto. La del riesgo relativo se calcula de la forma siguiente: (9’6 2’8)/9’60%, es decir, 71%. Por tanto, con el tratamiento intensivo se redujo un 71% el riesgo de que experimentaran una neuropatía. Sin embargo, mediante la expresión de la disminución del riesgo relativo no se pueden diferenciar los efectos absolutos del tratamiento (por ejemplo, se conseguiría el mismo resultado si el 96% de los pacientes diabéticos que reciben el tratamiento habitual y el 28% de los que reciben el tratamiento intensivo sufrieran una neuropatía). Por el contrario, mediante la disminución del riesgo absoluto se pueden diferenciar los efectos significativos del tratamiento de los efectos triviales. En el ejemplo anterior, la disminución del riesgo absoluto sería 9’6% - 2,8% = 6,8%. Siguiendo con este ejemplo, el número de pacientes a quienes sería necesario administrar tratamiento es de 15, puesto que el resultado de dividir 1 entre 6’8% es 14,7%. Por tanto, de cada 15 pacientes diabéticos que reciban tratamiento intensivo durante 6’5 años, uno de ellos no experimentará ninguna neuropatía. Habitualmente se lleva a cabo la comparación entre el número de pacientes a quienes es necesario administrar diferentes tratamientos durante diferentes períodos y para diferentes enfermedades, ya que de esta forma es posible determinar qué esfuerzo clínico hay que realizar para evitar un resultado adverso. No obstante, dado que el parámetro del que estamos hablando expresa la magnitud del efecto del tratamiento, en vez de la probabilidad, es preciso especificar cuáles son los intervalos de confianza. Un concepto similar al del número necesario de pacientes que han de recibir tratamiento es el número necesario de pacientes que han de recibir tratamiento para que se produzca un episodio nocivo, es decir, un acontecimiento adverso. Bibliografía Sackett DL, Richardson WS, Rosenberg W, et al. Evidence-bascd medicine -how to practice and teach EBM. New York: Churchill Livirigstone, 1997 Spilker 8. Guide to clinical trials. Philadelphia: Lippincott-Raven, 1996 EN RELACIÓ A LA RELLEVÀNCIA D´UN TEST DIAGNÒSTIC 4.- VALIDESA Validez: En el contexto de los estudios clínicos, epidemiológicos y de Economía de la Salud, se hace distinción entre validez interna y validez externa. La interna está determinada por las circunstancias del propio ensayo, como pueden ser el sesgo de selección o el instrumental empleado. Se dice que existe validez externa cuando se pueden generalizar los resultados del estudio y aplicarlos a la realidad (por ejemplo, en cuanto a la población y el tiempo de tratamiento se refiere). Para expresar la validez de las pruebas diagnósticas para determinar la condición de una enfermedad se emplean los términos sensibilidad” y “especificidad”. Mediante el primero de ellos se específica el porcentaje de pacientes estudiados que, según se ha determinado en una de esas pruebas, están enfermos. Consecuentemente, el hecho de que una prueba tenga una sensibilidad del 80% indica que, por término medio, sólo se ha determinado con exactitud que, de 100 pacientes, 80 están enfermos, mientras que otros 20 serían clasificados, erróneamente, como “sanos”. La especificidad de una prueba indica la proporción de personas sanas que mediante ella se ha determinado correctamente que, en efecto, lo están. A la hora de valorar los instrumentos de medición (que suelen ser cuestionarios), su validez tiene especial importancia. Es decir, que deben reflejar con exactitud aquello que se quiere que quede reflejado en ellos. Por ejemplo, una pregunta relativa al dolor físico debe redactarse de tal forma que los pacientes que lo sufran la respondan afirmativamente, mientras que los que no sufran ese dolor contesten con una negación. Además, hay otros dos tipos de validez: la “validez lógica”, que indica si en el documento se tienen en cuenta todos los puntos de vista que, en opinión de los expertos, sean importantes a efectos de la medición. La “validez del contenido” indica la capacidad de un documento para reflejar todos los tipos de resultados posibles (como, por ejemplo, todos los estados de salud). La “validez del criterio” se determina estableciendo una correlación entre un documento y otro medio de valoración de los mismos aspectos. De esta forma se observa si con dos documentos con los que se supone que se debe evaluar o cuantificar la misma cosa se obtienen realmente resultados similares cuando se emplean al mismo tiempo. La ‘validez discriminante” indica si una prueba tiene capacidad para detectar la más mínima variación que pueda tener significación clínica en los pacientes y entre ellos. Finalmente, la “validez del concepto’, o “validez convergente o divergente”, indica en qué medida una prueba se ajusta a unos conceptos teóricos relativos al fenómeno que se está estudiando; es decir, si en teoría una medida varía con la edad, en cualquier prueba que posea validez conceptual deberá quedar reflejada dicha variacion. Bibliografía Hennekens CH, Buring lE. Epdemiology o medicine. Boston: Litt~e, Brown and Company, 1987: 57-66 Hyland ME. selection of items and avoidance of bias in quality of life scales. Pharmacoeconomics 1993; 1 (3): 182-90 Last JM (cd.). A dictionary of epidemiology. 2nd edn. New York: Oxford University Press, 1988 Selby P. Measuring the quaiity of ife of patients with cancer. In: Walker SR, Rosser RM (eds). Ouality of Iife - assessment and app8cat~on. London: MTP Press Limited, 1988: 181-204 Spifker B. Guide to cIin~caI trials. Philadelphia: Lippincott—Raven, 1996: Ch. 43 5.- BIAIX SESGO: Se entiende por sesgo el error sistemático que se comete al diseñar o realiizar estudios de investigación y que tiene como consecuencia la distorsión de los resultados que se obtienen. Es distinto al error aleatorio, que se produce por casualidad. En cualquier fase de un estudio clínico se puede obtener un resultado sesgado, ya sea como consecuencia de las características del propio estudio o bien de las pruebas realizadas, de las personas que en él participan, del tipo de análisis realizados o la perspectiva desde la que se interpretan los resultados. En el momento de tomar decisiones se puede producir un sesgo en función de la opinión de los expertos, de la experiencia clínica de la persona que ha de tomarlas o de la información que se haya obtenido en la bibliografía consultada. La investigación clínica tiene como objetivo, en este sentido, reducir al máximo o eliminar la posibilidad de que se produzca cualquier sesgo. Para ello se recurre a la aleatorización o reclutamiento sistemático de los pacientes, a ocultar a los pacientes y a los investigadores en qué consiste el tratamiento (véase ensayo clínico), a la normalización de los procesos de medición y a evitar que haya pacientes de los que no se pueda realizar su seguimiento. Cuando no se puede evitar un sesgo, es importante determinar cuál ha sido su origen, ya que, así, se podrá tener en cuenta a la hora de extraer las conclusiones del estudio llevado a cabo. Aunque muchos son los tipos de sesgos que se pueden producir, los principales son los siguientes: Los derivados de los procedimientos de selección y seguimiento de pacientes. Por ejemplo, a desigual retirada de pacientes en los diferentes grupos de tratamiento de un estudio clínico. Si aquellos cuya enfermedad es grave no mejoran y abandonan el estudio, y silos que no están graves mejoran y siguen participando en el estudio, los resultados que se obtengan en éste indicarán, erróneamente, que el tratamiento ha resultado muy eficaz. Los implícitos en la información recibida. Es posible que la información que se recibe de los pacientes esté condicionada en gran medida por las creencias y los valores de éstos. Los inducidos por los observadores. Falta de objetividad de quienes determinan la magnitud de las reacciones o las respuestas de los pacientes. Los inducidos por los entrevistadores, ya que es habitual que sus expectativas condicionen la forma en que se refleja la información que se obtiene. Los que son debidos a factores de confusión, esto es, cuando en la evolución de una enfermedad influyen varias circunstancias que se dan al mismo tiempo. Por ejemplo, cuando se estudia si el virus de la hepatitis B provoca cáncer de hígado, el consumo de alcohol y de tabaco pueden inducir a confusión. Los resultantes de la publicación de trabajos. Es más probable que se publique un trabajo de investigación cuyos resultados tengan significado estadístico que uno cuyos resultados no sean significativos. Tanto los responsables de la atención sanitaria como los directores de revistas consideran que este tipo de sesgo es habitual en los estudios patrocinados por la industria. Bibliografía Drummond MF. A reappraisal of economic evaluation of pharmaceuticals: science or marketing? Pharmacoeconomics 1988; 14 (1): 1-9 Easterbrook Pi. Berlin JA. Gopaian R. et al. Publication blas in clinical research. Lancet 1991; 337: 867-72 Spiiker B. Guide to clinical trials. Philadeiphia: Lippincott-Raven. 1996 Stroni B (ed.). Pharmacoepidemiology. Chichester: John Wiley Ft Sons. 1994: 609-27 2nd edn. 6.- FIABILITAT Se entiende por fiabilidad la capacidad de un documento (por ejemplo, para medir la calidad de vida en relación con la salud) para proporcionar, en condiciones idénticas, resultados reproducibles. Si en evaluaciones reiteradas de pacientes o de personas cuyo estado de salud permanece estable se obtienen, aproximadamente, los mismos resultados en diferentes momentos (análisis de pruebas repetidas), se puede considerar que el instrumento empleado a este efecto resulta fiable. Si, por ejemplo, se obtiene la misma respuesta poco después de que se haya formulado una pregunta sobre las molestias físicas que se sufren al subir unas escaleras, sin que se haya modificado el estado de salud, se considera que dicha afirmación resulta fiable. Otra definición de fiabilidad se refiere a la denominada “coherencia interna” del documento, es decir, al hecho de que ante diferentes preguntas relacionadas con el mismo asunto se reciban respuestas similares. Las preguntas que figuran en el documento se dividen en dos apartados iguales, y, después, se determina estadísticamente qué correlación hay entre las respuestas dadas a las de cada apartado (“fiabilidad de las mitades partidas”). Si hay gran correlación, se asume que el grado de fiabilidad es elevado.