Sota, caballo y rey,Hay comparaciones que no son odiosas,El error

Anuncio

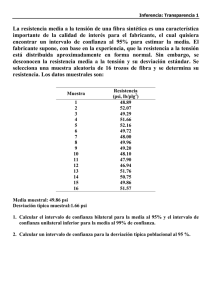

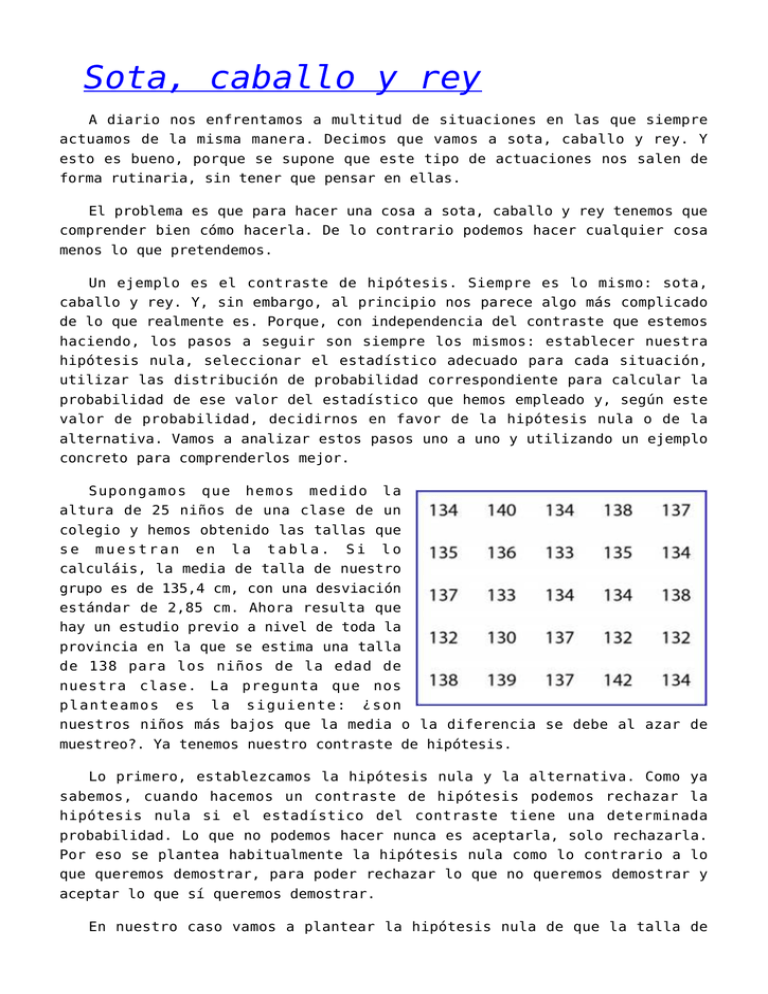

Sota, caballo y rey A diario nos enfrentamos a multitud de situaciones en las que siempre actuamos de la misma manera. Decimos que vamos a sota, caballo y rey. Y esto es bueno, porque se supone que este tipo de actuaciones nos salen de forma rutinaria, sin tener que pensar en ellas. El problema es que para hacer una cosa a sota, caballo y rey tenemos que comprender bien cómo hacerla. De lo contrario podemos hacer cualquier cosa menos lo que pretendemos. Un ejemplo es el contraste de hipótesis. Siempre es lo mismo: sota, caballo y rey. Y, sin embargo, al principio nos parece algo más complicado de lo que realmente es. Porque, con independencia del contraste que estemos haciendo, los pasos a seguir son siempre los mismos: establecer nuestra hipótesis nula, seleccionar el estadístico adecuado para cada situación, utilizar las distribución de probabilidad correspondiente para calcular la probabilidad de ese valor del estadístico que hemos empleado y, según este valor de probabilidad, decidirnos en favor de la hipótesis nula o de la alternativa. Vamos a analizar estos pasos uno a uno y utilizando un ejemplo concreto para comprenderlos mejor. Supongamos que hemos medido la altura de 25 niños de una clase de un colegio y hemos obtenido las tallas que se muestran en la tabla. Si lo calculáis, la media de talla de nuestro grupo es de 135,4 cm, con una desviación estándar de 2,85 cm. Ahora resulta que hay un estudio previo a nivel de toda la provincia en la que se estima una talla de 138 para los niños de la edad de nuestra clase. La pregunta que nos planteamos es la siguiente: ¿son nuestros niños más bajos que la media o la diferencia se debe al azar de muestreo?. Ya tenemos nuestro contraste de hipótesis. Lo primero, establezcamos la hipótesis nula y la alternativa. Como ya sabemos, cuando hacemos un contraste de hipótesis podemos rechazar la hipótesis nula si el estadístico del contraste tiene una determinada probabilidad. Lo que no podemos hacer nunca es aceptarla, solo rechazarla. Por eso se plantea habitualmente la hipótesis nula como lo contrario a lo que queremos demostrar, para poder rechazar lo que no queremos demostrar y aceptar lo que sí queremos demostrar. En nuestro caso vamos a plantear la hipótesis nula de que la talla de nuestros alumnos es igual a la de la media de la provincia y que la diferencia encontrada es debida al error de muestreo, al puro azar. Por otra parte, la hipótesis alternativa plantea que sí existe una diferencia y que nuestros niños son más bajos. Una vez planteadas la hipótesis nula y alternativa tenemos que elegir el estadístico adecuado para este contraste de hipótesis. Este caso es uno de los más sencillos, el de comparación de dos medias, la nuestra y la de la población. En este caso, nuestra media estandarizada respecto a la de la población sigue una distribución t de Student, según la siguiente fórmula que me vais a permitir: t = (media del grupo – media de población) / error estándar de la media Así que sustituimos la media por nuestro valor (135,4 cm), la media poblacional por 138 y el error estándar por su valor (la desviación estándar dividida por la raíz cuadrada del tamaño muestral) y obtenemos un valor de t de -4,55. Ahora tenemos que calcular la probabilidad de que t sea igual a -4,55. Si pensamos un poco veremos que en el caso de que las dos medias fuesen iguales t tendría un valor de cero. Cuánto más distintas sean, más se alejará el valor de t del cero. Nosotros queremos saber si esta desviación, de cero a -4,55, se debe al azar. Para ello calculamos la probabilidad de que t valga -4,55 utilizando una tabla de la distribución de la t de Student o un programa informático, obteniendo un valor de p = 0,0001. Ya tenemos el valor de p, así que solo nos queda el último paso, ver si podemos rechazar la hipótesis nula. El valor de p nos indica la probabilidad de que la diferencia observada entre las dos medias se deba al azar. Como es menor de 0,05 (menor del 5%), nos sentimos lo suficientemente seguros como para decir que no es debida al azar (o, al menos, es muy improbable), así que rechazamos la hipótesis nula de que la diferencia se debe al azar y abrazamos la hipótesis alternativa de que las dos medias son realmente diferentes. Conclusión: nos ha tocado la clase de los más canijos de la provincia. Y esto es todo respecto al contraste de hipótesis de igualdad de dos medias. En este caso hemos hecho una prueba de la t de Student para una muestra, pero lo importante es que os fijéis en la dinámica del contraste de hipótesis. Siempre es la misma: sota, caballo y rey. Lo que cambia, lógicamente, es el estadístico y la distribución de probabilidad que usamos en cada ocasión. Para terminar solo me queda llamar vuestra atención sobre otro método que podríamos haber utilizado para saber si las muestra son diferentes. Este no es más que recurrir a nuestros queridos intervalos de confianza. Podríamos haber calculado el intervalo de confianza de nuestra media y ver si incluía la media de la población, en cuyo caso habríamos concluido que eran similares. Si la media poblacional hubiese estado fuera del intervalo, habríamos rechazado la hipótesis nula, llegando lógicamente a la misma conclusión. Pero esa es otra historia… Hay comparaciones que no son odiosas Suele decirse que las comparaciones son odiosas. Y la verdad es que no es muy conveniente comparar personas o cosas entre sí, ya que cada cual tiene sus valores y no tiene porqué sentirse menospreciado por ser o hacer algo de forma diferente. Así que no es de extrañar que el mismo Quijote dijese que las comparaciones son siempre odiosas. Claro que esto puede referirse a la vida cotidiana, porque en medicina nos pasamos el tiempo comparando unas cosas con otras, a veces de forma más que provechosa. Hoy vamos a hablar de cómo comparar dos distribuciones de datos de forma gráfica y vamos a fijarnos en una aplicación de este tipo de comparaciones que nos sirve para comprobar si nuestros datos siguen una distribución normal. Imaginad por un momento que tenemos una serie de cien valores de colesterol sérico de niños escolares. ¿Qué pasaría si representásemos los valores frente a sí mismos de forma lineal?. Sencillo: el resultado sería una línea recta perfecta que cruzaría la diagonal del gráfico. Ahora pensemos que pasaría si en vez de compararla consigo misma la comparamos con otra distribución diferente. Si las dos distribuciones de datos son muy parecidas, los puntos del gráfico se colocarán muy cerca de la diagonal. Si las distribuciones difieren, los puntos se irán lejos de la diagonal, tanto más lejos cuanto más diferentes sean las dos distribuciones. Veamos algún ejemplo. Supongamos que dividimos nuestra distribución en dos partes, el colesterol de los niños y el de las niñas. Según nos dice nuestra imaginación, nuestros niños comen más bollería industrial que las niñas, así que sus valores de colesterol son mayores, como podéis comprobar si comparáis la curva de las niñas (negro) con la de los niños (azul). Ahora, si representamos los valores de las niñas frente a los de los niños de forma lineal, tal como puede verse en gráfico, los valores se alejan de la diagonal, estando de manera uniforme por encima de ella. ¿Esto a que se debe?. A que los valores de los niños son mayores y diferentes de los de las niñas. Me diréis que todo esto está muy bien pero que puede resultar un poco innecesario. Total, si queremos saber cuáles tienen el valor más alto no tenemos más que mirar las curvas. Y tendréis razón en este caso, pero este tipo de gráficos se ha ideado para otra cosa, que no es otra que para comparar una distribución con su equivalente normal. Imaginad que tenemos nuestra primera distribución y queremos saber si sigue una distribución normal. No tenemos más que calcular su media y su desviación estándar y representar sus quantiles frente a los quantiles de la distribución estándar teórica con la misma media y desviación. Si nuestra distribución es normal, los datos se alinearán cerca de la diagonal del gráfico. Cuanto más se alejen, menos probable será que nuestros datos sigan una distribución normal. Este tipo de gráfico se conoce como gráfico de quantil-quantil o, más comúnmente, por su nombre abreviado en inglés, qq plot. Veamos algún ejemplo de q-q plot para entenderlo mejor. En el segundo gráfico veis dos curvas, una azul que representa una distribución normal y una negra que sigue una t de Student. A la derecha podéis ver el q-q plot de la distribución de la t de Student. Los datos de la parte central se ajustan bastante bien a la diagonal, pero los extremos lo hacen peor, variando la pendiente de la recta. Esto nos indica que hay más datos en las zonas de las colas de los que habría si la distribución fuese normal. Claro que esto no debería extrañarnos, ya que sabemos que las “colas pobladas” son una de las características de la distribución de Student. Por último, en el tercer gráfico veis una distribución normal y su q-q plot, en el que podemos ver cómo los datos se ajustan bastante bien a la diagonal del gráfico. Veis, pues, como el q-q- plot es un método gráfico sencillo para determinar si una distribución de datos sigue una normal. Me diréis que puede resultar un poco latoso calcular los cuantiles de nuestra distribución y los de la normal para poder representar unos frente a otros, pero recordad que la mayor parte de los programas de estadística lo hacen sin esfuerzo. Sin ir más lejos, R tiene una función llamada qqnorm() que dibuja el q-q plot en un parpadeo. Y aquí vamos a dejar los ajustes a la normal por hoy. Recordaos que hay otros métodos más exactos de tipo numérico para saber si los datos se ajustan a la distribución normal, como la prueba de Kolmogorov-Smirnov o la de Shapiro-Wilk. Pero esa es otra historia… El error de la confianza Nuestra vida está llena de incertidumbre. Muchas veces queremos conocer información que está fuera de nuestro alcance, por lo que tenemos que conformarnos con aproximaciones. El problema de las aproximaciones es que están sujetas a error, por lo que nunca podemos estar completamente seguros de que nuestras estimaciones sean ciertas. Eso sí, podemos medir nuestro grado de incertidumbre. De eso se encarga en gran parte la estadística, de cuantificar la incertidumbre. Por ejemplo, supongamos que queremos saber cuál es el valor medio de colesterol de los adultos de entre 18 y 65 años de la ciudad donde vivo. Si quiero el valor medio exacto tengo que llamarlos a todos, convencerlos para que se dejen hacer un análisis (la mayoría estarán sanos y no querrán hacerse nada) y hacer la determinación a cada uno de ellos para calcular después la media que quiero conocer. El problema es que vivo en una ciudad muy grande, con unos cinco millones de habitantes, así que es imposible desde un punto de vista práctica determinar el colesterol a todos los adultos del intervalo de edad que me interesa. ¿Qué puedo hacer?. Tomar una muestra más asequible de mi población, calcular el valor medio de colesterol y estimar cuál es el valor medio de toda la población. Así que escojo 500 individuos al azar y determino sus valores de colesterol en sangre, en miligramos por decilitro, obteniendo una media de 165, una desviación estándar de 25 y una distribución de los valores aparentemente normal, tal como os muestro en el gráfico que se adjunta. Lógicamente, como la muestra es bastante grande, el valor medio de la población probablemente estará cerca de los 165 que he obtenido de la muestra, pero también es muy probable que no sea exactamente ese. ¿Cómo puedo saber el valor de la población?. La respuesta es que no puedo saber el valor exacto, pero sí aproximadamente entre qué valores está. En otras palabras, puedo calcular un intervalo dentro del cual se encuentre el valor inasequible de mi población, siempre con un nivel de confianza (o incertidumbre) determinado. Pensemos por un momento qué pasaría si repitiésemos el experimento muchas veces. Cada vez obtendríamos un valor medio un poco diferente, pero todos ellos deberían ser parecidos y próximos al valor real de la población. Si repetimos el experimento cien veces y obtenemos cien valores medios, estos valores seguirán una distribución normal con un valor medio y una desviación estándar determinados. Ahora bien, sabemos que, en una distribución normal, aproximadamente el 95% de la muestra se encuentra en el intervalo formado por la media más menos dos desviaciones estándar. En el caso de la distribución de medias de nuestros experimentos, la desviación estándar de la distribución de medias se denomina error estándar de la media, pero su significado es el mismo que el de cualquier desviación estándar: el intervalo comprendido por la media más menos dos errores estándar contiene el 95% de las medias. Esto quiere decir, aproximadamente, que la media de nuestra población se encontrará el 95% de las veces en el intervalo formado por la media de nuestro experimento (no necesitamos repetirlo cien veces) más menos dos veces el error estándar. ¿Y cómo se calcula el error estándar de la media?. Muy sencillo, aplicando la fórmula siguiente: error estándar = desviación estándar / raíz cuadrada del tamaño de la muestra En nuestro caso, el error estándar vale 1,12, lo que quiere decir que el valor medio de colesterol en nuestra población se encuentra dentro del intervalo 165 – 2,24 a 165 + 2,24 o, lo que es lo mismo, de 162,76 a 167,24, siempre con una probabilidad de error del 5% (un nivel de confianza del 95%). Hemos calculado así el intervalo de confianza del 95% de nuestra media, que nos permite estimar entre qué valores se encuentra el valor real. Todos los intervalos de confianza se calculan de forma similar, variando en cada caso la forma de calcular el error estándar, que será diferente según se trate de una media, una proporción, un riesgo relativo, etc. Para terminar esta entrada comentaros que la forma en la que hemos hecho este cálculo es una aproximación. Cuando conocemos la desviación estándar de la población podemos utilizar una distribución normal para el cálculo del intervalo de confianza. Si no la conocemos, que es lo habitual, y la muestra es grande, cometeremos poco error aproximando con una normal. Pero si la muestra es pequeña, la distribución de medias ya no sigue una normal, sino una t de Student, por lo que tendríamos que utilizar esta distribución para el cálculo del intervalo. Pero esa es otra historia… El estigma de la culpabilidad Hay veces en que los conceptos estadísticos son de gran utilidad para otras facetas de la vida. Por ejemplo, imaginad que se produce un robo en un banco y que el ladrón se ha introducido a través de un pequeño agujero que ha hecho en la pared. Ahora seguid imaginando que hace cinco años un ladrón pequeñito que salió de la cárcel hace dos meses, hizo un robo similar. ¿A quién creéis que interrogará la policía en primer lugar?. Todos estaréis de acuerdo en que el ladrón enano será el primer sospechoso, pero probablemente os preguntaréis también qué tiene todo esto que ver con la estadística. Pues os diré que es muy simple: la policía está utilizando el concepto de probabilidad condicionada cuando piensa en su pequeño sospechoso. Vamos a ver por partes qué es la probabilidad condicionada y veréis que tengo razón. Dos sucesos pueden ser dependientes o independientes. Son independientes cuando la probabilidad de producirse uno no tiene nada que ver con la de producirse el otro. Por ejemplo, si tiramos un dado diez veces, cada una de esas tiradas será independiente de las anteriores (y de la siguientes). Si sacamos un seis en una tirada, no por ello la probabilidad de sacar otro en la siguiente es más baja, sino que sigue siendo de un sexto. Aplicando el mismo razonamiento, si hemos tirado diez veces y no hemos tenido ningún seis, la probabilidad de sacarlo en la siguiente tirada sigue siendo un sexto. La probabilidad de obtener dos seises en dos tiradas sería el producto de la probabilidad de obtenerlo en cada una: 1/6 x 1/6 = 1/36. Expresado matemáticamente, la probabilidad de que ocurran dos sucesos independientes es la siguiente: P(A y B) = P(A) x P(B) En otras ocasiones los sucesos pueden ser dependientes, lo que significa que el que ocurra uno de ellos cambia la probabilidad de que ocurra el otro. Hablamos entonces de probabilidad condicionada. Veamos algún ejemplo. El más inmediato para los médicos puede ser el de los valores predictivos positivo y negativo de las pruebas diagnósticas. La probabilidad de que un paciente tenga un positivo en la prueba no es la misma que la probabilidad de que esté enfermo, una vez que haya dado positivo. Ésta, a su vez, será mayor que si ha dado negativo. Como veis, el resultado de la prueba condiciona la probabilidad de la enfermedad. Pensad por otro lado que estamos estudiando una población de niños para ver cuantos tienen anemia y malnutrición. Lógicamente, los anémicos tendrán más probabilidad de estar malnutridos. Una vez que determinamos que el niño está anémico, la probabilidad de que esté malnutrido se incrementa. Lo bueno de todo estos es que, si conocemos las distintas probabilidades, podremos calcular la probabilidad de que tenga anemia una vez que hemos constatado que está malnutrido. Vamos a verlo matemáticamente. La probabilidad de que dos sucesos dependientes ocurran puede expresarse de la siguiente forma: P(A y B) = P(A) x P(B|A), donde B|A se lee como B condicionada por A. También podríamos expresarlo cambiando A por B, de la siguiente forma: P(A y B) = P(B) x P(A|B) y como la parte izquierda de las dos ecuaciones es la misma podríamos igualarlas y obtener otra ecuación diferente: P(A) x P(B|A) = P(B) x P(A|B) P(B|A) = [P(B) x P(A|B)] / P(A) que es lo que se conoce como regla de Bayes, que fue un clérigo del siglo XVIII muy aficionado a los sucesos condicionados. Para entender su utilidad, vamos a aplicarlo al caso del valor predictivo positivo. Supongamos una enfermedad cuya prevalencia (probabilidad de padecerla en la población) es de 0,2 y una prueba diagnóstica para diagnosticarla con una sensibilidad de 0,8. Si tomamos una población y obtenemos un 30% de positivos (probabilidad 0,3), ¿cuál es la probabilidad de que un individuo esté enfermo una vez que ha obtenido un resultado positivo en la prueba?. Resolvamos el ejemplo: P(enfermo|positivo) = [P(enfermo) x P(positivo|enfermo)] / P(positivo) P(enfermo|positivo) = (prevalencia x sensibilidad) / P(prueba positiva) P(enfermo|positivo) = (0,2 x 0,8) / 0,3 = 0,53 En resumen, si un individuo da positivo habrá un 53% de probabilidades de que esté enfermo. Y aquí dejamos la regla de Bayes por hoy. Hay que decir que la contribución de Bayes a la ciencia de la estadística fue mucho más amplia. De hecho, este tipo de razonamientos conduce a otra forma de ver la estadística más dependiente de los sucesos que vayan ocurriendo, frente al enfoque estadístico clásico frecuentista que empleamos la mayor parte de las veces. Pero esa es otra historia…