APRENDIZAJE SUPERVISADO

Anuncio

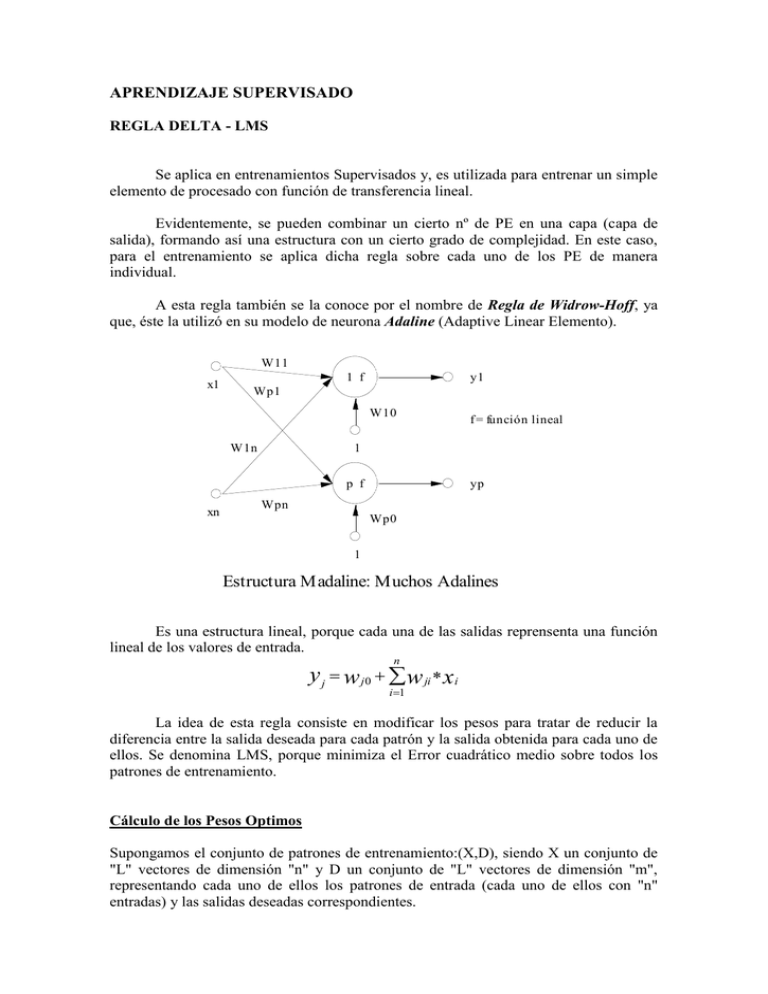

APRENDIZAJE SUPERVISADO REGLA DELTA - LMS Se aplica en entrenamientos Supervisados y, es utilizada para entrenar un simple elemento de procesado con función de transferencia lineal. Evidentemente, se pueden combinar un cierto nº de PE en una capa (capa de salida), formando así una estructura con un cierto grado de complejidad. En este caso, para el entrenamiento se aplica dicha regla sobre cada uno de los PE de manera individual. A esta regla también se la conoce por el nombre de Regla de Widrow-Hoff, ya que, éste la utilizó en su modelo de neurona Adaline (Adaptive Linear Elemento). W11 x1 1 f y1 Wp1 W10 W1n 1 p f xn f = función lineal yp Wpn Wp0 1 Estructura Madaline: Muchos Adalines Es una estructura lineal, porque cada una de las salidas reprensenta una función lineal de los valores de entrada. n y j w j0 w ji xi i 1 La idea de esta regla consiste en modificar los pesos para tratar de reducir la diferencia entre la salida deseada para cada patrón y la salida obtenida para cada uno de ellos. Se denomina LMS, porque minimiza el Error cuadrático medio sobre todos los patrones de entrenamiento. Cálculo de los Pesos Optimos Supongamos el conjunto de patrones de entrenamiento:(X,D), siendo X un conjunto de "L" vectores de dimensión "n" y D un conjunto de "L" vectores de dimensión "m", representando cada uno de ellos los patrones de entrada (cada uno de ellos con "n" entradas) y las salidas deseadas correspondientes. La Regla Delta se utiliza sobre elementos individuales de procesado por lo que en el desarrollo que se hará a continuación, se tendrán en cuenta dicho hecho significando que, la salida deseada para cada patrón será un vector de dimensión 1 (un sólo PE). ---------------------- Al estar trabajando con un conjunto de patrones de entrenamiento, es necesario minimizar la diferencia entre la salida deseada y la obtenida para todos los patrones. Empleamos la aproximación de minimizar el error cuadrático medio. Sea Yk la salida obtenida para el patrón k. El error para el patrón k Ek dk yk El Error Cuadrático Medio: E2k entonces 1 L 2 2 E k ( d k yk ) L k 1 n yk w j x j j 0 E 2 k 1 L 2 2 2 2 t t t t E k ( d k yk ) ( d k w x k ) d k w x k x k w 2 d k x k w L k 1 R x k x tk P d k x k E2k d 2k wt Rw 2 Pt w Para hallar el mínimo derivamos con respecto a W y hacemos igual a 0: ( w ) 2 Rw 2 P w 2 Rw * 2 P 0 w* R1 P Con esto diremos que la función del error (w), posee un extremo y, por otro lado, podemos asegurar que el extremo es un mínimo ya que la 2ª derivada es siempre positiva. La gráfica que se obtiene de la función error es un hiperparaboloide (dependiendo de la dimensión de "w". en el caso de 2 entradas, 2 pesos, sería un paraboloide). Ejemplo Freeman pag. 63. Ejercicio: Probar que el valor mínimo del error cuadrático medio se puede escribir de la manera siguiente: mínimo d 2k Pt w* Demostración : d 2k wt Rw 2 Pt w mínimo w* R1 P w* R P t w* P ( P t w * ) P w mínimo d 2k w*t Rw * 2 Pt w* t t * implicando : mínimo d 2k Pt w* Cálculo de W* mediante el método del Gradiente Descendente Una manera de encontrar los pesos idóneos sería hacer que el mecanismo buscase por todo el espacio de pesos hasta encontrar los que hiciesen el error mínimo. Una búsqueda puramente aleatoria podría no ser eficiente, por lo tanto, la búsqueda en cierta manera será Dirigida. Se inicializan al principio los pesos a valores aleatorios, con lo cual, ya tenemos el punto de partida en la superficie de pesos. Se determina a continuación, la dirección de la pendiente más pronunciada en dirección hacia abajo. Se modifican entonces los pesos para encontrarnos un poco más abajo en la superficie. Típicamente el vector de pesos no se desplaza al principio directamente hacia el mínimo. La sección transversal de la superficie paraboidal suele ser elíptica, de modo que el gradiente negativo, puede no apuntar de manera directa al punto mínimo. Sea W(t) el vector de pesos en el instante t. En el instante t+1 el vector habrá cambiado de la manera: W(t+1)=W(t) + W(t) Dirección opuesta y más pronunciada Dirección opuesta al gradiente de la Superficie (W(t)) Para obtener la magnitud del cambio (W(t)) Se realiza la siguiente aproximación: (t ) E k 2 k E k E k 2 k 2 Entonces com o: E k (t ) ( d k w t (t ) x k ) 2 2 Tenem os: (t ) 2 E k k (t ) x k Obteniendo w(t 1) w(t ) 2 E k x k Nota: Dibujos Freeman pag. 65-66-67 Algoritmo: 1- Inicialización de pesos. 2- Se aplica un patrón de entrada (entradas y salida deseada). 3- Se computa la salida lineal que se optiene de la red. 4- Se calcula el error cometido para dicho patrón. 5- Se actualizan las conexiones mediante la ecuación obtenida anteriormente. 6- Se repiten los pasos del 2 al 5 para todos los patrones de entrenamiento. 7- Si el error cuadrático medio es un valor reducido aceptable, termina el proceso. Sino se vuelve al paso 2. Aplicaciones: La principal aplicación de las redes tipo Adaline se encuentra en el campo de procesamiento de señales. Concretamente en el diseño de filtros capaces de eliminar ruido en señales portadoras de información. Otra aplicación es la de los filtros adaptivos, que pueden ser utilizados para predecir el valor futuro de una señal, a partir de su valor actual. CONCLUSIONES: - Una simple capa de PE lineales pueden realizar aproximaciones a funciones lineales o asociación de patrones. - Una simple capa de PE lineales puede ser entrenada con algoritmo LMS. - Relaciones No Lineales entre entradas y salidas no pueden ser representadas exactamentes por redes lineales. Dichas redes harán aproximaciones lineales. Otro tipo de redes abordarán la resolución de problemas no lineales. REGLA DEL PERCEPTRON (Rosenblatt) Supongamos un PE con una función de transferencia del tipo Hardlimiter y en donde las entradas son binarias o bipolares (mismo que Adaline pero con esas restricciones). La regla que rige el cambio de pesos es: Wi(t+1) = Wi(t) Si la salida es correcta. Wi(t+1) = Wi(t) + Xi(t) Si la salida = -1 y debería de ser 1. Wi(t+1) = Wi(t) - Xi(t) Si la salida = 1 y debería de ser -1. Sobre la regla anterior se han realizado diferentos modificaciones: A) Wi(t+1) = Wi(t) Si la salida es correcta. Wi(t+1) = Wi(t) + Xi(t) Si la salida = -1 y debería de ser 1. Wi(t+1) = Wi(t) - Xi(t) Si la salida = 1 y debería de ser -1. Con [0,1], término de control de ganancia y velocidad de aprendizaje. B) Otra de las modificaciones propuestas fue sugerida por Widrow and Hoff. Ellos propusieron una regla basada en la regla Delta. (Es la más utilizada). Los Pesos cambian según la formula: w(t 1) w(t ) 2 Ek x k Tomando las entradas y salidas como bipolares tenemos que el cambio en los pesos se produce de la manera siguiente: w (t 1) w (t ) (t ) z si z w (t ) 0 w (t 1) w (t ) en otro caso x si d 1 z x si d 1 i i i i i i i i i i i i Con esta regla de aprendizaje se otiene una convergencia finita si el conjunto de entrenamiento es linealmente separable. Pasos del Algoritmo: 1- Inicializar las conexiones a valores aleatorios. 2- Presentación de un nuevo par de entrada y salida deseada. 3- Cálculo de salida actual. 4- Chequeo de error. 5- Adaptación de pesos. 6- Se realiza esta operación para todos los patrones de entrenamiento. 7- Si el error cometido para cada patrón es suficientemente pequeño, acabó sino volver al paso2. REGLA DE BUTZ La regla del perceptrón no converge para el caso en el que el conjunto de entrenamiento está formado por clases no separables linealmente. Butz propone una solución al problema al tratar de minimizar la probabilidad del error para los casos no separables linealmente. Introduce un nuevo parámetro denominado Factor de Reforzamiento. w (t 1) w (t ) z w (t 1) w (t ) z i i i i i i si si z w (t ) 0 z w (t ) 0 i i i i