acerca de la corrección de la multicolinealidad en modelos

Anuncio

ACERCA DE LA CORRECCIÓN DE LA

MULTICOLINEALIDAD EN MODELOS DE

REGRESIÓN LINEAL

José Soto Liria1

José García Pérez2 - nikita97@larural.es

Antonio S. Andújar Rodríguez2 - andujar@ualm.es

1

Catedrático de Matemáticas de Enseñanza Secundaria

2

Universidad de Almería

Reservados todos los derechos.

Este documento ha sido extraído del CD Rom “Anales de Economía Aplicada. XIV Reunión ASEPELT-España. Oviedo,

22 y 23 de Junio de 2000”.

ISBN: 84-699-2357-9

1

ACERCA DE LA CORRECCIÓN DE LA MULTICOLINEALIDAD EN MODELOS

DE REGRESIÓN LINEAL.

José Soto Liria

Catedrático de Matemáticas de Enseñanza Secundaria

José García Pérez

Departamento de Economía Aplicada. Universidad de Almería.

Antonio S. Andújar Rodríguez

Departamento de Estadística y Matemática Aplicada. Universidad de Almería.

Palabras clave: multicolinealidad1 , regresión lineal, varianza, número métrico.

Resumen:

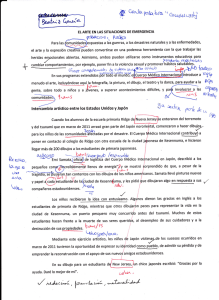

En esta comunicación se tratan algunos aspectos relacionados con el estudio de la

multicolinealidad en modelos de regresión lineal, siguiendo la línea marcada por una comunicación

presentada por los mismos autores en el XIII Congreso de ASEPELT, donde se proponía un método

alternativo de detección de la multicolinealidad. Ahora lo completamos con una propuesta para su

corrección. Basándonos en una interpretación geométrica actuamos sobre la variable X i que

provoca la máxima colinealidad con las restantes, la corregimos a través de un procedimiento de

“alzado” obteniendo una nueva variable X i* que, junto con las p − 1 restantes, nos permite una

estimación de los parámetros que, aunque ahora no son insesgados, sí reducen las varianzas con

respecto a los parámetros estimados con las variables originales.

1

Utilizaremos como sinónimos los términos colinealidad y multicolinealidad.

2

1.- Introducción

Cuando intentamos resolver un problema de regresión lineal por el método habitual de

mínimos cuadrados, pueden aparecer indicadores que nos muestran la presencia de

multicolinealidad. Una vez confirmada su presencia en la muestra , en este trabajo, nos planteamos

resolver el problema de regresión lineal en presencia de multicolinealidad.

Varios son los métodos que se presentan en la literatura al uso para abordar este tipo de

problemas, entre ellos la regresión cresta (Hoerl and Kennard, 1970; García Ferrer, 1977; Brown

and Beattie, 1975; MacDonal and Galarneau, 1975; etc.), componentes principales (Kendall,1957;

Massy, 1965; Farrar and Glauber, 1967; Silvey, 1969; Jhonston, 1989,etc), inversa generalizada

(D.W. Marquard, 1970), eliminación de variables, etc.

Nosotros proponemos un método que explicamos a continuación:

2.- Método de “alzado de una variable”.

Dado que a través del número métrico2 es posible detectar cuál de las variables exógenas es

“la mayor” causante de la multicolinealidad, desde una interpretación geométrica, dicha variable es

la “más próxima”, en el sentido euclídeo, al hiperplano generado por las demás. Supongamos sin

pérdida de generalidad que esa variable es X 1 . En principio tenemos dos opciones: a) eliminar la

X1

e1

X-1

Figura 1

2

Véase ACERCA DE LA DETECCIÓN DE LA COLINEALIDAD EN MODELOS DE REGRESIÓN

LINEAL, XIII Congreso de ASEPELT de los mismos autores .

3

variable si consideramos que su aportación a la explicación de la variable endógena Y está recogida

{

}

por el resto de las variables X 2 , X 3 , L , X p al ser cuasi combinación lineal de ellas, Figura 1,

o b) si la opción a) no parece adecuada porque tenemos interés en que dicha variable permanezca

en el modelo, nuestra propuesta es modificarla ligeramente en el sentido de aumentar el ángulo que

forma con el hiperplano generado por X 2 , X 3 ,L , X p con lo que evidentemente disminuye la

colinealidad como se muestra en la Figura 2 aunque las proyecciones de X 1 (el vector de datos

originales) y X 1* (el vector con los datos corregidos) sobre el hiperplano

X 2 , X 3 ,L , X p son la

misma X̂ 1 .

¿Cómo podemos elegir el valor adecuado del número positivo λ ?

Si atendemos a la Figura 2, desde el punto de vista vectorial, podemos escribir las

igualdades

X 1 = Xˆ 1 + e1 ;

X 1* = Xˆ 1 + (λ1 + 1 ) e1 = X 1 + λ1 e1

(1)

o, en función de los módulos de los vectores y aplicando el teorema de Pítágoras,

X 12 = Xˆ 12 + e12

2

X 1* 2 = Xˆ 12 + e1*2 = Xˆ 12 + ( λ 1 + 1) 2 e12 = Xˆ 12 + β 1 e12 ; β 1 = λ 1 + 1; λ 1 ≥ 0

(2)

El problema con la variable X 1 es que al ser muy colineal con las demás, al hacer la

regresión de X 1 sobre las restantes, el ajuste será muy bueno y si llamamos R12 al coeficiente de

determinación que mide la bondad del ajuste, su valor será próximo a 1 y, por tanto, el

X *1

X1

X1

Figura 2

4

l1 1

e

e1

el FIV1 muy grande por lo que nuestro objetivo es modificar la variable X 1 a X 1* con el objetivo de

disminuir el FIV* 1.

2

Xˆ 12

e1

1

2

El FIV1=

. Si tenemos en cuenta que R1 =

=1 − 2

1 − R12

X12

X1

por tanto,

2

e

⇒ 1 − R = 1 2 y,

X1

2

1

1

X 12

=

. Supongamos que aceptamos un FIV* 1 = F* 1 para la nueva variable X1* .

1 − R12

e12

(

)

De (2) podemos deducir que X 1* 2 = X 12 + β 12 − 1 e12

X 1* 2

X 1*2

X 12 + (β 12 − 1)e12

1

=

=

=

< FIV* 1 = F* 1 donde e1* = β 1 e1 ; β 1 ≥ 1

*2

2 *2

2 2

*2

e1

β 1 e1

1 − R1

β 1 e1

(

)

(

)

X12 + β12 −1 e12 < F1 β12 e12 ; ⇒ X12 − e12 < F1 β12 e12 − β12 e12 = F1 −1 β12 e12

X 12 − e12

(

)

e12 F1 − 1

< β 12

⇒ β1 ≥ +

X 12 − e12

(

)

e12 F1 − 1

(3)

La situación ideal sería conseguir un F1 =1, que no hubiera inflación de la varianza con

respecto a mínimos cuadrados, pero eso supondría una modificación muy grande en los datos de la

variable correspondiente (en este caso X 1 ). Según distintos autores, se consideran aceptables en

algunos casos valores del FIV <10 y en otros, más exigentes, consideran aceptable FIV < 5 lo que

ya se va aproximando a la situación ideal que nunca se podrá conseguir porque no debemos olvidar

que estamos trabajando en presencia de fuerte colinealidad.

5

3.-Caso práctico. Presentación y soluciones clásicas.

Hemos elegido para nuestro estudio un modelo econométrico del libro CIEN EJERCICIOS

DE ECONOMETRÍA, Pena Trapero, J.B. y otros, (1999), Ediciones Pirámide.

Se dispone de información acerca de los ingresos de explotación (INEX), el consumo

(CONS), los gastos de personal (GPER) y los gastos de explotación (GEX) relativos al sector de

metalurgia y fabricación de productos metálicos (CNAE, 27,28) para cada una de las 17

comunidades autónomas.

Comunidad autónoma

Andalucía

Aragón

Asturias

Baleares

Canarias

Cantabria

Castilla y León

Castilla-La Mancha

Cataluña

Comunidad Valenciana

Extremadura

Galicia

Madrid

Murcia

Navarra

País Vasco

La Rioja

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

INEX

CONS

302565.0

107689.0

348540.0

14619.00

17812.00

117007.0

134899.0

74856.00

761142.0

241131.0

14817.00

186509.0

337445.0

64181.00

170364.0

1051196.

50517.00

GPER

180236.0

51850.00

165985.0

7991.000

8693.000

59046.00

75042.00

43100.00

389019.0

118762.0

7806.000

92236.00

194993.0

36941.00

102965.0

568539.0

28624.00

GEX

51189.00

27642.00

75735.00

3813.000

5356.000

30838.00

30844.00

17484.00

193713.0

60946.00

4242.000

43276.00

82411.00

12675.00

38456.00

254043.0

10255.00

274346.0

100310.0

330602.0

13253.00

16000.00

115951.0

126969.0

70744.00

708598.0

225651.0

13773.00

176606.0

323954.0

59007.00

168279.0

1037175.

46462.00

Fuente: Encuesta Industrial , INE.

Tabla 1

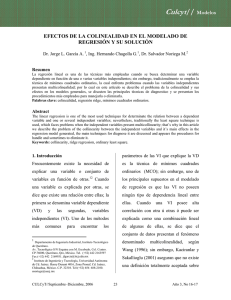

El objetivo del ejercicio es el análisis de la presencia de colinealidad en el modelo

econométrico

INEX i = β 0 + β 1 CONS i + β 2 GPER i + β 3 GEX i + ε i

por varias vías alternativas y su corrección aplicando la metodología propuesta de “alzado de una

variable”

La solución que se obtiene al aplicar el método de Mínimos Cuadrados Ordinarios al

modelo es la que se muestra en la Tabla 2

6

3.1.- Detección de la colinealidad.

a) Significación global y significación individual de los regresores.

En primer lugar, puede observarse que se trata de un modelo globalmente bien estimado. El

estadístico F nos indica que las variables conjuntamente son significativas. El valor del coeficiente

de determinación R2=0.998971 y al analizar la significación individual de las variables explicativas

se puede comprobar que CONS y GPER no son significativas en los ingresos de explotación.

Cuando estas dos características se presentan de forma simultánea tenemos indicios de la

presencia de colinealidad en el modelo

============================================================

LS // Dependent Variable is INEX

Sample: 1 17

Included observations: 17

============================================================

Variable

Coefficient

Std. Error

t-Statistic

Prob.

============================================================

C

3729.609

3240.869

1.150805

0.2705

CONS

0.392848

0.276641

1.420067

0.1791

GPER

0.663397

0.415687

1.595907

0.1345

GEX

0.648393

0.218018

2.974033

0.0108

============================================================

R-squared

0.998971

Mean dependent var

235017.0

Adjusted R-squared

0.998734

S.D. dependent var

279592.1

S.E. of regression

9949.564

Akaike info criterion

18.61289

Sum squared resid

1.29E+09

Schwarz criterion

18.80894

Log likelihood

-178.3315

F-statistic

4207.203

Durbin-Watson stat

1.589402

Prob(F-statistic)

0.000000

============================================================

Tabla 2

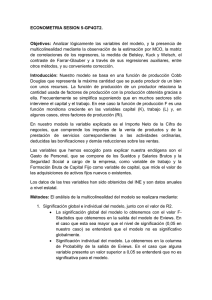

b) Análisis de la matriz de correlación de los regresores

La matriz de correlación de las variables exógenas se muestra a continuación

======================================

CONS

GPER

GEX

======================================

CONS 1.000000

0.990380

0.997769

GPER 0.990380

1.000000

0.995341

GEX 0.997769

0.995341

1.000000

======================================

Tabla 3

7

De esta matriz puede calcularse el determinante Rxx= 0.000033924, valor muy próximo a

cero que es otro de los indicativos de la posible existencia de colinealidad en el modelo. Además la

matriz refleja fuerte correlación entre las variables que se han considerado en el modelo.

c) Número de condición

Si calculamos los autovalores de la matriz de correlación obtenemos

λ1 = 0.009851

λ2 = 0.001152

λ3 =2.988997

por lo que sus índices de condición son IC1= 17.41869, IC2=50.93737, IC3 = 1. Al ser el Número de

condición (el mayor de los Índices de condición ) mayor que 30 es otro indicador de la presencia de

colinealidad fuerte entre los regresores.

d) Factores inflactores de la varianza.

Recordemos que los factores inflactores de la varianza representan la proporción entre la

varianza de la componente i-ésima del vector de los coeficientes de correlación y la correspondiente

componente en el caos de que los regresores fuesen ortogonales.

σb2i

σ

2

bOR

=

1

1 − Ri2

lo cual quiere decir que para calcularla debemos hacer unas regresiones auxiliares de cada una de

las variables con respecto a las demás.

Haciendo estas regresiones obtenemos los siguientes coeficientes de correlación:

2

2

2

RCONS

= 0 .996352 ; RGEX

= 0.998229 ; R GPER

= 0.992389

(4)

por lo que los FIV correspondientes son

FIV CONS = 274 .12 ; FIV GEX = 564 .65 ; FIV GPER = 131 .39 ;

(5)

Del análisis de estos valores se deduce que la varianza de los coeficientes de regresión en el

modelo original se encuentra muy inflada lo que originaría intervalos de confianza tan amplios que

podríamos tomar como no significativos coeficientes que sí podrían serlo.

e) Medida de Theil (1971)

Esta medida refleja la diferencia entre la variabilidad explicada por el modelo completo y la

suma de cada una de las aportaciones de los regresores al modelo.

8

m = R 2 − ∑ (R 2 −R−2 j )

donde

R 2 es el coeficiente de determinación del modelo completo.

R−2 j es el coeficiente de determinación de una regresión auxiliar en la que se excluye el

regresor X j

Después de hacer las regresiones auxiliares correspondientes obtenemos los siguientes

resultados

R−2CONS = 0.998811; R−2GPER = 0.998769;

R−2GEX = 0.998271

Si calculamos los valores que aporta cada variable obtenemos que

CONS: 0.998971 - 0.998811 = 0.00016

GPER: 0.998971 – 0.998769 = 0.00020

GEX:

0.998971 – 0.998271 = 0.00070

por lo que m = 0 .997909 que dista mucho de su valor óptimo para regresores ortornormales que es

cero. Por tanto, también esta medida contribuye a admitir la presencia de multicolinealidad en el

modelo.

f) Índices métricos

Si calculamos los Índices métricos para las variables del modelo obtenemos los

siguientes resultados:

IM CON = 0 .06040 ; IM GPER = 0 .08724 ;

IM GEX = 0.04208 ;

(6)

que corresponden a ángulos aproximados de 3.46º, 5º y 2.4º respectivamente. De los experimentos

realizados podemos considerar que una variable altamente colineal con las demás si su Índice

métrico es menor o igual a 0.085 equivalente a un ángulo ≤ 5º . En este caso todas las variables lo

cumplen pero la más afectada es GEX por lo que esta será la que elegiremos para actuar sobre ella.

9

4.- Solución por el “método de alzado”.

A partir de la regresión lineal de la variable GEX sobre CONS y GPER (incluimos también

el término independiente) obtenemos la variable GEXE (gastos de explotación estimados ) y la

variable RGEX (residuos gastos de explotación) donde RGEX=GEX – GEXE. Además hemos

calculado FIVGEX = 564.65 y el Índice métrico asociado IM GEX = 0.04208 ambos indicadores

de la fuerte colinealidad entre esta variable y las restantes por lo que hemos decidido actuar sobre

ella en el sentido de lo expuesto en (1) y calculado los correspondientes valores de λ y β según (3)

obteniendo los valores β GEX ≅ 10 . y λ GEX ≅ 9 . Generamos una nueva variable a la que llamamos

GEXC (gastos de explotación corregidos ) donde GEXC = GEX + 9 RGEX y hacemos la regresión

de INEX sobre CONS, GPER, GEXC obteniendo los resultados de la Tabla 4

===========================================================

LS // Dependent Variable is INEX

Sample: 1 17

Included observations: 17

===========================================================

Variable

Coefficient

Std. Error

t-Statistic

Prob.

===========================================================

C

2988.022

3229.123

0.925335

0.3717

CONS

1.059048

0.123291

8.589795

0.0000

GPER

1.527064

0.264047

5.783308

0.0001

GEXC

0.064839

0.021802

2.974033

0.0108

===========================================================

R-squared

0.998971

Mean dependent var

235017.0

Adjusted R-squared

0.998734

S.D. dependent var

279592.1

S.E. of regression

9949.564

Akaike info criterion

18.61289

Sum squared resid

1.29E+09

Schwarz criterion

18.80894

Log likelihood

-178.3315

F-statistic

4207.203

Durbin-Watson stat

1.589402

Prob(F-statistic)

0.000000

===========================================================

Tabla 4

Si comparamos la Tabla 4 con la Tabla 2, observamos que se han conservado la mayoría de

los indicadores. Se mantiene el coeficiente de determinación R2 (con lo que el modelo sigue estando

globalmente bien estimado) y los valores del estadístico F, aunque han cambiado los coeficientes de

las variables explicativas que son significativamente distintos de cero. Ha perdido peso la variable

GEXC mientras lo han ganado las restantes CONS y GPER. El hecho de que se mantengan

inalterados el coeficiente de determinación R2 y el valor del estadístico F no es una casualidad sino

una consecuencia del siguiente teorema.

10

Teorema:

Supongamos que tenemos los modelos Y = β X + ε e Y = β X * + ε * en los que X

representa la matriz cuyas columnas son los valores de las variables originales y X * la matriz

donde una de las variables originales se ha modificado por el método de alzado. Sean

(

−1

βˆ = ( X ' X ) X 'Y y βˆ * = X * ' X *

)

−1

X * 'Y los estimadores por mínimos cuadrados ordinarios

de ambos modelos respectivamente. En ese caso se verifica que sus correspondientes coeficientes

de determinación R2 y R *2 son iguales.

En efecto, sean R 2 =

SCE

SCE *

y R *2 =

SCT

SCT *

Teniendo en cuenta que SCT =

∑ (Y − Y )

2

i

= SCT * , puesto que la variable Y no ha

variado y que SCE = β̂ ' X 'Y − nY y SCE * = βˆ * ' X * ' Y − nY que serán iguales si β̂ ' X 'Y =

(

−1

βˆ * ' X * 'Y lo que equivale a que las formas cuadráticas Y ' X ( X ' X ) X 'Y =Y ' X * X * ' X *

)

−1

X * 'Y

sean iguales lo que ocurrirá si sus respectivas matrices son iguales, es decir, X ( X ' X )−1 X ' =

(

X * X *' X *

)

−1

X * ' . Pero estas matrices son simétricas, idempotentes y de rango p por lo que sus

polinomios característicos son de la forma λ n − p (λ − 1) p = 0 y µ n − p (µ − 1) p = 0 respectivamente.

(

) X'

(A − 1) = 0 .

Por el teorema de Cayley-Hamilton las matrices A = X ( X ' X )−1 X ' y A* = X * X * ' X *

satisfacen su propia ecuación característica por lo que A n − p ( A − 1) p = 0 y A*

n− p

*

−1

*

p

Desarrollando estos polinomios resultan tener el mismo grado y los mismos coeficientes de lo que

se deduce que A= A* como pretendíamos demostrar y, como consecuencia, queda probado que

los coeficientes de determinación de ambos modelos son iguales. Además, SCR= SCR* por lo que

SCE

los estadísticos F =

SCR

p −1

n− p

SCE*

y F* =

p −1

*

SCR

n− p

11

también son iguales.

Si analizamos la nueva matriz de correlación de los regresores, como era de esperar han

disminuido la variable GEXC con respecto a las demás. Además el determinante de dicha matriz es

ahora | Rxxc| =0.00288 que aunque sigue siendo pequeño es del orden de 85 veces mayor que el de la

matriz de correlación con las variables originales, Tabla 3.

=====================================

CONS

GPER

GEX

=====================================

CONS 1.000000

0.990380

0.920335

GPER 0.990380

1.000000

0.918095

GEXC 0.920335

0.918095

1.000000

=====================================

Tabla 5

En cuanto a los autovalores e índices de condición de la matriz de correlación, tenemos

µ1 = 0.009602

µ2 = 0.104120

µ3 = 2.886278

y los correspondientes índices de condición IC1 = 17.33, IC2 = 5.26, IC3 = 1 lo que supone que el

número de condición es 17.33, menor que 30 lo que en todo caso puede suponer un grado de

colinealidad débil.

Si hacemos las regresiones auxiliares en el modelo corregido y calculamos los coeficientes

de determinación y los correspondientes factores inflactores de la varianza, obtenemos

*2

RCONS

= 0 .981632

*2

FIV CONS

= 54 .35

*2

RGPER

= 0 .981138

*2

FIV GPER

= 53

*2

RGEXC

= 0 .849300

*2

FIV GEXC

= 6.63

Si estos valores se comparan con los de ( 4) y (5 ) observamos la sensible reducción que han

experimentado los FIV, especialmente el correspondiente a la variable que hemos modificado.

En cuanto a la medida de Theil, si hacemos las regresiones auxiliares correspondientes

obtenemos

2

R *−CONS

= .993131

R−* 2GPER = .996324

y las aportaciones de cada variable

12

2

R *−GEXC

= .998271

CONS: 0.998971 - 0.993131 = 0.0058

GPER: 0.998971 - 0.996324 = 0.0026

GEXC: 0.998971 - 0.998271 = 0.00070

lo que supone que las dos primeras se han incrementado en un factor de escala de alrededor de 10

mientras que la tercera, como es lógico en este caso, no ha variado. El índice de Theil vale

m = 0.989871 que no se aleja mucho del calculado en el modelo original.

En cuanto a los índices métricos en este caso son

IMCONS= 0.135528, IMGPER = 0.137339, IMGEXC = 0.388201

que corresponden a ángulos de 7.79º, 7.89º y 22.84º, todos ellos se alejan de los 5º que suponen

colinealidad fuerte, especialmente significativo es el que corresponde a la variable que hemos

corregido.

5.- De cómo a través del “alzado de variables” llegamos a la regresión cresta.

Para simplificar, y sin pérdida de generalidad, consideremos un conjunto de tres variables

independientes {X 1 , X 2 , X 3 } y que cada una de ellas la modificamos por el “método de alzado” tal

y como se ha explicado en el punto 1 y en el ejemplo correspondiente.

{

Ello daría lugar a tres nuevas variables X 1* , X 2* , X 3*

} de modo que cada X

*

i

= X i + λ i ei ;

i=1,2,3.Para obtener la matriz X* ’X*, que es la que genera el problema asociado a la varianza del

estimador, sustituimos cada vector por su alzado ( estamos exigiendo mucho puesto que debemos

“tocar” a todos los vectores representantes de las variables exógenas en la matriz original).

Calculemos X* ’X*

X 1* '

X * ' X * = X 2* ' X 1*

X 3* '

[

X

*

2

X 1 ' + λ 1 e'1

X = X 2 ' + λ 1 e'1 X1 + λ 1 e1

X 3 ' + λ 1 e'1

*

3

]

[

13

X 2 + λ 2 e2

]

X 3 + λ 3 e3 =

X '1 X 1 + k1

X' X

2

1

X '3 X 1

X '1 X 2

X '2 X 2 + k 2

X '3 X 2

X '1 X 1

X '2 X 3 = X ' 2 X 1

X '3 X 3 + k3 X ' 3 X 1

X '1 X 3

X '1 X 2

X '2 X 2

X '3 X 2

X '1 X 3 k1

X ' 2 X 3 + 0

X '3 X 3 0

0

k2

0

0

0 = X ' X + K

k3

que podemos justificar ya que, para los elementos de la diagonal principal:

X '*i X i* = ( X ' i + λ i e'i )( X i + λ i ei ) = X 'i X i + X 'i λ i ei + λ i e'i X i + λ i λ i e'i ei =

X 'i X i + 2λi X 'i ei + λi 2 e'i ei = X 'i X i + k i ; k i = 2λi X 'i ei + λi 2 e'i ei ; i = 1, 2, 3

y para los elementos fuera de la diagonal principal

X '*i X *j = ( X ' i + λi e'i )(X j + λj e j )= X 'i X j + λi e' i X j + X 'i λj e j + λi λi e' i e j =

X 'i X j + λi λ i e'i e j ya que e i es ortogonal a X j ; i ≠ j

Si queremos llegar a la matriz X ' X + kI del estimador cresta, debemos exigir

1) k1 = k 2 = k 3

2) e’i .ej =0, i ≠ j

La primera condición es fácil de cumplir puesto que

ki = 2 λ i X 'i ei + λ 2i e'i ei ; i = 1, 2, 3 y como X i = Xˆ i + ei

X 'i ei = Xˆ 'i ei + e'i ei = e'i ei significa que

λ 2i + 2 λ i −

ki

ei2

k i = 2 λ i e'i ei + λ 2i e'i ei ; i = 1, 2 , 3

= 0 ; resolviendo esta ecuación de segundo grado, obtenemos una raíz

positiva

λi = −1+ 1 +

ki

ei2

14

Si hacemos ki =k , ∀i llegamos a obtener λ i = − 1 + 1 +

k

ei2

, valores que nos llevarían al

mismo k en la diagonal principal de la matriz K; si además imponemos la condición e’i.ej =0, i≠ j

llegamos a la matriz del estimador cresta

X * ' X * = X ' X + kI

6.- Conclusiones y líneas de investigación.

La consecuencia fundamental de este trabajo es que, modificando una sola de las variables

exógenas (las p-1 restantes permanecen con los valores originales), reducimos sensiblemente la

colinealidad y obtenemos unas estimaciones de los parámetros que conservan el coeficiente de

determinación del modelo original y nos permiten hacer contrastes de la significación individual de

los parámetros y obtener intervalos de confianza.

Como líneas de trabajo proponemos

a) Seguir investigando sobre la mejor elección del factor de alzado λ .

b) Comparar este método con otros como el estimador cresta, componentes principales,

etc.

15

BIBLIOGRAFÍA:

[ 1]

Allen, D.M. (1974). The Relationship Between Variable Selection an Data Augmentation

and a Method for Prediction. Technometrics , 16, pp 125-127.

[ 2]

Baye, M.R.; Parker, D.F. (1984). Combining Ridge and Principal Component Tegression: A

Money Demand Illustration, Communication in Statistics: Theory and Methods, 13(2), pp

197-205.

[ 3]

Bellman, R. (1970). Introduction to Matriz Analysis. MacGraw-Hill Book Company.

[ 4]

Belsey, D.A. et. all. (1980). Regression Diagnosis: Identifying Influencial Data and

Sources of Collineariry. John Wiley and Sons

[ 5]

Brown, P.Z (1977). Centering and scaling in ridge regression. Technometrics , 19, pp 35-36

[ 6]

Brown, William G.; Beattie, Bruce R., (1975), Improving Estimates of Economics

Parameters by Use of Ridge Regression with Production Function Applications, American

Journal of Agricultural Economics, 57(1), pp 21-32

[ 7]

Casella, George, (1985), Condition Numbers and Minimax Ridge Regression Estimators,

Journal of the American Statistical Association, 80(391), pp 753-758

[ 8]

Dempster, A.P.; Schatzoff, M. and Wermuth, N. (1977), A Simulation Study of Alternatives

to Ordinary Least Squares, Journal of the American Statistical Association , 72, pp 77-91

[ 9]

Draper, N.R. and Van Nostrand, R.C. (1979). Ridge Regression and James-Stein

Estimation: Review and Comments. Technometrics, 21(4), pp 451-466.

[10]

Farebrother, R.W. (1975). The Minimun Mean Square Error Linear Estimator and Ridge

Regression. Technometrics , 17, pp 127-128.

[11]

Farebrother, R.W. (1976). Further result on the mean square error of ridge regression.

Journal of Royal Statistical Society, B38, pp 248-250.

[12]

Farrar, D.E and Glauber, R.R (1967). Multicollinearity in regression analysis: the problem

revisited. Review of Economics and Statistics, 49, pp 92-107

[13]

Feldstein, M.S. (1973)Multicollinearity and the mean squared error of alternative

estimators. Econometrica, 41, pp 337-346

[14]

Feig, Douglas G, (1978), Ridge Regression: When Biased Estimation Is Better, Social

Science Quarterly, 58(4), pp 708-716.

[15]

García Ferrer, Antonio (1977), El problema de la multicolinealidad en los modelos de

regresión lineales. Algunas soluciones posibles, Revista Española de Economía, MayoAgosto, pp 120-139.

[16]

Gibbons, Diane Galarneau, (1981), A Simulation Study of Some Ridge Estimators, Journal

of the American Statistical Association, 76(373), pp 131-139

16

[17]

Hoerl, A.E. and Kennard, R.W. (1970), Ridge Regression: Biased Estimation for

Nonorthogonal Problems, Technometrics, 12, pp 55-67

[18]

Hoerl, A.E. and Kennard, R.W. (1970), Ridge Regression: Applications to Nonorthogonal

problems, Technometrics, 12, pp 69-82.

[19]

Hoerl, A.E. and Kennard, R.W. (1976), Ridge Regression iterative estimation of the biasing

parameter. Communications in Statistics, A5, pp 77-78

[20]

Lawless, J.F, (1981), Mean Squared Error Properties of Genealized Ridge Estimators,

Journal of the American Statistical Association, 76(374), pp 462-466

[21]

Leamer, E.E. (1975). A result on sign of restrictec least squares estimates. Journal of

Econometrics, 3, pp 387-390

[22]

Lee, T. and Campbell, D.B. (1985), Selecting the Optimun k in Ridge Regression,

Communication in Statistics, Theory and Methods, 14 pp 1589-1604

[23]

Lott, W.F (1973) The Optimal Set of Principal Component Restrictions on a Least Squares

Regression, Communication in Statistics, 2, pp 449-464

[24]

Marquard, D.W. (1970). Generalized Inverses, Ridge Regression, Biased Linear Estimation

and Nonlinear Estimation, Technometrics, 12, 3, pp 590-612.

[25]

Massy, W.I. (1965). Principal Component Regression in Explanatory Statistical Research,

Journal of American Statistical Association, 60, pp 234-256.

[26]

McDonald, Gary G.; Galarneau, Diane I., (1975), A Monte Carlo Evaluation of Some

Ridge-Type Estimators, Journal of the American Statistical Association, 70(350), pp 407416

[27]

Oman, S.D. (1981). A confidence bound aproach to choosing the biasing parameter in

ridge regression. Journal of the American Statistical Association, 76, pp 452-461

Silvey, S.D. (1969). Multicollinearity and Imprecise Estimation. Journal of Statistical

Society, Ser B, 31, pp 539-552.

[28]

[29]

Smith, G and Campbell, F. (1980). A critique of some ridge regression methods. Journal of

the American Statistical Association, 75, pp 74-81, discussion, pp 81-103

[30]

Theil, H; and Goldberger (1960), On Pure and Mixed Stastistical

Estimation in Economics, International Economics Review, 2, pp 65-78

[31]

Theil, H (1971). Principles of Econometrics, Wiley, New York.

[32]

Vinod, H.D. (1978). A Survey of ridge regression and related techniques for improvement

over ordinary least squares. Review odf Economics and Statistics, 60, pp 121-131.

17

18