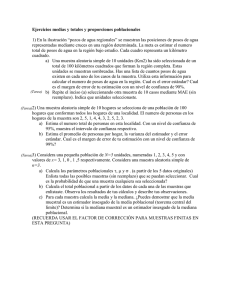

Tema 2. Estimación puntual.

Anuncio

Estimación puntual Estadística aplicada a la empresa II Prof. D. Juan José Pérez Castejón 1 ESTIMACIÓN PUNTUAL Tras hacernos a la idea en el tema anterior de lo que la inferencia estadística es y persigue, en este tema y en los que siguen, comenzaremos la revisión detenida de los diferentes métodos de llevarla a cabo. En particular, en el tema que ahora comienza comentaremos todo lo relacionado con la cuestión de la estimación puntual. La primera sección realmente estará dedicada a dar una visión general de los propósitos y forma de proceder de las distintas técnicas inductivas, y de las diferencias existentes entre ellas. Y también servirá para establecer algunas hipótesis generales bajo las que todas se realizarán. Las tres restantes secciones son las que verdaderamente se centran en la estimación puntual. La primera de las tres contiene una exposición de dos métodos de obtención del estimador, la herramienta fundamental para estimar. La segunda, define y comenta las propiedades básicas que los estimadores deben tener. La tercera, y última del tema, expone resultados acerca de cuáles de esas propiedades cumplen los estimadores que se ha aprendido a calcular. Las diferentes técnicas de inferencia estadística. La inferencia inductiva estadística, cuyos fines se expusieron en el tema anterior, se puede llevar a efecto a través de tres procedimientos diferentes, escogiéndose uno u otro según el tipo de resultado inductivo al que se quiera llegar. Son estos tres procedimientos los siguientes: estimación puntual; estimación por intervalos y regiones de confianza; y contraste de hipótesis. Realmente, procesos de carácter puramente inductivo son solamente los dos últimos, mientras que el primero sufre de algunas carencias que obligan a no considerarlo como tal. A pesar de ello, estudiaremos en este tema y en los siguientes, los tres, incluso el no estrictamente inductivo, ya que algunos de los resultados asociados a este último, son fundamentales para los otros dos. El proceso de estimación puntual consiste en lo siguiente. Sea c una cantidad –unidimensional– poblacional desconocida derivada de la distribución de la v.a. X que afecta a todos los individuos de la población. Supongamos que se precisa estimar c, esto es, obtener Prof. D. Juan José Pérez Castejón 2 una cantidad que aproxime lo mejor posible su verdadero valor. La forma habitual de conseguir esa estimación puntual pasa por seleccionar un estadístico muestral unidimensional T y tomar, como valor estimado de c, la realización muestral de T, t. Se dice entonces que ese estadístico T es el estimador –puntual– de c, ĉ = T . Si c no es unidimensional, sino que está compuesta de r componentes, c=(c1,...,cr), precisándose en ese caso una estimación de cada una de ellas, T entonces tendrá que tener el mismo número de componentes, T=(T1,...,Tr), empleándose Ti en la estimación de la correspondiente ci, ĉ i = Ti . Sea c de nuevo la cantidad unidimensional citada antes. Supongamos que mejor que una estimación puntual de c, lo que se requiere es determinar un intervalo de la recta real del que podamos tener un cierto grado de confianza de que contenga a c. En tal caso se dirá que lo que se busca es una estimación por intervalo de confianza de c. Para hacerla es preciso determinar dos estadísticos muestrales T1 y T2 adecuados, cuyas realizaciones muestrales sirvan para establecer los extremos inferior y superior del intervalo. La estimación por confianza también cubre el caso general en el que c=(c1,...,cr), precisándose entonces una región de Rr que contenga a c con un determinado nivel de confianza. El estadístico muestral que se escoja debe ser tal que su realización sirva para establecer los límites de esa región. No es necesario ser más preciso en la especificación del procedimiento para cantidades poblaciones de dimensión superior a 1 pues sólo se tratará ese caso, durante este curso, de manera marginal. El último de los tres procedimientos inductivos citados anteriormente, surge cuando lo que se plantea es cierta hipótesis acerca de c y existe la necesidad de desarrollar un criterio a partir del cual aceptar la validez o no de tal hipótesis. Se denomina contraste de hipótesis a una regla o criterio de decisión como el señalado. Los contrastes se construyen a partir de un estadístico muestral T, produciéndose la aceptación o rechazo de la hipótesis planteada según cuál sea el valor muestral de ese estadístico. El objetivo principal del presente tema es el de la introducción al primero de los tres procedimientos inductivos, el de la estimación puntual. A temas posteriores se retrasan introducciones análogas de los procedimientos de estimación por confianza y de contraste de hipótesis. Prof. D. Juan José Pérez Castejón 3 La mayor parte de la inferencia que se estudia en este tema y en los siguientes, es de tipo paramétrico. Se califica de esa manera a todo proceso inductivo que se lleva a cabo suponiendo de antemano que la variable –poblacional– X sigue cierta distribución – poblacional– continua o discreta, X~fπ(x) ó pπ(x), que ha sido especificada completamente excepto en lo que se refiere al valor de una cierta cantidad π, valor que es desconocido. π puede ser cierto número real o, incluso, un vector de k componentes, π=(π1,...,πk). Lo único que se conoce del valor de π es que cae dentro de cierto subconjunto de Rk, π∈Π⊆ Rk, subconjunto que se conoce con el nombre de espacio paramétrico. El fin general de la inducción paramétrica es aumentar la nuestro conocimientos sobre π mediante el análisis de la muestra de X disponible. La ventaja de la inferencia paramétrica radica en que los problemas que aborda pueden ser expresados siempre en términos del único elemento de la distribución poblacional desconocido, π, hecho que simplifica bastante todas las tareas a realizar. Como ya se ha dicho, de las técnicas que analicemos a continuación, solo una pequeña parte de ellas serán no parámetricas. Para concretar más este punto señalaremos que solo se revisarán algunas estimaciones de confianza de ese tipo, mientras que en lo que se refiere a los tests de hipótesis, uno de los dos temas dedicados a su presentación estará completamente inmerso en el ámbito no paramétrico. Hay que señalar también en este instante que los métodos que aquí revisaremos están situados dentro de la Inferencia Estadística Clásica, existiendo otra área de la Estadística Inductiva, la Estadística Inductiva Bayesiana, en la que no nos adentraremos. Como resultado de combinar el tipo de procedimiento inductivo que se estudia en este tema, la estimación puntual, con las hipótesis de partida de todas las técnicas paramétricas, podremos fijar ya de manera muy precisa el planteamiento y objetivos de las cuestiones y problemas que se tratan en las secciones siguientes. Supondremos que la variable poblacional es X~fπ(x) ó pπ(x) siendo π una cte. o vector de constantes de valor desconocido. Estaremos interesados en conseguir una estimación puntual de cierta cantidad poblacional de interés, c=h(π), cantidad que puede tener varias componentes h(π)=(h1(π),...,hr(π)). Las preguntas que surgen de forma inmediata son, ¿cómo seleccionar el estimador, ĥ( π) ?, ¿qué Prof. D. Juan José Pérez Castejón 4 propiedades debe tener el estimador seleccionado para asegurarnos de que proporcione una buena estimación?. Las secciones siguientes son las que se dedican a responderlas. Señalemos antes de empezar, dos características que deben cumplir los estimadores, características que no se han podido señalar mientras que no se ha formalizado adecuadamente la hipótesis paramétrica de partida. Por razones obvias, un estimador nunca podrá depender de parámetros desconocidos, y en particular, nunca podrá depender del propio π. Y también resulta obvio que los valores que el estimador de h(π) puede tomar, deben estar incluidos en h(Π) por ser este el conjunto donde se sabe que h(π) se encuentra. Métodos de estimación. Existen diferentes procedimientos para obtener estimadores. No siempre son todos aplicables a cualquier situación, dependiendo a veces el que se puedan emplear, de que se cumplan ciertas condiciones adicionales. Revisaremos a continuación dos de los de uso más general: el método de los momentos y el de máxima verosimilitud. Dos puntos importantes a tener en cuenta a la hora de decidir entre aplicar un determinado método de estimación u otro, son las posibilidades reales de poder llevar a efecto cada uno de ellos en la práctica, y las propiedades que tengan los estimadores que produzcan. Una vez que en secciones posteriores se analicen las propiedades deseables en los estimadores, se comentarán las que tienen los generados por los métodos de estimación que ahora se analicen. Por otro lado, si las dificultades técnicas permiten aplicar o no a una situación un método de estimación determinado, es algo que debe decidir el investigador combinando el análisis detenido de esa situación con su experiencia previa. METODO DE ESTIMACIÓN DE LOS MOMENTOS. Para presentar inicialmente este método, supondremos primero que la cantidad a estimar es el propio π, esto es, h(π)=π y k=r. Normalmente, es posible expresar las k componente de π en función de determinados momentos ordinarios de la distribución de Prof. D. Juan José Pérez Castejón 5 X. Supongamos por ejemplo, que eso se puede hacer recurriendo únicamente a sus k primeros momentos ordinarios. Si ello es así, tendremos π1=g1(E(X),E(X2),...,E(Xk)), ..., πk=gk(E(X),E(X2),...,E(Xk)). El estimador de los momentos de cada πi se obtendrá sustituyendo en esas expresiones cada momento ordinario por su estimación natural, esto es, por el momento ordinario muestral Ok: π̂1=g1(O1,...,Ok), ..., π̂k =gk(O1,...,Ok). Deben tenerse en cuenta dos puntos al aplicar lo señalado. Por un lado, como puede ocurrir que al expresar las πi como funciones de las E(Xi) sean válidas varias posibilidades según que se recurra a momentos de uno u otro orden, siempre se emplearán aquellas expresiones que empleen los momentos de ordenes más bajos posibles. Por otro, si de lo que se dispone son de igualdades que expresan las E(Xi) como función de las πi, al revés de cómo se indicó, las expresiones que se requieren se obtienen despejando los πi en esas igualdades. En general, cuando la cantidad a estimar h(π) es una función cualquiera de π, su estimador de los momentos se obtiene aplicando h a la estimación por los momento de π, ĥ (π)=h( π̂ ). METODO DE ESTIMACIÓN DE MÁXIMA VEROSIMILITUD. Igual que hicimos con el método de los momentos, la exposición de este otro método de estimación, comenzará por el caso en el que h(π)=π y k=r. Una idea intuitiva y bastante sencilla es la que subyace detrás del método de estimación de máxima verosimilitud, el mas popular y empleado de los métodos existentes. Con este método lo que se persigue es estimar como valor de π, aquel que hace mas probable (verosímil) la realización de la muestra que se observe. La mayor dificultad se va a encontrar a la hora de formalizar esa idea. El proceso de formalización se va a llevar a cabo a continuación. Sea una muestra (aleatoria o de cualquier otra clase) extraída de la población en estudio. Sea su función de probabilidad conjunta o su función de densidad, pπ(x1,....,xn) o fπ(x1,....,xn). De manera directa (caso discreto ) o proporcionalmente y de forma aproximada (caso continuo) esa función mide la probabilidad (verosimilitud) de que la muestra caiga en el punto (x1,....,xn) en el que se valore. Prof. D. Juan José Pérez Castejón 6 Como el tratamiento e interpretación que de ella se va a hacer, es el mismo tanto para poblaciones continuas como discretas, en lo que sigue adoptaremos siempre la notación del caso continuo y se escribirá siempre fπ(x1,....,xn), aunque sin perdida de generalidad pues todo lo que se diga será aplicable también al caso discreto. La anterior función es una función determinista que tiene una particularidad en la que hasta ahora hemos hecho poco hincapié. Además de depender de las n variables (x1,....,xn), también es función de π. Esa dependencia lo que indica es que según los diferentes valores que puede tomar el parámetro desconocido, la probabilidad de que la muestra valga (x1,....,xn) es diferente, mayor o menor. Como función de él, se comporta como otra función ordinaria cualquiera, por ejemplo, tendrá sus asíntotas, maximos, minimos, opcionalmente será derivable, etc. Si se valora ahora esa función, no en el punto (x1,....,xn) que se desee, sino en lo que la muestra valga, (X1,...,Xn), obtenemos una función que se denota como Lπ(X1,...,Xn)=fπ(X1,...,Xn). Dos hechos caracterizan a Lπ. Por una lado, el que sea una variable aleatoria pues el valor que toma dependerá de lo que a su vez valga la muestra, siendo el valor de esta última una cantidad de carácter totalmente aleatorio sin duda. Por otro lado, Lπ(X1,...,Xn), por la interpretación de la función de densidad o probabilidad conjunta comentada antes, medirá la probabilidad de que la muestra tome el valor que de ella se observe. Lπ(X1,...,Xn) se conoce como la función de verosimilitud de la muestra. Si alguna vez tenemos que manejar al mismo tiempo Lπ(X1,...,Xn) y la función Lπ(x1,...,xn)=fπ(x1,...,xn) ó pπ(x1,...,cn) definida inicialmente, las distinguiremos entre sí denominándolas, respectivamente, la versión aleatoria y determinista de la función de verosimilitud. Una vez definida Lπ, la estimación de π que se buscaba, se obtendrá sencillamente tomándola igual al valor de esa variable que maximiza Lπ: πˆ = arg max L π ( X1,..., Xn ) . El estimador π̂ así obtenido, π∈Π se conoce como el estimador máximo–verosímil (e.m.v. de π). El problema de maximización planteado en la definición anterior, es el que al ser resuelto, elimina la dependencia de π que presenta y permite que el estadístico muestral Lπ Prof. D. Juan José Pérez Castejón 7 arg max L π ( X1,..., Xn ) sea, inicialmente, un estadístico aceptable π∈Π para ser usado como estimador pues no depende de parámetros desconocidos. Por otro lado, resulta obvio que el mayor problema técnico que presentará la aplicación de la definición anterior, será precisamente la resolución de ese problema. Podríamos encontrarnos con un rango de situaciones que va desde las que no poseen solución, hasta las que poseen más de una. Hagamos a continuación algunos comentarios que pueden ser muy útiles para la tarea que hay que realizar: 1.- Como la función logaritmo es una función creciente y Lπ(X1,...,Xn)>0 siempre, se dará la igualdad siguiente: arg max logL π ( X1,..., Xn ) = arg max L π ( X1,..., Xn ) . Por otro lado, la π∈Π π∈Π experiencia demuestra que resolver la maximización de logLπ(X1,...,Xn) suele ser más sencillo que la de Lπ(X1,...,Xn). Como norma, optaremos por resolver siempre la maximización de logLπ. 2.- En este problema, se puede emplear las técnicas estándar de optimización. En especial, es aconsejable recurrir a resolver las condiciones de primer orden ( ∂L π ∂πi = 0 ) contrastando, mediante las de segundo orden, que la solución que se obtenga sea un máximo y no un mínimo. Sin embargo, hay que recordar que el uso de estas condiciones está sujeto a algunas limitaciones y cuidados. Destaquemos, que por un lado, un máximo solo está obligado a cumplirlas si tal máximo es realmente un punto interior del recinto de maximización, en este caso, Π. Mientras que, por otro lado, el cumplir las condiciones de primer y segundo orden no es condición necesaria de ser el máximo absoluto de una función, pudiéndose tratar solamente de un máximo local. Cuando la cantidad a estimar sea una función cualquiera h(π) del parámetro desconocido, el método correcto de estimación pasaría por redenominar a esa cantidad con otro nombre, por ejemplo, λ=h(π) y hacer una reparametrización de Lπ en términos de λ –y de parámetros adicionales si fuera preciso–. Una vez conseguido ese objetivo, se debería comenzar el proceso de estimación de λ desde el principio siguiendo todo el procedimiento explicado. Prof. D. Juan José Pérez Castejón 8 Existe un caso importante en el que el procedimiento de estimación de h(π) explicado puede obviarse. Se trata de aquel en el que h sea una función inyectiva (y por ello, biyectiva sobre el nuevo espacio paramétrico, Λ=h(Π), al que pertenece λ). Si se da esa circunstancia y ya se ha hallado el estimador máximo–verosímil de π̂ , es fácil demostrar que entonces el estimador de h(π) cumple que ĥ (π)=h( π̂ ). Propiedades de los estimadores. Como ha quedado establecido desde un principio, la estimación de h(π) no pretende coincidir con exactitud con el valor de esa cantidad, sino solo dar una buena aproximación – estimación– de ella. El anterior comentario queda reforzado aún más por el siguiente hecho. La estimación se extrae del valor de la realización muestral de un estadístico dado, y por ello lo que vale no será lo mismo según cual sea la realización que se obtenga al extraer la muestra. Si ese valor ni siquiera es siempre el mismo en todas las realizaciones muestrales posibles, no se puede pretender tampoco que sea igual a la cantidad a estimar. Llegados a este punto conviene entonces plantearse la siguiente cuestión. Puesto que la estimación que se obtenga va a depender de la realización muestral de cierto estimador, ¿qué propiedades se le deben exigir a ese estimador para estar seguro de que tales realizaciones –al menos un alto porcentaje de ellas– sean una buena estimación de h(π)? Resolver una cuestión como esa traerá otros beneficios adicionales. En la sección anterior quedaba abierta la cuestión de qué criterios pueden seguirse a la hora de seleccionar un método de estimación u otro. Claramente, el escoger aquel que genere los estimadores de mejores propiedades debe ser uno de tales criterios, y de hecho debe ser uno de los de mayor importancia. PROPIEDAD DE INSESGADEZ. Como se ha razonado, no tiene sentido exigirle a un estimador que su realización muestral sea igual a h(π). Si no se le puede exigir tal cosa, sí que parece aconsejable que por lo menos se le pida que Prof. D. Juan José Pérez Castejón 9 si consideramos la media de todas sus realizaciones a lo largo de todas las muestras posibles –esto es, su esperanza– con ella obtengamos el valor que se quiera estimar. Esta propiedad es la que se conoce como la de insesgadez: Eπ(ĥ (π))=h(π). En caso de darse, al estimador se le califica de estimador insesgado. Hay que notar que como la distribución de la muestra depende del parámetro desconocido, ya que así ocurría con la de X, pasa lo mismo con la distribución de cualquier estadístico y con cualquiera de sus características, en particular con su esperanza Esto último, en la igualdad anterior se hace notar mediante el subíndice π. Como el verdadero valor de π es desconocido, la insesgadez de un estimador se dará solo si la igualdad anterior se cumple para ∀π. Es posible incluso relajar aún más lo que exige la propiedad de insesgadez. Aunque la igualdad Eπ(ĥ (π))=h(π) no se cumpla de manera exacta, puede bastar con que se cumpla de manera aproximada, siendo tal aproximación mayor cuanto mayor sea la información muestral de la que se disponga –tamaño muestral–. Dicho de otra forma, también es admisible la propiedad de insesgadez asintótica: limnÆ∞Eπ(ĥ (π))=h(π). La insesgadez, al menos asintótica, es una las propiedades mínimas exigibles a un estadístico para que pueda ser considerado estimador de h(π). Conviene hacer en este momento un alto para establecer cierta terminología muy empleada al tratar las propiedades de los estimadores. Propiedades como la insesgadez, que se cumple para todo n independientemente de cómo de grande o pequeña sea esa cantidad, se denominan propiedades de muestra finita. Por su lado, las que son del tipo de la insesgadez asintótica, que lo que suponen es una aproximación más cierta cuanto mayor sea el tamaño muestral, se las conoce como propiedades asintóticas o de muestra grande. PROPIEDAD DE CONSISTENCIA. Aun siendo la insesgadez un requisito mínimo a exigir, no es sin embargo una propiedad que por sí sola garantice un estimador aceptable. Aunque la media del estimador sea igual a h(π), eso no garantiza que sus realizaciones muestrales no se alejen con Prof. D. Juan José Pérez Castejón 10 frecuencia de esa media, con lo que se permite la posible existencia de una alta probabilidad de estimaciones inexactas. Lo que se acaba de señalar viene a indicar que también se requiere una propiedad que controle el alejamiento entre los valores de ĥ (π) y h(π). Veamos qué propiedad puede ser esa, centrándonos primero en el caso en el que r=1 con lo que el estimador y la cantidad a estimar son ambos unidimensionales. Mas tarde la extenderemos al caso general. Aunque la distancia citada en los párrafos anteriores parece medida de manera natural por la cantidad |ĥ (π)–h(π)|, si en su lugar consideramos esta otra, (ĥ (π)–h(π))2, obtendremos al final una medida de mejores propiedades algebraicas y estadísticas. Puesto que esa cantidad, que mide la distancia cuadrática entre h(π) y su estimación, es una magnitud que varia de muestra en muestra, y nuestro propósito es hacerla pequeña para el conjunto de todas las muestras, parece bastante evidente que nuestro interés debe dirigirse a hacer pequeña su media, esto es, E(ĥ (π)–h(π))2. A partir de ahora a tal media la denominaremos error cuadrático medio asociado al estimador ĥ (π), ECM de ĥ (π). Intuitivamente debe entenderse como la distancia o diferencia cuadrática media –a lo largo de todas las muestras posibles– existente entre la cantidad a estimar y su estimación. Como ya se ha señalado, lo que interesa del ECM de un estimador es hacerlo pequeño. De todas formas, como no podemos hablar de una cantidad lo suficientemente pequeña que en cualquier problema pueda considerarse una cota aceptable del ECM, quizá sea mejor enfocar la propiedad buscada desde otro punto de vista ligeramente diferente. Lo que se puede exigir al estimador es que aumentando lo suficiente la información muestral disponible –esto es, aumentando el tamaño muestral–, el ECM se haga todo lo pequeño que se precise. Tal cosa implica que limnÆ∞ECM=0. Diremos que un estimador es consistente cuando cumpla esa igualdad asintótica. Es muy fácil demostrar la descomposición del ECM de cualquier estimador en la suma de las dos cantidades mayores o iguales que cero siguientes: ECM=var(ĥ (π))+(Eπ(ĥ (π))-h(π))2. Gracias a ella se puede concluir que condición necesaria y suficiente para que un estimador sea consistente, es que sea Prof. D. Juan José Pérez Castejón 11 asintóticamente insesgado además de tener una varianza que tienda a cero si n→∞. En el caso de estimadores insesgados, se tendrá que ECM=var(ĥ (π)) y para demostrar su consistencia, bastará con comprobar que su varianza tienda a cero. Otra forma de entender la consistencia se obtiene al apreciar que su definición lo que exige es que la sucesión ĥ (π), que varía con el tamaño muestral, converja en media cuadrática a h(π). Cuando en temas anteriores se definieron los diferentes tipos de convergencia de una sucesión de vv.aa., se razonó que la consecuencia más importante de la convergencia en m.c. a una constante es que la sucesión de variables se concentre cada vez más y con mayor probabilidad alrededor de esa constante, conforme n crece. Existe una definición alternativa de la propiedad de consistencia, que lo único que requiere de ĥ (π) es que converja en probabilidad a h(π). Podemos diferenciar una y otra definición entre sí, llamandolas, respectivamente, consistencia en probabilidad y en m.c. Obviamente, la consistencia en m.c. implica consistencia en probabilidad. El nuevo tipo de consistencia se basa en una definición menos exigente que la expuesta inicialmente, y sin embargo ambas tienen la misma implicación fundamental sobre el comportamiento del estimador. De todas formas, nosotros hemos adoptado, como definición, la más estricta basada en la convergencia en m.c., pues a nuestro nivel, lo estimadores que empleemos serán consistentes en ambos sentidos y siempre es mas sencillo el trabajo con la consistencia en m.c. Cuando h(π) sea todo un vector de r componente diferentes, la definición de consistencia se extiende de forma natural exigiendo la consistencia de cada una de las r componentes de su estimador. Así, diremos que ĥ (π) es un estimador consistente de h(π), si cada una de sus componentes ĥ i(π) lo es de la correspondiente hi(π). PROPIEDAD DE EFICIENCIA Y DE MINIMA VARIANZA. La propiedad de insesgadez –asintótica al menos– y de consistencia, pueden considerarse como las propiedades mínimas exigibles a un estimador para ser considerado como tal. Se necesitaría ahora una propiedad adicional que permitiera seleccionar entre estimadores cuando hay disponibles varios de Prof. D. Juan José Pérez Castejón 12 ellos que cumplan esos requisitos mínimos. Una propiedad así es la que se analizará en esta sección. Para simplificar, supondremos que tanto π como h(π) son cantidades unidimensionales. Al final de la sección, levantaremos en parte esas restricciones. Lo que se hecha en falta es un criterio que ayude a comparar estimadores entre sí. Tal criterio lo puede suministrar el ECM asociado a un estimador y que ya empleamos antes. Antes de seguir, modifiquemos un poco la forma de denotarlo. Puesto que será necesario, en aquellas referencias al ECM en las que se precise añadiremos dos símbolos que nos recuerden que el valor de esa cantidad depende del parámetro y que se trata del error asociado a un determinado estimador: ECMπ(ĥ (π)) Ya que el ECM es una medida del error cometido al estimar h(π), parece bastante lógico escoger para trabajar, aquellos estimadores con menor ECM. Por ello, dados dos estimadores ĥ 1(π) y ĥ 2(π), diremos que el primero es mejor que el segundo si ECMπ(ĥ 1(π))<ECMπ(ĥ 2(π)). Esa desigualdad debe ser cierta ∀π. Cuando la clase de los estimadores a considerar se restringe aún un poco más, y se descartan todos aquellos que no son insesgados en muestra finita, es posible ahondar más en la definición anterior, y buscar el mejor de todos ellos. Dado un determinado ĥ (π) insesgado, diremos que es el estimador insesgado de mínima varianza uniformemente (e.i.m.v.u.) si para cualquier otro ĥ ’(π) se cumple que ECMπ(ĥ (π))≤ECMπ(ĥ ’(π)). Esa desigualdad debe ser cierta ∀π. La definición de e.i.m.v.u. resulta muy atractiva. Caso de existir, el e.i.m.v.u. es claramente el estimador que debería emplearse para estimar h(π). Hay que advertir, sin embargo, que la definición no nos asegura la existencia del e.i.m.v.u. Dos condiciones implícitas se exigen en ella. Por un lado, para que exista el e.i.m.v.u. debe existir una cota inferior para la varianza de los estimadores insesgados de h(π). Esa cota variará con π y si se denota como COTA(π), debe cumplir que COTA(π)≤ECMπ(ĥ ’(π)) ∀π y ∀ĥ ’(π) insesgado. Pero además, debe ocurrir también que exista un estimador específico, ĥ (π), que será el e.i.m.v.u., que alcance expresamente esa cota: Prof. D. Juan José Pérez Castejón 13 COTA(π)=ECMπ(ĥ (π)) ∀π. En el momento en el que una de esas dos condiciones no se dé, y esto es factible que ocurra, no existiría tampoco el e.i.m.v.u. Cabe preguntarse hasta qué punto existen resultados que aseguren el cumplimiento de una u otra de las dos condiciones comentadas en el párrafo anterior. Esta cuestión ha sido analizada y fruto de su análisis surgió un resultado estadístico muy importante, el Teorema de Frechet, Cramer y Rao (FCR), que a continuación vamos a exponer. Su enunciado exige primero establecer las condiciones que debe cumplir una determinada situación estadística para que el teorema pueda ser aplicado. Esa es la tarea inicial que realizaremos aunque de manera muy resumida. Después enunciaremos el teorema en sí. Para empezar, indiquemos que seguiremos suponiendo todas las hipótesis que se han venido comentando referidas a la estimación que se pretende: las que afectan a la dimensión de π y de h(π), etc. Añadamos la condiciones siguientes: a) La distribución de la v.a. poblacional cumple que el conjunto donde su función de densidad o de probabilidad no se anula, es independiente de π. Por su lado, el espacio paramétrico Π debe ser un conjunto abierto, acotado o no –subconjunto de R mientras sigamos suponiendo que π es unidimensional–. b) La esperanza E( ∂ ln L π ( X) ∂π )2 existe. En esa expresión se emplea el símbolo de derivada parcial, ∂, en lugar del derivada total que sería mas correcto al suponer π unidimensional. Lo hacemos para que al tratar después el caso de π multidimensional, las mismas expresiones que ahora se escriban sigan siendo válidas. c) Son ciertas varias condiciones de ‘regularidad’ generales adicionales que no enunciaremos de manera detallada. Supuesto que todo lo anterior se cumple, el teorema comentado afirma: Prof. D. Juan José Pérez Castejón 14 Teorema (cota FCR).- Si ĥ (π) es un estimador insesgado entonces varπ(ĥ (π))=ECMπ(ĥ (π)) es ∀π mayor o igual que la siguiente cota: cotaFCR(π)=( ∂h( π) ∂π )2/(–E( ∂ 2 ln L π ( X1,..., Xn ) ∂ 2 π )) Además un cierto estimador ĥ (π) insesgado cumplirá que su varianza es de hecho igual a esa cota –y por ello será el e.i.m.v.u– si y solo si es cierta la siguiente descomposición: ∂ ln L π ( X1,..., Xn ) ∂π = (ĥ (π)-h(π))g(π) donde g(π) representa una función que no puede depender de las Xi pero sí de π. El importante teorema anterior debe entenderse y usarse correctamente, y no emplearlo para obtener conclusiones falsas. En primer lugar, antes de aplicarlo, deberá comprobarse la veracidad de sus condiciones de aplicación. Caso de no darse esas condiciones, debe tenerse presente que la cotaFCR no es relevante, y que el hecho de que un estimador la alcance ya no nos asegura nada. Una vez comprobado que las condiciones de aplicación son ciertas, deberá calcularse la cotaFCR, que sería ya una cota inferior de la varianza de todos los estimadores insesgados de h(π). En este punto, sabríamos que la primera condición de existencia del e.i.m.v.u. –la de la existencia de cota– se da. La pregunta a contestar a continuación es si algún estimador insesgado es tal que su varianza iguale a la cota hallada –segunda condición para que exista el e.i.m.v.u.–. Para ello nos podemos ayudar de las descomposición indicada en el enunciado del teorema. Una respuesta afirmativa a esta nueva cuestión, daría lugar a la finalización con éxito de nuestra búsqueda. Sin embargo, una respuesta negativa a esta segunda cuestión no debe llevar a la negación de la existencia del e.i.m.v.u. Realmente, quedarían abiertas dos posibilidades y no podríamos decidir cuál es la cierta, al menos empleando únicamente el teorema FCR para hacerlo. La primera posibilidad es que el e.i.m.v.u. exista pero su varianza sea superior a la cotaFCR, por lo que no la habríamos detectado nosotros. La segunda posibilidad es que realmente no exista e.i.m.v.u. Prof. D. Juan José Pérez Castejón 15 Como se ve, hay dos características que no son siempre equivalentes: “ser e.i.m.v.u” y “que la varianza alcance la cota”. Añadamos por ello una definición adicional: un cierto estimador ĥ (π) se dice eficiente si varπ(ĥ (π))=cotaFCR(π) ∀π. Merece la pena incluir ahora dos notas de tipo técnico, que ayuden a aplicar del teorema enunciado: 1.– De entre sus condiciones previas, solo contrastaremos inicialmente y de forma expresa, la que se refiere al dominio donde se anula la función de densidad o probabilidad de la población. La comprobación de las restantes condiciones va implícita en el desarrollo de los pasos posteriores. 2.– El denominador de la cota FCR, siempre de difícil cálculo, tiene una expresión alternativa. Se cumple que: –E( ∂ 2 ln L π ( X1,..., Xn ) ∂ 2 π )=E( ∂ ln L π ( X1,..., Xn ) ∂π )2 Si además estamos trabajando con una m.a.s, existen otras dos expresiones alternativas para él: –nE( ∂ 2 ln L π ( X) ∂ 2 π ) y nE( ∂ ln L π ( X) ∂π )2 En cada problema puede emplearse aquella que resulte más fácil de aplicar. Para terminar esta sección, vamos a eliminar las restricciones sobre π y h(π) –que ambas sean unidimensionales– con las que al principio encorsetábamos todo lo explicado. Lo haremos minimamente, pero asegurándonos, al menos, de no dejar fuera por completo un caso importante, el caso normal en el que π=(µ,σ). Para ello permitiremos que π tenga la dimensión que sea aunque mantendremos el hecho de que h(π) sea unidimensional añadiendo la restricción de que sea función solo de una determinada componente de π: h(π)=h(πi). En este caso, lo que ocurre es que todo lo comentado sigue siendo totalmente válido y solo hay que saber que en la expresiones anteriores en las que aparecen derivadas parciales respecto de π, deben estas sustituirse por derivadas parciales respecto de la componente πi que interviene en h(πi). Prof. D. Juan José Pérez Castejón 16 PROPIEDAD DE SUFICIENCIA. La propiedad de suficiencia no es tanto una propiedad de los estimadores, sino que se plantea para los estadísticos en general. Y tampoco está directa y únicamente dirigida a la estimación de una función de h(π), sino que está relacionada con el problema de la inferencia sobre π en general, independientemente del tipo de proceso inductivo que se emplee para llevarla a cabo. De todas maneras, la incluimos aquí de forma que esta sección se convierta en una pequeña revisión de algunas de las propiedades más relevantes relacionadas con la cuestión de la inducción estadística. Podemos cifrar el origen de la necesidad de disponer de estadísticos suficientes, en lo siguiente. Manejar una muestra completa puede convertirse en algo pesado por la gran cantidad de datos que puede incluir. Cabe preguntarse hasta qué punto es posible encontrar un estadístico con las componentes necesarias de forma que sus valores muestrales aporten la misma información sobre el parámetro π que la que aporta la propia muestra. Si se pudiera hallar, tendríamos que el conjunto de toda la muestra se puede resumir y sustituir por los valores del estadístico, sin perder la información relevante que aquella incluía sobre el parámetro. Con ello conseguiríamos seguramente un notable ahorro de medios: tiempo, dinero, .... De nuevo encontramos aquí una idea muy sugerente pero cuya formalización resulta complicada. Son varios los elementos que tenemos que expresar en términos estadísticos. Primero está la idea de ‘información sobre π suministrada por la muestra’. Notemos que en el hecho de que la densidad o probabilidad conjunta de la muestra dependa de π, es aquel en el que hasta ahora nos hemos basado –y así seguiremos haciendo– para obtener conclusiones sobre ese parámetro. Piénsese en los métodos de estimación ya explicados. La información a resumir aportada por la muestra se concentra pues en la dependencia respecto de π de fπ(x1,...,xn) –o de pπ(x1,...,xn) en el caso discreto–. Por otro lado, una vez conocido el valor muestral t que presente determinado estadístico T, la información sobre π que queda en la muestra una vez eliminada la que va asociada al propio t, la aportaría la función de densidad –probabilidad– condicionada fX1,...,Xn/T=t,π(x1,...,xn) –pX1,...,Xn/T=t,π(x1,...,xn)–. Prof. D. Juan José Pérez Castejón 17 Esta última función condicionada, en principio, podría depender del parámetro desconocido ya que las distribuciones originales así lo hacen. De hecho, si esa dependencia se da de forma efectiva, encontraríamos que incluso extrayendo la información aportada por T, en la muestra aún queda información relevante para π. Podemos ya definir el concepto de estadístico suficiente. Dada una muestra X1,...,Xn de cierta población X que se distribuye según fπ(x) ó pπ(x), el estadístico muestral T se dice que es un estadístico suficiente para π si fX1,...,Xn/T=t,π(x1,...,xn) ó pX1,...,Xn/T=t,π(x1,...,xn) es, de hecho, una función realmente independiente del parámetro desconocido π. Tres puntos adicionales deben de precisarse aún en esa definición: 1.– Para que realmente el valor muestral de T sea un valor conocido y pueda ser empleado en la práctica, en sustitución de la realización completa de la muestra disponible, x1,...,xn, T debe ser un estadístico cuya fórmula también esté libre de parámetros desconocidos, como ya dijimos que debe ocurrir, por ejemplo, con un estadístico que se piense usar como estimador. 2.- La independencia respecto de π de la función de densidad o de probabilidad condicionada, debe comprobarse para todo valor posible, lo que implica que debe ser cierta ∀(x1,...,xn), incluso, por ejemplo, para aquellos en los que se anula, y ∀t al que sea posible condicionar. 3.– T es un estadístico con la dimensión necesaria, dimensión que no tiene por qué ser ni 1 ni igual a la de π. Por otro lado, si T resultara ser de la misma dimensión que π, tampoco debe entenderse que entonces cada componente Ti pueda ser suficiente para cada πi ni nada similar. La única definición que se ha hecho es la que determina si un cierto T es suficiente de manera conjunta para el parámetro π, tenga este la dimensión que sea. En la práctica, hallar candidatos a estadístico suficientes y comprobar si lo son, empleando la definición de suficiencia, es una tarea complicada incluso en el caso de las distribuciones mas Prof. D. Juan José Pérez Castejón 18 sencillas. El siguiente resultado propone otro método mas simple de encontrar estadísticos suficientes : Teorema (criterio de factorizacion): En las condiciones que se vienen planteando, el estadístico T(X1,...,Xn) definido a partir de la función determinista T(x1,...,xn), es suficiente para π si y solo si es cierta una descomposición como la que sigue: fπ(x1,...,xn) ó pπ(x1,...,xn) = h(x1,...,xn)gπ(T(x1,...,xn)) La descomposición anterior debe ser cierta en todo vector (x1,...,xn). En ella, h representa una función que no puede depender de π. Por su lado, g sí depende de π pero en cambio, no depende directamente de las (x1,...,xn), sino que lo hace a través de una función de ellas, en concreto de la misma función con la que se define T. Intuitivamente, lo que exige la descomposición anterior es que la dependencia respecto de las (x1,...,xn) que f presente de manera conjunta e inseparable de π, se pueda expresar realmente en términos de T, mientras que el resto de dependencia de las (x1,...,xn), está libre de π. Una última propiedad de los estadísticos suficientes afirma lo siguiente: Teorema: Si T es un estadístico suficiente y g es una aplicación inyectiva de la dimensión adecuada, entonces g(T) también es suficiente. PROPIEDAD DE FAMILIA EXPONENCIAL. Tal y como se hizo en el apartado anterior, en este de ahora se comenta una propiedad, que más que estar específicamente relacionada con la estimación puntual, lo está con todo el conjunto de técnicas de la inferencia estadística. Examinaremos una propiedad de ciertas familias de distribuciones, la propiedad de familia exponencial. En lo que sigue, llamaremos familia de distribuciones a un conjunto de distribuciones estadísticas que tienen una función de densidad o de probabilidad que puede ser expresada según una formula general común. Todos los elementos que intervienen en esa fórmula están perfectamente identificados, a excepción de un cierto conjunto de parámetros, conjunto que representaremos por π. Prof. D. Juan José Pérez Castejón 19 Precisamente es π quien al ir tomando sus diferentes valores posibles, va generando las diferentes funciones de probabilidad o de densidad de las distribuciones que componen la familia. fπ(x) ó pπ(x) designará a la fórmula general a la que se ajusta la función de densidad o de probabilidad de las distribuciones pertenecientes a la familia que se analice. Aunque nos limitaremos a trabajar con distribuciones unidimensionales, π=(π1,...,πk) podrá tener la dimensión necesaria. El concepto que se acaba de definir, no es realmente nada nuevo y desconocido. Todas las distribuciones en su momento estudiadas, tales como las diferentes distribuciones de Bernouilli que dependían de la probabilidad p de éxito, o las distribuciones normales que dependían de µ y σ, y así cualquier otra, son casos concretos de familias de distribuciones. Por otro lado, la hipótesis paramétrica sobre la que estamos desarrollando todo el análisis inductivo, lo que en el fondo hace es suponer que la distribución poblacional pertenece a una determinada familia de distribuciones. Una familia de distribuciones se dirá que es una familia k ∑ c i ( π )d i ( x ) exponencial si fπ(x) –ó pπ(x)– cumple: fπ ( x ) = a( π)b( x )e i=1 . Esa descomposición debe ser cierta ∀x y ∀π. Nótese que a(π) representa una función que depende de π pero no de x, mientras que con b(x) ocurre lo contrario. A su vez, en el exponente de la potencia aparecen, como máximo, tantos sumandos como componentes tiene π. Aunque el hecho de ser familia exponencial dota al correspondiente conjunto de distribuciones estadísticas de muy buenas propiedades, no emplearemos por ahora más este concepto. Solo pondremos un ejemplo que ilustre la relación entre las familias exponenciales y algunas de las restantes propiedades ya comentadas. Se trata de una propiedad de fácil demostración, que razona cómo obtener un estadístico suficiente si se dispone de una familia exponencial: Teorema: Dada una familia exponencial que cumpla una descomposición como la señalada, entonces el siguiente estadístico n n i =1 i =1 k dimensional es suficiente para π: T=( ∑ d1( Xi ) ,..., ∑ dk ( Xi ) ). Prof. D. Juan José Pérez Castejón 20 Propiedades de algunos de los estimadores obtenidos. Es conveniente cerrar el tema comprobando si los estimadores obtenidos mediante los métodos de estimación que se comentaron inicialmente, cumplen algunas de las propiedades que se han expuesto. Lo haremos solamente para el e.m.v. ya que es el estimador de uso más común, a la vez que el que mejor propiedades posee. Las propiedades del e.m.v. se derivan del resultado que se va a comentar a continuación. Podemos considerar que sus condiciones de aplicación son, básicamente, las de aplicación del teorema FCR. Haremos un enunciado parcial del resultado, recogiendo únicamente aquellos aspectos que precisemos para derivar las propiedades del e.m.v. que después se expongan. Teorema: El e.m.v. cumple que: L (ĥ (π)–h(π))/(cotaFCR(π))½ → N(0,1) Las implicaciones de este resultado suponen muy buenas propiedades para el e.m.v. Para empezar, la convergencia en ley indicada provoca que ĥ (π)≈(cotaFCR(π))½N(0,1)+h(π), siendo la aproximación entre el comportamiento probabilístico de los dos términos de esa expresión, más exacta cuanto mayor sea el tamaño muestral. Equivalentemente podemos expresar esa aproximación como ĥ (π)≈N(h(π),cotaFCR(π)). De tales aproximaciones, se deduce primero que limn→∞E(ĥ (π))=h(π), o lo que es lo mismo, que el e.m.v es asintóticamente insesgado. También podemos deducir que var(ĥ (π))≈cotaFCR(π) y que ambas series tendrán el mismo límite. Si se revisa la expresión de la cota, esta es una serie que converge a cero (véase, por ejemplo su fórmula cuando se maneja una m.a.s., aunque también es cierta la convergencia a cero para otro tipo de muestras). Así, se podrá decir que lo mismo ocurre con var(ĥ (π)) y que, por ello, el e.m.v. también es consistente. La propiedad de ser e.i.m.v.u. no tiene sentido plantearla en general para todo e.m.v. puesto que no hemos podido demostrar que sea insesgado. La propiedad de eficiencia tampoco será cierta Prof. D. Juan José Pérez Castejón 21 pues solo es var(ĥ (π))≈cotaFCR(π). Lo que sí que queda demostrado con esa proximación es que el e.m.v. es asintóticamente eficiente en el sentido de que su varianza y la cotaFCR se aproximan entre sí todo lo que queramos conforme aumenta el tamaño muestral. Muy útil es otro implicación derivada del resultado anterior. Nos referimos al comportamiento probabilístico normal –al menos asintóticamente– del e.m.v. En más de una ocasión en la que la distribución exacta en muestra finita de ese estimador no se conozca, saber al menos que si el tamaño muestral es grande esa distribución se puede aproximar bastante bien por la distribución normal, facilitará la realización de más de un procedimiento inductivo, aunque estaremos limitados a considerar que sus conclusiones son válidas solo como aproximación. Debe hacerse hincapié en que las propiedades comentadas son asintóticas –no son propiedades exactas en muestra finita– y basadas en aproximaciones. No es descartable que en situaciones particulares se demuestren propiedades más fuertes para el e.m.v., por ejemplo, insesgadez en vez de solo insegadez asintótica, etc. Al mismo tiempo, si se dispone de la versión exacta y no aproximada de una de estas propiedades –por ejemplo, la distribución exacta frente a la asintótica– siempre sería preferible usarla para realizar inferencia si ello es factible. Prof. D. Juan José Pérez Castejón 22