Perceptrón multicapa

Anuncio

Perceptrón multicapa

Diego Milone y Leonardo Rufiner

Inteligencia Computacional

Departamento de Informática

FICH-UNL

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Organización

Un poco de historia...

¿Cómo resolver el problema XOR?

Métodos de gradiente para el entrenamiento

Perceptrón multicapa

Retropropagación en el perceptrón multicapa

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Organización

Un poco de historia...

¿Cómo resolver el problema XOR?

Métodos de gradiente para el entrenamiento

Perceptrón multicapa

Retropropagación en el perceptrón multicapa

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Notas históricas

1957 Rosenblatt comienza el desarrollo del Perceptrón

(simple).

1960 Widrow y Hoff desarrollan el modelo Adaline

(ADAptative LINear Elements).

1969 Minsky y Papert prueban que el Perceptrón no es

capaz de resolver problemas sencillos (XOR).

1974 Werbos desarrolla la idea básica del algoritmo de

retro-propagación (BP).

1986 Rumelhart y Hinton redescubren y mejoran el

algoritmo de BP.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Organización

Un poco de historia...

¿Cómo resolver el problema XOR?

Métodos de gradiente para el entrenamiento

Perceptrón multicapa

Retropropagación en el perceptrón multicapa

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

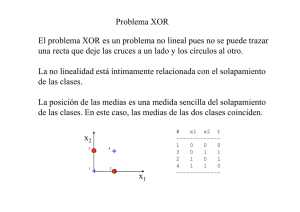

El problema del XOR

Figura: Representación gráfica del problema del OR exclusivo.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Combinación de perceptrones simples

¿Cómo podemos combinar dos o más PS para resolver el

problema XOR?

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Combinación de perceptrones simples

¿Cómo podemos combinar dos o más PS para resolver el

problema XOR?

Perceptrón A: x2 = −1 − x1

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Combinación de perceptrones simples

¿Cómo podemos combinar dos o más PS para resolver el

problema XOR?

Perceptrón A: x2 = −1 − x1 =

wA0

wA2

−

wA1

wA2 x1

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Combinación de perceptrones simples

¿Cómo podemos combinar dos o más PS para resolver el

problema XOR?

− wwA1

x1

Perceptrón A: x2 = −1 − x1 = wwA0

A2

A2

wA0 = −1

wA1 = +1

→ yA = sgn(x2 + x1 + 1)

→

wA2 = +1

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Combinación de perceptrones simples

¿Cómo podemos combinar dos o más PS para resolver el

problema XOR?

− wwA1

x1

Perceptrón A: x2 = −1 − x1 = wwA0

A2

A2

wA0 = −1

wA1 = +1

→ yA = sgn(x2 + x1 + 1)

→

wA2 = +1

Perceptrón B: x2 = +1 − x1

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Combinación de perceptrones simples

¿Cómo podemos combinar dos o más PS para resolver el

problema XOR?

− wwA1

x1

Perceptrón A: x2 = −1 − x1 = wwA0

A2

A2

wA0 = −1

wA1 = +1

→ yA = sgn(x2 + x1 + 1)

→

wA2 = +1

Perceptrón B: x2 = +1 − x1

wB0 = +1

wB1 = +1

→

→ yB = sgn(x2 + x1 − 1)

wB2 = +1

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Combinación de perceptrones simples

Perceptrón C: yA = +1 + yB

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Combinación de perceptrones simples

Perceptrón C: yA = +1 + yB

wC0 = +1

wC1 = −1

→

→ yC = sgn(yA − yB − 1)

wC2 = +1

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Combinación de perceptrones simples

Perceptrón C: yA = +1 + yB

wC0 = +1

wC1 = −1

→

→ yC = sgn(yA − yB − 1)

wC2 = +1

¿Cómo es la arquitectura

de esta red neuronal?

yA = sgn(x2 + x1 + 1)

→ yC = sgn(yA − yB − 1)

yB = sgn(x2 + x1 − 1)

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Combinación de perceptrones simples

Perceptrón C: yA = +1 + yB

wC0 = +1

wC1 = −1

→

→ yC = sgn(yA − yB − 1)

wC2 = +1

¿Cómo es la arquitectura

de esta red neuronal?

yA = sgn(x2 + x1 + 1)

→ yC = sgn(yA − yB − 1)

yB = sgn(x2 + x1 − 1)

¿Resuelve el problema XOR?

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Combinación de perceptrones simples

Figura: (a) Arquitectura de una red para resolver el problema del

XOR. (b) Gráfico de flujo de señal de la red.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Combinación de perceptrones simples

Figura: (a) Límite de decisión construido por la neurona oculta 1 de la

red en la fig. anterior. (b) Límite de decisión construido por la

neurona oculta 2 de la red. (c) Límite de decisión construido por la

red completa.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Organización

Un poco de historia...

¿Cómo resolver el problema XOR?

Métodos de gradiente para el entrenamiento

Perceptrón multicapa

Retropropagación en el perceptrón multicapa

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Entrenamiento por el método de gradiente

• Concepto:

Mover los pesos en la dirección en que se reduce el error,

dirección que es opuesta a su gradiente con respecto a los

pesos

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Entrenamiento por el método de gradiente

• Concepto:

Mover los pesos en la dirección en que se reduce el error,

dirección que es opuesta a su gradiente con respecto a los

pesos

• Interpretación gráfica

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Entrenamiento por el método de gradiente

• Concepto:

Mover los pesos en la dirección en que se reduce el error,

dirección que es opuesta a su gradiente con respecto a los

pesos

• Interpretación gráfica

• Ecuación básica:

w(n + 1) = w(n) − µ∇w ξ(w(n))

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Entrenamiento por el método de gradiente

• Concepto:

Mover los pesos en la dirección en que se reduce el error,

dirección que es opuesta a su gradiente con respecto a los

pesos

• Interpretación gráfica

• Ecuación básica:

w(n + 1) = w(n) − µ∇w ξ(w(n))

• Aplicación:

• Caso sencillo: perpectrón simple (least mean squares)

• Caso más general: perceptrón multicapa

(back-propagation)

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Organización

Un poco de historia...

¿Cómo resolver el problema XOR?

Métodos de gradiente para el entrenamiento

Perceptrón multicapa

Retropropagación en el perceptrón multicapa

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Extensión del algoritmo a múltiples capas

• Entrenamiento por gradiente en el ADALINE

• Entrenamiento por gradiente en el MADALINE

• Entrenamiento por gradiente en el caso general

• Regiones de decisión

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Regiones para varias capas

Figura: Diferentes problemas no-linealmente separables (Lippmann,

1987).

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

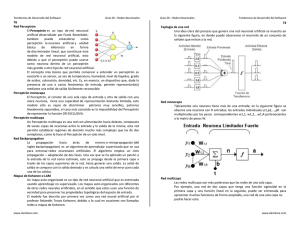

Arquitectura del perceptrón multicapa

Figura: Arquitectura de un perceptrón multicapa (PMC) con dos

capas ocultas.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Arquitectura del perceptrón multicapa

Figura: Ilustración de las dos direcciones básicas de flujos de señal

en un PMC.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Arquitectura del perceptrón multicapa

• Representación gráfica de 3 capas

• Cálculo de las salidas en cada capa

• Criterio: suma del error cuadrático instantáneo

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Cálculo de las salidas en cada capa

• Capa I:

N

P

wIji xi (completo vI = Wx)

vIj = wI , x =

i=0

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Cálculo de las salidas en cada capa

• Capa I:

N

P

wIji xi (completo vI = Wx)

vIj = wI , x =

i=0

yIj

=

φ(vIj )

=

2

I

1 + e−bvj

− 1 (simétrica ± 1)

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Cálculo de las salidas en cada capa

• Capa I:

N

P

wIji xi (completo vI = Wx)

vIj = wI , x =

i=0

yIj

=

φ(vIj )

• Capa II:

=

vIIj = wII , yI

2

I

1 + e−bvj

• Capa III:

III II vIII

j = w ,y

→

→

− 1 (simétrica ± 1)

yIIj = φ(vIIj )

III

yIII

j = φ(vj ) = yj

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Criterio de error

Suma del error cuadrático instantáneo

M

1X 2

ξ(n) =

e (n)

2 j=1 j

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Aplicación del gradiente (caso general)

∂ξ(n)

∆wji (n) = −µ ∂w

ji (n)

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Aplicación del gradiente (caso general)

∂ξ(n)

∆wji (n) = −µ ∂w

ji (n)

∂ξ(n)

∂ξ(n) ∂ej (n) ∂yj (n) ∂vj (n)

=

∂wji (n)

∂ej (n) ∂yj (n) ∂vj (n) ∂wji (n)

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Aplicación del gradiente (caso general)

∂ξ(n)

∆wji (n) = −µ ∂w

ji (n)

∂ξ(n)

∂ξ(n) ∂ej (n) ∂yj (n) ∂vj (n)

=

∂wji (n)

∂ej (n) ∂yj (n) ∂vj (n) ∂wji (n)

∂vj (n)

=

∂wji (n)

∂

N

P

wji (n)yi (n)

i=0

∂wji (n)

= yi (n)

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Aplicación del gradiente (caso general)

∂ξ(n)

∆wji (n) = −µ ∂w

ji (n)

∂ξ(n)

∂ξ(n) ∂ej (n) ∂yj (n)

yi (n)

=

∂wji (n)

∂ej (n) ∂yj (n) ∂vj (n)

Gradiente de error local instantáneo: δj =

∂ξ(n) ∂yj (n)

∂yj (n) ∂vj (n)

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Aplicación del gradiente (caso general)

∆wji (n) = µδj (n)yi (n)

∂ξ(n)

∂ξ(n) ∂ej (n) ∂yj (n)

=

yi (n)

∂wji (n)

∂ej (n) ∂yj (n) ∂vj (n)

Gradiente de error local instantáneo: δj =

∂ξ(n) ∂yj (n)

∂yj (n) ∂vj (n)

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Derivada de la función de activación simétrica (1/2)

∂yj (n)

∂vj (n)

∂

=

= 2

= 2

n

2

1+e−vj (n)

o

−1

∂vj (n)

e−vj (n)

1 + e−vj (n)

2

1

e−vj (n)

1 + e−vj (n) 1 + e−vj (n)

0

z }| {

1

−1 + 1 +e−vj (n)

= 2

1 + e−vj (n) 1 + e−vj (n)

1

= 2

1 + e−vj (n)

−1

1 + e−vj (n)

+

1 + e−vj (n) 1 + e−vj (n)

!

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Derivada de la función de activación simétrica (2/2)

∂yj (n)

∂vj (n)

=

=

=

=

=

1

1

2

1−

1 + e−vj (n)

1 + e−vj (n)

yj (n) + 1

yj (n) + 1

2

1−

2

2

yj (n) + 1

(yj (n) + 1) 1 −

2

2 − yj (n) − 1

(yj (n) + 1)

2

1

(yj (n) + 1)(yj (n) − 1)

2

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Aplicación del gradiente (caso general)

∆wji (n) = µδj (n)yi (n)

∂ξ(n)

∂ξ(n) ∂ej (n) ∂yj (n)

=

yi (n)

∂wji (n)

∂ej (n) ∂yj (n) ∂vj (n)

Gradiente de error local instantáneo: δj = −

δj =

∂ξ(n) ∂yj (n)

∂yj (n) ∂vj (n)

∂ξ(n) 1

(1 + yj (n))(1 − yj (n))

∂yj (n) 2

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Organización

Un poco de historia...

¿Cómo resolver el problema XOR?

Métodos de gradiente para el entrenamiento

Perceptrón multicapa

Retropropagación en el perceptrón multicapa

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Retropropagación en la capa III (salida)

III

II

∆wIII

ji (n) = µδj (n)yi (n)

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Retropropagación en la capa III (salida)

III

II

∆wIII

ji (n) = µδj (n)yi (n)

δjIII (n) = −

∂ξ(n) 1

III

(1 + yIII

j (n))(1 − yj (n))

2

(n)

∂yIII

j

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Retropropagación en la capa III (salida)

III

II

∆wIII

ji (n) = µδj (n)yi (n)

δjIII (n) = −

∂ξ(n) 1

III

(1 + yIII

j (n))(1 − yj (n))

2

(n)

∂yIII

j

δjIII (n) = −

∂ξ(n) ∂ej (n) 1

III

(1 + yIII

j (n))(1 − yj (n))

∂ej (n) ∂yIII

j (n) 2

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Retropropagación en la capa III (salida)

δjIII (n) = −

∂

n P

1

2

o

2

j ej (n)

∂ej (n)

·

n

o

∂ djIII (n) − yIII

j (n)

∂yIII

j (n)

1

III

· (1 + yIII

j (n))(1 − yj (n))

2

·

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Retropropagación en la capa III (salida)

δjIII (n) = −

∂

n P

1

2

o

2

j ej (n)

∂ej (n)

·

n

o

∂ djIII (n) − yIII

j (n)

∂yIII

j (n)

1

III

· (1 + yIII

j (n))(1 − yj (n))

2

III

F

δjIII (n) = 12 ej (n)(1 + yIII

j (n))(1 − yj (n))

·

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Retropropagación en la capa III (salida)

δjIII (n) = −

∂

n P

1

2

o

2

j ej (n)

∂ej (n)

·

n

o

∂ djIII (n) − yIII

j (n)

∂yIII

j (n)

1

III

· (1 + yIII

j (n))(1 − yj (n))

2

III

F

δjIII (n) = 12 ej (n)(1 + yIII

j (n))(1 − yj (n))

III

III

II

∆wIII

ji (n) = ηej (n)(1 + yj (n))(1 − yj (n))yi (n)

·

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación en la capa II (oculta)

∆wIIji (n) = µδjII (n)yIi (n)

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación en la capa II (oculta)

∆wIIji (n) = µδjII (n)yIi (n)

δjII (n) = −

∂ξ(n) 1

(1 + yIIj (n))(1 − yIIj (n))

∂yIIj (n) 2

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación en la capa II (oculta)

∆wIIji (n) = µδjII (n)yIi (n)

δjII (n) = −

δjII (n)

=−

∂ξ(n) 1

(1 + yIIj (n))(1 − yIIj (n))

∂yIIj (n) 2

∂

1 P

2

k ek (n)

∂yIIj (n)

2

1

(1 + yIIj (n))(1 − yIIj (n))

2

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación en la capa II (oculta)

∆wIIji (n) = µδjII (n)yIi (n)

δjII (n) = −

δjII (n)

=−

δjII (n) = −

∂ξ(n) 1

(1 + yIIj (n))(1 − yIIj (n))

∂yIIj (n) 2

∂

1

2

1 P

2

k ek (n) 1

(1 + yIIj (n))(1 − yIIj (n))

2

∂yIIj (n)

X ∂e2 (n) 1

k

(1 + yIIj (n))(1 − yIIj (n))

∂yIIj (n) 2

k

2

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación en la capa II (oculta)

∆wIIji (n) = µδjII (n)yIi (n)

δjII (n) = −

δjII (n)

=−

∂ξ(n) 1

(1 + yIIj (n))(1 − yIIj (n))

∂yIIj (n) 2

∂

1 P

2

k ek (n) 1

(1 + yIIj (n))(1 − yIIj (n))

2

∂yIIj (n)

X ∂e2 (n) 1

k

(1 + yIIj (n))(1 − yIIj (n))

∂yIIj (n) 2

k

2

1

2

X

∂ek (n) 1

δjII (n) = −

ek (n) II

(1 + yIIj (n))(1 − yIIj (n))

∂yj (n) 2

δjII (n) = −

k

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Retropropagación en la capa II (oculta)

δjII (n) = −

X

k

ek (n)

III

∂ek (n) ∂yIII

k (n) ∂vk (n) 1

(1+yIIj (n))(1−yIIj (n))

III

III

∂yk (n) ∂vk (n) ∂yIIj (n) 2

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Retropropagación en la capa II (oculta)

δjII (n) = −

X

k

δjII (n) = −

X

k

ek (n)

III

∂ek (n) ∂yIII

k (n) ∂vk (n) 1

(1+yIIj (n))(1−yIIj (n))

III

III

∂yk (n) ∂vk (n) ∂yIIj (n) 2

∂ dkIII (n) − yIII

1

k (n)

III

ek (n)·

· (1 + yIII

k (n))(1 − yk (n)) ·

III

2

∂yk (n)

nP

o

III yII (n)

∂

w

j kj j

1

·

· (1 + yIIj (n))(1 − yIIj (n))

II

2

∂yj (n)

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Retropropagación en la capa II (oculta)

δjII (n) = −

X

ek (n)

k

δjII (n) = −

X

k

III

∂ek (n) ∂yIII

k (n) ∂vk (n) 1

(1+yIIj (n))(1−yIIj (n))

III

III

∂yk (n) ∂vk (n) ∂yIIj (n) 2

∂ dkIII (n) − yIII

1

k (n)

III

ek (n)·

· (1 + yIII

k (n))(1 − yk (n)) ·

III

2

∂yk (n)

nP

o

III yII (n)

∂

w

j kj j

1

·

· (1 + yIIj (n))(1 − yIIj (n))

II

2

∂yj (n)

δjII (n) = −

X

k

1

III

ek (n)·(−1) · (1 + yIII

k (n))(1 − yk (n)) ·

2

1

II

II

·wIII

kj · (1 + yj (n))(1 − yj (n))

2

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación en la capa II (oculta)

δjII (n) =

X

k

1

III

III

ek (n) · (1 + yIII

k (n))(1 − yk (n)) · wkj ·

2

1

· (1 + yIIj (n))(1 − yIIj (n))

2

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación en la capa II (oculta)

δjII (n) =

X

k

1

III

III

ek (n) · (1 + yIII

k (n))(1 − yk (n)) · wkj ·

2

1

· (1 + yIIj (n))(1 − yIIj (n))

2

Pero de la capa IIIF sabemos que:

III

δkIII (n) = 12 ek (n)(1 + yIII

k (n))(1 − yk (n))

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación en la capa II (oculta)

δjII (n) =

X

k

1

III

III

ek (n) · (1 + yIII

k (n))(1 − yk (n)) · wkj ·

2

1

· (1 + yIIj (n))(1 − yIIj (n))

2

Pero de la capa IIIF sabemos que:

III

δkIII (n) = 12 ek (n)(1 + yIII

k (n))(1 − yk (n))

Reemplzando:

δjII (n) =

X

k

1

II

II

δkIII (n)wIII

kj · (1 + yj (n))(1 − yj (n))

2

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación en la capa II (oculta)

Volviendo a:

∆wIIji (n) = µδjII (n)yIi (n)

Retropropagación

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Retropropagación en la capa II (oculta)

Volviendo a:

∆wIIji (n) = µδjII (n)yIi (n)

Por lo tanto:

∆wIIji (n)

=η

P

k

δkIII wIII

kj (n)

(1 + yIIj (n))(1 − yIIj (n))yIi (n)

Introducción

Entrenamiento ∇ PS

XOR

Perceptrón multicapa

Retropropagación

Generalizando para la capa “p”

"

∆wIIji (n) = η

#

X

II

II

I

δkIII wIII

kj (n) (1 + yj (n))(1 − yj (n))yi (n)

k

⇓

E

D

(p)

(p+1)

(p)

(p)

(p−1)

∆wji (n) = η δ (p+1) , wj

(1 + yj (n))(1 − yj (n))yi

(n)

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Resumen del algoritmo de retropropagación (BP)

1. Inicialización aleatoria

2. Propagación hacia adelante (de la entrada)

3. Propagación hacia atras (del error)

4. Adaptación de los pesos

5. Iteración: vuelve a 2 hasta convergencia o finalización

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Ejemplo gráfico BP con PMC 3 capas

Figura: Ejemplo de un PMC de 3 capas.

Retropropagación

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Cálculo de las salidas en cada capa

Figura: Cálculo salida capa I, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Cálculo de las salidas en cada capa

Figura: Cálculo salida capa I, neurona 2.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Cálculo de las salidas en cada capa

Figura: Cálculo salida capa I, neurona 3.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Cálculo de las salidas en cada capa

Figura: Cálculo salida capa II, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Cálculo de las salidas en cada capa

Figura: Cálculo salida capa II, neurona 2.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Cálculo de las salidas en cada capa

Figura: Cálculo salida capa III, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Retropropagación en la capa III (salida)

Figura: Cálculo del error en capa III, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Retropropagación en la capa III (salida)

Figura: Propagación del error a la capa II, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Retropropagación en la capa III (salida)

Figura: Propagación del error a la capa II, neurona 2.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Retropropagación en la capa II (oculta)

Figura: Propagación del error a la capa I, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Retropropagación en la capa II (oculta)

Figura: Propagacion del error a la capa I, neurona 2.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Retropropagación en la capa II (oculta)

Figura: Propagación del error a la capa I, neurona 3.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Actualizando los pesos de la red

Figura: Actualización de pesos capa I, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Actualizando los pesos de la red

Figura: Actualización de pesos capa I, neurona 2.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Actualizando los pesos de la red

Figura: Actualizacion de pesos capa I, neurona 3.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Actualizando los pesos de la red

Figura: Actualización de pesos capa II, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Actualizando los pesos de la red

Figura: Actualización de pesos capa II, neurona 2.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Retropropagación

Ejemplo: Actualizando los pesos de la red

Figura: Actualización de pesos capa III, neurona 1.

Introducción

XOR

Entrenamiento ∇ PS

Perceptrón multicapa

Término de momento

Modificación adaptativa de la velocidad de aprendizaje.

(ver Haykin Sección 6.3)

Retropropagación