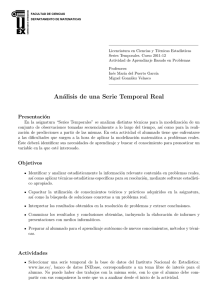

Introducción a la estimación con datos faltantes. Algoritmo EM para

Anuncio

Trabajo C Trabajos Curso 2012-2013 1 Introducción a la estimación con datos faltantes. Algoritmo EM para poblaciones normales 1. 1.1. Conceptos generales sobre datos faltantes Datos faltantes Las técnicas estadı́sticas estándar analizan conjuntos de datos que usualmente vienen dados por una matriz rectangular en la que las filas representan los individuos (casos) objeto de estudio y las columnas indican los valores de las variables medidas sobre cada individuo. Este tipo de presentación de los datos recibe el nombre de introducción por casos, en contraposición a la introducción por variables, la cual se obtiene sin más que trasponer la anterior matriz. No obstante, en las aplicaciones prácticas, dicha matriz de datos puede no estar completa, esto es, hay datos faltantes. Por ejemplo, en un experimento realizado en una cadena de montaje, pueden faltar algunos resultados debido a una averı́a en la cadena de producción. Otro ejemplo muy común de falta de datos ocurre en las encuestas de opinión; por ejemplo en una encuesta de intención de voto algunos individuos pueden no dar su preferencia por ninguno de los candidatos presentados. En el primer caso es natural tratar los valores no observados como perdidos o faltantes (missings) ya que existen valores subyacentes que podrı́an haberse observado si las técnicas de mantenimineto de la cadena de producción fueran mejores. En el segundo caso, sin embargo, es menos claro que se debiera tratar el valor no observado como perdido puesto que la no respuesta no marca ninguna preferencia por un candidato sino que representa un punto adicional en el espacio muestral de la variable en estudio (no sabe). La mayor parte del software estadı́stico identifica el estrato de no respuesta creando uno o más códigos especiales para aquellas entradas de la matriz de datos que no son observadas (no sabe, no contesta, valor fuera de rango,...). Algunos paquetes estadı́sticos excluyen a los individuos para los que no existen códigos para alguna de las variables. Esta estrategia es generalmente inapropiada ya que el investigador suele estar interesado en realizar inferencias sobre la muestra de forma completa antes que sólo sobre la porción que haya respondido a las variables objeto de estudio. Algunas de las técnicas aquı́ presentadas están implementadas en paquetes estadı́sticos, como el capı́tulo AM de BMDP. 1.2. Una clasificación de métodos con datos parcialmente perdidos La literatura sobre análisis de datos parcialmente perdidos es relativamente reciente: Afifi y Elashoff (1966), Hartley y Hocking (1971), Orchard y Woodburg (1972), Dempster, Laird y Rubin (1977), Little (1982),... La siguiente es una clasificación dada en un sentido amplio, con categorı́as no excluyentes. Procedimientos basados en casos completos. En estos métodos se elimina los individuos para los que existe algún dato faltante, tratando sólo con aquellos con casos completos. Esta estrategia puede resultar satisfactoria si hay pocos datos faltantes y hay que tener en cuenta que, en general, puede conducir a importantes sesgos y no es esencialmente eficiente. Procedimientos de imputación. Análisis Multivariante. 3o Grado en Estadı́stica Trabajo C Trabajos Curso 2012-2013 2 Los datos faltantes se completan por algún método. Entre otros destacan: • Imputación Hot Deck, en el que se emplea otros datos procedentes de la muestra observada. • Imputación por la media. En ella se sustituye el valor faltante por medias procedentes del conjunto de datos observados. • Imputación por regresión. En ella los valores faltantes para un individuo se estiman mediante predicción a partir de la regresión de las variables conocidas para ese individuo. Procedimientos ponderados. Las inferencias realizadas en encuestas donde hay presencia de datos faltantes suele realizarse basándose en diseños ponderados, con ponderaciones inversamente proporcionales a la probabilidad de selección. Si Y es una variable e yi es el valor que sobre ella toma el individuo i-ésimo, entonces la media poblacional suele estimarse por P −1 π yi P i −1 πi donde la suma se extiende a todas las unidades muestrales, πi es la probabilidad de inclusión en la muestra del individuo i-ésimo y πi−1 es el peso dado por el diseño para dicho individuo. Los procedimientos ponderados modifican los pesos en un intento para ajustar la no respuesta. El estimador anterior suele reemplazarse por P (π pb )−1 y P i i −1 i (πi pbi ) donde la suma se extiende ahora sobre los individuos con respuesta y pbi es un estimador de la probabilidad de respuesta para el individuo i-ésimo, estimador que suele ser la proporción de individuos que responden en una subclase de la muestra. La ponderación está relacionada con la imputación mediante la media. Por ejemplo, si los pesos diseñados son constantes en subclases de la muestra, entonces imputar las unidades perdidas por las medias de las subclases en cada subclase y ponderar las unidades por la proporción de respuesta en cada subclase, conduce a las mismas estimaciones de las medias, si bien no a las mismas estimaciones de las varianzas muestrales. Procedimientos basados en modelos. Una amplia clase de procedimientos están amparados en la existencia de un modelo subyacente para los datos parcialmente perdidos, realizándose las inferencias sobre la verosimilitud asociada al modelo y estimando los parámetros por técnicas como la máxima verosimilitud. Las ventajas de estos métodos es su flexibilidad, evitar procedimientos ad hoc, la disponibilidad de estimaciones de la varianza para grandes muestras basadas en las segundas derivadas del logaritmo de la verosimilitud. Análisis Multivariante. 3o Grado en Estadı́stica Trabajo C 1.3. Trabajos Curso 2012-2013 3 Patrones de datos faltantes Algunos métodos de análisis están concebidos para patrones particulares de datos faltantes y emplean sólo análisis para datos completos. Otros métodos, como el algoritmo E.M., son aplicables a patrones más generales pero implican más cálculos que los diseñados para patrones especiales. Como ejemplo tomemos el analizado por Marin, Olsen y Rubin en 1980 sobre estudiantes de 10 escuelas de Illinois. En primer lugar se tiene un bloque de variables, fijado para todos los individuos al principio del estudio y, por lo tanto, es completamente observado. El segundo bloque consiste en variables medidas para todos los encuestados anteriores pero quince años después. Del total muestral anterior, el 79 % respondieron al bloque segundo. Ası́ pues el bloque primero es más observado que el bloque segundo. Los datos del estudio realizado a los quince años fueron tomados en varias fases y, por razones económicas, se fijaron los valores de las variables para un subconjunto de los individuos que respondieron al segundo bloque. Por lo tanto el bloque segundo es más observado que el tercero. Los bloques 1,2 y 3 forman un patrón monótono de datos faltantes. El cuarto bloque de variables está formado por un pequeño número de items medidos mediante un cuestionario enviado a los padres de todos los estudiantes de la muestra original. Del total respondieron el 65 %. Los cuatro bloques de variables no forman ya un patrón monótono. Sin embargo, sacrificando un relativamente pequeño número de datos, puede obtenerse un patrón monótono. 1.4. Mecanismos que conducen a datos faltantes El conocimiento, o la falta de él, sobre los mecanismos que conducen a la existencia de datos faltantes es un elemento clave para elegir un análisis apropiado e interpretar resultados. Algunas veces el mecanismo está bajo el control del estadı́stico. Por ejemplo, en una encuesta el mecanismo puede ser el proceso de selección muestral: unas variables (variables de diseño muestral) están dadas para todas las unidades de la población y otras son faltantes para las unidades que no han sido seleccionadas. Si los individuos fueran seleccionadas por muestreo probabilı́stico, entonces el macanismo está bajo el control del encuestador y puede considerarse ignorable. La técnica del doble muestreo en la metodologı́a de las encuestas proporciona otra circunstancia en la que el patrón de datos faltantes está bajo el control del encuestador. Se selecciona una muestra grande, fijando ciertas caracterı́sticas para los individuos. Los datos resultantes forman un patrón monótono. El caso de muestras censuradas ilustra una situación en la que el mecanismo que conduce a los datos faltantes no está bajo el control del estadı́stico, pero es conocido. Los datos, en este caso, están constituidos por el tiempo de ocurrencia de un suceso (fallo de una componente,...). Para algunos individuos de la muestra, el tiempo se censura porque el suceso no ha ocurrido antes de concluir el experimento. Si el tiempo de censura está determinado de antemano, entonces tenemos información parcial de que el tiempo de fallo excede al tiempo de censura. El análisis de los datos necesita tener en cuenta esta información para evitar resultados sesgados. En muchos análisis de datos el mecanismo que da lugar a la existencia de datos faltantes no se tiene de forma explı́cita. En tales casos se suele hacer la hipótesis de que el mecanismo es ignorable. Es posible, no obstante, incluir el mecanismo en el modelo estadı́stico mediante variables indicadoras que tomen el valor 1 si un item ha sido observado y 0 en otro caso. En general este mecanismo no debe ser ignorado. Análisis Multivariante. 3o Grado en Estadı́stica Trabajo C 1.5. Trabajos Curso 2012-2013 4 Muestras univariantes con valores faltantes Tal vez la situación más simple que nos podemos encontrar en este contexto es la de una variable aleatoria unidimensional. Sea Y tal variable y notemos por yi al valor que sobre ella toma el individuo i-ésimo. Supongamos que tenemos una muestra aleatoria y1 , . . . , yn de la cual son conocidos los valores y1 , . . . , ym (m < n) y desconocidos los valores ym+1 , . . . , yn . Una consecuencia obvia de la existencia de datos faltantes es la reducción del tamaño muestral de n a m. Podrı́amos plantearnos realizar el mismo análisis para la muestra reducida que el que harı́amos para la muestra completa. Por ejemplo, si suponemos que la variable de partida es normal unidimensional y deseamos hacer inferencias sobre la media poblacional, podrı́amos estimarla por medio de la media muestral de los valores observados. Asimismo se podrı́a estimar la varianza poblacional a partir de los valores observados. Cuando hacemos ésto estamos ignorando el mecanismo que produce la falta de datos observados. En este ambiente unidimensional, el mecanismo que produce la falta de datos puede ser ignorado si los valores faltantes lo son de forma aleatoria, lo cual notaremos por M.A.R. (missing at random). Esto significa que las unidades observadas son una submuestra aleatoria de las unidades muestrales. Si, por el contrario, la probabilidad de que yi sea observable depende del valor de yi entonces el mecanismo no debe ser ignorado ya que el análisis sólo de la muestra observada está sujeta a sesgos. Por ejemplo sea y una variable distribuida de forma normal con media cero y varianza uno y generemos una muestra aleatoria de tamaño 100 a partir de ella. Se estima la media poblacional mediante la media muestral, obteniéndose 0.03. A continuación podemos obtener una submuestra de los datos anteriores borrando unidades de forma independiente con probabilidad 0.5. La probabilidad de eliminar un dato no depende del valor de y. Ası́ obtenemos una muestra de tamaño 52 y la media muestral (en este caso -0.11) puede ser usada para estimar la media poblacional sin sesgo. A continuación tomemos los datos originales y eliminemos todos los valores positivos, manteniendo los negativos. La variable indicadora que muestra el mecanismo de datos faltantes es: 1 yi < 0 P[Ri = 1|yi ] = P[yi observado|yi ] = 0 yi ≥ 0 La probabilidad de respuesta depende de y y por lo tanto el mecanismo no puede ser ignorado ya que podrı́amos llegar a resultados sesgados. En particular la media muestral subestimarı́a la media poblacional al ser todos los valores muestrales menores que cero. En este caso el mecanismo de datos faltantes es del tipo censura. Si, como es el caso, el mecanismo de censura es conocido, entonces hay métodos disponibles que corrigen el sesgo. Estos métodos están casi siempre relacionados con la técnica de estimación por máxima verosimilitud. Si el mecanismo fuera desconocido el problema es bastante más complicado. En este caso, por ejemplo, el mecanismo no es ignorable. Una prueba evidente es que la muestra es asimétrica, lo cual contradice que proceda de una distribución normal. 1.6. Muestras bivariantes en las que los datos faltantes se producen sólo en una variable Supongamos que en el planteamiento anterior añadimos una nueva variable, X, para la cual se conocen todos los valores de una muestra de tamaño n. En ocasiones los valores muestrales de esa variable pueden estar presentes en la muestra desde el principio del experimento (por ejemplo, una covariable) o puede estar fijada de antemano por el experimentador (por ejemplo, una variable control en un diseño aleatorizado). Algunos de los datos Análisis Multivariante. 3o Grado en Estadı́stica Trabajo C Trabajos Curso 2012-2013 5 de Y pueden faltar por múltiples causas: no respuesta del individuo, valores que han sido descartados con posterioridad, errores al presentar los datos, etc... Las variables objeto de estudio pueden ser continuas o categóricas. El caso en el que ambas sean normales ha sido objeto de un estudio especial en la literatura sobre este tema. Si X es categórica e Y continua, los datos tienen una estructura de análisis de la varianza de una vı́a. Si ambas son categóricas entonces conforman una tabla de contingencia. Para los datos que responden a esta estructura es usual clasificar los mecanismos de falta de datos de acuerdo a si la probabilidad de respuesta: (1) Depende de Y y, posiblemente, de X. (2) Depende de X pero no de Y . (3) Es independiente de X y de Y . Rubin en 1976 propone la siguiente terminologı́a. Si se da el caso (3) entonces diremos que los datos faltante son missing at random (M.A.R.) y los observados son observed at random (O.A.R.). En este caso diremos que el total de los datos son completamente aleatorios (M.C.A.R), missing completely at random, y ası́ los valores observados de Y forman también una submuestra aleatoria de los valores muestrales de Y . Si se da el supuesto (2) entonces diremos que los datos son faltantes de forma aleatoria (M.A.R.) (missing at random). En tal caso los valores observados de Y no son necesariamente una submuestra aleatoria de los valores muestrales, pero sı́ son una submuestra aleatoria de los valores muestrales dentro de cada una de las clases definidas por X. Si se verifica el supuesto (1) los datos no son ni M.A.R. ni O.A.R. En los casos (2) y (3) el mecanismo de producción de datos faltantes es ignorable para las inferencias basadas en la verosimilitud. En el caso (3) ese mecanismo es ignorable tanto para las inferencias basadas en la verosimilitud como en las basadas en la propia muestra. En el caso (1) ese mecanismo no es ignorable. Ejemplo 1.1. Supongamos que las variables X e Y representan la edad y los ingresos de una muestra de n individuos. Si la probabilidad de que los ingresos de un individuo sean observados es la misma para todos los individuos, sin tener en cuenta su edad o ingreso, entonces los datos son M.A.R. y O.A.R. (y por lo tanto M.C.A.R). Si la probabilidad de que de que se observe un ingreso varı́a según la edad del encuestado pero no varı́a según el ingreso dentro del mismo grupo de edad, los datos son M.A.R. pero no O.A.R. Si la probabilidad de que el ingreso sea observado varı́a según el ingreso dentro del mismo grupo de edad, entonces no son ni M.A.R. ni O.A.R. Esta última es la cuestión más difı́cil de tratar analı́ticamente, lo cual es bastante importante pues es el caso que más se da en las aplicaciones prácticas. La significación de estos supuestos sobre el mecanismo que da origen a la existencia de datos faltantes depende del objetivo del análisis. Por ejemplo, si el interés radica en la distribución marginal de X , entonces los datos de Y (y el mecanismo que produce que falten datos de esa variable) es irrelevante. Si el interés radica en la distribución condicionada de Y dado X, entonces el análisis basado en las unidades observadas puede ser satisfactorio si los datos son M.A.R. Por otro lado, si Análisis Multivariante. 3o Grado en Estadı́stica Trabajo C Trabajos Curso 2012-2013 6 el interés radica en la distribución marginal de Y , o medidas tales como la media de Y , entonces el análisis basado sólo en los casos completos es generalmente sesgado salvo que los datos sean M.C.A.R. La estimación de la distribución conjunta de X e Y suponiendo que los datos son M.A.R. se simplifica bastante debido a la factorización f (X, Y ) = f (X)f (Y |X) Volviendo al ejemplo anterior, la inferencia sobre la distribución marginal de la edad puede basarse sobre los n valores muestrales de dicha variable. La inferencia sobre la distribución condicionada de los ingresos dada la edad puede basarse en las unidades de X e Y observadas. Los resultados de estos análisis pueden combinarse para estimar la distribución conjunta de la edad y los ingresos o la condicionada de la edad dados los ingresos. La estimación de la distribución condicionada de los ingresos dada la edad es con frecuencia del tipo del análisis de regresión y la estrategia de factorizar la distribución conjunta relaciona la idea de imputar los valores faltantes de los ingresos regresándolos sobre la edad y luego calculando predicciones sobre la ecuación de regresión. 1.7. Datos faltantes multivariantes Las estructuras de datos faltantes comentadas hasta ahora son univariantes en el sentido de que los valores faltantes están relacionados con una sola variable. Veamos ahora algunas estructuras multivariantes. Muchas técnicas estadı́sticas están basadas en la reducción inicial de la información muestral en el vector de medias y la matriz de varianzas-covarianzas muestral. La cuestión que surge ahora es cómo estimarlas a partir de datos incompletos. Supongamos que los datos pueden ponerse como un patrón monótono. Una aproximación simple al problema que tratamos de resolver es calcular los estadı́sticos anteriormente citados con sólo los datos observados. Estos métodos descartan gran cantidad de información. Además los datos pueden no ser M.C.A.R. y ello conlleva sesgos inevitablemente. Otra estrategia es suponer normalidad multivariante en los datos y estimar los parámetros por máxima verosimilitud. En el caso de patrones monótonos la cuestión no es difı́cil porque la estimación se simplifica por medio de factorizaciones de la distribución conjunta, obteniéndose los estimadores máximo verosı́miles a partir de regresiones sucesivas. En ocasiones los datos faltantes no presentan patrones monótonos. Sin embargo se ha desarrollado técnicas que pueden ser aplicadas a cualquier patrón de valores faltantes. Estos métodos están con frecuencia basados en estimaciones máximo verosı́miles suponiendo normalidad multivariante y la estimación supone algoritmos iterativos. El algoritmo de estimación-maximización (E.M.) es una técnica general muy importante para encontrar estimadores máximo-verosı́miles para datos incompletos. Es bastante instructivo puesto que está muy relacionado con los métodos que imputan datos de valores perdidos mediante regresión. Si los datos son categóricos no es apropiado reducir la información muestral mediante el vector de medias y la matriz de varianzas-covarianzas muestral. En tal caso los datos se ordenan en una tabla de contingencia, existiendo procedimientos para ello (incluso si los datos no son M.A.R.). 2. El algoritmo E.M. El algoritmo E.M. es un algoritmo iterativo de carácter general para la estimación máximo verosı́mil en problemas con datos incompletos. De hecho el rango de problemas que pueden ser abordados por este algoritmo es bastante amplio e incluye situaciones como la estimación de componentes de la varianza, mı́nimos cuadrados ponderados de forma iterativa,... Análisis Multivariante. 3o Grado en Estadı́stica Trabajo C Trabajos Curso 2012-2013 7 El algoritmo E.M. formaliza una antigua idea para tratar los datos faltantes: 1. Reemplazar los valores faltantes por valores estimados. 2. Estimar los parámetros del modelo. 3. Reestimar los valores faltantes tomando ahora las estimaciones anteriores de los parámetros. 4. Reestimar de nuevo los parámetros. y ası́ sucesivamente hasta llegar a una convergencia. Los métodos E.M. son algoritmos que se aplican en modelos para los cuales la logverosimilitud para los datos completos ln L(θ|Yo , Yf ) sea lineal en Yf .1 De forma más general se puede decir que antes que las observaciones individuales se necesita estimar estadı́sticos suficientes e, incluso de forma aún más general, es la logverosilimitud ln L(θ|Y ) la que necesita ser estimada en cada iteración del algoritmo para, después, ser maximizada. Puesto que el algoritmo E.M. está cercano a la idea intuitiva de imputar datos faltantes e iterar, no es sorprendente que haya aparecido en diversos contextos. La primera referencia es debida a McKendrick (1926), el cual se sitúa en un ambiente médico. Hartley (1958) considera el caso general de datos de conteo, desarrollando la teorı́a anexa. Baum et al. (1970) usan el algoritmo en un modelo de Markov. Orchard y Woodbury (1972) fueron los primero que vieron la aplicabilidad de la idea del algoritmo, adoptando la terminologı́a principio de información perdida. El término E.M. fue introducido por Dempster, Laird y Rubin en 1977, quienes proporcionaron resultados generales sobre el comportamiento del algoritmo (esencialmente el crecimiento de la logverosimilitud ln L(θ|Yo ) en cada iteración) y propusieron un amplio rango de ejemplos. Cada iteración del algoritmo E.M. consiste en un paso E (cálculo de esperanzas) y un paso M (paso de maximización). Estos pasos suelen ser fáciles de construir conceptualmente ası́ como tienen una interpretación estadı́stica. Una ventaja adicional del algoritmo es que bajo condiciones generales cada iteración hace aumentar la logverosimilitud ln L(θ|Yo ) y, si es acotada, la sucesión ln L(θ(t) |Yo ) converge a un valor estacionario. Más generalmente, si la sucesión θ(t) converge, lo hace a un máximo local o a un punto de silla de ln L(θ|Yo ). Una desventaja del algoritmo es que su razón de convergencia puede ser muy lenta si hay muchos datos faltantes. Dempster, Laird y Rubin (1977) demostraron que la convergencia es lineal con razón proporcional a la fracción de información sobre ln L(θ|Y ) que ha sido observada. El paso M del algoritmo es fácil de describir: desarrolla la estimación máximo veroxı́mil de θ como si no hubiera datos faltantes, o sea, como si hubieran sido imputados. Ası́ pues, el paso M del algoritmo emplea los mismos métodos computacionales que la estimación máximo verosı́mil a partir de ln L(θ|Y ). El paso E calcula la esperanza condicionada de los datos faltantes dados los datos observados y la estimación actual de los parámetros, sustituyendo posteriormente los datos faltantes por esas esperanzas. La idea clave del algoritmo, que se diseña desde la idea de imputar los datos faltantes e iterar, es que las datos faltantes no son Yf sino ciertas funciones suyas que aparecen en la logverosimilitud completa ln L(θ|Y ). 2.1. El algoritmo E.M. en las familias exponenciales El algoritmo E.M. posee una fácil y particular interpretación cuando los datos completos Y tienen una distribución que pertenezca a la familia exponencial regular, con densidad asociada 1 Notamos por Yf a los datos faltantes, mientras que Yo nota a los datos observados. Análisis Multivariante. 3o Grado en Estadı́stica Trabajo C Trabajos Curso 2012-2013 f (Y |θ) = 8 b(Y ) exp(s(Y )θ) a(θ) donde θ es un vector paramétrico d-dimensional, s(Y ) denota un vector de estadı́sticos suficientes y completos, mientras que a y b son funciones de θ e Y respectivamente. Es inmediato verificar que la logverosimilitud en este caso es una función lineal de s(Y ), por lo que el paso E del algoritmo queda reducido a calcular h i s(t+1) = E s(Y )|Yo , θ(t) mientras que el paso M encontrará el valor de θ que maximiza la logverosimilitud resultante a partir del paso anterior, teniendo en cuenta la actualización del conjunto de estadı́sticos suficientes y completos, o sea, se encuentra θ(t+1) que maximiza la función l(θ|s(Y ) = st+1 ). 3. El algoritmo EM para muestras incompletas de una normal multivariante Muchas técnicas estadı́sticas como la regresión lineal múltiple, el análisis de componentes principales, el análisis factorial, la correlación canónica, etc..., están basadas en el resumen inicial de la matriz de datos por medio de la media muestral y la matriz de varianzas-covarianzas. Por esta razón, cuando existen datos faltantes en la muestra, una cuestión de suma importancia es estimar de forma eficiente dichos estadı́sticos muestrales. A continuación exponemos la estimación máximo-verosı́mil de los mismos para una muestra incompleta procedente de una población normal multivariante. Para este desarrollo supondremos que los datos son MAR (missing at random). Sea X Np [µ; Σ] y sea X = (X1 , . . . , XN ) una muestra aleatoria simple extraı́da de dicha 0 0 población. Para cada j = 1, . . . , N notaremos Xj = (Xj,(1) |Xj,(2) )0 , donde la caja Xj,(1) es la parte de datos faltantes del individuo j-ésimo y Xj,(2) es la parte de datos observados en dicho individuo. Notaremos Xf = (X1,(1) , . . . , XN,(1) ) y Xo = (X1,(2) , . . . , XN,(2) ) a la parte de la muestra con datos faltantes y datos observados, respectivamente. N N X X Sean T1 = Xj y T2 = Xj Xj0 los estadı́sticos suficientes para µ y Σ en una población normal j=1 j=1 (t) (t) p-dimensional para una muestra completa. Llamemos T1 y T2 a los estadı́sticos anteriores obtenidos tras la iteración t-ésima. Asimismo sea µ(t) y Σ(t) las estimaciones de los parámetros en esa misma iteración del algoritmo. • El paso E del algoritmo consiste en calcular h i (t+1) |Xo = Xo ; µ(t) , Σ(t) E T1 Ahora bien T1 = N X j=1 y h i (t+1) |Xo = Xo ; µ(t) , Σ(t) E T2 N X Xj,(1) Xj = Xj,(2) j=1 y T2 = N X j=1 Xj Xj0 = N X j=1 Análisis Multivariante. 3o Grado en Estadı́stica 0 0 Xj,(1) Xj,(1) Xj,(1) Xj,(2) 0 0 Xj,(2) Xj,(1) Xj,(2) Xj,(2) ! Trabajo C Trabajos Curso 2012-2013 9 por lo que N h i X E Xj,(1) |Xl,(2) = xl,(2) , l = 1, . . . , N ; µ(t) , Σ(t) (t+1) (t) (t) |Xo = Xo ; µ , Σ = = E T1 E Xj,(2) |Xl,(2) = xl,(2) , l = 1, . . . , N ; µ(t) , Σ(t) j=1 X N N X E Xj,(1) |Xj,(2) = xj,(2) ; µ(t) , Σ(t) = = xj,(2) ! −1 (t) (t) (t) (t) (xj,(2) − µj,(2) ) µj,(1) + Σ12,j Σ22,j j=1 j=1 xj,(2) y razonando de igual manera se tiene i h (t+1) |Xo = Xo ; µ(t) , Σ(t) = E T2 i h 0 |Xj,(2) = xj,(2) ; µ(t) , Σ(t) E Xj,(1) |Xj,(2) = xj,(2) ; µ(t) , Σ(t) x0j,(2) E Xj,(1) Xj,(1) i h = 0 xj,(2) E Xj,(1) |Xl,(2) = xj,(2) ; µ(t) , Σ(t) xj,(2) x0j,(2) j=1 N X (t) Si llamamos x] = E Xj,(1) |Xj,(2) = xj,(2) ; µ(t) , Σ(t) entonces el paso E del algoritmo se j,(1) reduce a calcular dicho valor para todo individuo j para el que haya datos faltantes, lo cual (t) (t) permitirá actualizar el estadı́stico T1 . Por otro lado la actualización de T2 se realiza mediante el cálculo de ^ xj,(1) x0j,(1) (t) i h 0 = E Xj,(1) Xj,(1) |Xj,(2) = xj,(2) ; µ(t) , Σ(t) = h i (t) (t) (t) ] (t) ] (t) 0 0 = Cov Xj,(1) |Xj,(2) = xj,(2) ; µ(t) , Σ(t) + x] = Σ11,2,j + x] j,(1) xj,(1) j,(1) xj,(1) (t) ası́ como x] j,(1) xj,(2) , siendo −1 (t) (t) (t) (t) (t) Σ11,2,j = Σ11,j − Σ12,j Σ22,j Σ21,j 0 0 Notemos que dichas matrices dependen del ı́ndice j puesto que la partición Xj = (Xj,(1) |Xj,(2) )0 es distinta, en general, para cada individuo incompleto. De esta forma, en este paso del algoritmo, los datos faltantes se reemplazan por los valores x] j,(1) , obteniéndose ası́ una nueva actualización de los estadı́sticos T1 y T2 . • El paso M del algoritmo se realiza reestimando de nuevo los parámetros µ y Σ a partir de la actualización de los estadı́sticos T1 y T2 , o sea µ(t+1) = 1 (t+1) T N 1 Σ(t+1) = 1 (t+1) 0 T2 − µ(t+1) µ(t+1) N Análisis Multivariante. 3o Grado en Estadı́stica Trabajo C Trabajos Curso 2012-2013 10 La convergencia del algoritmo se suele establecer en cuanto a la estabilidad de las estimaciones y Σ(t) en dos iteraciones sucesivas ası́ como en los valores que va tomando el logaritmo de la función de verosimilitud (que va creciendo en cada etapa). En cuanto a la estimación inicial, punto de partida del algoritmo, se han sugerido diversas opciones, si bien Dempster, Laird y Rubin (1977) demostraron la convergencia del método independientemente de la solución inicial. Las principales alternativas para µ(0) y Σ(0) son: µ(t) • Usar en su cálculo sólo los casos completos. Ello proporciona estimaciones consistentes si los datos son MCAR y hay al menos p + 1 observaciones completas. • Usar para cada variable, y para cada par de variables en el caso de productos cruzados, sólo los casos disponibles. Ello puede llevar a matrices de varianzas-covarianzas no definidas positivas, con los consecuentes problemas en la primera iteración del algoritmo. No obstante, algunos paquetes estadı́sticos plantean en estos casos suavizamientos de la matriz de varianzas-covarianzas que llevan a matrices definidas positivas. Ejemplo 3.1. Dada la siguiente matriz de datos completa, eliminamos cinco de ellos 1 2 3 4 5 6 7 8 9 X1 19,5 24,7 30,7 29,8 19,1 25,6 31,4 27,9 22,1 X2 43,1 49,8 51,9 54,3 42,2 53,9 58,5 52,1 49,9 X3 29,1 28,2 37 31,1 30,9 23,7 27,6 30,6 23,2 1 2 3 4 5 6 7 8 9 X1 19,5 24,7 ∗ 29,8 19,1 25,6 ∗ 27,9 22,1 X2 43,1 49,8 51,9 54,3 ∗ 53,9 58,5 52,1 49,9 X3 29,1 28,2 37 31,1 30,9 23,7 ∗ ∗ 23,2 La solución inicial para el algoritmo EM se calculará empleando los casos disponibles para cada variable y par de variables. Ejercicio: Realizar dos iteraciones completas del algoritmo y rellenar la matriz de datos. Análisis Multivariante. 3o Grado en Estadı́stica