Tesis HDTV - Monografias.com

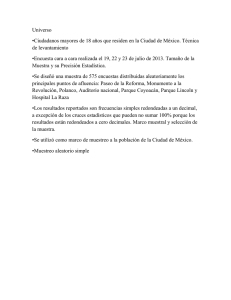

Anuncio