fdi con técnicas estadísticas multivariantes

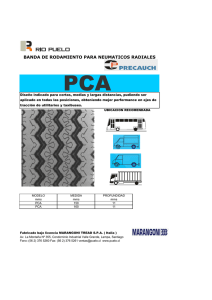

Anuncio

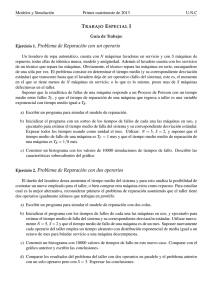

FDI CON TÉCNICAS ESTADÍSTICAS MULTIVARIANTES María Jesús de la Fuente Dpto. Ingeniería de Sistemas y Automática Universidad de Valladolid Índice Control estadístico de procesos (SPC) Introducción Estadísticas univariantes Estadísticas multivariantes (MSPC) Análisis de componentes principales (PCA) Mínimos cuadrados parciales (PLS) Discriminante de Fisher (FDA) Aplicación a detección y diagnóstico de fallos Variabiliad de los procesos Monitorización vs Regulación Monitorización: sistema de información de la evolución del proceso para la detección de fallos y ayuda a su diagnóstico. Regulación: se fuerza al proceso a seguir un comportamiento determinado mediante ajustes en variables manipulables. Variabilidad Causas de la variabilidad Causas comunes Variabilidad inherente al proceso Tienen carácter permanente Su efecto da lugar a una pauta de variabilidad estable o predecible, cuantificada por la capacidad del proceso Si sólo hay causas comunes el proceso está BAJO CONTROL Su solución exige modificar el sistema que incumbe a la Dirección Causas especiales Fluctuaciones no inherentes al proceso Tienen carácter esporádico o puntual Su efecto da lugar a una pauta de variabilidad errática o impredecible Si aparecen causas especiales el proceso está FUERA de CONTROL En general pueden solucionarse mediante actuaciones locales a cargo de los operarios o encargados del proceso Distribución normal y Variabilidad natural n μˆ = ∑q t =1 t n n σˆ 2 = ∑ (q t =1 t − μˆ ) 2 n −1 n suele ser pequeño (4 -10) para evitar la aparición de causas asignables durante ese tiempo Control estadístico de procesos Control estadístico de procesos SPC: Estabilidad y capacidad del proceso Dadas unas especificaciones y el comportamiento normal del proceso: Especificaciones (proceso/Producción) LSL: Límite inferior de especificación USL: límite superior Comportamiento natural del proceso (estadísticamente normal) LPL: límite inferior del proceso UPL: límite superior Cuando los límites de las especificaciones son mayores que los límites naturales del proceso (ambos), se dice que el proceso es estable y capaz y producirá con 100% de producto correcto Cuando el proceso es estable pero los límites de control son mayores que los de especificación (uno o ambos), el proceso es estable pero no es capaz y aparecen errores en la producción Control de la calidad del proceso (SQC) Control estadístico de procesos (SPC) Objetivos Establecer un sistema de información permanente e inteligente de la evolución del procesos. Detectar precozmente anomalías (causas especiales) Tratar de identificar el origen de las anomalías Eliminarlas y evitar su reaparición en el futuro ( o incorporarlas al proceso si son favorables). Estadísticas univariantes - Gráficas de control Cusum: sumas acumulativas EWMA: media móvil pesada exponencialmente Control estadístico de procesos (SPC) Idea básica: Graficar la evolución de ciertos estadísticos, obtenidos a partir de muestras tomadas periódicamente de los procesos, utilizando gráficos que facilitan la rápida detección visual de señales estadísticas reveladoras de la salida de control. 5 Límite superior de control: LSC 4 .5 4 3 .5 Línea central 3 2 .5 2 1 .5 Límite inferior de control: LIC 0 5 10 15 Número de muestras 20 25 SPC: Gráficas de control Las gráficas de control son una representación del comportamiento del proceso dada por la localización (media o mediana) y su variación (rango o desviación estándar) de las variables observadas: Los índices de localización y variación se usan para calcular los límites normales de operación para cada variable: σ LPL: μ - 3 σ UPL: μ + 3 SPC. Gráficos de la media y del rango Procedimiento: K subgrupos de n observaciones cada uno. Calcular: Media ( x i) y el rango (Ri) de cada subgrupo Media de las k medias: Media de las k rangos: R x Obtener los límites de control a través de tablas: A2, D4, D3 SPC: Gráficos de la media y el rango SPC: Detección de fallos Reglas de decisión: 4.5 4 Regla 1. 1 punto fuera de los límites de control, sistema fuera de control Regla 2. 7 puntos consecutivos sobre o debajo de la media: pauta Regla 3. 7 puntos consecutivos en un orden creciente o decreciente: tendencia Regla 4. Concentración de cinco puntos consecutivos alrededor de la media o dispersión de 5 puntos consecutivos alejados de la media 3.5 3 5 2.5 4 2 3 1.5 2 1 1 0.5 0 5 10 15 20 0 -1 -2 0 5 10 15 20 25 25 SPC. CUSUM (Cumulative SUMs) I Las gráficas de control anteriores tienen algunas limitaciones inherentes a los límites de control considerados: μ ± 3 σ (bajo número de falsas alarmas): Esto permite detectar sólo grandes variaciones Tienen una respuesta muy lenta: retardo entre la aparición del fallo y su detección. CUSUM es una reinterpretación de los límites de control orientado a reducir el tiempo de detección del fallo, pero preservando el ratio de falsas alarmas. CUSUM se basa en el método anterior y puede usarse en combinación con él. SPC. CUSUM (Cumulative SUMs) II Los límites de control en las gráficas de control tradicionales son: Pero podemos calcular z como: Entonces, se puede calcular un zi para cada observación xi Se calculan las siguientes sumas acumuladas: donde k es un parámetro de sensibilidad relacionado con el mínimo cambio a detectar. SPC. CUSUM (Cumulative SUMs) III El parámetro k corresponde con la mitad de la magnitud a ser detectada, típicamente k=0.5 Para detectar fallos hay que definir un umbral, h, para las dos magnitudes calculadas SH y SL. Típicamente: h=4 o 5 En estos casos el número de falsas alarmas es: Para k=0.5, h=4 → ARL=168 Para k=0.5, h=5 → ARL=465 R1 (un punto fuera de los límites de control ± 3 σ ) . ARL=370 ARL=Average Run lenght (entre falsas alarmas) Ejemplo Ejemplo SPC. EWMA EWMA: media móvil pesada exponencialmente El objetivo es similar a CUSUM: respuesta rápida ante fallos. La secuencia de observaciones se reemplaza por una secuencia filtrada calculada como: Del estudio estadístico de la señal transformada se obtienen los límites de control como: SPC. Ejemplo Control estadístico de procesos multivariante (MSPC) para detección de fallos Motivación PCA: análisis de componentes principales SPL: mínimos cuadrados parciales (partial least squares) FDA: Discriminante de Fisher MSPC. Motivación I Limitaciones del control estadístico de procesos univariante: Las variables se procesan individualmente => una gráfica de control por cada variable. Sólo se pueden monitorizar un número pequeño de variables Por tanto, sólo las “variables más importantes” son monitorizadas No se tiene en cuenta la correlación entre variables, fundamental en un proceso industrial MSPC se implementa para monitorizar el conjunto completo de variables del proceso. MSPC. Motivación II Naturaleza de los datos tomados de un proceso industrial: Dimensionalidad (muy elevada) Colinealidad No ocurren miles de cosas independientes Sólo unos cuantos acontecimientos subyacentes afectan a todas las variables Las variables están altamente correlacionadas Ruido (ratio bajo señal/ruido) Datos faltantes (fallos en sensores) Datos espurios MSPC. Motivación III x e y están muy correlacionadas Fuera de control PCA: Análisis de componentes principales PCA es una técnica de proyección que Los datos se proyectan a un espacio de menor dimensión que el original. Produce una reducción de la dimensionalidad Preserva la estructura de correlación de las variables del proceso Es óptimo en términos de capturar la máxima variabilidad de los datos PCA nos permite dividir el espacio en dos subespacios diferentes: uno captura la tendencia del proceso y otro el ruido La estructura PCA es útil para identificar las variables responsables de los fallos y/o las variables que están más afectadas por los fallos PCA. Interpretación geométrica I Interpretación geométrica: Se desea proyectar los puntos sobre un espacio de dimensión menor: recta (dimensión 1), pero manteniendo lo más posibles sus posiciones relativas. Si lo hacemos para un punto en concreto: PCA. Interpretación geométrica II Tenemos lo siguiente: Tenemos: xi = xˆi + ei xˆi = ti p i Donde pi es el vector unitario y director de la recta, y ti es el módulo del vector x̂ i pi => ‘loading’ ti => ‘score’ La condición que la recta pase cerca de la mayoría de los puntos se consigue exigiendo que la distancia entre los puntos originales y sus proyecciones sobre la recta sea la mínima posible PCA. Interpretación geométrica III Resultado: de esta forma se conserva la variabilidad de los puntos. Si proyectamos en la dirección perpendicular: los puntos tienen poca variabilidad y se pierde toda la información sobre sus distancias en el espacio. PCA: pre-tratamiento de los datos Se necesita un conjunto de datos representativo del comportamiento normal de la planta para calcular el modelo PCA Hay que realizar un pretratamiento de estos datos: Eliminar las variables inapropiadas: por ejemplo las que tienen errores de medida muy grande Escalado: para asegurar que cada variable tiene el mismo peso en el proceso de monitorización: Restar de cada variable su valor medio (el objetivo es capturar la variación de la media) Dividir cada variable por su desviación estándar (las variables se escalan para tener varianza unidad) Eliminar datos espurios (outliers) PCA. Matriz de covarianza Dado un conjunto de datos de entrenamiento que contienen n observaciones de m variables del proceso (de media cero y varianza unidad), se colocan en la matriz X ∈Rnxm ⎛ x11 ⎜ ⎜ x 21 X=⎜ ... ⎜ ⎜x ⎝ n1 x12 x 22 ... x n2 ... x1m ⎞ ⎟ ... x 2m ⎟ Observación 2 ... ... ⎟ ⎟ ... x nm ⎟⎠ X: (n x m) Variable x2 La matriz de covarianza, R, puede estimarse a partir de los datos de la forma siguiente: 1 R= XTX R: (m x m) n −1 PCA: valores y vectores propios La descomposición en valores y vectores propios (o en valores singulares: SVD) de R revela la estructura de correlación de las variables R = VΛV T R: (m x m) V: (m x m) Donde Λ: (m x m) Λ, es una matriz diagonal, que contiene todos los valores propios reales no negativos de R en orden decreciente en su diagonal principal, y cero en todos los demás elementos λ1 ≥ λ2 ≥ L ≥ λm ≥ 0 El valor propio i es igual al cuadrado de i-esimo valor singular: λi = σi2 V es una matriz ortogonal (VTV = I). Las columnas de V son los vectores propios (llamados en PCA: ‘scores’) Así, la varianza de los datos de entrenamiento proyectados sobre la columna i-ésima es igual a σi2 PCA: Loadings y scores La proyección del un vector de observaciones x∈Rm desacopla el espacio de observaciones en un conjunto de variables no correlacionadas correspondientes a los elementos de t t = xV x: (1 x m) V: (m x m) t: (1 x m) La columna i-ésima de V es el vector de caga pi (loading) que transforma x en el ‘score’ ti Las variables transformadas se llaman ‘componentes principales’ y las observaciones individuales transformadas son los ‘scores’ PCA. Reducción de la dimensionalidad Reteniendo sólo los a vectores de carga (matriz P) correspondientes a los a valores singulares más grandes, podemos proyectar un vector de observación x ∈ Rm en un espacio de menor dimensión: Ra. t: (1 x a) t = xP x: (1 x m) P: (m x a) a<m O aplicando esta transformación a todo el conjunto de datos de entrenamiento (X: n x m), tenemos: T = XP T: (n x a) X: (n x m) P: (m x a) PCA. Propiedades Definiendo ti como la columna i-ésima de T (conjunto de datos transformado), se cumplen las siguientes propiedades: var(t1) ≥ var(t2) ≥ … ≥ var(ta) (varianza está ordenada) media(ti) = 0; ∀i (centrado en la media) tiTtj = 0; ∀ i≠j (descomposición ortogonal) No existe ninguna otra expansión ortogonal de a componentes que capture más variación de los datos PCA. Matriz de los residuos Podemos calcular nuevamente los datos originales en función de T: Xˆ = TP T Y ahora podemos definir una matriz de residuos: E, calculada como la diferencia entre el espacio original X y el espacio calculado: E = X − Xˆ El espacio de los residuos, E, captura la variación de los datos de observación contenidos en los vectores propios (carga) asociados con los m-a valores singulares más pequeños. X = TP T + E PCA. Reducción del orden del sistema (I) Hay varios criterios para reducir el orden del sistema (elección de a): Test del porcentaje de la varianza: se selecciona a de forma que explique un porcentaje específico de la varianza total. Test scree (test del codo): se representa los valores de λi frente a i, y se busca un codo en la gráfica, un valor a partir del cual todos los λi son iguales y pequeños: PCA. Reducción del orden del sistema (II) Análisis paralelo: determina a comparando el comportamiento de la varianza obtenido suponiendo que todas las variables son independientes. El orden se determina en el punto al cual los dos gráficos se cruzan Validación cruzada: usando la estadística PRESS (prediction sum of squares) 1 PRESS (i ) = X − Xˆ mn 2 PCA para detección de fallos (I) La reducción dada por los PCA representa la misma información en un espacio de dimensión menor. Este nuevo espacio se va a utilizar para monitorizar el proceso. Se trabaja con dos estadísticas: Estadística de Hotelling’s o T 2 que se utiliza en el espacio de dimensión a, para detectar comportamientos anómalos del sistema cuando traspasan un umbral. Estadística Q se usa para monitorizar el resto del espacio de observación correspondiente a los m-a valores singulares más pequeños, es decir para monitorizar el espacio de los residuos PCA para detección de fallos (II) Estadística Hotelling’s o T2: Para a componentes principales la estadística T2 se calcula: a T 2 = ∑ ti λi−1tiT = xPΛ−a1 P T xT i =1 t = xP t: (1 x a) x: (1 x m) P: (m x a) Cuando se calcula para una observación x, de n variables, T2 puede interpretarse como la distancia de la observación al centro del modelo (media). Los scores está escalados inversamente proporcional a la varianza. Esto permite definir un umbral escalar característico de la variabilidad en todo el espacio a-dimensional Dado un nivel de significancia (nivel de falsas alarmas), se puede calcular automáticamente un umbral para T2 PCA para detección de fallos (III) El umbral para T2 se calcula: Donde: 2 ( n − 1)a Tα2 = Fα (a, n − a ) n( n − a ) a: número de componentes principales seleccionado n: número de observaciones Fα es la distribución de Fisher-Snedecor, con a y n-a grados de libertad α nivel de significancia o 100α % es el radio de falsas alarmas La estadística T2 es útil para detectar operaciones del proceso fuera de sus condiciones normales de operación La calidad de los datos según el modelo Es una medida en la dirección del modelo Los datos conservan la estructura del modelo pero con valores más grandes (desde el punto de vista de la media). PCA para detección de fallos (IV) A partir de un vector de observación, x, se calcula el vector de residuos como: r = x − xˆ = x − tP T = x − xPPT = x( I − PPT ) El error de predicción al cuadrado o estadística Q se calcula a partir de los residuos como: Q = rr T El umbral se calcula también estadísticamente: PCA para detección de fallos (V) Interpretación de las estadísticas T2 y Q PCA para detección de fallos (VI) Procedimiento de cálculo: Off-line: conseguir datos de comportamiento normal de la planta, y construir la matriz X, eliminando datos no deseados y centrando los datos para tener media cero y varianza unidad Calcular el modelo PCA en condiciones normales y los umbrales de las estadísticas: T2 y Q On-line: Para una nueva observación del proceso, x, se normaliza con la media y la varianza del PCA calculado, se calculan las estadísticas T2 y Q para ese datos y se comparan con sus umbrales. Si alguna de las dos estadísticas supera el umbral, ha ocurrido un fallo. PCA para detección de fallos (VII) Ejemplo: PCA. Identificación de fallos (I) ¿Qué variables del espacio original son las responsables del fallo detectado (del cruce de las estadísticas por su umbral)? Diagramas de contribución (para ambos SPE y T2) Para la observación con fallo: Determinar los r scores t (r<a) responsables del estado de i fuera de control (los que cumplan que ti2/λi > 1/α (Tα2)) y calcular la contribución de cada variables xj a ese score ti que está fuera de control. contij = ti λi pij x j Calcular la contribución total de la varible j-ésima r CONT j = ∑ contij i =1 Dibujar CONTj PCA. Identificación de fallos (II) Ejemplo: PCA. Identificación de fallos (III) Para diagnosticar fallos se puede hacer lo siguiente: Calcular un modelo PCA para cada situación posible del sistema, es decir, un modelo PCA0 con datos de situación normal, PCA1 con datos de situación de fallo1, etc… Calcular un umbral para cada una de las estadísticas Ti2 y Qi para cada situación posible. Tomar un nueva observación de la planta 2 Calcular las estadísticas T i y Qi para cada situación y aquella que no supere su umbral nos indica la situación actual de la planta. Ejemplo. Estación de evaporación I Estación de evaporación de una fabrica azucarera. Se utiliza un modelo basado en primeros principios muy exhaustivo. Ejemplo. Estación de evaporación II Hay 46 variables en el proceso Fallos: Fallo 1: rendimiento en las calderas de evaporación: la transmisión de calor entre el vapor de calefacción y el jugo de los evaporadores disminuye, lo que ocasiona una disminución del agua evaporada, una disminución de la presión en el efecto correspondiente y una reducción del Brix Fallo 2: fallo en la válvulas de control Fallo 3: Aumento de la fracción de incondensables que entran al evaporador y reducción de la apertura de la válvula de salida de estos Fallo 4. Disminución del rendimiento de una de las bombas de circulación de jugo de anteevaporación Ejemplo. Estación de evaporación III Se obtienen 5 componentes principales que explican el 95% de la varianza del proceso. Ejemplo. Estación de evaporación IV Fallo 1. Diagrama de contribuciones Ejemplo. Estación de evaporación V Fallo 2. Diagrama de contribuciones Otros métodos de MSPC PLS: mínimos cuadrados parciales -FDA: Análisis del discriminante de Fisher - PLS: Partial Least Squares or Projection to Latent Structures PLS es también una técnica de reducción de la dimensionalidad Objetivo: Obtener un modelo en un espacio de menor dimensión que maximice la covarianza entre una matriz independiente, X (Matriz de predicción) y otra matriz dependiente de X, Y (Matriz predicha) Los elementos de la matriz X son las observaciones (variables del proceso) Los elementos de Y pueden ser: Medidas de la calidad del producto Miembros de una clase dada Y puede estar formada por una sola variable (PLS1) o por un conjunto de ellas (PLS2) PLS: fundamentos I Modelo PLS es un modelo de predicción calculado basándose en: Capturar la máxima variación en X con el número mínimo de variables (PCA) Maximizando la correlación entre X e Y a p U n max cov(ta, ua) Y n a QT p PLS: fundamentos II T y U son los ‘scores’ y P y Q son los ‘loadings’ asociados con las matrices X e Y respectivamente B es una matriz de regresión lineal entre los espacios de los ‘scores’ que debemos calcular Hay varios algoritmos para obtener este modelo, el más utilizado es el NIPALS (recursivo) PLS: fundamentos III Algoritmo: 1.- X∈ Rnxm (n: número de observaciones, m: número de variables), Y∈Rnxp (n: igual, p: numero de variables de calidad). Normalizar X e Y para tener media cero y varianza unidad para cada variable 2.- Inicialización: E0 = X, F0 = Y e uj= cualquier columna de Y 3.- Iterar hasta la convergencia comparando tj con su valor en la iteración anterior, empezando j=1: PLS: fundamentos IV Calcular t1, u1 y w1 de la forma anterior es equivalente a calcular los vectores propios de: XXTYYT, YYTXXT y XTYYTX asociados a los valores propios más grandes. 4.- Calcular pj: 5.- Se escala pj, tj y wj con la norma de pj, anterior p j, nuevo = p j, anterior p j, anterior 2 t j, nuevo = t j, anterior p j, anterior 2 w j, nuevo = w j, anterior p j, anterior 2 PLS: fundamentos V 6.- Se calcula bj: bj = t Tj t j 7.- Se calculan los residuos para la siguiente iteración: E j = E j-1 − t j p Tj u Tj t j Fj = Fj-1 − b j t j p Tj 8.- Hacemos j=j+1 y pasamos al paso 3 para la siguiente iteración. Esto se repite hasta que j=min(m,n) o hasta que se calculen el número adecuado “a” de factores PLS. Este orden de reducción se calcula usando validación cruzada. PLS: predicción PLS puede usarse como modelo de predicción: Se calcula la matriz de regresión B2: B2 j = Wj (PjT Wj ) −1 (TjT Tj ) −1 TjT Y La Y predicha se calcula como: Ypredicha = X * B2 a PLS: para detección y diagnóstico de fallos PLS puede usarse para calcular un modelo de predicción, en este caso Y son las variables de calidad del producto, y se monitorizan las variaciones de X relacionadas con la calidad del producto. Estadística T2: Para los nuevos datos x recolectados de la planta: Normalizar x Calcular: T = x*W 2 Calcular la estadística T Comparar con un umbral Estadística Q: Calcular Q xˆnew = TP T donde Comparar con un umbral PLS: para detección y diagnóstico de fallos PLS discriminante, se usa para detectar fallos, o para distinguir entre diversas clases: Dos posibilidades: PLS1: La matriz Y se forma como una columna de unos La matriz X solo contiene datos de comportamiento normal Se calcula el modelo PLS para este comportamiento 2 Detección: Se calculan las estadísticas T y Q para datos nuevos de la planta y si superan el umbral hay un fallo (no hay comportamiento normal) Diagnosis: o se usa el diagrama de contribuciones como en PCA o se calcula un modelo PLS para cada posible situación de fallo, como hacíamos en PCA. PLS: para detección y diagnóstico de fallos PLS2: La matriz Y: La matriz X tiene variables de todas las posibles situaciones de fallo, colocando en las n1 primeras filas comportamiento normal, en las n2 restantes fallo 1, etc.. Detección y diagnóstico: ⎛1 0 0 L 0⎞ ⎜ ⎟ M M M L M ⎜ ⎟ ⎜1 0 0 L 0⎟ ⎜ ⎟ ⎜ 0 1 0 L 0⎟ ⎜ ⎟ M M M L M ⎜ ⎟ ⎜ Y = 0 1 0 L 0⎟ ⎜ ⎟ ⎜M L O L M⎟ ⎜M L O L M⎟ ⎜ ⎟ 0 0 0 L 1 ⎜ ⎟ ⎜M M M L M⎟ ⎜⎜ ⎟⎟ 0 0 0 L 1 ⎝ ⎠ Calcular B2 Calcular la Y predicha: Ypre= x * B2a Comparar con la Y original p columnas n1 primeras filas indican que hay un fallo de tipo 1 Ejemplo. Dos tanques comunicantes I Datos reales: planta de laboratorio: dos tanques comunicantes. Ejemplo. Dos tanques comunicantes II Fallos considerados: Atasco a la salida del primer tanque: f1 Atasco a la salida del segundo tanque: f2 Fallo en el sensor de nivel 1: f3 Fallo en el sensor de nivel 2: f4. Consideramos un modelo PLS para cada tipo de fallo Se calculan las dos estadísticas T2 y Q, pero la más eficaz es Q, porque T2 da muchas falsas alarmas, por lo que los resultados sólo muestran al estadística Q. Ejemplo. Dos tanques comunicantes III PLS1 para detección de fallos: Un modelo PLS de comportamiento normal Fallo en el sensor de nivel Fallo en la bomba Ejemplo. Dos tanques comunicantes IV PLS1 para detección y diagnóstico de fallos: Modelo PLS con comportamiento normal Modelo PLS con datos de fallo en el sensor de nivel 1 del 40% en el instante 1000 Modelo PLS con datos de fallo en el sensor de nivel 2 del 40% en el instante 1000 Etc Testeamos con un fallo en h1 del 30% en el instante 1500 Ejemplo. Dos tanques comunicantes V Comportamiento del modelo PLS de h1 con datos de fallo en h1: Comportamiento del modelo PLS de h2 con datos de fallo en h1: Comportamiento del modelo PLS de q1 con datos de fallo en h1: Comportamiento del modelo PLS de q2 con datos de fallo en h1: Ejemplo. Dos tanques comunicantes VI PLS2: utilizar PLS2 para distinguir distintas clases X datos de 2 clases: comportamiento normal y fallo en h1 Calculamos Ypred= X*B2a=> y representamos las tres componentes de Ypred (nos hemos quedado con 3 factores PLS) Ejemplo. Dos tanques comunicantes VII Ahora pongo PLS2 con 3 clases (normal, fallo en h1 y fallo en h2) Si hay 4 clases FDA: Análisis discriminante de Fisher FDA. Fundamentos I FDA también es una técnica de reducción de la dimensionalidad. La dimensionalidad se reduce en términos de maximizar la distancia entre varias clases. FDA determina un conjunto de vectores de transformación lineal que: Maximiza la distancia entre clases Minimiza la distancia dentro de la propia clase Método útil para detectar fallos: cada clase es una posible situación de operación de la planta: Clase 1: comportamiento normal Clase 2: comportamiento con fallo 1 etc FDA. Fundamentos II Se define n: como el número de observaciones, m: número de variables, p es el número de clases y nj es el número de observaciones de la clase j. Los datos se almacenan en la matriz X ∈ R(nxm) ⎛ x11 ⎜ ⎜ x 21 X=⎜ ... ⎜ ⎜x ⎝ n1 x12 x 22 ... x n2 ... x1m ⎞ ⎟ ... x 2m ⎟ ... ... ⎟ ⎟ ... x nm ⎟⎠ Se define una serie de conceptos: Matriz de dispersión total, St: con x el valor medio total 1 n x = ∑ xi n i =1 n S t = ∑ (x i − x)(x i − x) T i =1 FDA. Fundamentos III Matriz de dispersión de la clase j Sj: S j = T (x − x )(x − x ) ∑ i j i j x i ∈X j donde Xj es el conjunto de vectores xi que pertenecen a la clase j, y x j es el valor medio de los datos de la clase j xj = 1 nj ∑x x i ∈X j i p Matriz de dispersión dentro de las clases Sw: p j=1 Matriz de dispersión entre clases Sb: S b = ∑ n j (x j − x)(x j − x) T j =1 Sw = ∑ S j Notar que: St = Sb + Sw FDA. Fundamentos IV El objetivo para calcular el primer vector FDA, w1, es maximizar la dispersión entre clases mientras que se minimiza la dispersión dentro de la clase: T w Sw max 1T b 1 w1 ≠ 0 w S w 1 w 1 El objetivo del segundo vector FDA es resolver el mismo problema con w2 pero considerando que tiene que ser perpendicular al primer vector FDA, y así sucesivamente. Esto es equivalente a resolver el siguiente problema de valores y vectores propios: FDA. Fundamentos V λk indica el grado de separabilidad entre las clases cuando se proyectan los datos originales sobre el nuevo espacio de dimensión reducida: w Si llamamos Wa a la matriz conteniendo los a primeros vectores FDA elegidos, la transformación de los datos originales sobre este espacio de dimensión reducida es: Problema: elección de los a factores FDA más adecuados: Correlación cruzada Cuando hay pocos datos, elegir a que minimice el criterio: a f m (a) + ~ n fm(a) son los datos mal clasificados ñ es el número medio de observaciones por clase FDA. Detección y diagnóstico de fallos I Definir una función discriminante que nos clasifique los datos actuales recogidos de la planta a alguna de las clases definidas: normal, fallo1, fallo2, etc. Un dato se asigna a la clase i cuando el valor máximo de la función discriminante gi satisface: La función discriminante que minimiza el error cuando ocurre el evento, vi (por ejemplo un fallo) es: donde P(vi|x) es la probabilidada posteriori de que x pertenezca a la clase i FDA. Detección y diagnóstico de fallos II p(x v i )P(v i ) Según la regla de Bayes: y suponiendo que los datos están normalmente distribuidos P(x v i ) = P(v i x ) = p(x) 1 ⎤ ⎡ 1 T −1 exp (x μ ) Σ (x μ ) − − − i i i ⎥ 1/2 ⎢⎣ 2 (2π2m/2 [det (Σ i )] ⎦ La función gi(x) definida anteriormente se puede sustituir por: sustituyendo la probabilidad: 1 m 1 g i (x) = − (x − μ i ) T Σ i−1 (x − μ i ) − ln2π − ln[det(Σ i )] + lnP(v i ) 2 2 2 FDA. Detección y diagnóstico de fallos III y si caracterizamos dicha función para nuestro caso particular, considerando los vectores FDA, la función discriminante para cada clase es: ⎛ 1 ⎞ 1 T g j (x) = − (x − x j )Wa ⎜ Wa S j Wa ⎟ ⎜ n j −1 ⎟ 2 ⎝ ⎠ ⎞⎤ 1 ⎡ ⎛⎜ 1 T Wa S j Wa ⎟⎥ − ln ⎢det ⎟⎥ 2 ⎢ ⎜⎝ n j − 1 ⎠⎦ ⎣ −1 WaT (x − x j ) + ln(p i ) Para clasificar datos se calcula la función discriminante para cada clase y la mayor de ellas nos dice a que clase pertenecen los datos actuales recogidos de la planta. FDA: Ejemplo. I Planta real de dos tanques comunicantes. Un modelo FDA con las 5 clases (clase 1: situación normal, clase 2: fallo en el sensor de nivel del tanque 1, clase 3: fallo en el sensor de nivel del tanque 2, etc.) En cada caso tenemos 2 vectores FDA, si proyectamos los datos de cada posible situación sobre el modelo FDA: Dispersión entre clases: FDA: Ejemplo II Calculamos las funciones discriminantes Sin fallo Con fallo 1 FDA: Ejemplos III Fallo 2 Fallo 3 Fallo 4: fallo en q2 FDA: Ejemplos IV Una solución más eficaz: Detectar fallos con PCA o PLS (sólo un modelo PCA o PLS con datos de comportamiento normal). Diagnosticar con FDA: un modelo FDA con 4 clases de datos: fallos pero no el comportamiento normal. FDA: Ejemplos V Fallo 1 Fallo 4