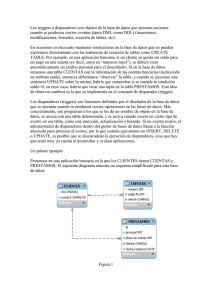

Arquitectura de bases de datos

Anuncio