la autonomía de las tradiciones experimentales como problema

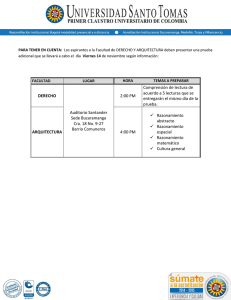

Anuncio