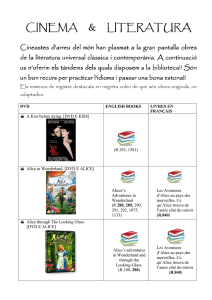

TECHNOLOGIES DE LA TELEVISION

Anuncio