El juego de las potencias - Ciencia sin seso…locura doble

Anuncio

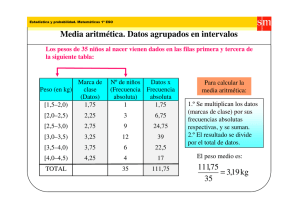

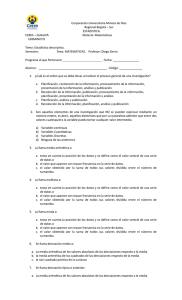

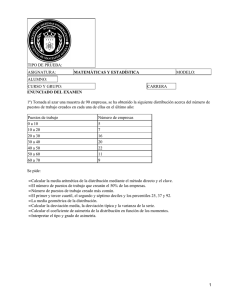

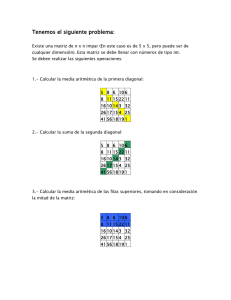

El juego de las potencias Los números son una cosa muy curiosa. Parece increíble a veces lo que se puede conseguir haciendo operaciones con algunos de ellos. Incluso puedes obtener otros números diferentes que expresan cosas distintas. Este es el caso del proceso mediante el cual podemos tomar los valores de una distribución y, a partir de la media aritmética (una medida de centralización) calcular cómo se separan de ella el resto de los valores e ir elevándolos a potencias sucesivas para obtener medidas de dispersión e, incluso, de simetría. Ya sé que parece mentira, pero os juro que es verdad. Lo acabo de leer en un libro bastante gordo. Os cuento cómo… Una vez que tenemos la media aritmética podemos calcular el promedio de separación de cada valor respecto a ella. Restamos a cada valor la media y lo dividimos por el total de valores (es como calcular la media aritmética de las desviaciones de cada valor respecto a la media de la distribución). Pero hay un pequeño problema: como la media siempre está en medio (de ahí su nombre), las diferencias de los valores mayores (que serán positivas) se anularán con las de los valores menores (que serán negativas) y el resultado será siempre cero. Es lógico, y es una propiedad intrínseca de la media, que se aleja de todos una cantidad promedio igual. Como no podemos cambiar este carácter de la media, lo que sí podemos hacer es calcular el valor absoluto de cada resta antes de sumarlas. Calculamos así la desviación media, que es el promedio de los valores absolutos de las desviaciones de los valores con respecto a la media aritmética. Y aquí empieza el juego de las potencias. Si en lugar de hacer el valor absoluto de las rectas las elevamos al cuadrado antes de sumarlas podemos calcular la varianza, que es la media de las desviaciones al cuadrado con respecto a la media aritmética. Ya sabemos que si hacemos la raíz cuadrada de la varianza (para recuperar las unidades originales de la variable) obtenemos la desviación estándar, que es la reina de las medidas de dispersión. ¿Y si elevamos las diferencias al cubo en lugar de al cuadrado?. Pues calcularemos el promedio del cubo de las desviaciones de los valores con respecto a la media. Si pensamos un poco en seguida nos daremos cuenta de que al elevar al cubo no perdemos los signos negativos. De esta forma, si hay predominio de valores menores (la distribución está sesgada hacia la izquierda) el resultado será negativo y, por el contrario, si predominan los valores mayores, positivo (la distribución estará sesgada hacia la derecha). Un último detalle: para poder comparar este índice de simetría con otras distribuciones debemos estandarizarlo dividiéndolo por el cubo de la desviación típica, según la fórmula que os pongo en el recuadro adjunto. La verdad es que, viéndola, acojona un poco, pero no os preocupéis, los programas de estadística pueden con esto y con cosas peores. Y como ejemplo de cosa peor, ¿qué pasa si elevamos las restas a la cuarta potencia en lugar de al cubo?. Pues calcularemos el promedio de la cuarta potencia de las desviaciones de los valores con respecto a la media. Si nos paramos a pensar un segundo, rápidamente entenderemos su utilidad. Si todos los valores están muy cerca de la media, al multiplicarlos por sí mismos cuatro veces (elevarlos a la cuarta potencia) se harán más pequeños que si están muy alejados de la media. Así, si hay muchos valores cerca de la media (la curva de la distribución será más puntiaguda) el valor será menor que si los valores están más dispersos. Este parámetro puede estandarizarse dividiéndolo por la cuarta potencia de la desviación estándar para obtener el apuntamiento o curtosis, lo que me da pie a introducir tres palabros más: si la distribución es muy puntiaguda se denominará leptocúrtica, si los valores están dispersos por los extremos la llamaremos platicúrtica y, si ni una cosa ni la otra, mesocúrtica. ¿Y si elevamos las restas a la quinta potencia?. Pues no sé deciros qué ocurriría. Afortunadamente, y hasta donde yo sé, a nadie se le ha ocurrido todavía semejante ordinariez. Todo este cálculo de medidas de centralización, dispersión y simetría puede parecer el delirio de alguien con muy poco trabajo, pero no os engañéis: son muy importantes, no solo para resumir de forma adecuada una distribución, sino para determinar el tipo de prueba estadística que debemos utilizar cuando queramos hacer un contraste de hipótesis. Pero esa es otra historia…