La trampa de la ratio - Ciencia sin seso…locura doble

Anuncio

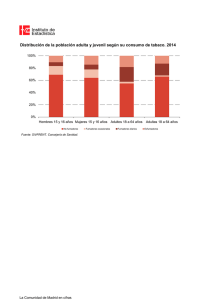

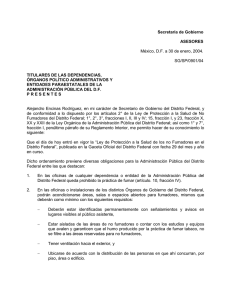

La trampa de la ratio El mundo de la ciencia está lleno de trampas. Las hay por cualquier parte. No se libran ni tan siquiera las grandes revistas médicas ni los autores más prestigiosos. Muchos de ellos tienden a aprovecharse de nuestra ignorancia utilizando los indicadores de medida que más interesan para mostrar los resultados que se buscan. Por este motivo, tenemos que estar muy alerta siempre y fijarnos en los datos de los estudios para llegar a nuestra propia interpretación. Desgraciadamente, no podemos evitar que se manipulen los resultados o la forma de presentarlos, pero sí que podemos pelear contra nuestra ignorancia y hacer siempre lectura crítica de los trabajos científicos. Un ejemplo de lo que estoy hablando es la elección entre riesgos relativos y odds ratios. Ya sabéis la diferencia entre riesgo y odds. El riesgo es una proporción entre los sujetos que presentan un evento y el total de sujetos susceptibles. Así, podemos calcular el riesgo de sufrir un infarto entre los que fuman (fumadores infartados dividido por el total de fumadores de la muestra) y entre los que no fuman (lo mismo, pero con no fumadores). Si vamos un paso más allá, podemos calcular la razón de los dos riesgos, llamada riesgo relativo (RR) o razón de riesgos, que nos indica cuánto más probable es que se produzca un evento en un grupo respecto al otro. Por su parte, el concepto de odds es un poco diferente. La odds nos indica cuánto más probable es que se produzca un suceso frente a que no se produzca (p/(1-p)). Por ejemplo, la odds de sufrir un infarto en fumadores se calcularía dividiendo la probabilidad de infarto en fumadores (fumadores infartados dividido por el total de fumadores de la muestra, exactamente igual que el riesgo) por la probabilidad de no sufrir infarto (fumadores no infartados dividido por el total de fumadores de la muestra o, lo que es igual, uno menos la odds de padecerlo). Al igual que hacíamos con los riesgos, podemos calcular la razón de las odds de los dos grupos y obtener la odds ratio (OR), que nos da una idea de cuánto más probable es que se produzca el evento es un grupo que en el otro. Como veis, son conceptos parecidos, pero diferentes. En ambos casos el valor nulo es uno. Un valor mayor que uno indica que los sujetos del numerador tienen más riesgo y un valor menor que uno, que tienen menos riesgo. Así, un RR de 2,5 querría decir que el grupo del numerador tiene una probabilidad un 150% mayor de presentar el evento que estemos midiendo. Una OR de 2,5 quiere decir que es una vez y media más probable que ocurra a que no ocurra el suceso en el grupo del numerador. Por otra parte, un RR de 0,4 indica una reducción de la probabilidad de ocurrir del 60% en el grupo del numerador. La OR de 0,4 es más compleja de interpretar, pero viene a decir más o menos lo mismo. ¿Cuál de las dos debemos utilizar?. Depende del tipo de estudio. Para poder calcular el RR tenemos que calcular previamente los riesgos en los dos grupos, y para eso tenemos que conocer la prevalencia o la incidencia acumulada de la enfermedad, por lo que esta medida suele utilizarse en los estudios de cohortes y en los ensayos clínicos. En los estudios en los que no se conoce la prevalencia de la enfermedad, como es el caso de los estudios de casos y controles, no hay más remedio que usar OR. Pero el uso de OR no se limita a este tipo de estudio. Podemos usarla cuando queramos, en lugar de los RR. Además, un caso particular es cuando se recurre a modelos de regresión logística para ajustar por los diferentes factores de confusión detectados, que proporcionan OR ajustadas. En cualquier caso, el valor del RR y de la OR es similar cuando la prevalencia del efecto es baja, por debajo de un 10%, aunque la OR siempre es un poco más baja que el RR para valores menores de uno y un poco más alta para valores mayores. ¿Un poco?. Bueno, a veces no tan poco. En la figura tenéis representada, aproximadamente, la relación entre OR y RR. Veis que, a medida que la frecuencia del evento aumenta, la OR crece mucho más rápido que el RR. Y aquí es donde viene la trampa, ya que para un mismo riesgo, el impacto puede parecer mucho mayor si usamos una OR que si usamos un RR. La OR puede ser engañosa cuando el evento es frecuente. Veámoslo con un ejemplo. Imaginemos que estoy muy preocupado con la obesidad entre los asistentes a una sala de cine y quiero evitar que entren a ver la película con un tanque enorme de una bebida azucarada cuya marca no voy a mencionar. Así que mido cuántos espectadores compran la bebida y veo que son el 95%. Entonces, otro día diferente, coloco un cartel en el bar advirtiendo de lo malo para la salud que es tomar bebidas azucaradas en grandes cantidades y veo con agrado que el porcentaje de los que la compran baja a un 85%. En este caso, la medida absoluta de efecto sería la diferencia de riesgos, que es solo de un 10%. Algo es algo, pero no parece demasiado, solo consigo concienciar a uno de cada 10. Veamos qué pasa con las medidas de asociación. El RR se calcularía como el cociente 95/85 = 1,17. Esto indica que si no colocamos el cartel, el riesgo de comprar la bebida es un 17% mayor que si lo ponemos. No parece demasiado, ¿verdad?. La odds de comprar sería de 95/(1-95) sin cartel y de 85/(1-85) con cartel, luego la OR sería igual a (95/5)/(85/15) = 3,35. Quiere decir que es tres veces más probable comprar sin cartel que con cartel. Parece claro que el RR da una idea que se corresponde mejor con la medida absoluta (la diferencia de riesgos), pero ahora os pregunto: si mi cuñado tiene una fábrica de carteles, ¿qué medida creéis que emplearía?. Sin duda, os presentaría la OR. Por este motivo, siempre debemos mirar los resultados para ver si podemos calcular alguna medida absoluta a partir de los datos del estudio. En ocasiones esto no es tan fácil como en nuestro ejemplo, como ocurre cuando nos presentan las OR que salen del modelo de regresión. En estos casos, si conocemos la prevalencia del efecto o enfermedad en estudio, siempre podemos calcular el RR equivalente con la siguiente fórmula: Y aquí dejamos las trampas por hoy. Veis como se puede manipular la forma de expresar los resultados para decir lo que uno quiere sin llegar a mentir. Hay más ejemplos de mal uso de medidas de asociación relativas en lugar de absolutas, como el de utilizar la diferencia relativa del riesgo en lugar de la diferencia absoluta. Pero esa es otra historia…