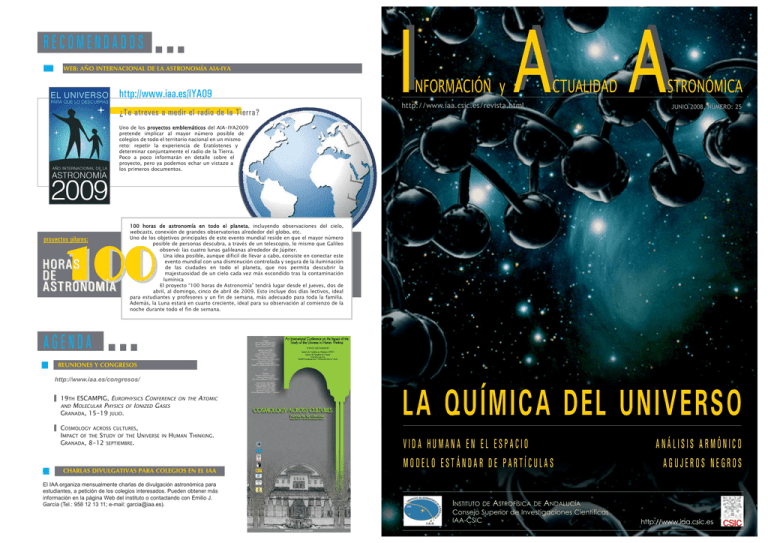

Descargar número completo

Anuncio