Resultados en España del estudio PISA 2000

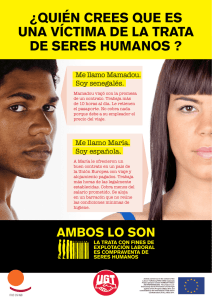

Anuncio