La voz y su especto (PDF Available)

Anuncio

SIGMA

27

LA VOZ Y SU ESPECTRO

Belén Ruiz Mezcua (*)

INTRODUCCIÓN

En este artículo se incide sobre la importancia de las matemáticas en el mundo real, específicamente en el entorno de el procesamiento del lenguaje natural. Cada vez es más importante

tener una interacción con las máquinas más cercana a la comunicación oral, a la que los

humanos accedemos desde edades muy tempranas. Los primeros sentidos que se desarrollan

plenamente en los humanos son los que nos permiten la comunicación oral, así un bebé

cuando llega al mundo lo primero que hace es llorar para permitir la entrada del aire en su

aparato fonador que incluye los pulmones. Tras ello la comunicación con el exterior se produce a través del tacto, la succión y el llanto, siendo la visión uno de los sentidos más tardíos

en la interacción con el exterior.

Es por esto y por la posibilidad de acercar las máquinas al mundo de discapacitados, tanto físicos como motrices, que la comunicación oral con las máquinas ha cobrado una importancia

vital en los últimos tiempos.

No obstante si bien la voz es el medio de comunicación más usual, los humanos producimos y

percibimos la misma con gran redundancia y de ella extraemos la información más relevante.

Es muy importante determinar cómo se produce y percibe la voz a la hora de realizar su tratamiento automático para incluirlo en nuestras máquinas.

Veremos a lo largo de estas páginas el método de producción de voz y su modelado matemáticos.

También se repasará la importancia de su tratamiento espectral que consigue reducir de una

manera importantísima la cantidad de material acústico sin perder la información que permanece en ella.

MECANISMOS DE PRODUCCIÓN DEL HABLA

Para determinar las operaciones de un sistema automático de reconocimiento de voz y

hablante, es fundamental conocer y determinar los mecanismos que han producido un mensaje hablado, para, a continuación poder reproducirlos automáticamente. Es por ello que se

van a repasar algunos conceptos fundamentales y básicos en el mecanismo de producción del

habla, tanto en el órgano físico que soporta dicho mecanismos, como la producción propia

del mensaje.

El aparato vocal consta esencialmente de los siguientes órganos que se ilustran a continuación

(figura 1) : pulmones, tráquea, laringe y los tractos vocal y nasal.

(*) Departamento de Informática. Universidad Carlos III de Madrid

Noviembre 2005 • 2005eko Azaroa

179

Belén Ruiz Mezcua

Figura 1. Estructura del aparato fonador

La laringe alberga las cuerdas vocales, que son pequeñas membranas de piel que vibran al pasar

el aire entre ellas. El hueco que existe entre ambas se llama glotis. El tracto vocal, de unos 17

cm en un adulto, es un tubo que se extiende desde los labios hasta la laringe. El tracto nasal es

también un tubo de unos 12 cm que va desde los orificios nasales hasta el velo del paladar.

El velo del paladar controla el acoplo entre los dos tractos de la siguiente manera: en sonidos

no nasales éste se cierra y el aire pasa por el tracto vocal. En los sonidos nasales el velo permite

pasar el aire hacia el tracto nasal, cerrándose el vocal en los labios. En los sonidos nasalizados

el aire pasa por ambos tractos.

La función de los pulmones en la producción de habla es de gran importancia. Éstos son los encargados de impulsar el aire hacia el resto de los órganos con la ayuda muscular del diafragma.

Los sonidos de que consta el habla se pueden clasificar básicamente en tres tipos:

• Sonoros. Son aquellos sonidos que hacen vibrar las cuerdas vocales. Esta vibración es

cuasi periódica y su espectro es muy rico en armónicos que son múltiplos de la frecuencia

de vibración de las cuerdas. A esta frecuencia de vibración de las cuerdas se le llama frecuencia fundamental. La frecuencia fundamental depende de la presión ejercida al pasar

el aire por las cuerdas, y de la tensión de éstas. En un hombre la frecuencia fundamental

se encuentra en el rango 50-250 Hz, mientras en la mujer el rango es más amplio, encontrándose entre 100 y 500 Hz.

• Sordos. En estos sonidos, que se caracterizan por no provocar la vibración de las cuerdas

vocales, se distinguen dos variedades diferentes: fricativos y aspirados.

En los sonidos fricativos se produce un estrechamiento del tracto vocal por el que se hace

pasar el aire, lo que proporciona como resultado una excitación de ruido aleatorio.

En los sonidos aspirados la "turbulencia" en el paso de aire se produce en la glotis.

180

SIGMA Nº 27 • SIGMA 27 zk.

La voz y su espectro

• Plosivos. Estos sonidos se producen por la existencia de una obstrucción temporal al paso

del aire.

Podrías poner algunos ejemplos de cada sonido en el castellano. No?

Falta un epígrafe que indique algo así como construcción del mensaje donde englobas los

fonemas y esas cosas que ya están definidas para el idioma en particular. Algo así que indique

que los mensajes están estructurados en frases, las frases en palabra y las palabras están constituidas por unidades básica concatenadas y en la gramática ...

FONEMAS

El habla se puede ver como una secuencia de unidades básicas de sonido o fonemas. Los

fonemas son unidades lingüísticas abstractas y no pueden observarse directamente en la señal

de voz. Un mismo fonema se aplica a muchos sonidos ligeramente diferentes llamados realizaciones del fonema o alófonos.

Podemos clasificar los fonemas atendiendo a dos criterios: modo de articulación y punto de

articulación. En el castellano se definen 24 fonemas que se clasifican en la siguiente tabla

de dos entradas (tabla 1) atendiendo a los dos criterios enunciados.

Así mismo se indica el carácter sonoro (SN) o sordo (SR) del fonema.

Tabla 1. Clasificación de los fonemas del castellano

Punto de

articulación

Modo de

Articulación

Labiales

Abierto

Dentales

Alveolares

Palatales

SN

SN

SR

SN

d

t

SR

Plosivas

b

p

Nasales

m

SN

SR

SN

SR

Laterales

Fricativas

SR

SR

n

ñ

l

ll

f

s

Vibr simple

r

V. Comp.

r

SN

SR

g

k

y

x

SN

SR

h

c

Africadas

Semivocales

Glotales

Bilabiales Labiodentales

SN

Vocales

Velares

a

e,i

w

o,u

j

Las vocales en castellano no se suelen clasificar de la manera anterior sino que responden a

una clasificación más sencilla atendiendo a la posición de la lengua (anterior, media o posterior) y a la abertura de la boca (cerradas, medio cerradas o abiertas), como se ilustra en la

tabla siguiente (tabla 2).

Noviembre 2005 • 2005eko Azaroa

181

Belén Ruiz Mezcua

Tabla 2. Clasificación de los fonemas vocálicos

Posición de

la lengua

Abertura

de la boca

ANTERIORES

CENTRALES

POSTERIORES

CERRADAS

i

u

MEDIO CERRADAS

e

o

ABIERTAS

a

COARTICULACIÓN Y PROSODIA

El habla es mucho más que la simple secuencia de fonemas. La articulación de un fonema en

realidad no es la ideal, sino que viene modificada por la articulación de los sonidos de alrededor. Este fenómeno se conoce por coarticulación, y da lugar a un gran número de variedades

alofónicas. La coarticulación es el mecanismo que hace que una secuencia de sonidos tenga

al oírla una apariencia natural, y es una de las principales dificultades en la síntesis de voz.

Una secuencia de fonemas coarticulados tampoco hace habla, el habla además de presentar

efectos coarticulatorios, presenta variaciones de su frecuencia fundamental, la intensidad y el

ritmo a lo largo del tiempo. Entonación, intensidad y ritmo constituyen la prosodia. Entre los

ejemplos de la información que proporciona la prosodia se incluye el carácter enunciativo

o interrogativo de una frase por la variación de la frecuencia fundamental al final de ésta; la

acentuación (incremento de la intensidad y variación del ritmo) a menudo distingue dos palabras que constan de los mismos sonidos,...

ANÁLISIS DE LA SEÑAL DE VOZ

El análisis de la señal de voz se puede abordar desde dos puntos de vista: estudiando las características temporales de la voz, o analizando las características espectrales de la voz. Al primero se le llama

análisis en el dominio del tiempo, e incluye medidas de parámetros como la tasa de cruces por cero,

la autocorrelación,... El segundo, llamado análisis en el dominio de la frecuencia, pretende localizar

parámetros de la señal de voz atendiendo a la información que provee su espectro. Este último es el

que cobra mayor importancia debido a su utilización en los sistemas automáticos del habla.

Aunque la voz cambia a lo largo del tiempo, y por tanto no se puede hablar de estacionareidad, la voz está producida por unos órganos físicos que tienen una cierta inercia mecánica

o lo que es lo mismo, no pueden cambiar demasiado rápido. La voz generada mientras los

órganos permanecen en una cierta posición, sí se puede considerar estacionaria, y en su estudio se pueden emplear numerosas técnicas.

Persiguiendo la adquisición de segmentos de voz estacionarios se ha desarrollado el análisis a

corto plazo de la voz, que consiste en tomar muestras de voz cada 10 a 30 msec. de manera

que la voz se pueda considerar estacionaria en este intervalo.

La mayoría de los sistemas de análisis usan este método y realizan el análisis de tramas de

voz de 10 a 30 msec.

Es importante conseguir tramas estacionarias de voz para poder realizar su análisis espectral.

182

SIGMA Nº 27 • SIGMA 27 zk.

La voz y su espectro

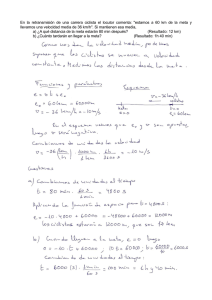

PRE-ÉNFASIS

En el espectro de los segmentos de voz sonoros, la amplitud decae con la frecuencia debido

fundamentalmente a la característica espectral de emisión de las cuerdas vocales. Aunque este

efecto se ve compensado por las características de emisión de la boca, la disminución aún es

significativa por lo que es necesario compensarla.

Se ha comprobado experimentalmente que esta disminución es de 6dB/octaba, lo que hace

que cada vez que se dobla la frecuencia, la amplitud se reduzca a 1/16 de la original.

El mecanismo usado para compensar este efecto se denomina pre-énfasis, y consiste en la

implementación de un filtro paso alto de pendiente 6db/octaba.

En tecnologías digitales el filtrado paso alto más sencillo se realiza mediante la operación

y[n] = x[n] – ax[n]

Donde y[n] es la muestra de salida del filtro de pre-énfasis, y x[n] y x[n-1] las muestras actuales y anterior respectivamente. La transformada z de la anterior expresión proporciona una

función de transferencia de la forma

H(z) = Y(z)/X(z) = 1- az-1

Aunque en el caso de segmentos de voz sordos el pre-énfasis no es necesario, por simplicidad,

y dado que no afecta negativamente al sistema, se mantiene su uso.

ENVENTANADO HAMMING

Una trama de voz de 10 a 30 msec contiene las muestras correspondientes a ese segmento de

voz, podríamos decir que la voz se ha multiplicado por una ventana rectangular de amplitud

1 y duración la de la trama. Al realizar una transformación de Fourier sobre esta trama, la

transformada resultante será la convolución de las dos transformadas, esto lleva a que aparezcan términos de altas frecuencias en lo que se supone que es el espectro de mi señal de

voz. Estas frecuencias altas son indeseables y representan el escalón o discontinuidad de mi

ventana rectangular.

Con el fin de evitar esta aparición de componentes en altas frecuencias, se suaviza el enventanado de manera que responda a una curva continua. Una de las ventanas más usadas es la

ventana de Hamming cuya expresión general es:

W[nT] = {0.54 – 0.46 cos(2πn/N)},

0<N

= 0 , en el resto de los casos

Donde N es el número de muestras de mi ventana.

Esta ventana presenta un filtrado de las frecuencias altas con un rechazo de unos 40 dB.

FFT

El medio más utilizado para extraer el espectro de mi señal de voz es la Transformada discreta

de Fourier (DFT) y el algoritmo más utilizado la FFT.

Noviembre 2005 • 2005eko Azaroa

183

Belén Ruiz Mezcua

Las expresiones para la Transformadas discretas de Fourier directas e inversas se derivan de

las expresiones análogas para señales continuas. El proceso de paso de estas expresiones para

trabajar con señales discretas nos lleva a

Expresiones respectivamente de la transformada directa y la inversa, donde T es el periodo de

muestreo y N el número de muestras en nuestra trama. De los sumatorios se puede ver que el

orden de operaciones necesario para realizar la transformación es de N2. Este número de operaciones puede ser inaceptable en términos de tiempo, lo que ha motivado que se buscasen

algoritmos de cálculo de la DFT que redujesen esta complejidad.

La FFT es el algoritmo más usado y logra reducir el número de operaciones a Nlog2N mediante

la realización de la transformada por un método recursivo. Descripciones de este algoritmo se

pueden encontrar en múltiples referencias, baste citar [RABINER L. & JUANG B.H. 93].

BINS

El aparato auditivo humano, entre sus muchas partes alberga la membrana basilar, que básicamente transforma las ondas sonoras incidentes sobre ella en impulsos eléctricos que llevan

al cerebro información acerca del sonido que hemos recibido. A lo largo de esta membrana

se encuentran numerosos órganos llamados células pilares que son las que efectivamente realizan la conversión sonido-impulso nervioso. Se ha demostrado que este conjunto de células

pilares y membrana basilar presenta una respuesta proporcional al logaritmo de la frecuencia.

De manera que un incremento lineal en la membrana basilar lleva a incrementos logarítmicos

en la frecuencia.

Con el objetivo de tener en cuenta esta mayor sensibilidad del oído humano a las bajas frecuencias se realizan sucesivos filtrados del espectro de mi señal de voz. Estos filtrados se pueden ver como un banco de filtros triangulares más estrechos a frecuencias bajas, y más anchos

en las altas, de modo que reduzco la información del espectro a unos cuantos parámetros que

representan grosso-modo la envolvente de mi espectro.

CEPSTRUM Y CEPSTRUM

Para extraer la información del tracto vocal, es necesario separar esta información de la correspondiente a la frecuencia de vibración de las cuerdas vocales. Si X() es el espectro de un

tramo sonoro de voz, P() el espectro de la componente debida a la frecuencia fundamental,

y H() el espectro del tracto vocal, la relación entre las tres se puede ver como

|X()| = |P()| · |H()|

Tomando logaritmos en la anterior expresión, las componentes del tracto vocal y de la frecuencia fundamental se relacionan por una suma, la correspondiente a la frecuencia fundamental tendrá mayor frecuencia que la de la envolvente espectral, por lo que la primera puede

ser eliminada por un filtrado paso bajo.

184

SIGMA Nº 27 • SIGMA 27 zk.

La voz y su espectro

Una posterior transformación inversa de Fourier de la señal me conduce al dominio cepstrum

que es un dominio análogo al de tiempo pero en el que he eliminado las componentes relativas a mi frecuencia fundamental.

En nuestro sistema este esquema no es exactamente así ya que el filtrado del que hablamos

en esta sección no ha sido homogéneo, lo que hace que nuestra escala de "tiempos" incluya

información sobre la percepción que de los sonidos hace el aparato auditivo humano. A esta

escala se la llama habitualmente mel-cepstrum.

Los ∆cepstrum no son más que la resta de un cepstrum menos el mismo de la trama anterior,

estos ∆cepstrum proporcionan información de cómo varía la voz trama a trama, esto es de

la velocidad de variación de la voz, y es útil en el reconocimiento de palabras aisladas.

La señal de voz es el resultado de la convolución de la respuesta impulsional de filtro resonante que representa al tracto vocal h(n) y de la excitación e(n) (pulsos periódicos/ruido) (1).

Considerando que Se() –espectro de la excitación– es constante (2), H(z) se puede considerar un filtro todo polo, dando lugar a la codificación LPC clásica que realiza la deconvolución entre la señal de voz y la señal de excitación obteniendo las características del filtro del

tracto vocal, que es inherente a cada persona. En ambientes ruidosos el modelo todo polos

no es válido y por lo tanto, tampoco la codificación LPC. Sabemos que la autocorrelación

es más robusta al ruido que la propia señal de voz, ya que si consideramos un ruido blanco

y gaussiano, la secuencia de autocorrelación sólo se ve afectada en su primer término R(0)

(3), donde Rc es en ausencia de ruido. Es por ello, que se prevé que una codificación (por

ejemplo, LPC) que parta del dominio de la autocorrelación será más robusta al ruido que

si partimos de la señal de voz. Al ser la señal de voz real su autocorrelación tendrá simetría par, por lo que estudiando su parte causal obtendremos la información de toda ella. Si

definimos R+(n) como la parte causal de la autocorrelación (4) [RABINER Y SCHAFER, 78],

su transformada de Fourier se corresponde con el espectro complejo (5), donde S() es el

espectro (FFT) de R(n) y SH() es la transformada de Hilbert de S().Debido a la analogía

entre S+() y la señal analítica usada en modulación de amplitud, se puede definir una

"envolvente" espectral como E() (6). Esta característica de envolvente, junto con el gran

margen dinámico del espectro de la señal de voz, origina que E() enfatice las frecuencias

de mayor potencia, que son precisamente las más robustas a un ruido de banda ancha.

Como conclusión podemos decir que el cuadrado de la envolvente espectral E2(), que es

además el espectro de R+(n), será más robusto al ruido que el propio espectro. Estas propiedades sugieren que es más factible obtener una representación espectral robusta al ruido

aplicando un modelo de predicción lineal a R+(n), que directamente de la señal de voz. Al

igual que la técnica LPC estándar asume un modelo todo polo para S(), la técnica consistente en aplicar LPC a la parte causal de la autocorrelación ,llamada OSALPC[HERNANDO,

NADEU, LLEIDA, 92], equivale a suponer un modelo, todo polo para E2() (8). Se demuestra

[HERNANDO, NADEU, LLEIDA, 92] que B() depende de Se() y A(), y por lo tanto, no

puede ser considerada constante. Esto implica que E2() no puede considerarse como un

filtro únicamente con polos, sino que también tendrá ceros. Por lo tanto la parametrización

OSALPC no realiza una deconvolución entre el filtro y la señal de voz, como la LPC clásica,

en cambio, realiza una deconvolución parcial de la señal de voz, que si bien no se corresponde con un modelo todo polos, si que proporciona mejores resultados en presencia de

ruido que la LPC clásica.

El proceso de cálculo de los coeficientes OSALPC [Hernando, Nadeu, Villagrasa, Monte, 94]

es el siguiente:

El término R(0) se coloca a 0 ya que es el más susceptible al ruido.

Noviembre 2005 • 2005eko Azaroa

185

Belén Ruiz Mezcua

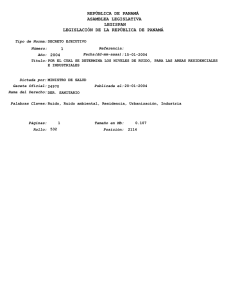

Figura 2. Espectro LPC, en ausencia de ruido (línea continua) y con 10dB (línea discontinua

186

SIGMA Nº 27 • SIGMA 27 zk.

La voz y su espectro

Para comprobar los excelentes resultados de la parametrización OSALPC compararemos los

espectros de un segmento de la vocal "a" (8bits / 11KHz) codificado mediante LPC y OSALPC

en ausencia y en presencia de ruido con una relación de 10 dB:

En las gráficas podemos observar dos hechos:

1) Sin ruido la parametrización LPC es mejor que OSALPC, ya que esta última sólo representa las frecuencias de mayor potencia (debido a la deconvolución parcial)

2) LPC se ve gravemente degradada en presencia de ruido mientras que OSALPC es mucho

más robusta y mantiene sus características. Es de uso común el realizar un procesado

homomórfico a los coeficientes LPC o OSALPC obteniendo como resultado los coeficientes cepstrales o CEPSTRUM, los cuales representan la respuesta aproximadamente

logarítmica del oído.

Método de Reconocimiento

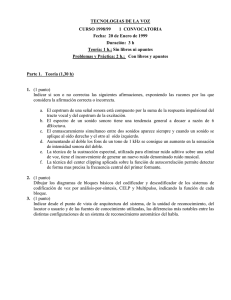

El resultado de la parametrización es una sucesión de M vectores cepstrales de orden p:{Xt}

(un vector por cada ventana estudiada). Para obtener un único elemento que represente la

identidad del locutor se hallará la matriz de covarianza (9)[BIMBOT Y MATHAN, 96]. La

matriz de covarianza, cuyos elementos de la diagonal son la covarianza de las componentes

de los vectores cepstrales, nos informa de las capacidades articulatorias del locutor (como por

ejemplo, la velocidad media de variación de los parámetros espectrales,...). Una vez definida

la matriz como unidad que identificará a cada locutor, debemos plantearnos como medir la

distancia entre la matriz de un locutor de test y las de referencias (que se habrán creado en el

proceso de entrenamiento).

Figura 3. Matriz de covarianza y distancia aritméticoarmónica de esfericidad

Codificación robusta de la señal de voz en ambientes ruidosos

Sea Y la matriz de test y X la de referencia. Existe una gran familia de medidas que se pueden expresar como una función de los valores propios de Y·X-1, cuanto más cercanos estén

a la unidad más parecidas son las matrices X e Y. Si llamamos A a la media aritmética de los

valores propios y H a la media armónica, podemos definir la distancia aritmético-armónica

de esfericidad (10). Si las matrices son iguales la distancia será cero. Para evitar calcular de

forma explícita los valores propios, se puede expresar a partir de las trazas (11) siendo más

rápido de calcular.

Noviembre 2005 • 2005eko Azaroa

187

Belén Ruiz Mezcua

Fase de Entrenamiento y de Test

Fase de entrenamiento

Cualquier sistema de reconocimiento para poder ser operativo debe tener un grupo de locutores que deseen ser identificados o verificados, ellos configurarán la base de locutores de

referencia. Para crear dicha base deberán pronunciar cada locutor un texto de 15’’ de duración

(aprox), y de él se extraerá la matriz de covarianza que representará a cada locutor. Como para

calcular las distancias hará falta su matriz inversa también se realizará en esta fase, guardando

para cada locutor la matriz y su inversa.

Fase de identificación

Cuando un locutor quiera ser identificado (por lo tanto debe pertenecer a la base de referencia) deberá pronunciar una frase (de 3’’ aprox), a partir de ella se extraerá su matriz de covarianza y su inversa. Luego se calculará la distancia entre el locutor test y todas y cada una de

las referencias. Aquella que de distancia mínima será la identidad del locutor.

Fase de verificación

Al ser independiente de texto, las distancias suelen ser muy variables en función de su duración, por lo que es muy difícil elegir un umbral. Para evitarlo se deben normalizar las distancias calculando su verosimilitud [MONTACIÉ Y LE FLOCH] según (12), donde d(X,Y) es la

distancia entre el test y la referencia correspondiente a la identidad pretendida y el sumatorio

se corresponde a las k (13) referencias más cercanas, siendo N el no total de locutores. Si

definimos la tasa de falsa aceptación (FA) como la posibilidad de que un locutor que no perteneciendo al conjunto de locutores referencia, pretenda acceder y sea aceptado; y la tasa de

falso rechazo (FR) a que un locutor perteneciente sea rechazado, el umbral deberá elegirse tal

que iguale ambas tasas. En el proceso de test se calculará la verosimilitud y si es menor que

el umbral se aceptará, si no se rechazará.

Resultados

Identificación

Se ha denominado proyecto LOCUS [GARCÍA LÓPEZ,96] a la implementación de un sistema

automático de identificación y verificación de locutor basado en un PC y adquirido mediante

una tarjeta de sonido estándar. Todo el software de reconocimiento así como el control de la

tarjeta ha sido realizado en C++. Para probar el sistema se ha creado una base de 50 locutores

grabados a 16KHz y 16 bits (base LOCUS-16, la grabación se realizó en una única sesión por

lo que no se pudo observar el problema de la variabilidad temporal de la voz. Cada locutor

grabó 15’’ para la fase de entrenamiento y 5 frases de 3’’ para realizar los test. Se usó un filtro

de preénfasis 1-0.95·z-1. Se implementaron las parametrizaciones LPC-Cepstrum y OSALPCCepstrum. El proceso de test se dividió en:

188

SIGMA Nº 27 • SIGMA 27 zk.

La voz y su espectro

• Sin ruido: Se usaron las 5 frases para cada locutor. (250 test en total).

• Con ruido: Se formaron 2 frases de test de 6’’ cada una. (100 test en total), se añadió ruido

gaussiano (generado a partir de una distribución uniforme y aplicándole la distribución de

Rayleigh[GARCÍA LÓPEZ,96]) con las relaciones señal/ruido tabuladas a continuación.

Los resultados obtenidos son:

S/N →

30dB

20 dB

10dB

0dB

LPCC

100%

94%

41%

8%

2%

OSALPCC

100%

97%

69%

27%

6%

Sobre un subconjunto de 20 locutores, los resultados fueron:

S/N →

30dB

20 dB

10dB

0dB

LPCC

100%

100%

92,5%

40%

10%

OSALPCC

100%

100%

100%

62,5%

15%

Para comprobar el efecto del proceso de adquisición de la señal de voz, se hicieron los mismos

experimentos sobre 20 locutores grabados a 11KHz y codificados a 8 bits (base LOCUS-8):

S/N →

30dB

20 dB

10dB

0dB

LPCC

100%

100%

82,5%

35%

5%

OSALPCC

100%

100%

100%

57,5%

12,5%

Verificación

De las 5 frases de test se usaron 3 de ellas para determinar un umbral por verosimilitudes.

Luego se simuló un proceso de verificación con las 5 frases de test, cada locutor probó con

todas las identidades de los 50 locutores, los resultados fueron:

• Cálculo del umbral: Umbral = 0.55 (FA = FR = 0%)

• Proceso de test: Acierto: 98% (FA = 0.8%, FR = 1.2%).

Conclusiones

El proceso de reconocimiento de locutor parte de la extracción de las características que

definen la identidad del locutor a partir de su voz, para ello se obtienen las parametrizaciones LPC o OSALPC, ambas hallan las características del tracto vocal (que es inherente a cada

persona). Hemos estudiado como afecta la presencia de ruido en el proceso de identificación,

observando que:

• El proceso de reconocimiento de locutor es muy sensible al ruido.

• En su ausencia hay un 100% de acierto, siendo LPC un mejor estimador de la envolvente

espectral que OSALPC.

Noviembre 2005 • 2005eko Azaroa

189

Belén Ruiz Mezcua

• En presencia de ruido LPC se degrada rápidamente mientras OSALPC es más robusta

para relaciones señal/ruido moderadas. Aumentando la probabilidad de error de forma

considerable al aumentar el no de locutores.

• La adquisición afecta sensiblemente a los resultados, observando que con 16KHz y 16bits

se obtiene una mejor representación de la señal de voz ( y de la identidad del locutor)

que con 11KHz y 8 bits.

En todas estas pruebas no se ha podido observar el fenómeno de la variabilidad temporal,

hecho muy importante y que obliga a actualizar las bases de locutores en períodos cortos de

tiempo.

El problema de la verificación en sistemas independientes de texto es la gran variación de las

distancias, lo que obliga a normalizarlas calculando la verosimilitud. De esta forma se puede

elegir un umbral sin demasiados problemas.

BIBLIOGRAFÍA

[DODDINGTON, 85] G.R. Doddington: "Speaker Recognition-Identifying People by

their voices", Proceedings of the IEEE, vol 73, Nº 11. November 1985 pp. 1651-1663.

[RABINER Y SCHAFER, 78] L. Rabiner y R. Schafer, 1978: Digital Processing of Speech

Signals. Prentice-Hall.

[HERNANDO, NADEU, LLEIDA, 92] J. Hernando, C. Nadeu, E. Lleida: "On the AR

modelling of the one-sided autocorrelation sequence for noisy speech recognition",

ICSLP’92. Banff (canadá), pp 1593-1596.

[HERNANDO, NADEU, VILLAGRASA, MONTE, 94] J. Hernando, C. Nadeu, C. Villagrasa,

E. Monte: "Speaker Identification in noisy conditions using linear prediction of the onesided autocorrelation sequence". ICSLP 94. Yokohama, pp 1847-1850.

[BIMBOT Y MATHAN, 93] F. Bimbot y L. Mathan: "Text-Free Speaker Recognition

using an Arithmetic-Harmonic sphericity measure". Proc. Eurospeech sept’93. Berlin

(Germany).

[MONTACIÉ Y LE FLOCH] C. Montacié y J. Le Floch: "Discriminant AR-vector models for

free-text speaker verification".

[GARCÍA LÓPEZ, 96] F. García López: "Reconocimiento de locutor en ambientes ruidosos". Trabajo final de carrera Mayo’96. EUP Mataró.

[YOUNG 95] Steve Young, Joop Jansen, Julian Odell, Dave Ollason, Phil Woodland: "The

HTK Book. For HTK v2.0". Cambridge University Technical Services Ltd.

[GRAVIER 99] Guillaume Gravier: "Spro 3.2 User Manual". Ultima actualización

Diciembre 99.

[GAUVAIN J. & LEE C. 94]: "Maximum a posteriori estimation for multivariate gaussian

mixture observations of markov chains, Transactions on Speech and Audio Processing.

vol 2, pp. 291-298.

[MCLAUGHLIN J, REYNOLDS D.A. & GLEASON T. 99]: "A Study of Computation SpeedUps of the GMMUBM Speaker Recognition System". EuroSpeech, vol 3, pp. 1215-1218.

[MUTHUSAMY Y. K., BARNARD E. & COLE R. A. 94]: "Reviewing automatic language

identification". ieee signal processing magazine, vol 11, no 4, pp. 33-41.

190

SIGMA Nº 27 • SIGMA 27 zk.

La voz y su espectro

NIST, (2000): Spoken Natural Language Processing Group.

Web page: http://www.nist.gov/speech/.

[PELECANOS J., MYERS S., SRIDHARAN S. & CHANDRAN V. 2000]: "Vector Quantization

based Gaussian Modelling for Speaker Verification". International Conference on Pattern

Recognition, paper number 1219.

[RABINER L. & JUANG B.H. 93]: Fundamentals of Speech Recognition. Prentice-Hall.

New Jersey.

[REYNOLDS, D. A. & ROSE R. C. 95]: "Robust Text-Independent Speaker Identification

Using Gaussian Mixture Speaker Models". IEEE Transactions on Speech and Audio

Processing, vol. 3, no. 1, pp. 72-83.

[REYNOLDS, D. A. 97]: "Comparison of Background Normalization Methods for TextIndependent Speaker Verification". EuroSpeech, vol. 2, pp. 963-966.

[SCHALKOFF R. 89]: Pattern Recognition. New York: John Wiley & Sons.

[ZISSMAN M. A. 96]: "Comparison of Four Approaches to Automatic Language

Identification of Telephone Speech". IEEE Transactions on Speech and Audio Processing,

vol. 4, no. 1, pp. 31-44.

Noviembre 2005 • 2005eko Azaroa

191

art

digital

r,

e

h

c

s

Café E

a

i Kitaok

h

s

o

y

i

k

A