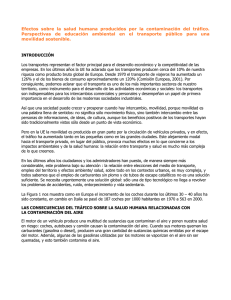

Capítulo 11 - cienciared

Anuncio