Para bajar la revista Tomo 63 Nº 5 - 2012 en formato PDF clic con el

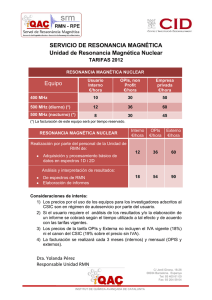

Anuncio