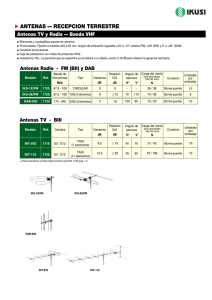

Comparación analítica de arreglos de antenas Yagi por los métodos

Anuncio