CAPITULO II MARCO TEORICO 1. Antecedentes de la

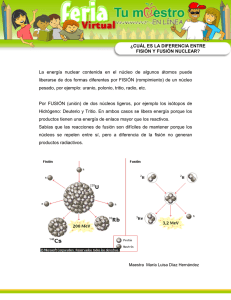

Anuncio