DESARROLLO DE LA CAPACIDAD DE EVALUACIÓN

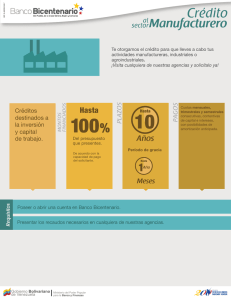

Anuncio