HAI-Principios-2015-con preguntas y ejercicios de autoevaluacion

Anuncio

2015

ha

Cátedras de Hormigón Armado I y II

Rn

Rn Rm

Rn U

U

Sn

P RI NCI P I O S DE C ÁL CUL O E N

HORMIGÓN ESTRUCTURAL

Juan Francisco Bissio

S

S

R=S

R<S (Fallo)

y

R>S (No Fallo)

Pc

Sm

Sm

Rm

a)

x

Rm

R

R

b)

Facultad de Ingeniería de la Universidad Nacional de La Plata

Departamento de Construcciones

1

PRINCIPIOS DE CÁLCULO EN HORMIGÓN ESTRUCTURAL

J.F. Bissio

1) Introducción

En el presente fascículo se abordan algunos aspectos particulares, indispensables para la

comprensión cabal de los contenidos subsiguientes, tanto de esta asignatura como la

inmediatamente correlativa (HAII). Estos aspectos se relacionan, suscintamente, con los

siguientes conceptos:

a) La enseñanza del comportamiento de un cierto material, profusamente utilizado en

la ingeniería civil, como es el hormigón estructural, bajo el permanente enfoque de

aspectos reglamentarios. Un Reglamento, en Ingeniería civil, es la codificación de

una serie de condiciones generales y/o particulares, de aplicación mandatoria para

el desempeño de la profesión y la construcción de estructuras en edterminado

ámbito legal. La mayoría de las materias “físicas” dictadas en una carrera de

ingeniería, es decir, aquellas que tratan básicamente sobre fenómenos de

mecánica del continuo, desarrollan los modelos matemáticos que mejor aproximan

al problema, ajustan sus parámetros a partir de resultados experimentales, y –con

menor frecuencia de la deseada- comparan los resultados obtenidos con valores

experimentales. Rara vez se hace referencia a los aspectos normativos

relacionados con el campo de aplicación de los fenómenos analizados, por

ejemplo, en la enseñanza de la hidráulica. No sucede lo mismo en lo relativo al

diseño y construcción de estructuras de hormigón estructural y también metálicas.

b) El hecho de que los reglamentos citados en el punto anterior tienen como objetivo

primordial proveer Seguridad a los usuarios de las estructuras. ¿Seguridad frente

a cualquier circunstancia? No. Seguridad frente a factores bien conocidos,

relacionados con la variabilidad en las propiedades de los materiales que

componen la estructura, y desconocimiento intrínseco de la magnitud de ciertos

hechos cuya ocurrencia se ubica en el futuro (por ejemplo, la magnitud de un sismo

futuro).

c) La circunstancia insoslayable de que el hormigón estructural pertenece al mundo

real, donde los fenómenos se resisten a las descripciones matemáticamente

elegantes y más o menos rebuscadas, como las que encontramos en los cursos de

estructuras y elasticidad. Un abordaje completo del problema resulta, en realidad,

muchísimo más complejo que cualquier problema relacionado con el acero, los

materiales compuestos aeronáuticos o el plástico más rebuscado. Es probable que

solamente los suelos resulten más complejos de modelar “rigurosamente”. El

comportamiento de una estructura de hormigón armado no es lineal ni elástico,

pero no obstante, las solicitaciones a partir de las cuales de calculan las armaduras

(y a partir de las cuales se evalúa la seguridad…) se determinan normalmente a

partir de programas de cálculo que utilizan la teoría lineal y elástica.

Indudablemente, es un aspecto que debe ser analizado y explicado.

2

SEGURIDAD

2) Seguridad. Esquema General

La seguridad inherente a una estructura, referida la misma a cualquiera de sus Estados

Límite (EL), fue incorporada a la práctica general de la ingeniería estructural -y en

particular a las estructuras de Hormigón Armado- a partir de la segunda mitad del siglo

pasado en su formato actual. Sin embargo, los Reglamentos ya estaban establecidos

como documentos de referencia desde principios del siglo, aunque sin un criterio riguroso

respecto a este tema. Con anterioridad a la introducción de los conceptos probabilísticos,

el formato más utilizado consistía en la limitación de las tensiones de trabajo, suponiendo

un comportamiento elástico lineal para los materiales. De esta manera se establecía un

coeficiente de seguridad único, que dividía a alguna tensión nominal de los materiales. En

el caso de las estructuras metálicas, resultaba natural establecer un valor de tensión

admisible por debajo de la tensión de fluencia del material. Para las estructuras de

hormigón el concepto fue extendido, sobre las base de los procedimientos desarrollados

para analizar el comportamiento de las secciones. En muchas oportunidades, el

coeficiente de seguridad ni siquiera era visualizado como una variable del problema, ya

que directamente se establecían "tensiones admisibles" para los materiales.

Pero resultaba muy difícil justificar la extrapolación de los análisis elástico-lineales para

aplicarlos al comportamiento de las secciones de hormigón armado, y tomó fuerza el

análisis de las mismas en su estado "de Rotura". Aunque este planteo puso

necesariamente de manifiesto la presencia de los coeficientes, su desarrollo no

necesariamente estuvo ligado con el de las teorías de seguridad. En efecto, si bien

formalmente los coeficientes pasaron a afectar las acciones, denominadas "últimas", en

la mayoría de los casos no hacían más que reflejar un ajuste a los antiguos coeficientes

de seguridad utilizados para pasar a tensiones admisibles.

En la década de 1960 comenzaron a imponerse los criterios probabilísticos y el concepto

de probabilidad de falla o fiabilidad estructural. En el ámbito del ACI, el principal

responsable de esta tendencia fue Allin C. Cornell, quien entre otros conceptos

ampliamente utilizados, popularizó el uso del Índice de Fiabilidad . En ese momento

comenzaron a delinearse los primeros esfuerzos serios por alcanzar, entre otras cosas,

niveles de fiabilidad generales y relacionados con el tipo de rotura o la naturaleza de las

acciones en juego. El proceso completo ha involucrado asimismo la adecuación de los

Reglamentos de aplicación a distintos materiales, de forma tal que las acciones se

mayoren de igual manera, independientemente del material. Este esfuerzo ha llegado

hasta nuestros días.

Como ya se mencionó, los conceptos probabilísticos pueden ser aplicados con

generalidad a todos los Estados Límite. De hecho, la confiabilidad de un componente

estructural se define como la probabilidad de no superar ninguno de sus EL. No obstante,

su aplicación se ha afianzado principalmente en el estudio de los Estados Límite Últimos

(ELU), y en ese ámbito se desarrollará esta publicación.

3

El Reglamento nacional Cirsoc 201-05 adopta un esquema general de seguridad

cuyo formato es del tipo:

Resistencia Minorada Solicitación Mayorada

en los que:

Resistencia Minorada: valor de resistencia menor al que se esperaría rompa una

sección. La resistencia nominal se minora de acuerdo a la variabilidad del mecanismo de

rotura, y también a la ductilidad correspondiente (a menor ductilidad, se aplica una

minoración más severa).

Solicitación Mayorada: las acciones individuales se combinan utilizando factores de

mayoración que tengan en cuenta la variación propia de cada una de ellas y la

probabilidad de ocurrencia del estado combinado en estudio.

El Cirsoc 201 expresa el siguiente requisito básico de diseño:

Resistencia de Diseño Resistencia Requerida

Sn U

donde:

: Factor de reducción de resistencia.

Sn : Resistencia nominal.

U : Resistencia requerida.

La Resistencia Nominal se calcula aplicando las expresiones especificadas y/o

permitidas por el Reglamento, utilizando los valores nominales de las resistencias (f’c y

fy). A esta Resistencia se le aplica el Factor de reducción . La Resistencia Requerida

es igual a las solicitaciones producidas por las cargas mayoradas . Por ejemplo, y como

ya se ha estudiado en los cursos de estructuras I y II, para el estado de carga más común

-peso propio D más sobrecarga L- , la combinación aplicable es: 1.2D + 1.6L. En lo

subsiguiente se verá el fundamento de todos estos valores y factores, su justificación y las

bases para una aplicación racional de los mismos en aquellos casos que se escapan de lo

habitual.

La mayoría de los usuarios ve con naturalidad el hecho de mayorar las cargas y minorar

la resistencia, como un intento de alejarse de la igualdad entre resistencia y solicitación.

De la misma manera, muchos piensan que se trata de meros coeficientes de seguridad

en el sentido "antiguo" del término, cuando aquellos se utilizaban para definir tensiones

admisibles alejando la situación de la rotura o el colapso.

Para comprender cabalmente el tema, es necesario introducirse brevemente en la teoría

de la seguridad estructural.

4

3) Conceptos básicos sobre seguridad estructural

La seguridad de una estructura está asociada a cuestiones netamente probabilísticas, es

decir que es posible establecer con cierta exactitud (dependiendo del desarrollo de las

teorías específicas) la probabilidad de ocurrencia de un determinado suceso referido a la

misma, tal como puede ser la rotura o colapso. El concepto de seguridad abarca también

a otros fenómenos aparte de la rotura, tal como las flechas, fisuración y vibraciones, pero

no nos referiremos a ellos en este fascículo.

La razón por la cual es necesario recurrir a la teoría de las probabilidades para estudiar la

seguridad estructural se basa en el carácter aleatorio de, por un lado, las variables que

definen la resistencia de la estructura, como por otro las solicitaciones actuantes. Por lo

tanto, estas variables pueden ser definidas por su función de distribución de

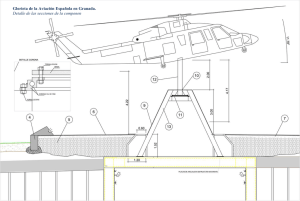

probabilidades (fdp)1, como se muestra en la figura Fig. siguiente:

Por estar calculada con fy y f'c, -que representan percentiles inferiores a la media- la

resistencia nominal Rn

será menor a la media

Rm.

Rn

Rn Rm

Rn U

U

Sn

Sin embargo en el caso

de las acciones, los

valores nominales se

definen de manera tal

que representan un valor

cuya recurrencia es de

50 años, período que

coincide con la vida útil

implícita

para

la

estructura en Cirsoc 201.

Por lo tanto, Sn coincide

con el valor medio de la

variable. Obviamente las

acciones derivadas de

las cargas mayoradas,

representan un valor

superior a Sn.

La cuestión referida a los percentiles para los que se definen las resistencias

especificadas de los materiales merece un tratamiento particular.

1

Matemáticamente, las distribuciones se pueden escribir:

R = Rm k R = Rm (1 k R)

S = Sm k S =Sm (1 k S)

Donde -por ejemplo para el caso de la Resistencia- R representa a cualquier valor posible que puede tomar la

resistencia, y k un parámetro de la distribución, asociado con una determinada probabilidad de excedencia. Los

parámetros restantes (Rm y R, o bien Rm y R) son constantes que definen la distribución, de manera tal que a mayor

coeficiente de variación R , más abierta es la campana.

5

Tensión de fluencia especificada para el acero fy: Cirsoc 201 tiene implícito el percentil

5% (95% de excedencia), mientars que otro formatos reglamentarios como las Normas

ASTM, no definen el acero relacionando su tensión de fluencia directamente por un

percentil determinado, sino a través de un proceso de aceptación.

Resistencia especificada a la compresión para el hormigón f'c: En este caso se

presenta una variación conceptualmente importante respecto a la situación vigente en

otros países y también con criterios ampliamente difundidos en la comunidad

ingenieril, que muestra una gran familiaridad con los valores característicos (95% de

excedencia). El Cirsoc 201-05 vigente considera para f'c un percentil 10% (90% de

probabilidad de excedencia). Esto significa que, para un mismo hormigón, definido por

un valor medio de resistencia fm y un coeficiente de variación , y suponiendo válida

una fdp Normal, sería:

'bk = fm (1-1.645 )

f'c = fm (1-1.28 )

Es el valor de referencia para reglamento basado en valores

característicos.

Es el valor de referencia para el Cirsoc 201

El significado práctico de esta modificación es que un H20 con resistencia característica

de 20 MPa, no es el mismo hormigón que un H20 del Cirsoc 201-05. La diferencia no es

de gran significación, pero debe ser tenida en cuenta. La cuantificación de estas

diferencias se muestra a continuación:

f'c = 1.04 'bk

f'c = 1.07 'bk

f'c = 1.11 'bk

para = 0.10, que representa una dispersión baja.

para = 0.15, lo que se considera una dispersión media.

para = 0.20, un valor relativamente alto.

Ahora bien, el hecho central es que resulta fácil perderse en las matemáticas de las

funciones de distribución de probabilidades, y no entender que significan conceptos como

dispersión, valor medio, o desviación estándar. En la práctica, y por supuesto que luego

de una gran simplificación, lo que sucede es que si –haciendo un experimento mental1500 personas fuesen a la misma planta de elaboración de hormigón a comprar lo que en

principio es el mismo material, digamos un H21, no obtendrían todos una misma

resistencia. Y esto es inevitable, provocado por la variabilidad de las propiedades de los

materiales componentes, el proceso de fabricación, etc.

La figura siguiente muestra hasta que punto se podrían encontrar diferencias en la

resistencia final:

6

H21 - fcm estructura = 22.2MPa - COV=17.5%

40

35

fc (MPa)

30

25

20

15

10

5

0

0

500

1000

1500

Casos Aleatorios

Los valores pueden variar drásticamente entre unos 10MPa y 33 MPa. Es una especie de

lotería, que inevitablemente debe ser considerada a la hora de analizar la seguridad de la

estructura construida con este material.

Y para el acero, se tendría la siguiente situación:

Acero 420MPa - fym = 465MPa - COV=8.5%

700

600

fy (MPa)

500

400

300

200

100

0

0

500

1000

1500

Casos Aleatorios

Es evidente que la dispersión de valores es mucho menor, básicamente debido a que la

fabricación se realiza en condiciones mucho más controladas.

Volviendo al tema central, la seguridad puede ser definida unívocamente por los valores

que toma la variable (R-S), siendo R la resistencia de una estructura y S la solicitación. Es

obvio que para valores positivos de esta variable, no habrá colapso, y lo contrario

sucederá para valores negativos de la misma. Como R y S son variables aleatorias,

debido a la variabilidad e incertidumbre de los parámetros que las definen (resistencias,

dimensiones, acciones naturales,

fdp(R-S)

etc), existe una probabilidad de que

(R-S)

(R-S) tome valores negativos, es

decir, de que ocurra la rotura. Esta

probabilidad

se

denomina

Probabilidad de Fallo (Pf) y está

representada por el área rayada en

la Figura de la izquierda.

P

f

(R-S)medio

La seguridad estructural respecto a

la rotura se evalúa directamente a

través de la probabilidad de que la

7

resistencia de la pieza sea superada por las solicitaciones, y se la denomina

Probabilidad de Fallo (Pf). Si llamamos Riesgo a cada una de las roturas probables

(considerando roturas por flexión, corte, adherencia, etc), cada riesgo posee una Pf y un

impacto determinado, que se relaciona directamente con las consecuencias (en pérdidas

de vidas, bienes, tiempo o dinero) de que ocurra la rotura. Aún en el caso de eventos

relacionados con estados límite últimos, el impacto de una rotura dúctil por flexión es

radicalmente diferente al de una rotura de tipo frágil, de manera tal que para este último

tipo de evento se debería aceptar una menor Pf que para el primero. Por supuesto que el

impacto producido por el colapso de una estructura es considerablemente mayor que el

producido por una flecha excesiva, pero es necesario señalar que numerosos factores

sociales y hasta políticos inciden en la valoración que una sociedad hace de los diferentes

riesgos (piénsese en el diseño de las centrales nucleares en diferentes regiones del

planeta, por ejemplo). Por lo tanto es natural que, a menor impacto, sea aceptable una Pf

mayor.

Tal como se ha visto, no existe un valor de Resistencia o de Solicitación, sino que hay un

conjunto de valores posibles, cada uno con una determinada probabilidad de excedencia.

Para continuar con una visualización más directa del tema, se presentan a continuación

tres gráficos en los que, una vez más, se presentan para 1500 casos aleatorios, valores

posibles de R, S y del cociente R/S, que es otra manera de visualizar la diferencia (R-S).

Es fundamental ver que, aún cuando el valor promedio de resistencia es bastante mayor

que el valor promedio de solicitación, al analizar (R-S), existen muchas situaciones

cercanas al colpaso, y aún dentro de el mismo.

Resistencia R - Solicitación S

250

R - S (kNm)

200

150

100

50

0

0

500

1000

1500

Casos Aleatorios

Resistencia R / Solicitación S - Valor medio=1.86

4.00

3.50

3.00

R/S

2.50

2.00

1.50

1.00

0.50

0.00

0

500

1000

1500

Casos Aleatorios

8

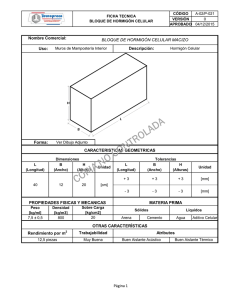

De acuerdo con la forma de las fdp, es más probable encontrar valores cercanos a la

media de cada distribución que aquellos alejados de ésta. Es decir que si se plotearan en

un gráfico de ejes R-S (ver Fig. 3.03 a) puntos representando los pares (R,S) posibles, se

encontraría una gran concentración en torno al punto (R m, Sm) y una menor densidad en

las zonas más alejadas.

Claramente, la recta R=S define la condición de rotura de la sección, y por lo tanto, los

puntos que se encuentren a la izquierda de la misma representarán casos de falla de la

misma. Intuitivamente se puede ver que existe una relación entre la seguridad implícita

de un par (R,S) y su distancia a la recta R=S.

S

S

R=S

R<S (Fallo)

R>S (No Fallo)

y

Pc

Sm

Sm

Rm

a)

x

Rm

R

R

b)

Para cuantificar esta idea intuitiva, se define a esa distancia mínima “d” entre el punto

definido por el par (resistencia media, solicitación media) y la recta R=S (condición de

colapso) como el Índice de Fiabilidad .

= (R-S)m / (R-S)

La utilidad de este parámetro está directamente relacionada con la distribución Normal de

probabilidades, ya que cuando (R-S) está normalmente distribuida, resulta:

{[m-(R-S)m] / (R-S) } m=0= [ -(R-S)m / (R-S) ] = P (R=S) = Pf = ()

Es decir que, en caso de que R-S esté Normalmente distribuida, la Probabilidad de Falla

Pf puede obtenerse de a través de la distribución Normal.

Existe por lo tanto una relación biunívoca entre al Índice de Fiabilidad y la

Probabilidad de Falla de la sección.

La menor distancia entre el origen del sistema (xy) y la recta R=S representa, en el

espacio (x,y) o análogamente (R,S), la menor fiabilidad del sistema. Esta condición está

representada por un punto Pc del espacio, al cual se llamará Punto crítico, Punto de

9

chequeo o Punto de Proyecto. Las coordenadas de Pc, expresadas en el sistema (R,S)

tiene coordenadas Pc (Rc, Sc), que valen:

Rc = Rm - cos R = Rm - 2S R / (Rm-Sm) = Rm - S R / (S2 + R2)1/2

Y de manera análoga:

Sc = Sm + sen S = Sm + 2R S / (Rm-Sm) = Sm + R S / (S2 + R2)1/2

Que también se puede escribir de la forma:

Rc = Rm ( 1 - R R)

Sc = Sm ( 1 + S S)

con R = S / (S2 + R2)1/2 (R 1)

con S = R / (S2 + R2)1/2 (S 1; S2 + R2 = 1)

Comparando con la descripción general de ambas variables aleatorias:

R = Rm ( 1 k R)

S = Sm ( 1 k S)

kR = - R

kS = S

Siendo R y S 1 resulta inmediato deducir que, para obtener una Fiabilidad (asociada

con una Pf = () ), cada variable toma en el Punto de Proyecto valores cuyas

probabilidades (de excedencia para las solicitaciones, y de no excedencia para la

resistencia) son obviamente menores que Pf.

4) Niveles de Fiabilidad asociados a diferentes eventos posibles

Una pregunta de gran importancia en el tema de seguridad estructural es ¿son las

estructuras que diseñamos y construimos, suponiendo que seguimos estrictamente

las prescripciones reglamentarias, totalmente seguras?. La respuesta es: NO. Y no

debe alarmarnos esta respuesta, dado que el mundo está lleno de riesgos para las

personas y los bienes.

Surge entonces la siguiente pregunta, mucho más inetersante: ¿Qué tan seguras son

las estructuras que diseñamos y construimos, suponiendo que seguimos

estrictamente las prescripciones reglamentarias, respecto a otros riesgos

socialmente aceptados?

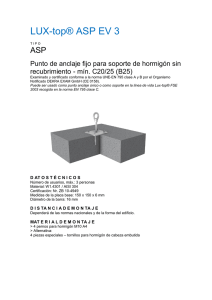

0

1

2

3

4

5

6

1.E-10

1.E-09

1.E-08

T = 50

años

1.E-07

1.E-06

Pf 1.E-05

1.E-04

1.E-03

6

1

D+L

D+L+W

5

D+L+E

4

2

1.E-02

1.E-01

7

En la figura de la izquierda

se

presentan

algunos

ejemplos

emparentados

con la vida común, para

permitir la formación de una

idea

relativa

de

la

seguridad implícita en las

prescripciones del Cirsoc

201. La Figura muestra un

gráfico -Pf , en el que la

seguridad es creciente

hacia arriba el extremo

superior derecho (observar

3

1.E+00

10

que crece en ese sentido, así como P f disminuye). Es importante destacar que todos los

valores mostrados han sido homogeneizados para una exposición de 50 años, que es la

vida útil de la estructura implícita en el PRAEH 201, y por esa razón el Índice de fiabilidad

se indica como 50. Las situaciones mostradas en la figura son:

1: Representa tres estados de carga correspondientes al PRAEH 201. Para Peso propio y

sobrecarga (D+L) se toma =3 para el período de refrencia de 50 años, mientras que

cuando se suman la acción del viento o del sismo, los correspondientes valen 2.5 y 2.

2: Corresponde a una situación social preocupante tal como es la inseguridad en las

ciudades. Representan la probabilidad de resultar herido ya sea por un intento criminal o

en un accidente de tránsito (lesiones dolosas o culposas), en las ciudades de Bs As

(punto superior) y La Plata.

3: Una eventualidad del mismo tipo que la 2, pero de mayor gravedad, ya que se trata de

la probabilidad de resultar víctima de un homicidio doloso o culposo, en la ciudad de La

Plata. Los puntos de 2 y 3 han sido calculados sobre la base de las estadísticas del año

2001. Las correspondientes a 2002 son considerablemente peores y la tendencia es

creciente, por lo que los valores de 50 mostrados son en realidad una estimación

optimista.

4: Muestra una situación más trivial, ya que representa la posibilidad de ganar el premio

principal del Quini 6, jugando todas las semanas durante los 50 años de referencia.

Comparando con los dos puntos anteriores, es mucho más probable resultar víctima de

un delito que ganar el quini 6, por más empeño que se ponga en el intento...

5: Accidentes relacionados con aviones (sobre la base de estadísticas estadounidenses).

El punto inferior corresponde a la probabilidad de morir en un accidente de aviación,

como pasajero. El superior -y por lo tanto menos probable- indica la probabilidad de ser

alcanzado por un avión que cae, estando el sujeto en tierra.

6: Hace unos 65 millones de años, la caída de un meteorito en el golfo de México provocó

una catástrofe global que -se cree- acabó con los dinosaurios y buena parte de la vida

sobre el planeta. El riesgo de que el suceso se repita al menos una vez (no serían

necesarias muchas más) en los próximos 50 años está representado por el punto 6. Por

supuesto, eventos de menor magnitud (digamos aquellos que solamente tendrían efectos

destructivos limitados a una zona) pueden ocurrir con mayor probabilidad.

En resumen: la evaluación de la probabilidad de ocurrencia de un evento debe asociarse

siempre con la consideración de sus consecuencias, aspecto que desafortunadamente es

un parámetro subjetivo ya que depende de la valoración personal y otros aspectos

ambientales que modifican completamente la percepción del riesgo. Algunos autores

sugieren que el cerebro humano podría tener una limitación funcional para interpretar la

realidad desde un punto de vista aleatorio, y que necesita establecer siempre una relación

causa-efecto para sentirse cómodo y seguro. Esta puede ser la razón por la que el ser

humano evalúa de manera bastante errónea las probabilidades y chances reales de

cualquier situación, aún las más obvias, y tiende a dejarse guiar por sus expectativas,

deseos, o valoraciones subjetivas.

La probabilidad de que algún suceso determinado ocurra tiene interés práctico solamente

si se lo relaciona con el posible Impacto o consecuencia del mismo, Por ejemplo, un

11

evento con la capacidad de provocar un daño global a nivel planetario, como el

mencionado meteorito que cayó hace unos 65 millones de años exterminando la mayor

parte de la vida sobre la tierra, posee una probabilidad anual de ocurrencia sumamente

baja (aprox. 1 en 65 millones) comparada con otros eventos destructivos (terremotos,

huracanes, etc.), pero su impacto sería tan grande, que en conjunto representan un riesgo

cuya entidad amerita que las agencias espaciales mantengan programas tendientes a

detectar potenciales objetos estelares en órbitas de colisión con la Tierra. Por otra parte,

otros riesgos son claramente subestimados por la sociedad. Para un período de

exposición de 50 años, la probabilidad de morir en un accidente de tránsito es del orden

de 1 en 63 para nuestro país, mientras que la probabilidad de morir asesinado (en la

Ciudad de Buenos Aires) es de aprox. 1 en 270. Sin embargo, la opinión pública califica al

segundo caso como un riesgo mayor que el primero. La mejor prueba de que el ser

humano valora deficientemente las posibilidades reales puede ser las altas expectativas

que se ponen en los juegos de azar. La posibilidad de ganar el premio principal del Quini

6, jugando todas las semanas durante los 50 años de referencia, es de aproximadamente

1 en 5000. A partir de las estadísticas de accidentes de tránsito, ¡es mucho más probable

resultar víctima de uno de ellos al trasladarnos para apostar, que ganar el premio, por

más empeño que se ponga en el intento!

5) Obtención del formato final de seguridad

En teoría, una vez que se ha establecido o convenido el nivel de seguridad requerido por

los usuarios, se cuenta con los siguientes elementos:

El Índice de Fiabilidad requerido (o la Pf tolerada)

Las solicitaciones establecidas por el Reglamento de referencia (El PR Cirsoc 101, en

nuestro caso, cuya base es ASCE 7). Estas solicitaciones nominales tienen una

determinada probabilidad de excedencia. Para el caso de los pesos propios, por

ejemplo, los valores indicados por el Reglamento coinciden sensiblemente con los

valores medios de la fdp. Para las cargas variables, dado su carácter intrínsecamente

aleatorio, el valor nominal (¡¡ CON LA CORRECCIÓN POR ÁREA DE INFLUENCIA !! )

representa a la media de la fdp en tanto la vida útil de la estructura sea de 50 años.

Ésto es debido a que el valor nominal mencionado corresponde al valor medio de los

máximos valores para recurrencia R=50 años. Los valores nominales para las

acciones de viento (en ASCE 7) también tienen una recurrencia de 50 años.

La resistencia nominal (Rn). esta resistencia también se calcula a partir de valores

nominales de todas las variables. Como ya se mencionó anteriormente, los percentiles

de no excedencia para los que se definen las resistencias especificadas de los

materiales corresponden al 10% para el hormigón y al 5% para el acero. Además,

otras variables cuyo carácter aleatorio no puede ser dejada de lado son las

dimensiones, posición y sección de las armaduras, separación de estribos, etc. Para

estas variables se asume que los valores "teóricos" son medios, y que su fdp es

simétrica (en general Normal). Inclusive los modelos de cálculo pueden ser , ya que

normalmente los precedimientos utilizados incluyen algunas simplificaciones

necesarias para no complicar los procedimientos. Todos estos factores determinan

que la Resistencia Nominal Rn sea cercano aunque algo menor al valor medio Rm.

De lo anterior se desprende que no se puede comparar directamente a la

Resistencia Nominal con las solicitaciones derivadas de las cargas nominales,

12

porque eso conduciría a un valor de (o Pf) diferente al buscado. De hecho,

derivaría en un muy inferior al necesario, o lo que es lo mismo decir, en una

seguridad menor que la requerida.

Para ello, se plantea:

Resistencia de Diseño Resistencia Requerida

Sn U

donde:

: Factor de reducción de resistencia.

Sn : Resistencia nominal.

U : Resistencia requerida, obtenida a partir de las solictaciones calculadas con las

cargas mayoradas.

Se asume que este mecanismo de disminuir la resistencia mediante el factor , y

aumentar las solicitaciones a través de las combinaciones de mayoración de acciones,

conduce a la condición del Punto de Proyecto (Pc).

Como la tendencia de este formato consiste en aplicar coeficientes o factores a las cargas

(acciones) y resistencias finales de las secciones, es común que se lo denomine con la

sigla LRFD (por Load and Resistance Factored Design)

6) Valores de los coeficientes ( factores )

En el punto anterior se estudió el fundamento teórico del formato de seguridad propuesto

por el Cirsoc 201. También se mencionó que para hacer aplicable el esquema, resulta

necesario contar con un juego limitado de factores a aplicar a las acciones y las

resistencias, los cuales deben cumplir con dos premisas:

a) Ser suficientes para cubrir las diferencias intrínsecas entre diferentes tipos de acciones

(permanentes, variables, accidentales) y de mecanismos de rotura (con ductilidad

variable entre ellos).

b) Constituir un cuerpo claro y comprensible, como para que su aplicación masiva sea

sencilla, y por lo tanto aceptada por la mayoría de los involucrados.

Valores aceptables de

En el ámbito del ACI y de la ASCE, esta tarea fue llevada a cabo principalmente por

Ellingwood, McGregor, Galambos y Cornell.

Básicamente estudiaron probabilísticamente los Reglamentos vigentes, a los efectos de

determinar las Pf implícitas en prescripciones cuya base no era estrictamente

probabilística. El estudio incluyó estructuras de HA y metálicas, así como también

diferentes tipos de acciones.

Como resultado final de estos estos estudios (teniendo en cuenta otros tipos de rotura

además de flexión simple), se concluyó que:

13

Para secciones metálicas y de Hormigón Armado, sometidas a flexión y también a

compresión, calculadas siguiendo los estándares vigentes a la fecha, los valores de

Fiabilidad 50 caían en el rango de 2.5 a 3.5, para combinaciones de acciones

gravitatorias (D+L, D+S)

Para el caso de acciones combinadas en las que se encuentran presentes el sismo o

el viento, 50 oscilaba entre 1.75 y 2.5.

Sobre la base de los resultados comentados brevemente arriba, se establecieron los

siguientes valores de 50 como objetivo, con la intención de mantener tan constante como

sea posible la fiabilidad de las secciones, sin que varíen ampliamente al ser sometidas a

acciones de diverso origen y comportamiento:

a)

b)

c)

d)

e)

Peso propio + Sobrecarga (D + L) :

Peso propio + Nieve (D + S) :

Peso propio + Sobrecarga + Viento (D + L + W) :

Peso propio - Viento (D - W) :

Peso propio + Sobrecarga + Sismo (D + L + E) :

50 = 3.0 (Pf 50 = 0.00135)

50 = 3.0

50 = 2.5 (Pf 50 = 0.00621)

50 = 2.0 (Pf 50 = 0.02275)

50 = 2.0

En particular, cuando los miembros estructurales pueden fallar de un modo frágil (caso de

las columnas, por ejemplo), los valores anteriores se incrementan en aprox. 0.50.

Una vez definida la seguridad a ser alcanzada por las estructuras, es necesario

ajustar los factores de mayoración de acciones y los factores de minoración de

resistencia siguiendo los siguientes criterios:

Los factores de mayoración de acciones i se ajustan de manera tal que, para

diferentes composiciones de éstas (% de D, L, W, etc), la Pf se mantenga lo más

uniforme posible (nunca es posible mantenerla constante). Estos factores son

utilizados para todos los tipos de estructuras sometidos al mismo tipo de acción.

Una vez establecidos los i , el ajuste final para lograr el deseado se realiza por

medio de los factores de minoración de resistencias . De esta manera las

características propias de cada material, tipo de rotura, ductilidad, etc, son tenidos en

cuenta a través de estos factores.

Factores de mayoración de acciones

Las combinaciones para cargas gravitatorias (D+L y D+S) son las siguientes:

U = 1.4 (D + F)

U = 1.2 (D + F + T) + 1.6 (L + H) + 0.5 (Lr ó S ó R)

U = 1.2 D + 1.6 (Lr ó S ó R) + (1.0 L ó 0.8 W)

U = 1.2 D + 1.6 W + 1.0 L + 0.5 (Lr ó S ó R)

U = 0.9 D + 1.6 W +1.6 H

U = 1.2 D E + 0.20 (0.70) S

U = 0.9 D E

14

D: CARGAS PERMANENTES

L: SOBRECARGAS

Lr: SOBRECARGA EN CUBIERTAS

F: PRESIÓN DE FLUIDOS

T: ACCIONES POR COACCIÓN, DT, etc.

W: VIENTO

S: NIEVE

E: SISMO

H: PRESIONES DE SUELO

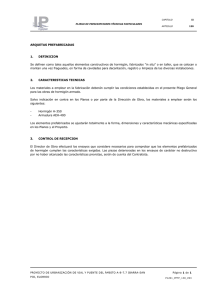

Donde es muy importante considerar que “Ln” es el valor NOMINAL de la sobrecarga, es

decir, con la corrección por área de

influencia (ver PR Cirsoc 101). Los

C'/A

2

valores de sobrecargas indicados en las

(kN/m )

tablas del mencionado Proyecto de

3.0

Reglamento se indican por Lo, y luego de

su reducción por efecto del área de

Máxima Carga sostenida

influencia

se

convierten

en

Ln.

en la vida útil

Obviamente Ln Lo.

2.5

Valor arbitrario (AT) de

la carga sostenida

El fundamento de la reducción de la

acción variable a medida que aumenta la

2.0

superficie cargada es, básicamente,

intuitivo, ya que resulta lógico esperar

que cuanto mayor es la superficie,

1.5

menos probable resulta que se

encuentre cargada en su totalidad.

Experimentalmente se verifica la idea, tal

0

como se aprecia en la Fig. 6-03, que

200

300

100

0

Sup. Influencia (m2)

muestra resultados (círculos y triángulos)

50

75

25

Sup tributaria (m2)

de mediciones de cargas en columnas,

tanto en función de la superficie de

influencia como la tributaria. La expresión que permite obtener Ln en función de Lo es:

Ln = 0.25 Lo [ 1 + 60 / Ai1/2 ]

Donde Ai es la Superficie de Influencia del elemento estructural (no confundir con la

tributaria!)

Pero Ln 0.5 Lo para elementos que soportan un piso, y Ln 0.4 Lo para 2 o más pisos.

Las sobrecargas cuyo valor Lo sea mayor a 5kN/m2 no se reducen, con alguna excepción

Otra cuestión de importancia fundamental es comprender que algunos estados de carga

NO se pueden obtener por simple eliminación de términos en una ecuación que contiene

otras acciones. Para clarificar, si se tiene el caso de un elemento estructural sometido

exclusivamente (o mejor dicho, predominantemente) al peso propio, la acción mayorada

NO VALE U=1.2 Dn. Esto se debe a que los factores de mayoración dependen de la

proporción entre las acciones. Por esta razón, cuando el peso propio es fundamental ( se

puede considerar así solamente cuando Ln/Dn < 0.125), vale:

U = 1.4 Dn (solamente si Ln/Dn < 0.11)

(3)

15

También es fundamental considerar las probabilidades en el caso de que actúen en

simultáneo dos acciones con variabilidad temporal. La variación temporal de L es como se

muestra en la Figura siguiente, con dos componentes bien diferenciadas: La carga

sostenida, cuyas variaciones sustanciales se producen a intervalos de duración

considerable (generalmente relacionados con un cambio en la ocupación del bien), y por

otra parte una componente transitoria de duración muy corta, que en la escala de la vida

útil de la estructura se vé prácticamente como pulsos. El máximo valor de la carga

sostenida (A) en general no coincide con el máximo valor de la carga accidental (B), de

manera tal que el máximo L (C) se ubica con mayor probabilidad en otro momento no

concurrente. Otras acciones variables en el tiempo tienen un comportamiento similar.

Como ya se ha mencionado, los valores Ln

corresponden al valor medio del máximo

C

esperable para un período de referencia de

A

50 años. De manera tal que la cantidad más

B

probable de veces que será alcanzado ese

valor durante esos 50 años es una. Si se

tiene otra acción que tiene una descripción

aleatoria del mismo tipo, como por ejemplo

el viento (W), resulta obvio que la

probabilidad de que ambos máximos se

LAT

alcancen al mismo tiempo es despreciable

comparada con los valores de Pf

Tiempo

aceptables. Concretamente, el valor máximo

de una de las acciones variables será -con

mayor probabilidad- simultáneo con un valor

arbitrario en el tiempo de la componente de carga sostenida de la otra (L AT en el gráfico ).

Este LAT puede expresarse también a partir de el valor nominal de la acción, a través de

un factor AT:

LAT = AT Ln

L

Donde AT puede ser menor que 1. Si se considera la actuación de dos cargas variables

en el tiempo, obviamente se necesitarán dos estados de carga, con el máximo valor de la

primera junto con el valor AT de la otra, y viceversa. Para la actuación combinada de

acciones gravitatorias y viento (D+L+W), las dos combinaciones quedan como sigue:

U = 1.2 Dn + 1.6 Ln + 0.10 Wn

U = 1.2 Dn + 0.5 Ln + 1.6 Wn

Normalmente la primera ecuación resulta prácticamente igual a la que contiene solamente

D y L, hasta el punto de que no es presentada en el cuerpo Reglamentario.

Acciones cuyos efectos se contraponen:

La acción del viento en combinación con cargas gravitatorias (por ejemplo D, que actúa

siempre) origina normalmente fecetos cuyo signo puede ser contrapuesto. En este caso,

puede resultar más desfavorable un valor menor del peso propio. Considerando que la fdp

16

de D es simétrica, tiene sentido tomar como valor de D el simétrico respecto al valor

medio, pero a la izquierda del mismo. Teniendo en cuenta que el valor medio de D (D m)

difiere ligeramente de Dn, siendo Dm/Dn 1.05, el factor a aplicar valdrá:

1.20 Dn = 1.2 Dm / 1.05 = 1.14 Dm luego el valor simétrico a la izquierda de la media será

0.86 Dm, pero para la combinación hay que expresarlo en función de Dn:

0.86 Dm = 0.86 1.05 Dn = 0.90 Dn

Ajustando los factores para obtener un =2.0, se obtiene la combinación:

U = 0.9 Dn + 1.4 W n , pero el Reglamento indica la aplicación de :

U = 0.9 Dn + 1.6 Wn

(6)

Que obviamente se aplica cuando el signo de W n es opuesto al de Dn.

Factores de minoración de resistencia

Los factores consideran, además del ajuste matemático que permite llegar al punto “Pc”,

cuestiones referidas al tipo de rotura, y la ductilidad implícita en la misma. Por ejemplo,

una rotura de compresión simple resulta mucho menos dúctil que la correspondiente a

flexión simple (asumiendo que se provee una cuantía de acero adecuada). Por lo tanto,

resultan los siguientes valores:

a) Flexión Simple

0.90

b) Compresión simple

0.65

c) Corte y Torsión

0.75

Tipo de Rotura

CÁLCULO DE SOLICITACIONES EN ESTRUCTURAS DE HORMIGÓN

ARMADO

7) ¿Es válido el cálculo elástico de solicitaciones?

Es conveniente repetir el concepto vertido en el punto (1.b): El hormigón estructural

pertenece al mundo real, donde los fenómenos se resisten a las descripciones

matemáticamente elegantes y más o menos rebuscadas, como las que encontramos en

los cursos de estructuras y elasticidad. Un abordaje completo del problema resulta, en

realidad, muchísimo más complejo que cualquier problema relacionado con el acero, los

17

materiales compuestos aeronáuticos o el plástico más rebuscado.

Cabe preguntarse entonces, como en el título: ¿Es válido el cálculo elástico de

solicitaciones, en estructuras compuestas por un material (el hormigón armado) cuyo

comportamiento es claramente NO lineal y elástico?. Como se verá en este apartado, y

aunque parezca ilógico, la respuesta es (con algunas consideraciones), SI.

Afortunadamente es así, dado que si se habla de estructuras de barras, los métodos

enseñados (y supuestamente aprendidos) en los cursos de estructuras hiperestáticas,

asumen el comportamiento lineal y elástico del material.

Para entender la –aparantemente- contradictoria aseveración anterior, tenemos unas

pocas pero nobles herramientas que aplicamos profusamente: las condiciones de

equilibrio y los teoremas del cálculo plástico.

A las primeras las aplicamos con total conciencia, citando a Homero (Simpson), “¡en esta

familia, respetamos las leyes de la termodinámica!”. No es poco, consideremos que en

ambientes bastante menos pedestres, como el de los elementos finitos, estas condiciones

no se cumplen en todos los puntos del dominio de análisis. Los segundos suelen ser

aplicados a destajo, pero no siempre con el crédito adecuado. Recordemos brevemente

sus enunciados.

TEOREMA DEL LÍMITE INFERIOR (TLI): Una carga externa calculada a partir de

una distribución de esfuerzos internos adoptada, (pero en equilibrio con la carga

aplicada), y donde en ningún punto se supera el límite plástico, es siempre menor

o igual que la verdadera carga de colapso. Por lo tanto es "segura".

TEOREMA DEL LÍMITE SUPERIOR (TLS): Una carga externa calculada a partir

de un mecanismo adoptado (compatible con los vínculos), es siempre mayor o

igual que la verdadera carga de colapso. Por lo tanto, es "insegura”.

La realidad es que, básicamente, y cuando se trata del cálculo de secciones y estructuras

de hormigón estructural, la mayor parte del tiempo se aplica el TLI y el resto del tiempo, el

TLS. La mayoría de las veces se obvia mencionarlo, y mucho menos hacer referencia a

su carácter “seguro” o “inseguro”. Algunos ejemplos breves pero frecuentes:

Los diagramas de momentos flectores con que se determina las secciones críticas de

dimensionamiento en vigas, obtenidas de un análisis estructural lineal y elástico, son,

además de “la” solución elástica (única), una de las tantas soluciones posibles del TLI. Si

se considera el verdadero comportamiento no lineal de las piezas flexadas, la distribución

de momentos últimos más improbable, es la lineal elástica….pero por supuesto, cumple el

TLI. Lo mismo sucede con las “redistribuciones” tan usuales en la práctica: son una simple

manera de ampliar el margen de posibles distribuciones, un subconjunto dentro del TLI.

18

M Apoyo/ M Tramo - t/tu

Análisis numéricos realizados con relaciones Momento-Curvatura bastante realistas

muestran, para una viga continua de dos tramos con carga uniformemente distribuida, que

es posible diseñar tramo y apoyo con Mu exactamente iguales (mientras que la solución

elástica indica MAp=1.78MTr), llegando a una carga de colapso 11.8% veces mayor que

la carga mayorada (es decir, con un 11.8% de sobrerresistencia), y obteniendo en el

mismo momento una relación de MAp=MTr. En resumen, la validación total del TLI. Los

valores característicos obtenidos a través de todo el proceso de carga se muestran en la

figura siguiente.

2.00

1.80

1.60

1.40

1.20

1.00

0.80

0.60

0.40

0.20

0.00

0.00

0.20

0.40

0.60

0.80

1.00

Pasos de tiempo

MAp / MTr

t / tu

Al analizar placas, la aplicación del TLI implica simplemente “repartir” la carga en tres

términos: ∂2Mx / ∂x2 + ∂2My / ∂y2 + 2 ∂2Mxy / ∂x∂x = q(x,y). Puede hacerse

“sofisticadamente” mediante un programa que brinde una solución particular de la

ecuación de equilibrio, o bien (solamente porque es mucho más simple), se pasa

rápidamente al TLS para aplicar el Método de las Líneas de Rotura… sin percibir muchas

veces que es el “lado inseguro” de los Tepremas del Cálculo Plástico

19

CONCLUSIÓN

El hormigón estructural comenzó a utilizarse en el mundo mucho antes de que se

desarrollara una teoría completa de su comportamiento en cualquier fase de carga. Por

sus características particulares, ninguna de las teorías elásticas lo representa siquiera de

manera aproximada. Los modelos para representar su funcionamiento fueron

desarrollándose durante todo el siglo pasado, siendo uno de los primeros materiales

cuyos códigos incluyeron conceptos probabilistas de seguridad estructural. Estos códigos

serán citados de manera permanente en los programas de estudio de esta asignatura y la

correlativa inmediata, HAII. Todo este conjunto de factores debe estar siempre presente

en la mente del alumno, y también del profesional, porque la cabal comprensión del

comportamiento del material y las estructuras que se emplean en los proyectos, es la

base fundamental de la seguridad.

20

EJERCICIOS Y CUESTIONARIO DE AUTOEVALUACIÓN

1) Considerar un experimento en el que se introducen en una bolsa nueve bolas, tres

de color azul, dos de color blanco y cuatro de color amarillo

a)

Se extrae una bola de la bolsa, calcular la probabilidad de que la misma sea

blanca.

b)

En primer lugar se quita una bola de la bolsa sin dar a conocer el color de la

misma. Posteriormente se repite el experimento del punto (a). Recalcular la

probabilidad de que la bola extraída sea blanca.

c)

Discutir los dos puntos anteriores considerando los conceptos de variabilidad

intrínseca e incertidumbre.

2) Sea una fdp Normalmente distribuida, que representa la resistencia a compresión

de un hormigón, con valor medio = 18MPa y CV = 0.20.

a)

Calcular por integración la probabilidad de que la resistencia se encuentre entre 17

y 19 MPa. Calcular la resistencia característica (valor con 95% de excedencia)

b)

Calcular los mismo valores anteriores pero utilizando las siguientes funciones de

Excel descriptas en el Anexo al final de los enunciados. A partir de aquí, utilizar

siempre estas funciones para calcular probabilidades cuando se lo solicite.

c)

Observesé que se está utilizando una fdp Normal (que admite valores negativos de

la variable aleatoria, ya que su dominio es - a +) para describir la resistencia a

compresión de un material, cantidad que físicamente no puede ser menor que cero.

Calcular la probabilidad de que, según la fdp Normal indicada, la resistencia sea

menor que cero. Opinar si el error cometido es aceptable o no.

3) El valor nominal de una sobrecarga activa se define como aquel que tiene una

probabilidad igual a 50% de ocurrir al menos una vez durante toda la vida útil de la

estructura.

a)

Si para una determinada estructura esta vida útil es de 50 años, calcular la

probabilidad ANUAL de excedencia de la sobrecarga, y el Período de Retorno

asociada (la inversa de la probabilidad anual de excedencia).

Ayuda: Es conveniente considerar el evento opuesto: Si la probabilidad de que ocurra

al menos una vez en 50 años es P%, la probabilidad de que no ocurra nunca durante

el mismo lapso es de (100%-P%), y luego plantear que no ocurre el primer año, ni el

segundo, ni el tercero, etc... Recordar que la probabilidad de ocurrencia simultánea de

N eventos independientes es el producto de las N probabilidades de ocurrencia).

Por ejemplo: Si un determinado evento tiene un período de retorno medio de 5 años,

implica que la probabilidad de que ocurra al menos una vez en un año es de 20%. Si

se quiere calcular la probabilidad de que suceda al menos una vez en un lapso total

de 3 años, existen muchas combinaciones que cumplen la premisa (ocurre el primer

año solo, ocurre el segundo año solo, ocurre el primero y segindo, etc..). Por lo tanto

conviene plantear el suceso que excluye todos: que no ocurra nunca. La probabilidad

21

de que No ocurra durante un año es 1-0.20=0.80, y luego la probabilidad de que No

ocurra en ninguno ed los 3 años es igual a 0.803 = 0.512. Finalmente, la probabilidad

de que ocurr al menos una vez en los 3 años es igual a 1-0.512=48.8%.

b)

Realizar el mismo cálculo, pero considerando que la estructura tiene ahora 75 años

de vida útil, pero manteniendo la probabilidad de excedencia de 50% para toda la vida

útil. Analizar: ¿Deberá usarse el mismo valor de sobrecarga nominal que para 50

años de vida útil?. En caso de cambiar el valor, ¿cambia el riesgo total de que se se

supere esa sobrecarga?

4) Elaborar un gráfico que muestre la variación del Coeficiente de Seguridad

(tomando como tal al cociente Rn/Sn) en función de , siendo:

a) R = 0.12, S = 0.18

b) R = 0.20, S = 0.25

En ambos casos, considerar R=0.57, kn=0

5) Se tiene una viga continua como la de la figura. Todas las cargas indicadas son

independientes entre sí, lo mismo que la componente de peso propio y la de

sobrecarga en cada una de ellas.

PD1, PL1, PW1

PD2, PL2, PW2

tD1, tL1, tW1

tD2, tL2, tW2

PD3, PL3, PW3

tD3, tL3, tW3

PD4, PL4, PW4

tD4, tL4, tW4

Indicar, para cada solicitación determinante (Momentos máximos de apoyos y de

tramos, y Reacciones), el valor mayorado de cada acción. Considerar dos estados de

carga: (a) D+L, y (b) D+L+W. Por ejemplo, para el estado (a), y para el momento

máximo en el voladizo izquierdo, el valor mayorado de P1 es P U1 = 1.20 PD1,+ 1.60

PL1 (solamente de P1, el resto de las cargas tendrá sus propios valores últimos).

Observar que no es necesario calcular las solicitaciones últimas, sino solamente

indicar con que valores mayorados de cada carga se calcularían.

6) ¿Por Que no se pone como condición básica de seguridad que resulte

simplemente Rn ≥Sn?

7) a) Para las sobrecargas de uso definidas en el CIRSOC 101, ¿cuál es el valor más

probable de ocurrencia en la vida útil de la estructura? b) ¿Cuál es el período de vida

útil asumido por el Reglamento CIRSOC para lass estructuras normales de edificios?

22

8) Indicar si en las combinaciones de (D, L) por un lado, y (D, L, W) por otro, los

factores de mayoración de L y W son iguales an ambas, y en caso de no serlo,

explicar la razón.

9) Explicar la variación de la Fiabilidad () con el Coeficiente de Variación de la

resistencia del hormigón.

10) ¿En que formato de seguridad se minoran directamente las resistencias de los

materiales?

11) ¿Cómo se determine el nivel de Fiabilidad acceptable en los reglamentos

modernos?

12) ¿Por que no resulta adecuado el format de Coeficiente de Seguridad Único?

13) ¿Por que se separan los factores de mayoración de las cargas de los factores de

minoración de resistencia?

14) ¿Cuál es la propiedad de una sección flexionada de hormigón estructural que

permite realizar redistribución de esfuerzos internos con mayor libertad?

15) ¿Por que razón, si el horigón estructural persenta un comportamiento claramente

no lineal, es posible dimensionar de forma segura las estructuras cuyas solicitaciones

han sido determinadass por métodos elásticos?

23

Anexo. Funciones de probabilidades en EXCEL.

Excel cuenta con funciones que describen la probabilidad de excedencia (o no

excedencia) de un determinado valor de una variable aleatoria con distribución

Normal Estandard. La distribución Normal Estandard es aquella cuyo valor medio =

0, y cuya desviación estándar = 1, y se nota como N(0,1), siendo su expresión

matemática

x 2

N (0,1)

1

e 2

2

Por ejemplo, la probabilidad de que la variable aleatoria N(0,1) sea menor o igual a X,

se obtiene en Excel mediante la función:

=DISTR.NORM.ESTAND(X)

Valor que sería igual a calcular la integral definida de la función N(0,1) entre - y X.

A partir de lo anterior, si se desea calcular la probabilidad de que la variable aleatoria

N(0,1) se encuentre entre X1 y X2, se hace:

=DISTR.NORM.ESTAND(X2) - DISTR.NORM.ESTAND(X1)

Por ejemplo, si X2=0.57, y X1=-0.23, se obtiene:

=DISTR.NORM.ESTAND(0.57) - DISTR.NORM.ESTAND(-0.23) = 0.30661527 =

30.661527%

Por supuesto que en Excel no es práctico escribir los argumentos de la función dentro

de la misma, sino hacer referencia a una dirección de celda, por ejemplo:

=DISTR.NORM.ESTAND(A3)

Y elaborar tablas como la siguiente:

En la que se observa la simetría de la función N(0,1).

24

Esta función es la que permite obtener la Probabilidad de falla Pf en función del Indice

de Fiabilidad . Por ejemplo, si la = 2.612 , Pf se obtien como sigue::

Pf = -DISTR.NORM.ESTAND(-2.612) = 0.0045

(observar que la función de excel se aplica sobre –)

También es posible calcular en Excel la Inversa a la fdp N(0,1), es decir, dada una

probabilidad “p”, encontrar el valor X de la variable aleatoria cuya probabilidad de no

ser excedida es igual a “p”. en este caso, la función que permite obtener el valor de X

es:

=DISTR.NORM.ESTAND.INV(p)

La tabla siguiente permite ver que se obtienen los resultados inverso que la función

anterior:

Como es lógico, esta función es la que permite obtener el Índice de Fiabilidad en

función de la probabilidad de Falla. Por ejemplo, si la Pf= 0.0045, se obtiene:

= -DISTR.NORM.ESTAND.INV(0.0045) = 2.612

(Una vez más observar el signo menos).

25