los lenguajes de la economa.

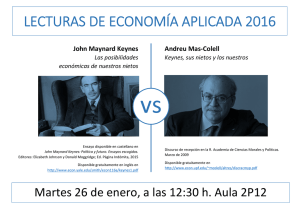

Anuncio