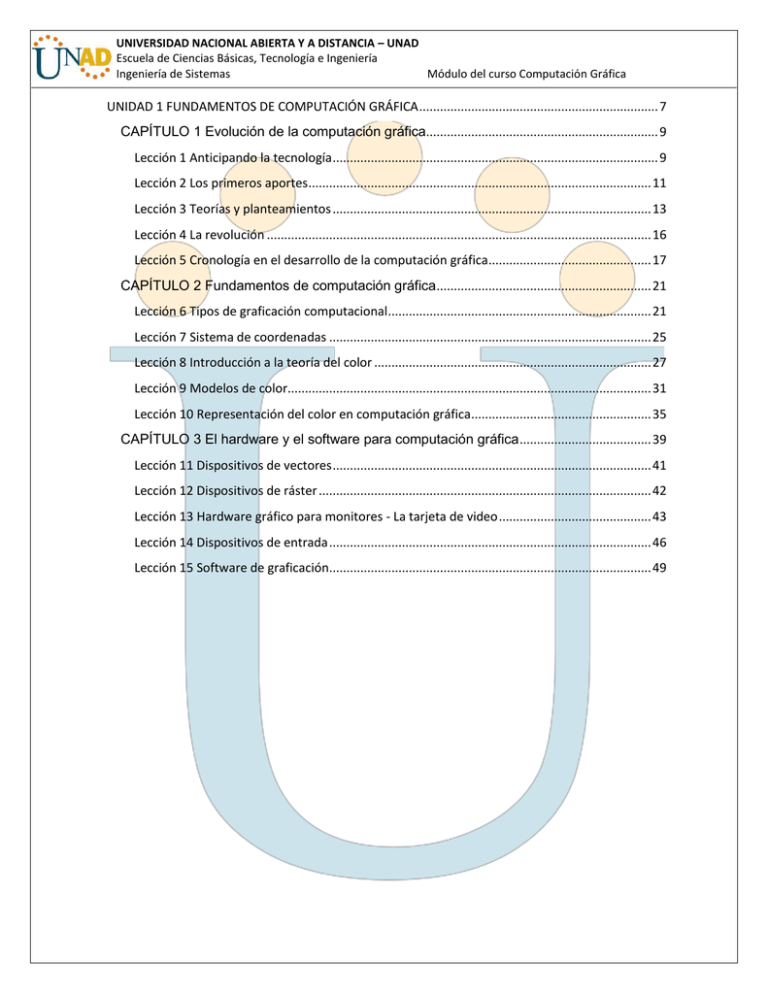

Módulo Computación Gráfica

Anuncio