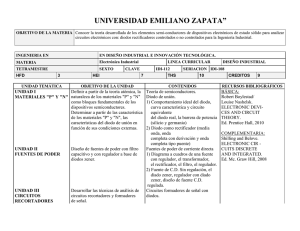

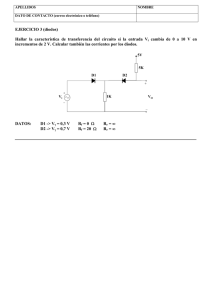

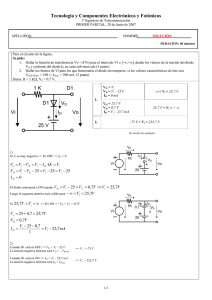

1 7-feb-07 MODULO INTRODUCCIÓN A LA INGENIERÍA

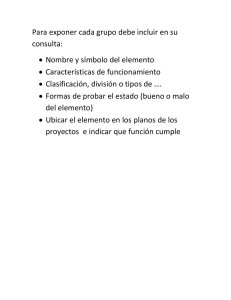

Anuncio