República Bolivariana de Venezuela. Ministerio Del Poder Popular

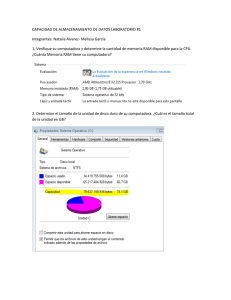

Anuncio