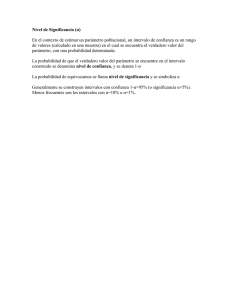

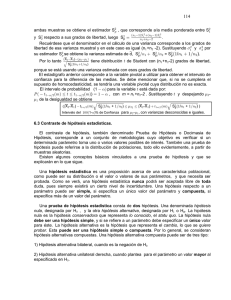

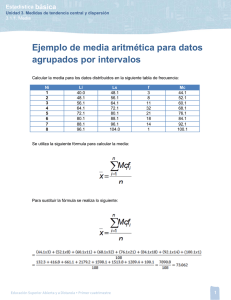

Teoría de la Estimación Estadística Teoría de la Estimación Estadística Razón para estimar Los administradores utilizan las estimaciones porque se deben tomar decisiones racionales, sin que tengan la información pertinente completa y con una gran incertidumbre acerca de lo que pueda deparar el futuro, pero con la esperanza de que las estimaciones posean una semejanza razonable con el resultado Estimador Es la regla o procedimiento, expresado en general por medio de una fórmula, que se utiliza para deducir la estimación. Estimación Es un valor específico observado de un estimador, por lo que asigna un valor numérico a un parámetro de una población sobre la base de datos de muestra. Tipos de estimación a) Estimación puntual: consiste en un solo estadístico muestral que se usa para estimar el valor verdadero de un parámetro de una población que es desconocido. Por ejemplo, la media muestral x es una estimador puntual de la media poblacional μ. Cuando usamos una estimación puntual, sabemos que aunque usemos un método bueno de estimación es prácticamente improbable que el valor de la estimación coincida con el verdadero valor del parámetro, así que sería conveniente acompañar nuestra estimación con alguna medida que nos permitiera expresar la cercanía del estimador al parámetro. Una solución a ello no los brindan los estimadores por Intervalos de Confianza. b) Estimación por intervalo: es la estimación de un parámetro de la población dado por dos números entre los cuales se puede considerar que se encuentra el parámetro. Las estimaciones de intervalo indican la precisión de una estimación y son, por lo tanto, preferibles a las estimaciones puntuales. Características que debe tener un buen estimador a) Debe ser insesgado: un estimador es insesgado, si en promedio, tiende a tomar valores que están por encima del parámetro de la población con la misma frecuencia y la misma extensión, con la que tiende a asumir valores por debajo del parámetro de población que se está estimando. b) Debe ser eficiente: de varios estimadores insesgados, el más eficiente es el que tiene el error estándar más pequeño. c) Debe ser consistente: significa que a medida que aumenta el tamaño de la muestra, la estimación se aproxima al valor del parámetro. d) Debe ser suficiente: significa que ningún otro estimador puede suministrar más información sobre el parámetro. Teoría de la Estimación Estadística Nivel de Confianza Probabilidad asociada con una estimación de intervalo de un parámetro de población. Ésta indica qué tan seguro se está de que la estimación de intervalo incluirá al parámetro de la población. Los niveles de confianza que más se utilizan son 90%, 95% y 99%. Intervalo de Confianza Es el alcance, rango o recorrido de la estimación que se hace y que tiene designada una probabilidad de que incluya el valor real del parámetro de la población que se está estimando. Límites de Confianza Son el límite inferior y superior de un intervalo de confianza. Coeficiente de Confianza Es el nivel de confianza (en valores relativos) que tenemos en que el intervalo contiene el valor desconocido del parámetro. Por ejemplo, para un nivel de confianza del 90%, el coeficiente de confianza es 0,9 Relación entre nivel de confianza e intervalo de confianza Aunque podría pensarse que deberíamos utilizar un alto nivel de confianza (como 99%) en todos los problemas de estimaciones, en la práctica, altos niveles de confianza producen intervalos de confianza grandes y éstos no son precisos. Teoría de la Estimación Estadística Interpretación de los intervalos de confianza Un intervalo de confianza se puede interpretar de dos maneras diferentes. Ejemplo: una directora de tiendas cree que el gasto medio de sus clientes en el último año se encuentra en el intervalo de 35 a 38 dólares y concede una significación del 95% a ese intervalo. Interpretación 1: confía al 95% en que la media poblacional se encuentra entre 35 y 38 dólares. Nota: no significa que haya una probabilidad del 95% de que μ se encuentre entre 35 y 38 dólares. En sentido apriorístico (antes de formar el intervalo de confianza) hay una probabilidad del 95% de construir un intervalo que comprenda a μ, pero una vez fijado el intervalo, μ está o no está comprendido en él; es decir, el 95% de probabilidad se asigna a nuestro grado de confianza de que μ se encuentra en el intervalo, no a la probabilidad de que esté en él. Interpretación 2: si se construyen todos los intervalos de confianza posibles, el 95% de ellos incluirá el parámetro desconocido. Probabilidad de error (el valor α) Es la proporción de intervalos que no contienen el valor desconocido del parámetro. Se calcula utilizando el coeficiente de confianza: α = 1 – Coeficiente de Confianza Intervalos de confianza para la media poblacional y la proporción (muestras grandes) a) Para la media: σ Si se conoce σ: μ = x ± Z σ (recordar: σ x = ) x n s σ̂ No se conoce σ: μ = x ± Z sx (recordar: s x = también es usada: σ̂ = ) x n n s es la desviación típica en la muestra y s = σ̂ . n Observación: si la población es finita y ≥ 0,05 se utiliza también el factor de corrección N N -n N -1 La expresión Z σ o Z s es el margen de error. Gráficamente: x x b) Para la proporción: teóricamente, la distribución binomial es la distribución correcta para utilizarse en la construcción de intervalos de confianza para estimar una proporción, sin embargo, Teoría de la Estimación Estadística debido a que el cálculo de probabilidades binomiales es muy tedioso podemos aproximar a una normal al aumentar el tamaño de la muestra y siempre que nπ y n(1-π) sean mayores o iguales 5. π = p ± Z s (recordar s = σ̂ = p (1 - p) y Z s es el margen de error) p p p p n Intervalos de confianza para la media poblacional (muestras pequeñas) Hasta ahora se había estudiado la estimación para la media poblacional en diversas condiciones, en algunos casos se conocía σ mientras que en otros se eludía esta hipótesis. Se han calculado intervalos de confianza con la hipótesis de una población que seguía una distribución normal y también cuando se suponía que la distribución era desconocida pero a la cual se podía aplicar el teorema del límite central ya que las muestras eran grandes. Sin embargo, en muchas aplicaciones, obtener una muestra grande es poco probable e incluso imposible, por ejemplo, las compañías de seguro que comprueban la resistencia de los carros a las colisiones. Destruir a propósito 30 o más carros puede ser algo caro. Cuando hay que tomar una muestra pequeña, la distribución t de student es más apropiada. El intervalo correspondiente será: μ = x ± t s x (recordar: s x = s n y en donde t sx es el margen de error) La distribución t (a) Características Es simétrica respecto de la media. El eje horizontal es una asíntota y la gráfica se extiende de -∞ a ∞. Su varianza es mayor que 1 por lo que gráficamente esta distribución es más achatada y más dispersa que la normal. La varianza de la distribución depende de los grados de libertad (es el número de valores que podemos escoger libremente. gl = n – 1) n 1 n3 Cuando n ≥ 30, esta distribución se aproxima a una normal. La varianza es σ 2 = b) Condiciones para usar la distribución t: La muestra es pequeña (n < 30) Teoría de la Estimación Estadística No se conoce σ Se supone que la población es normal o aproximadamente normal. c) Características de la tabla de la distribución t: Es más compacta y muestra áreas y valores de t solamente para algunos porcentajes. No se enfoca en la probabilidad de que el parámetro de la población que se está estimando se encuentre dentro de nuestro intervalo de confianza, mide la probabilidad de que no esté dentro de nuestro intervalo de confianza. Se deben especificar los grados de libertad con los cuales se esté trabajando. d) Para tipificar: t = x -μ sx Determinación de tamaño de muestra en estimación ¿Qué tan grande deberá ser la muestra?, si es muy pequeña se puede fallar en la obtención de los objetivos de nuestro análisis; pero si es demasiado grande desperdiciamos recursos cuando tomamos la muestra. Siempre se tendrá algo de error de muestreo debido a que no hemos estudiado a la población completa, cada vez que tomamos una muestra perdemos algo de información útil con respecto a la población; pero ese error se puede controlar si se selecciona una muestra cuyo tamaño sea adecuado. Dado un nivel de confianza que se desea, hay dos factores principales que influyen en el tamaño muestral necesario: a) La variabilidad de la población (queda fuera del control del investigador). b) El grado de error que se puede tolerar. Para la media: n = Z X 2 En donde el denominador es el error. Si no se conoce σ se utiliza una muestra piloto grande para estimarla. Z 2 π (1 -π) Para la proporción: n = En donde el denominador es el error. Si no se conoce (p -π) 2 π se utiliza una muestra piloto para estimarlo o se limita a colocar π = 0,5. Control de la anchura del intervalo Es evidente que si se estrecha el intervalo, se suministrará al investigador una estimación más exacta del valor del parámetro. Hay dos métodos corrientes para estrechar un intervalo, pero para ambos se debe hacer un sacrificio adicional. Estos procedimientos son: a) Ajuste del nivel de confianza: por la propia naturaleza de los intervalos de confianza, si se acepta un nivel de confianza más bajo, se podría generar un intervalo más preciso, menos amplio, pero eso aumenta la probabilidad de error. b) Ajuste del tamaño de la muestra: el aumentar el tamaño de la muestra disminuye el error esperado y es más probable que se de una estimación más ajustada del valor verdadero del Teoría de la Estimación Estadística parámetro, con ello se puede conservar un nivel de confianza determinado y al mismo tiempo disminuir la anchura del intervalo; pero el sacrificio es un aumento ya sea de tiempo, del gasto, etc.; que se exige para recoger los datos para una muestra mayor. Resumen de fórmulas n Estimación de μ Población finita y ≥ 0,05 N σ conocido x±z Población infinita o n < 0,05 N σ σ n N -n N-1 x±z σ̂ N-n N -1 x±z σ̂ n x±t σ̂ n n σ desconocido n ≥ 30 ( σ̂ = s ) x±z n Si n < 30 y la población es normal o aproximadamente normal Estimación de π n ≥ 30 p±z p (1 - p) n Nomenclatura => estimación de la desviación estándar de la población. σ̂ σ̂ x σ̂ p sp => error estándar estimado de la media (recordar: σ̂ x = σ̂ n si la población es infinita) => error estándar estimado de la proporción => estimación del error típico de la distribución muestral de proporciones muestrales. p (1 - p) (recordar que sp = σ̂ p = n ) Teoría de la Estimación Estadística