Traducido del inglés al español - www.onlinedoctranslator.com

HiFi-GAN: Eliminación de ruido y desreverberación de alta fidelidad

basada en funciones profundas de voz en redes antagónicas

jiaqi su1,2, Zeyu-jin2, Adam Finkelstein1

1Universidad

de Princeton

1{jiaqis,af}@princeton.edu

Resumen

Las grabaciones de audio del mundo real a menudo se degradan debido a

factores como el ruido, la reverberación y la distorsión de ecualización. Este

documento presenta HiFi-GAN, un método de aprendizaje profundo para

transformar el habla grabada en sonido como si se hubiera grabado en un

arXiv:2006.05694v2 [eess.AS] 21 de septiembre de 2020

estudio. Utilizamos una arquitectura WaveNet de avance de punta a punta,

entrenada con discriminadores adversarios de múltiples escalas tanto en el

dominio del tiempo como en el dominio de la frecuencia del tiempo. Se basa en

las pérdidas de coincidencia de características profundas de los discriminadores

para mejorar la calidad de percepción del habla mejorada. El modelo propuesto

se generaliza bien a nuevos hablantes, nuevos contenidos de habla y nuevos

entornos. Supera significativamente a los métodos de referencia de última

generación tanto en experimentos objetivos como subjetivos. Términos del

Índice:mejora del habla, eliminación de ruido, eliminación de reverberación,

redes antagónicas generativas, características profundas

1. Introducción

2Investigación

de adobe

2zejin@adobe.com

la estructura U-Net al dominio del tiempo para combinar funciones en diferentes

escalas de tiempo para tareas de separación y mejora del habla [18, 19]. Los

métodos basados en formas de onda tienden a producir menos artefactos

inducidos por fase pero tienen sus propias distorsiones. Nuestros experimentos

también los encuentran sensibles a los datos de entrenamiento y difíciles de

generalizar a ruidos y reverberaciones desconocidos.

Las redes antagónicas generativas (GAN) mejoran la autenticidad del

audio sintetizado al incorporar una pérdida antagónica de un

discriminador [20, 21]. El discriminador aprende a identificar si un ejemplo

de audio dado es real o falso, para alentar al generador a aproximarse

mejor a la distribución de datos reales. Si bien los investigadores han

explorado las características espectrales de las GAN [6, 22], SEGAN [23] y

los siguientes trabajos [24, 25] muestran un éxito inicial de las GAN

operadas en forma de onda para mejorar el habla. Reducen los artefactos

en comparación con otras redes basadas en formas de onda, pero cada

una tiene su propio artefacto único que se vuelve más notorio para una

entrada más distorsionada.

Dado que el oído humano es sensible a la incoherencia en la señal inducida

Las grabaciones del mundo real capturadas en espacios naturales con

por artefactos, es necesario modelar la percepción humana y utilizarla como

dispositivos de consumo suelen contener una amplia variedad de ruido,

objetivos de optimización. MetricGAN [22] y QualityNet [26] optimizan

reverberación y distorsión de ecualización. Sin embargo, muchas

directamente sobre aproximaciones diferenciables de métricas objetivas como

aplicaciones se beneficiarían de grabaciones limpias y de alta calidad. Los

PESQ y STOI; ayudan a reducir los artefactos, pero no de manera significativa, ya

investigadores han desarrollado una variedad de métodos para reducir el

que las métricas se correlacionan mal con la percepción humana a distancias

ruido [1, 2], reducir la reverberación [3, 4], corregir la ecualización [5] o

cortas. Como otra forma de modelar la similitud perceptiva, la pérdida de

mejorar el habla para tareas posteriores como el reconocimiento de voz

características profundas utiliza mapas de características aprendidos para tareas

[6]. Sin embargo, el problema combinado de eliminación de ruido,

de reconocimiento (que pueden verse como percepción de máquina) para

desreverberación y ecualización no se aborda suficientemente. El objetivo

aproximar la percepción humana de otras tareas, por ejemplo, eliminación de

de este documento es mejorar el habla grabada económica del mundo

ruido [27]. Sin embargo, este enfoque se basa en un espacio de características

real para que suene como grabaciones profesionales con calidad de

fijas aprendidas a través de una tarea no relacionada con la eliminación de ruido

estudio para grabaciones de audio de un solo canal.

y, por lo tanto, puede tener un rendimiento inferior en escenarios de

Los métodos tradicionales de procesamiento de señales, como el

filtrado de Wiener [2], el error de predicción lineal ponderado [7] y la

aplicaciones posteriores con diferentes estadísticas de sonido.

Dadas las deficiencias de los métodos anteriores, proponemos HiFi-GAN

factorización de matriz no negativa [8, 9], operan en el dominio de tiempo-

que combina una arquitectura WaveNet de avance de extremo a extremo con la

frecuencia utilizando el conocimiento previo de la estructura espectral del

idea de una combinación profunda de características en el entrenamiento

habla. Se generalizan bien en todas las condiciones ambientales, pero solo

adversario, operado tanto en el dominio del tiempo como en el dominio de la

ofrecen una reducción modesta del ruido y la reverberación. Los enfoques

frecuencia del tiempo. Usamos un conjunto de discriminadores en la forma de

modernos utilizan el aprendizaje automático para modelar el mapeo de

onda muestreada a diferentes velocidades, así como un discriminador en el

una señal reverberante ruidosa a una señal limpia y ofrecen un

espectrograma de mel. Estos discriminadores evalúan conjuntamente varios

rendimiento sustancialmente mejorado en comparación con los métodos

aspectos del audio generado, mejorando así su calidad percibida. Las pérdidas

tradicionales. Los métodos basados en espectros transforman el

de coincidencia de características profundas pueden adaptarse dinámicamente a

espectrograma de una señal de entrada distorsionada para que coincida

la tarea en función de los mapas de características de los discriminadores,

con el de una señal limpia objetivo al estimar un mapeo no lineal directo

estabilizar el entrenamiento GAN y, por lo tanto, mejorar la capacidad de

desde la entrada al objetivo [10, 11], o una máscara sobre la entrada [12,

discriminación. En resumen, nuestras principales contribuciones son: (1) un

13] . Requieren ISTFT u otros métodos para obtener la forma de onda de

método genérico de mejora del habla de alta fidelidad para el ruido, la

las predicciones,

reverberación y la distorsión que se generaliza a los nuevos hablantes, nuevos

Los avances recientes en las arquitecturas de redes neuronales permiten el

contenidos del habla y nuevos entornos; (2) un procedimiento de entrenamiento

mapeo directamente sobre la forma de onda, a pesar de los desafíos duales de

contradictorio que utiliza discriminadores de múltiples escalas y múltiples

alta resolución junto con una estructura temporal densa en muchas escalas.

dominios junto con sus pérdidas de coincidencia de características profundas en

WaveNet [14] y sus variantes de alimentación hacia adelante para la mejora del

aplicación a la mejora del habla; y (3) evaluaciones objetivas y subjetivas tanto en

habla [15, 16] aprovechan la convolución dilatada para habilitar un campo

la tarea de mejora del habla genérica como en la tarea de eliminación de ruido

receptivo grande mientras retienen una cantidad relativamente pequeña de

de referencia, lo que demuestra que nuestro enfoque supera significativamente

parámetros. Wave-U-Net [17] se adapta

los métodos de referencia de última generación.

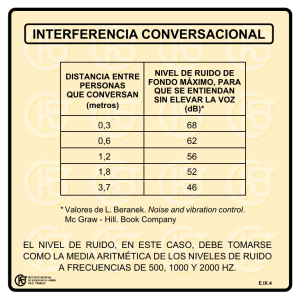

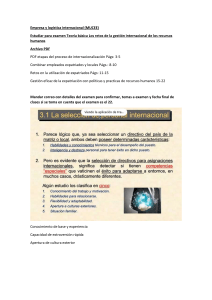

Figura 1:GAN Arquitectura. El Generador G incluye un WaveNet feed-forward para la mejora del habla, seguido de un Postnet convolucional para la

limpieza. Los discriminadores evalúan la forma de onda resultante (DW,a múltiples resoluciones) y espectrograma de mel (DS).

2. Método

Nuestro método se basa en nuestros trabajos anteriores de

mejora del habla motivada por la percepción [16]. Aunque el

trabajo anterior tiene como objetivo la eliminación de ruido y la

desreverberación conjunta en un solo entorno de grabación,

nuestro objetivo es generalizar en todos los entornos. La

arquitectura general se muestra en la Figura 1. Nuestra red de

mejora (Generador G) es una WaveNet de avance [15] que ha

demostrado tener éxito en la eliminación de ruido y la

desreverberación [28, 16]. Sus circunvoluciones dilatadas no

casuales con tasas de dilatación que aumentan

exponencialmente permiten un gran campo receptivo adecuado

para el ruido aditivo típico y la reverberación de cola larga.

También incluimos la pérdida de espectrograma logarítmico y la

pérdida de muestra L1 como componentes básicos de la función

de pérdida, ya que ayudan a acelerar el entrenamiento y sirven

como una métrica de percepción simple. En la práctica,

128. El más grande da más resolución de frecuencia, mientras que el más

pequeño da más resolución temporal. Nuestros experimentos en este

documento operan en 16 kHz para facilitar la comparación con métodos

anteriores, ya que se desarrollan a la misma frecuencia de muestreo. Sin

embargo, el verdadero audio de alta fidelidad exige una frecuencia de muestreo

más alta, para lo cual analizamos las estrategias en la Sección 4. Las secciones

posteriores analizarán las modificaciones a esta arquitectura que aportan una

mejora significativa en la fidelidad.

2.1. posnet

Se ha encontrado que el uso de postnets es efectivo para mejorar la

calidad de la síntesis [29]. Adjuntamos a la red principal una pila simple de

12 capas convolucionales 1D, cada una con 128 canales y una longitud de

kernel de 32.Tanhse utiliza como función de activación entre capas

convolucionales. L1 y las pérdidas de espectrograma se aplican tanto a la

salida de la red principal (antes de la red posterior) como a la posterior a la

red posterior. Esto permite que la red principal se concentre en generar

una versión gruesa del habla limpia mientras que la red posterior elimina

los artefactos para mejorar la fidelidad.

2.2.1. Discriminadores multidominio multiescala

El diseño de los discriminadores está inspirado en MelGAN [21], que utiliza

la discriminación multiescala en la forma de onda en la síntesis de voz. De

manera similar, utilizamos tres discriminadores de forma de onda, que

funcionan respectivamente con versiones muestreadas de forma de onda

de 16kHz, 8kHz y 4kHz, para discriminar en diferentes rangos de

frecuencia. Los discriminadores de forma de onda tienen la misma

arquitectura de red pero no comparten los pesos. Cada red se compone

de una convolución 1D, cuatro bloques de convolución estriados, dos

convoluciones 1D adicionales y una agrupación promedio global para

generar una puntuación de valor real. Leaky Relu se utiliza entre las capas

para la no linealidad. La convolución agrupada se utiliza en lugar de la

convolución tradicional para reducir el número de parámetros

entrenables. Descubrimos que los discriminadores de forma de onda

ayudan a reducir el ruido y el artefacto de filtrado de peine,

También aplicamos un discriminador en el espectrograma de mel,

para diferenciar el habla generada del habla real. La pérdida del

espectrograma L2 a menudo causa efectos de suavizado excesivo que

conducen a una mayor aperiodicidad en los sonidos sonoros y un efecto

fantasma debido a la ambigüedad y la falta de coincidencia entre el F0 y

los parciales. El discriminador de espectrograma agudiza el

espectrograma correspondiente del habla predicha. También es más fácil

identificar residuos de reverberación de largo alcance en el dominio de

tiempo-frecuencia que en el dominio de tiempo. La red consta de cuatro

pilas de capa de convolución 2D, normalización por lotes y unidad lineal

cerrada (GLU), similar a StarGAN-VC [30]

Tener discriminadores de dos dominios diferentes estabiliza el

entrenamiento y equilibra la ponderación de diferentes factores de

cualidades perceptivas, de modo que no se aborde en exceso ningún tipo

de ruido o artefacto. Para todos nuestros discriminadores, usamos la

versión bisagra de la pérdida adversarial [31] para un entrenamiento más

eficiente. Para un discriminador específicoDk, su derrota adversarial en

el generadorLAvanzado

GRAMOy su pérdida discriminadoraLDkson los siguientes:

LAvanzado

GRAMO(x,

x′;Dk) = máx[1− Dk(GRAMO(X)),0]

LDk(x, x′) = máx[1 +Dk(GRAMO(X)),0]

+ máx[1− Dk(X′),0]

(1)

(2)

2.2. entrenamiento adversario

donde (x, x') es el par de entradas de audioXy objetivo de audioX′.

El entrenamiento adversario adicional ayuda a exponer ruidos sutiles y

confrontación funciona mejor junto con la postnet que sin ella. Nuestra

artefactos que no son capturados por funciones de pérdida simples. Empleamos

intuición es que es más fácil para los discriminadores controlar la red

discriminadores tanto de espectrograma como de forma de onda para cubrir

posterior que la red principal altamente no lineal para remodelar la señal.

diferentes dominios y resoluciones. El generador es penalizado con las pérdidas

Si bien ambos mejoraron con el entrenamiento adversario, se pueden

del adversario, así como con las pérdidas de coincidencia de características

observar diferencias de calidad perceptibles para los resultados antes y

profundas calculadas en los mapas de características de los discriminadores.

después de la red posterior.

En nuestros experimentos, descubrimos que el entrenamiento de

tamaños de 1, 4, 4, 4, 4, 1, 1; tamaños de canal de 16, 64, 256, 1024, 1024,

2.2.2. Pérdida profunda de coincidencia de características

Tomada de Computer Vision [32], la idea de pérdida profunda de funciones se ha

aplicado a la eliminación de ruido del habla [27], que utiliza un espacio de

alimentación hacia adelante para pasos de 500K con una tasa de aprendizaje de

entornos y etiquetado de audio doméstico. MelGAN [21] comparte una idea

similar, calculando la pérdida de coincidencia en los mapas de características

profundas de las capas intermedias en el discriminador durante el

entrenamiento. Lo aplicamos a la mejora del habla para permitir la actualización

dinámica de la pérdida de coincidencia de características. Dado que el

discriminador está en competencia dinámica con el generador, su pérdida de

coincidencia de características profundas se mantiene en la parte superior para

detectar diferencias notables, lo que mejora el poder de la discriminación

variable. La pérdida de coincidencia de características profundas también evita

que el generador se colapse, un escenario de falla común de las GAN [33], al

obligar al generador a que coincida con el contenido de referencia para que no

pueda hacer trampa al producir ejemplos monótonos. Además, anima al

discriminador a aprender un espacio de características continuas en lugar de

memorizar las muestras reales, evitando así el sobreajuste.

Para un discriminador específicoDk, formulamos su pérdida de coincidencia de

características profundas en el generador de la siguiente manera:

LFM

GRAMO(x, x′;Dk) =

i=1

nortei

||Dk(i)(GRAMO(X))− D(ik) (X′)||1

circunvoluciones agrupadas.

El entrenamiento ocurre en tres etapas. Primero, entrenamos WaveNet de

funciones fijo aprendido del entrenamiento previo en tareas de detección de

∑Tk 1

1024, 1; y tamaños de grupo de 1, 4, 16, 64, 256, 1, 1 para sus

0.001, usando pérdida L1 y pérdida de espectrograma. Esto es para asegurarse

de que la red principal capte la estructura de forma de onda del habla. Luego

entrenamos junto con la postnet y el aumento de datos para 500K pasos, con

una tasa de aprendizaje de 0.0001. Finalmente, entrenamos el generador a una

tasa de aprendizaje de 0,00001 con los cuatro discriminadores inicializados

aleatoriamente a una tasa de aprendizaje de 0,001 para pasos de 50 000,

utilizando pérdidas adversas y pérdidas de coincidencia de características

profundas. Actualizamos los discriminadores dos veces por cada paso del

generador con optimizadores Adam. Se utiliza un tamaño de lote de 6 en una

GPU Tesla V100, con cada entrada de 32000 muestras. Las muestras de audio de

los experimentos están disponibles en el sitio web de nuestro proyecto:

https://pixl.cs.princeton.edu/pubs/Su_2020_HiFi/

3.1. Mejora del habla conjunta

En un experimento conjunto de mejora del habla para la conversión de una grabación

(3)

del mundo real a una grabación limpia con calidad de estudio, nuestro

El conjunto de entrenamiento se construye a través de la simulación de

datos. Utilizamos las grabaciones de voz con calidad de estudio del

dóndeTkes el número de capas enDkexcluyendo la salida

conjunto de datos limpio [36] del dispositivo y el habla producida (DAPS),

capa, ynorteies el número de unidades en eli-ésima capaD(i) k.

las combinamos con las 270 respuestas de impulso del conjunto de datos

una combinación de pérdidas L1 en formas de onda (tanto antes como

ruido extraído del desafío REVERB base de datos [4] y la base de datos ACE

Para concluir, la función de pérdida construida en la red de mejora es

después de la red posterior), pérdidas L2 en espectrogramas de registro

(tanto antes como después de la postnet), pérdidas adversariasLAvanzado GRAMOy

pérdidas de coincidencia de características profundasGRAMO

LFM

de

los cuatro discriminadores.

Básicamente, esto puede verse como una función de pérdida de percepción

de la encuesta de respuesta al impulso del MIT [37] y luego agregamos el

Challenge [38]. En total, los datos incluyen dos géneros.×diez hablantes

por género×diez minutos de guion×270 entornos antes del aumento.

Disponemos de un ponente para cada género, dos minutos de guión y 70

ambientes para evaluación. El conjunto de datos DAPS también

parcialmente aprendida que evalúa varios aspectos de la calidad del habla.

proporciona grabaciones del mismo conjunto de voz con calidad de

2.3. Simulación y aumento de datos

las interacciones de los factores acústicos en el mundo real. Esto nos

El entrenamiento de nuestro modelo se basa en pares paralelos de grabaciones

generaliza a entornos reales invisibles.

ruidosas y grabaciones limpias, que en realidad son costosas de obtener. En su

lugar, creamos datos de entrenamiento para varios entornos a través de la

simulación de datos mediante la convolución de grabaciones con calidad de

estudio con respuestas de impulso de sala medidas y la adición de ruido.

Para generalizar a nuevos hablantes, nuevo contenido de voz y

nuevos entornos, realizamos un gran aumento de datos sobre la marcha

[34]. La amplitud y la velocidad del habla se escalan aleatoriamente para

agregar variación en los hablantes. El ruido extraído de una colección de

muestras se pasa a través de un filtro multibanda aleatorio y se agrega

con una SNR aleatoria entre 10 dB y 30 dB. La cantidad de reverberación

se aumenta ajustando las propiedades DRR y RT60 de las respuestas de

impulso siguiendo el procedimiento propuesto por Bryan [35]. También

aplicamos filtros multibanda aleatorios a las respuestas de impulso para la

distorsión de ecualización.

3. Experimentos

estudio regrabadas en doce ambientes de sala diferentes, capturando así

permite también probar qué tan bien nuestro modelo entrenado se

Realizamos un estudio de ablación agregando un componente a la

vez. Los componentes básicos de nuestro método incluyen: feedforward

WaveNet (Base),uso de la postnet (posnet),uso del discriminador de

espectrograma (SpecGAN),y el uso de los discriminadores de forma de

onda (WaveGAN).También comparamos con seis métodos de última

generación en reducción de ruido y desreverberación: WPE conjunto [7] y

Wiener Filtering [2] (W+W),Pérdida de características profundas para

eliminación de ruido [27] (FL profunda),Atención Wave-U-Net [19] (Wave-UNet),enmascaramiento espectral con LSTM bidireccional [13] (BLSTM),y

MétricaGAN [22].

3.1.1. Evaluaciones objetivas

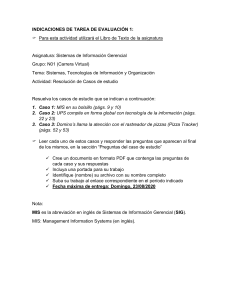

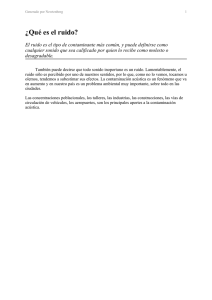

La Tabla 1 informa evaluaciones objetivas tanto en el conjunto de prueba

sintético como en el conjunto de datos DAPS: evaluación perceptual de la

calidad del habla (PESQ), inteligibilidad objetiva a corto plazo (STOI),

relación de energía de modulación del habla a la reverberación (SRMR) y

A través de experimentos, nuestra red generadora de mejor rendimiento

frecuencia ponderada. SNR segmental (FW-SSNR), que son métricas de uso

es una WaveNet de alimentación directa de 20 capas con dos pilas de

común en tareas de eliminación de ruido y de reverberación, por ejemplo,

circunvoluciones dilatadas, cada una con un tamaño de filtro de 3 y tasas

el Desafío REVERB de 2014 [4].

de dilatación de 1 a 512. El tamaño del canal es 128 en toda la red. El

Descubrimos que la red Deep Feature Loss entrenada en nuestro conjunto

discriminador de espectrograma sigue la misma configuración que en

de datos produce peores resultados que el modelo preentrenado,

StarGAN-VC [30]: tamaños de kernel de (3, 9), (3, 8), (3, 8), (3, 6); tamaños

probablemente porque su red de pérdida atiende al ruido ambiental aditivo pero

de zancada de (1, 2), (1, 2), (1, 2), (1, 2); y tamaños de canal de 32 a través

no a las diferencias de reverberación. Por lo tanto, ejecutamos el modelo de

de las capas. La entrada se calcula como el espectrograma log mel de 80

pérdida de características profundas preentrenado para comparar.

coeficientes con mels que van desde 20 Hz a 8000 Hz. Los discriminadores

Nuestro método HiFi-GAN consigue el mejor PESQ de todos en ambos

de forma de onda siguen la misma configuración que en MelGAN [21]:

casos. Sin embargo, el uso del discriminador de forma de onda por sí solo puede

tamaños de kernel de 15, 41, 41, 41, 41, 5, 3; paso

degradar las puntuaciones. Planteamos la hipótesis de que tener

Tabla 1:Medidas objetivas sobre conjuntos de datos sintéticos y DAPS.

Método

PESC

STOI

SRMR

FW-SSNR

Datos sintéticos

4,64 1,00

1,92 0,91

7.82

5.64

35.00

Ruidoso

WPE+Salchicha [7, 2]

2,20 0,90

2.01

2.01

2.12

2.59

0.88

0,94

0.93

0,92

6.81

6.39

7.59

7.01

7.28

4.53

7.02

8.12

9.57

6.23

2.50

2.60

2.69

2.56

2.78

0,95

0,95

0,94

0,95

0,94

7.16

7.48

7.83

7.62

7.47

11.52

11.68

10.24

10.95

10.52

Limpio

Florida profunda [27]

Wave-U-Red [19]

BLSTM [13]

MétricaGAN [22]

Base

+ Postnet

+ Postnet +SpecGAN

+ Postnet +WaveGAN

HiFi-GAN (Todos)

4.63

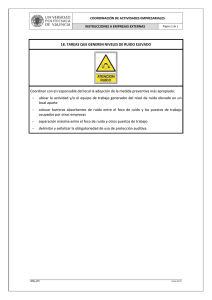

Figura 2:Puntuaciones de MOS (arriba) y porcentaje de preferencia en HiFi-

GAN en un estudio por pares (abajo) en el conjunto de datos DAPS.

recibió 900 calificaciones por voz. Nuestro método es fuertemente

Conjunto de datos DAPS

preferido sobre otras líneas de base (más del 90 % de las veces), y HiFi-

4,64 1,00

1,41 0,87

7.82

4.79

35.00

3.04

GAN muestra una ventaja evidente sobre SpecGAN, que obtiene casi la

7.84

6.96

6.58

6.65

7.38

3.61

5.92

4.70

6.61

4.73

3.2. Tarea de eliminación de ruido

MétricaGAN [22]

1,84 0,87

1,63 0,85

1,47 0,86

1,63 0,88

1,89 0,88

Base

1,76 0,89

6.80

7.22

7.46

7.48

7.67

6.38

7.44

7.44

6.52

7.62

Limpio

Ruidoso

WPE+Salchicha [7, 2]

Florida profunda [27]

Wave-U-Red [19]

BLSTM [13]

+ Postnet

+ Postnet +SpecGAN

+ Postnet +WaveGAN

HiFi-GAN (Todos)

1.93

0.89

2.00

0.89

1,97 0,87

1,86 0,88

misma puntuación en la prueba MOS.

Para demostrar aún más la eficacia de HiFi-GAN, llevamos a cabo un

experimento de referencia de mejora del habla (eliminación de ruido), utilizando

un conjunto de datos estándar [40] que consiste en pares de grabaciones

limpias y ruidosas (28 altavoces para entrenamiento y 2 altavoces para prueba).

Las medidas objetivas de nuestro método en comparación con otros métodos de

última generación se informan en la Tabla 2.

HiFi-GAN supera a todos los demás métodos, y Postnet solo es superado

el discriminador de espectrograma junto con los discriminadores de forma de

onda estabiliza el entrenamiento adversario, lo que conduce a un mejor punto

de convergencia para HiFi-GAN. También observamos que los métodos basados

en formas de onda generalmente no funcionan tan bien como los espectrales

cuando hay reverberación. Esto muestra la importancia de incluir

representaciones de tiempo-frecuencia en el aprendizaje.

No existe una clasificación consistente en las cuatro métricas objetivas, lo

que sugiere que ninguna medida individual captura adecuadamente el sentido

subjetivo de la calidad general, también observado en trabajos anteriores [39].

Por lo tanto, realizamos evaluaciones subjetivas para el juicio humano de las

cualidades perceptivas generales.

por MetricGAN. Esto muestra que nuestro enfoque puede generalizarse a

diferentes conjuntos de datos y tareas de mejora del habla. Tenga en cuenta que

las grabaciones limpias del conjunto de datos VCTK todavía contienen una

pequeña cantidad de ruido de fondo y, por lo tanto, nuestros métodos obtienen

una puntuación más baja en la medida de distorsión de fondo (CBAK).

Tabla 2:Medidas objetivas sobre el VCTK Noisy Dataset

PESC

CSIG

CBAK

COVL

Wave-U-Red [19]

MétricaGAN [22]

1.97

2.22

2.16

2.62

2.86

3.35

3.23

3.48

3.62

3.86

3.91

3.99

2.44

2.68

2.94

3.23

3.33

3.35

3.18

2.63

2.67

2.80

2.98

3.22

3.27

3.42

posnet

HiFi-GAN

2.84

2.94

4.18

4.07

2.55

3.07

3.51

3.49

Método

Ruidoso

salchicha [2]

SEGAN [23]

WaveNet [15]

Florida profunda [27]

3.1.2. Evaluaciones subjetivas

Usamos Amazon Mechanical Turk (AMT) para el estudio auditivo. En una prueba

de puntuación de opinión media (MOS), se le pide a un sujeto que califique la

calidad del sonido de un fragmento de audio en una escala del 1 al 5, con 1 =

Malo, 5=Excelente. Proporcionamos un audio con calidad de estudio como

referencia para alta calidad y el audio de entrada ruidoso como ancla baja. En

4. Discusión y Trabajo Futuro

total, recopilamos alrededor de 1000 HIT válidos por voz, con un total de 14 000

En este documento, presentamos HiFi-GAN, un método de aprendizaje profundo de

calificaciones por voz. Como se muestra en la Figura 2, HiFi-GAN obtiene la

extremo a extremo para mejorar las grabaciones de voz a calidad de estudio. Utiliza un

puntuación más alta y todas nuestras variantes se encuentran entre las mejores.

WaveNet feed-forward junto con entrenamiento contradictorio de múltiples escalas

Si bien MetricGAN parece competitivo en la medición objetiva, nuestros métodos

tanto en el dominio del tiempo como en el dominio del tiempo-frecuencia. Las pérdidas

lo superan significativamente con un valor p<10−4. Dado que las calificaciones de

de coincidencia dinámica de las características profundas de los discriminadores ayudan

MOS son relativamente cercanas para algunos métodos, también realizamos

a lograr mejores cualidades perceptivas. Las evaluaciones muestran que el método

una prueba de preferencia en los pares de métodos seleccionados para revelar

propuesto supera a todas las demás líneas de base de última generación en tareas de

la consistencia de la calidad de nuestro HiFi-GAN de mayor rendimiento frente a

eliminación de ruido y desreverberación.

los competidores. En este estudio, a un sujeto se le presentan dos expresiones

Tenga en cuenta que nuestros experimentos se realizan con una frecuencia

producidas por dos métodos y se le pide que elija cuál suena mejor dada una

de muestreo de 16 kHz, pero la alta fidelidad real debe apuntar a 44 kHz. Esto se

grabación limpia como referencia. Una vez que se recopilan todas las

puede lograr volviendo a entrenar las redes en la frecuencia de muestreo

respuestas, asignamos el método preferido a cada expresión en función de la

deseada, que sin embargo es computacionalmente costosa. Alternativamente,

votación por mayoría para reducir la alta variación en las calificaciones. Cada par

un posible trabajo futuro es conectar una red de extensión de banda [41] para

de métodos

postnet para aumentar la muestra de 16 kHz a 44 kHz.

5. Referencias

[1] Y. Ephraim y D. Malah, "Mejora del habla usando un estimador de

amplitud espectral de tiempo corto de error cuadrático medio

mínimo"Transacciones IEEE sobre acústica, voz y procesamiento de

señales, vol. 32, núm. 6, págs. 1109–1121, 1984.

[2] P. Escarlataet al., “Mejora del habla basada en una estimación a priori

de señal a ruido”, enICASSP 1996, vol. 2. IEEE, págs. 629–632.

[3] PA Naylor y ND Gaubitch,Dereverberación del habla.

Springer Science & Business Media, 2010.

[4] K. Kinoshita, M. Delcroix, T. Yoshioka, T. Nakatani, A. Sehr,

W. Kellermann y R. Maas, "El desafío de la reverberación: un marco de

evaluación común para la desreverberación y el reconocimiento del habla

reverberante", enWASPAA 2013. IEEE, págs. 1–4.

[21] K. Kumar, R. Kumar, T. de Boissiere, L. Gestin, WZ Teoh,

J. Sotelo, A. de Brébisson, Y. Bengio y AC Courville, "Melgan:

Generative adversarial networks for conditional waveform lysis", en

Avances en sistemas de procesamiento de información neuronal,

2019, págs. 14 881–14 892.

[22] SO-O. Fu, C.-F. Liao, Y. Tsao y S.-D. Lin, "Metricgan: Optimización de puntajes

métricos de caja negra basada en redes generativas antagónicas para la

mejora del habla", enConferencia Internacional sobre Aprendizaje

Automático, 2019, págs. 2031–2041.

[23] S. Pascual, A. Bonafonte, and J. Serrà, “Segan: Red adversarial

generativa de mejora del habla,”proc. Interdiscurso 2017, págs.

3642–3646.

[24] H. Phan, IV McLoughlin, L. Pham, OY Chen, P. Koch,

M. De Vos y A. Mertins, "Mejora de gans para mejorar el habla"

preimpresión de arXiv arXiv:2001.05532, 2020.

[5] FG Germain, GJ Mysore y T. Fujioka, "Ecualización de la ecualización de

grabaciones de voz en entornos del mundo real", enICASSP 2016.

IEEE, págs. 609–613.

[25] S. Pascual, J. Serrà y A. Bonafonte, “Hacia la mejora generalizada

del habla con redes generativas antagónicas”,proc.

Interdiscurso 2019, págs. 1791–1795.

[6] C. Donahue, B. Li y R. Prabhavalkar, "Explorando la mejora del habla

con redes antagónicas generativas para un reconocimiento de voz

sólido", enICASSP 2018. IEEE, págs. 5024–5028.

[26] SO-O. Fu, C.-F. Liao y Y. Tsao, "Aprendizaje con función de pérdida

aprendida: mejora del habla con red de calidad para mejorar la evaluación

perceptual de la calidad del habla".Letras de procesamiento de señales

IEEE, 2019.

[7] T. Nakatani, T. Yoshioka, K. Kinoshita, M. Miyoshi y B.-H. Juang,

"Desreverberación del habla basada en la predicción lineal retardada

normalizada por varianza"Transacciones IEEE sobre procesamiento de

audio, voz y lenguaje, vol. 18, núm. 7, págs. 1717–1731, 2010.

[8] Z. Duan, GJ Mysore y P. Smaragdis, "Mejora del habla mediante

descomposición de espectrograma no negativo en línea en entornos

de ruido no estacionario", enDecimotercera Conferencia Anual de la

Asociación Internacional de Comunicación del Habla, 2012.

[9] H. Kagami, H. Kameoka y M. Yukawa, "Separación conjunta y

desreverberación de mezclas reverberantes con factorización de

matriz no negativa multicanal determinada", enICASSP 2018. IEEE,

págs. 31–35.

[10] K. Han, Y. Wang, D. Wang, WS Woods, I. Merks y T. Zhang, "Aprendizaje de

mapeo espectral para la desreverberación y eliminación de ruido del

habla"IEEE/ACM TASLP, vol. 23, núm. 6, págs. 982–992, 2015.

[11] Y. Xu, J. Du, L.-R. Dai y C.-H. Lee, "Un enfoque de regresión para

mejorar el habla basado en redes neuronales profundas"IEEE/ACM

TASLP, vol. 23, núm. 1, págs. 7 a 19, 2015.

[12] DS Williamson y D. Wang, “Speech dereverberation and

denoising using complex ratio masks”, enICASSP 2017. IEEE,

págs. 5590–5594.

[13] W. Mack, S. Chakrabarty, F.-R. Stöter, S. Braun, B. Edler y

E. Habets, "Desreverberación de un solo canal mediante

optimización mmse directa y redes lstm bidireccionales",proc.

Interdiscurso 2018, págs. 1314–1318.

[14] A. Van Den Oord, S. Dieleman, H. Zen, K. Simonyan, O. Vinyals,

A. Graves, N. Kalchbrenner, AW Senior y K. Kavukcuoglu, "Wavenet:

un modelo generativo para audio sin procesar". enSSO, 2016, pág.

125.

[27] FG Germain, Q. Chen y V. Koltun, "Speech denoising with deep

feature loss"proc. Interdiscurso 2019, págs. 2723–2727.

[28] K. Qian, Y. Zhang, S. Chang, X. Yang, D. Florêncio y

M. Hasegawa-Johnson, "Mejora del habla mediante la red de ondas

bayesiana". enInterdiscurso 2017, págs. 2013–2017.

[29] J. Shen, R. Pang, RJ Weiss, M. Schuster, N. Jaitly, Z. Yang,

Z. Chen, Y. Zhang, Y. Wang, R. Skerrv-Ryanet al., "Síntesis natural de

tts al condicionar la red de ondas en las predicciones del

espectrograma mel", enICASSP 2018. IEEE, págs. 4779–4783.

[30] H. Kameoka, T. Kaneko, K. Tanaka y N. Hojo, "Stargan-vc: conversión de voz

de muchos a muchos no paralelos con redes antagónicas generativas de

estrellas"preimpresión de arXiv arXiv:1806.02169, 2018.

[31] JH Lim y JC Ye, “ganancia geométrica”,preimpresión de arXiv

arXiv:1705.02894, 2017.

[32] LA Gatys, AS Ecker y M. Bethge, “Un algoritmo neural del estilo

artístico”,preimpresión de arXiv arXiv:1508.06576, 2015.

[33] I. Goodfellow, “Tutorial de Nips 2016: Redes antagónicas generativas”

preimpresión de arXiv arXiv:1701.00160, 2016.

[34] J. Su, Z. Jin y A. Finkelstein, "Coincidencia acústica mediante la incorporación

de respuestas de impulso", enICASSP 2020. IEEE, págs. 426–430.

[35] NJ Bryan, "Aumento de datos y redes neuronales convolucionales profundas

para la estimación de parámetros acústicos de salas ciegas"preimpresión

de arXiv arXiv:1909.03642, 2019.

[36] GJ Mysore, “¿Podemos transformar automáticamente la voz grabada en

dispositivos de consumo comunes en entornos del mundo real en voz de

calidad de producción profesional? Un conjunto de datos, conocimientos y

desafíos”,Letras de procesamiento de señales IEEE, vol. 22, núm. 8, págs.

1006–1010, 2015.

[15] D. Rethage, J. Pons y X. Serra, “A wavenet for speech denoising”,

enICASSP 2018. IEEE, págs. 5069–5073.

[37] J. Traer y JH McDermott, "Las estadísticas de la reverberación natural

permiten la separación perceptiva del sonido y el espacio".procedimientos

de la Academia Nacional de Ciencias, vol. 113, núm. 48, págs. E7856–

E7865, 2016.

[16] J. Su, A. Finkelstein y Z. Jin, "Mejora del habla específica del

entorno motivada por la percepción", enICASSP 2019, págs.

7015–7019.

[38] J. Eaton, ND Gabitch, AH Moore y PA Naylor, "Estimación de los

parámetros acústicos de la sala: el desafío del as"IEEE/ACM TASLP,

vol. 24, núm. 10, págs. 1681–1693, 2016.

[17] D. Stoller, S. Ewert y S. Dixon, "Wave-u-net: una red neuronal multiescala

para la separación de fuentes de audio de extremo a extremo"

preimpresión de arXiv arXiv:1806.03185, 2018.

[18] C. Macartney y T. Weyde, "Mejora del habla mejorada con waveu-net"preimpresión de arXiv arXiv:1811.11307, 2018.

[19] R. Giri, U. Isik y A. Krishnaswamy, "Atención wave-u-net para

mejorar el habla", enWASPAA 2019. IEEE, págs. 249–253.

[20] M. Binkowski, J. Donahue, S. Dieleman, A. Clark, E. Elsen,

N. Casagrande, LC Cobo y K. Simonyan, "Síntesis de voz de alta

fidelidad con redes antagónicas"preimpresión de arXiv

arXiv:1909.11646, 2019.

[39] K. Kinoshita, M. Delcroix, S. Gannot, EA Habets, R. HaebUmbach, W. Kellermann, V. Leutnant, R. Maas, T. Nakatani,

B.Rajet al., "Un resumen del desafío de la reverberación: desafíos actuales

y restantes en la investigación del procesamiento del habla reverberante".

Revista EURASIP sobre avances en procesamiento de señales, vol. 2016,

núm. 1, pág. 7, 2016.

[40] C. Valentini-Botinhao, X. Wang, S. Takaki y J. Yamagishi, "Investigación

de métodos de mejora del habla basados en rnn para texto a voz

resistente al ruido". enSSO, 2016, págs. 146–152.

[41] B. Feng, Z. Jin, J. Su y A. Finkelstein, "Aprendizaje de la expansión del ancho de

banda mediante la pérdida motivada por la percepción", enICASSP 2019. IEEE,

págs. 606–610.