Proceso distribuido, en informática, método de procesamiento de la

Anuncio

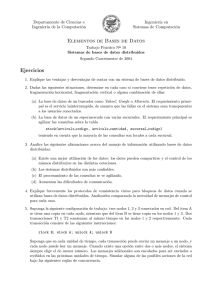

PROCESAMIENTO DISTRIBUIDO Distintas máquinas pueden estar conectadas en una red de comunicación tal que una sola tarea de procesamiento de datos puede ocupar muchas máquinas en la red. En general, cada servidor puede servir a muchos clientes, y cada cliente puede accesar muchos servidor. Un sistema de base de datos distribuido es cuando un cliente puede accesar muchos servidores simultáneamente. Es decir, que una sola petición a "la base de datos" puede combinar datos de varios servidores. OTRA DEFINICION: Método de procesamiento de la información en el que varios procesos(programas en ejecución) en paralelo, en paralelo, en la misma máquina o distribuidos entre ordenadores o computadoras interconectados a través de una red de comunicaciones, colaboran en la realización de una tarea. Esta colaboración pude ser tan sencilla como distribuir la carga de trabajo entre procesos idénticos, en el caso por ejemplo de una red de cajeros automáticos, o tan complejo como multitud de procesos distintos. APLICACIONES: Los ambientes en los que se encuentra con mayor frecuencia el uso de las bases de datos distribuidas son: Cualquier organización que tiene una estructura descentralizada. Casos típicos de lo anterior son: organismos gubernamentales y/o de servicio público. La industria de la manufactura, particularmente, aquella con plantas múltiples. Por ejemplo, la industria automotriz. Aplicaciones de control y comando militar. Líneas de transportación aérea. Cadenas hoteleras. Servicios bancarios y financieros. EJEMPLO: en una compañía, la realización de tareas que requieran altas capacidades de proceso, para lo cual se utilizarán los PCs conectados a la intranet de esta empresa. Sin embargo, si queremos afrontar un proyecto de ámbito universal y con un elevado grado de complejidad habremos de ser capaces de abordarlo mediante análisis diferenciales que puedan ser realizados de forma separada, en paralelo mediante diferentes máquinas presentes en nuestro ambicioso terreno de juego: Internet. A continuación presentaremos dos de estos proyectos. El proyecto SETI @ Home desarrollado por la Universidad de California en Berkeley comienza en Mayo de 1999. Más de 2 millones de voluntarios lo convierten en la experiencia más grande de procesamiento distribuido hasta la fecha. SETI (the Search for Extra-Terrestrial Inteligente) es un nombre colectivo para designar los diferentes programas encargados de buscar evidencias de vida en el cosmos. Para ello se utiliza como fuente los datos recogidos por radiotelescopios, que como si de grandes pabellones auditivos se tratase, se encargan de escudriñar el cielo en busca de señales de radio provenientes del espacio. Como se comprenderá, la capacidad de computación necesaria para analizar todos los datos que se recogen es desmesurada. Pero, ahí es precisamente donde nace SETI@Home como proyecto de aplicación de computación distribuida de la Universidad de Berkeley. Los datos de partida en este caso son los recogidos por el telescopio de Arecibo en Puerto Rico, el mas grande del mundo. De una forma similar a SETI@Home surge una nueva iniciativa conjunta de las empresas Intel y United Devices centrada esta vez en la investigación del cáncer. En este caso se pone el procesamiento distribuido de Internet al servicio de la investigación molecular realizada en el departamento de Química de la Universidad de Oxford en Inglaterra y la Fundación Nacional para la Investigación del Cáncer en los EE.UU. El objetivo de estos centros es la búsqueda de drogas que actúen contra el cáncer y la leucemia. Para ello es necesario realizar complejos análisis de compatibilidad molecular sobre moléculas, susceptibles de convertirse en un tratamiento efectivo para lo que se precisa de una alta potencia de proceso. FUTURO DEL PROCESAMIENTO DISTRIBUIDO Aunque la idea de distribución de datos es bastante atractiva, su realización conlleva la superación de una serie de dificultades tecnológicas entre las que se pueden mencionar: Asegurar que el acceso entre diferentes sitios o nodos y el procesamiento de datos se realice de manera eficiente, presumiblemente óptima. Transformar datos e integrar diferentes tipos de procesamiento entre nodos de un ambiente distribuido. Distribuir datos en los nodos del ambiente distribuido de una manera óptima. Controlar el acceso a los datos disponibles en el ambiente distribuido. Soportar la recuperación de errores de diferentes módulos del sistema de manera segura y eficiente. Asegurar que los sistemas locales y globales permanezcan como una imagen fiel del mundo real evitando la interferencia destructiva que pueden ocasionar diferentes transacciones en el sistema. Así también, la aplicación de técnicas de distribución de información requiere de superar algunas dificultades de índole organizacional y algunas otras relacionadas con los usuarios. Entre ellas se puede mencionar: El desarrollo de modelos para estimar la capacidad y el tráfico esperado en el sistema distribuido. Soportar el diseño de sistemas de información distribuidos. Por ejemplo, ayudar a decidir donde localizar algún dato particular o donde es mejor ejecutar un programa de aplicación. Considerar la competencia que habrá por el uso de los recursos entre nodos diferentes. Aun cuando las dificultades mencionadas son importantes, las ventajas de la distribución de información han promovido su aplicación en ambientes del presente y del futuro. ALUMNO: RUBEN ALEJANDRO LUGO LÓPEZ TELEPROCESO 1D BIBLIOGRAFIA: http://www.lania.mx/biblioteca/seminarios/basedatos/arq2.html http://html.rincondelvago.com/bases-de-datos-distribuidas.html http://www.cs.cinvestav.mx/SC/prof_personal/adiaz/Disdb/Cap_1.html http://www.coit.es/publicac/publbit/bit131/internet.htm Encarta