Introducción a las técnicas de análisis multivariante I.

Anuncio

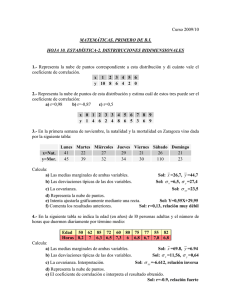

Jacobo Trébol EPI.CLIN. 15: ANÁLISIS MULTIVARIANTE I Dr. Carrasco INTRODUCCIÓN Hasta ahora hemos estudiado los métodos estadísticos convencionales; éstos analizan exhaustivamente el comportamiento de una variable en las muestras y en la población (estimación y comparación) y las leyes que pueden ligar dos variables entre sí (relación). Conocemos, por tanto, la estadística univariante y la estadística bivariante. Pero en la vida una cosa no suele depender sólo de otra. El gran número de variables habitualmente observadas en una colección de individuos, y la realidad multidimensional de la vida en que todas configuran con sus relaciones el fenómeno que se investiga, obliga a encarar la inevitable complejidad matemática e intenta un tratamiento conjunto de ellas. Éste es el objetivo de la estadística multivariante. El Análisis Multivariante engloba los métodos y técnicas estadísticas que permiten estudiar y tratar, en bloque, un conjunto de variables medidas u observadas en una colección de individuos. COEFICIENTE DE CORRELACIÓN-ECUACIÓN DE REGRESIÓN Pongamos por caso que queremos conocer la posible relación entre dos variables cuantitativas [temperatura (t) y frecuencia cardiaca (FC), por ejemplo]. Nos hacemos varias preguntas: 1. ¿Hay relación? La posible correlación se calcula a través de un coeficiente de correlación, que para las variables cuantitativas es el coeficiente de correlación de Pearson (r) 2. ¿ Es significativo? Una vez conocido r lo siguiente es conocer si ese coeficiente es estadísticamente significativo. En caso contrario no podemos usarlo para calcular ninguna ecuación de regresión que expresase la relación entre las dos variables. 3. ¿ Es estilizada la nube de puntos? La significación estadística del coeficiente de correlación es necesaria pero no suficiente en sí misma para poder calcular la ecuación de regresión; dicha ecuación es un modelo teórico de estimación de la tendencia de dispersión de los valores de nuestra muestra, de modo que aunque nuestros valores mostrasen una relación claramente ascendente, pueden estar muy dispersos y aplicando una ecuación de regresión (que representa una línea en el espacio) para representarlos cometeríamos mucho error. Por ello es muy importante tener en cuenta el grado de estilización de la nube de dispersión que representa los valores de esas variables en mi muestra. El que la nube de puntos sea estilizada o no es una condición “estética”, experimental, que decidiremos en 1 función de lo que nos juguemos (no es lo mismo jugarse la vida de un paciente que la de varias ratas de laboratorio). r=1 r=0 r=0,8 r=- 0,5 Coeficientes de correlación En cuanto a la r: Desconfiad de los r=1. Un valor de tan alta correlación indica que se trata en realidad de valores exactamente iguales, esto es, que se trata de la misma variable, ya que sólo ella se correlacionaría tanto consigo misma. En la práctica, que se den r=0,9 es muy raro. La mayoría de las veces los coeficientes de correlación tienen valores de 0,7 ó 0,8. Éstos son considerados indicadores de una buena correlación. Valores de r=0,6 indican menos correlación, pero aún válida. Si son menores de 0,5 no son aceptables (por mucha significación estadística que presenten). En resumen, las condiciones para poder calcular una ecuación de regresión serían: 1. Un coeficiente de correlación de Pearson aceptable (lo suficientemente alto) y estadísticamente significativo. 2. Estilización adecuada de la nube de dispersión de nuestros datos, según lo que se pretenda demostrar. Variables A y B Cálculo estadístico Coeficiente de correlación Condición estadística ¿Significativo? NO 2 SÍ Condición clínica ¿Suficientemente alto? SÍ Ley experimental Imposibilidad de aplicación NO No ecuación de regresión Según lo que te “juegues” Ecuación de Regresión Condiciones de aplicación de la Ecuación de Regresión Ajuste por mínimos cuadrados El procedimiento matemático empleado para la sustitución de una nube de puntos por una recta es el ajuste por mínimos cuadrados. Busca describir la recta que mejor define la nube de dispersión de los valores de las variables, es decir, aquella que haga los mínimos errores (que serán la suma de los desajustes de todos los puntos de la nube, definidos por la distancia que exista desde cada uno de ellos hasta la recta). Sin embargo, las diferencias con respecto a la recta de los puntos que quedan por encima de ella serán positivas, mientras que las que queden por debajo serán negativas; de este modo cabría la posibilidad de que al sumarlas todas nos diese un error equivocadamente nulo (ajuste falsamente perfecto). Por ello, el método se llama de mínimos cuadrados porque eleva esas diferencias con la recta al cuadrado, eliminando así la influencia “positiva” o “negativa”. Ecuación de la recta-Ecuación de regresión La ecuación general de la ecuación de regresión viene definida por la fórmula: y- y = r x (y/x) x (x – x) donde sólo nos hace falta conocer las medias de los valores de x e y (x, y), sus desviaciones típicas (x,y) y el coeficiente de correlación entre las variables (r) para conocer la ecuación de la recta. Siempre hay que tener en cuenta que el alcance de una Ecuación de Regresión viene marcado por nuestra muestra; cuanta mayor sea la experiencia, más perfecta será la ecuación. Por eso las Ecuaciones de Regresión que se publican no son siempre definitivas, sino que una correcta práctica consiste en irlas perfeccionando a medida que nuestra experiencia aumente. Una vez definida la recta, despejamos una de las variables en relación a la otra [por ejemplo hallar el pulso de mis pacientes (y) a partir de su temperatura (x)] y = 7 + 1,5x 3 Esa ecuación sólo sirve para ser utilizada en ese sentido; NO sirve para despejar igualmente x a partir de y (temperatura a partir de pulso) porque lo que hemos elevado al cuadrado para ajustar las mínimas diferencias eran los errores “en vertical” de la recta, es decir, los errores de y, no de x. Para calcular x a partir de y deberíamos utilizar los errores “horizontales” de cada punto con respecto a la recta. Ello significa que cada nube de dispersión de valores presenta dos ecuaciones de regresión lineal. La que despeja x de y sería: (x – x) = r x (x/y) x ( y –y) El problema con respecto a la regresión lineal enunciada hasta ahora es que prácticamente NO existen variables en la naturaleza que mantengan relaciones lineales (“No existen fenómenos biológicos rectilíneos en su distribución”). Es mucho más frecuente que se relacionen ajustándose a modelos logísticos (sigmoideos), exponenciales, logarítmicos, etc. Antes el modelo de regresión lineal solía utilizarse cuando las otras vías eran asumibles a una lineal pero más complejas, con el fin de simplificar cálculos. Hoy en día, los programas informáticos han hecho desaparecer esta posibilidad (la diferencia entre calcular una y otra es apretar uno u otro botón). La metodología para calcular en estos casos la ecuación de regresión es la misma, pero la formula aplicable de la misma será distinta de y = a +bx Ejemplo real: Se estudiaron 13000 RNV sin ninguna patología para intentar hallar una relación entre alguno de los parámetros fetales y las semanas de gestación. Una de las variables que presentaba mayor correlación era el perímetro craneal. Aplicando una ecuación de regresión lineal se obtenía una r=0,94. Pero la relación lineal entre estas dos variables es “poco biológica” (supondría un crecimiento sin freno de la cabeza, y ésta decae en su crecimiento en las últimas semanas de gestación). Empleando un modelo parabólico, obtuvieron una r=0,99, es decir, mayor correlación y mayor “calidad biológica” de ésta. SALTO AL ANÁLISIS MULTIVARIANTE Pocos fenómenos biológicos dependen de una única variable. El r expresa la correlación de una variable sólo con otra. Por ello es frecuente encontrar en la investigación coeficientes de correlación bajos, porque al tener en cuenta la relación de un fenómeno con sólo uno de todos aquellos de los que depende, la correlación que se refleja es “parcial”. De ahí que la estadística avanzada tienda al análisis “multivariante”, que tiene en cuenta varias variables a la vez en la regresión y obtiene resultados hiperdimensionales. La regresión lineal se convierte, así, en Regresión Lineal Múltiple. La importancia del análisis multivariante es aumentar el ajuste al potenciarlo con varias variables (este “efecto sinérgico” es la clave de la investigación multivariante). Es decir, lo que pretende es buscar ecuaciones que liguen la variable que quieres estudiar (por ejemplo, la fracción de eyección del ventrículo izquierdo, FEVI) con todas aquellas variables que influyan en ella. Si, siguiendo con el ejemplo de la FEVI, haciendo Regresión lineal Simple sabes 4 que el coeficiente de correlación entre la pendiente del ECG y la FEVI es r=0,56 y el del diámetro del ápex con la FEVI es r=0,52, si consideramos ambas variables (diámetro del ápex y ECG) para conocer la FEVI obtenemos una r=0,7, evitándonos, por ejemplo, la realización de un cateterismo cardíaco para la medición de la FEVI. 5