Document

Anuncio

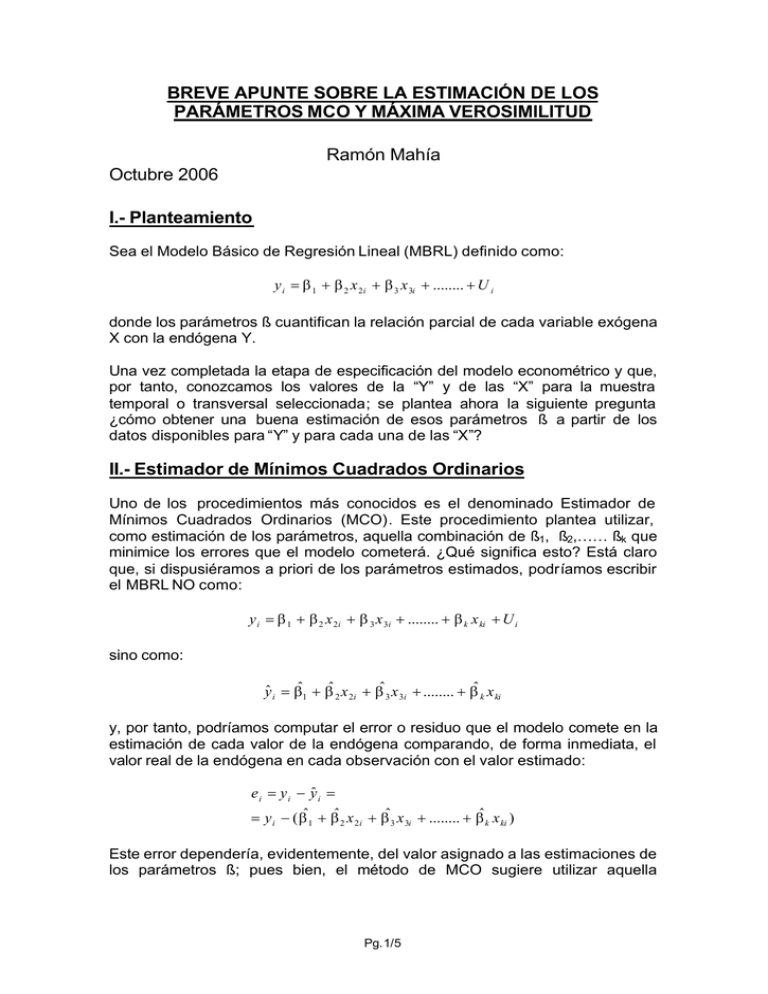

BREVE APUNTE SOBRE LA ESTIMACIÓN DE LOS PARÁMETROS MCO Y MÁXIMA VEROSIMILITUD Ramón Mahía Octubre 2006 I.- Planteamiento Sea el Modelo Básico de Regresión Lineal (MBRL) definido como: y i = β 1 + β 2 x 2i + β 3 x 3i + ........ + U i donde los parámetros ß cuantifican la relación parcial de cada variable exógena X con la endógena Y. Una vez completada la etapa de especificación del modelo econométrico y que, por tanto, conozcamos los valores de la “Y” y de las “X” para la muestra temporal o transversal seleccionada; se plantea ahora la siguiente pregunta ¿cómo obtener una buena estimación de esos parámetros ß a partir de los datos disponibles para “Y” y para cada una de las “X”? II.- Estimador de Mínimos Cuadrados Ordinarios Uno de los procedimientos más conocidos es el denominado Estimador de Mínimos Cuadrados Ordinarios (MCO). Este procedimiento plantea utilizar, como estimación de los parámetros, aquella combinación de ß1, ß2,…… ßk que minimice los errores que el modelo cometerá. ¿Qué significa esto? Está claro que, si dispusiéramos a priori de los parámetros estimados, podríamos escribir el MBRL NO como: y i = β 1 + β 2 x 2i + β 3 x 3i + ........ + β k x ki + U i sino como: yˆ i = βˆ1 + βˆ 2 x 2i + βˆ 3 x 3i + ........ + βˆ k x ki y, por tanto, podríamos computar el error o residuo que el modelo comete en la estimación de cada valor de la endógena comparando, de forma inmediata, el valor real de la endógena en cada observación con el valor estimado: e i = y i − yˆ i = = y i − ( βˆ1 + βˆ 2 x 2i + βˆ3 x 3i + ........ + βˆ k x ki ) Este error dependería, evidentemente, del valor asignado a las estimaciones de los parámetros ß; pues bien, el método de MCO sugiere utilizar aquella Pg.1/5 combinación de parámetros estimados que minimice la suma al cuadrado de todos los errores cometidos para las “n” observaciones disponibles: n β̂ MCO → min( S ) = min ∑ (e i ) 2 i =1 Para obtener algebraicamente una expresión de cálculo operativa para los estimadores MCO, procedemos de la siguiente forma: • La expresión a minimizar es: n n i =1 i =1 ( 2 ( S ) = ∑ (e i ) = ∑ y i − βˆ1 − βˆ 2 x 2i − βˆ 3 x 3i − ........ − βˆ k x ki • ) 2 Para obtener los valores de cada uno de los “k” parámetros β̂ j que minimizan esta expresión derivamos con respecto a cada uno de ellos e igualamos a cero, obteniendo “k” expresiones del tipo: ( ) n ∂( S ) = 2∑ y i − βˆ1 − βˆ 2 x2 i − βˆ3 x 3i − ........ − βˆ k x ki ⋅ (− x ji ) = 0 ∂βˆ i =1 j • Estas expresiones, se denominan “ecuaciones normales”. En este sistema formado por las ecuaciones normales las incógnitas son los parámetros β̂ j a estimar y los valores conocidos son los datos muestrales recogidos de la “y” y de las “x”. • Observadas una a una, para cada parámetro, las expresiones de las ecuaciones normales son: n n n n n i =1 i =1 i =1 i =1 i =1 n n n n n i =1 n i =1 n i =1 n i =1 n ∑ y i x1i = βˆ1 ∑ x1i x1i + βˆ2 ∑ x 2i x1i + βˆ3 ∑ x3i x1i + ........ + βˆ k ∑ x ki x1i ∑ y i x2 i = βˆ1 ∑ x1i x 2i + βˆ2 ∑ x 2i x 2i + βˆ3 ∑ x 3i x2i + ........ + βˆk ∑ x ki x 2i i =1 n ∑yx i i =1 3i = βˆ1 ∑ x1i x3i + βˆ 2 ∑ x 2i x3i + βˆ 3 ∑ x 3i x 3i + ........ + βˆ k ∑ x ki x3i i =1 i =1 i =1 i =1 n ∑ + ........ + ........ + ........ + ........ + .......... + ....... i =1 n n n n n i =1 i =1 i =1 i =1 i =1 ∑ y i x ki = βˆ1 ∑ x1i x ki + βˆ 2 ∑ x 2i x ki + βˆ3 ∑ x 3i x ki + ........ + βˆk ∑ x ki x ki Pg.2/5 • Lo que, teniendo en cuenta las expresiones matriciales del vector endógeno “Y” y la matriz de exógenas “X”, puede resumirse matricialmente como: X ' Y = X ' Xβ̂ • De donde se obtiene fácilmente la expresión final matricial1 del vector de parámetros estimados β̂ : X ' Y = X ' Xβˆ ( X ' X ) −1 X ' Y = ( X ' X ) −1 X ' Xβˆ −1 βˆ = ( X ' X ) X ' Y III.- Estimador Máximo Verosímil Una segunda aproximación consiste en utilizar lo que se conoce como planteamiento de estimación máximo verosímil. Esta planteamiento propone utilizar como estimadores de los parámetros aquel conjunto de parámetros ß 1 Puede comprobarse como podríamos haber planteado la estimación desde el principio utilizando álgebra matricial. Efectivamente, la minimización de residuos puede plantearse a partir del vector de residuos “e” como: (( )( )) ( min( e' e) = min ((Y − Xβˆ )( ' Y − Xβˆ )) = min (Y ' Y − Y ' Xβˆ − βˆ ' X ' Y + βˆ ' X ' Xβˆ ) = min (Y ' Y − 2 βˆ ' X ' Y + βˆ ' X ' Xβˆ ) min( e' e) = min Y − Xβˆ ' Y − Xβˆ = min Y 'Y − Y ' Xβˆ − βˆ ' X ' Y + βˆ ' X ' Xβˆ Obsérvese cómo los productos ) Y ' Xβˆ Y β̂ ' X ' Y son en realidad el mismo e iguales a un escalar, por lo que podemos escribir: ( min( e' e) = min Y ' Y − 2βˆ ' X ' Y + βˆ ' X ' Xβˆ ) y teniendo ahora en cuenta que, para cualquier par de matrices X y A se cumple que: ∂( X ' AX ) = 2 AX = 2 X ' A ∂X tenemos: min( e' e) = ( ) ∂ (e ' e) ∂ Y ' Y − 2βˆ ' X ' Y + βˆ ' X ' Xβˆ =0→ = 0 → 0 − 2 X ' Y + 2 X ' Xβˆ = 0 ˆ ˆ ∂β ∂β de donde nuevamente obtenemos: −1 βˆ = ( X ' X ) X ' Y Pg.3/5 que hace más probable observar una determinada muestra de errores, es decir, un conjunto de errores que van a distribuirse conforme a una determinada función de densidad conjunta con una determinada media y desviación típica. Entre las hipótesis básicas formuladas para el MBRL establecimos que nuestros errores “U” seguirían una distribución normal con media nula y varianza constante, es decir: ( u i → N o,σ 2 ) o bien para todo el vector de perturbaciones aleatorias: ( U → N o,σ 2 I ) Así pues, la función de densidad de cada uno de los errores será: f (u i ) = 1 σ2 1 1 u i2 exp − 2 2 2π σ Por lo que, tomando la función de densidad conjunta para cualquier normal multivariante tenemos que 2: n u i2 ∑ n L = f ( u) = Π f (u i ) = ( 2π ) − n / 2 σ − n / 2 exp − 1 2 i =1 2 i =1 σ Se trata, por tanto, de obtener el conjunto de parámetros β̂ que hacen máxima la función (probabilidad) de densidad conjunta: 2 En realidad, la expresión genérica correcta para esta función es: n L = f ( u) = Π f (u i ) = ( 2π ) − n / 2 | Σ | −n / 2 i =1 n u i2 ∑ exp − 1 2 i=1 2 σ donde S es la matriz de varianzas y covarianzas de las variables aleatorias normales multivariantes. No obstante, y a pesar de la pérdida de precisión de la notación, se mantiene la 2 referencia a s por sencillez expositiva y porque, evidentemente, no afecta al resultado final que se pretende ilustrar. Pg.4/5 n u i2 ∑ n −n / 2 −n / 2 max( L) = max f (u ) = Π f (u i ) = ( 2π ) σ exp − 1 i=1 2 2 σ i =1 Con el fin de computar la derivada parcial de esa expresión “L” con respecto a los parámetros estimados, linealizamos la expresión obteniendo: Ln( L ) = − n ln (2π ) − n ln σ 2 − 1 2 U ' U 2 2 2σ o lo que es igual, considerando ahora errores muestrales y no las perturbaciones aleatorias poblacionales: Ln( L ) = − n ln (2π ) − n ln σ 2 − 1 2 e ' e 2 2 2σ 2 − n n 1 Ln( L ) = ln (2π ) − ln σ − y − Xβˆ ' y − Xβˆ 2 2 2σ 2 ( )( ) Es evidente que maximizar esta probabilidad con respecto a β̂ implica minimizar el último de los sumandos, ya que todos están restando. En definitiva : [( )( max [Ln( L )] → min y − Xβˆ ' y − Xβˆ )] Que como se ve, es lo mismo que plantear el estimador de Mínimos Cuadrados Ordinarios revisado anteriormente. Es decir, el estimador Máximo Verosímil va a coincidir para el Modelo Básico de Regresión Lineal con el estimador de Mínimos Cuadrados Ordinarios. Pg.5/5