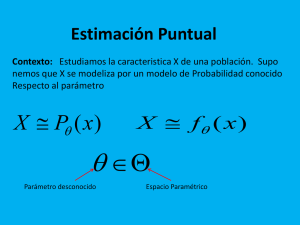

ESTIMACIÓN TEMA 5: Estimación puntual I. Propiedades de los

Anuncio

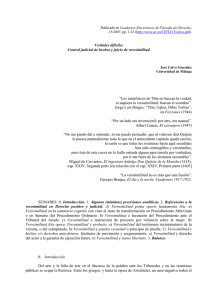

ESTIMACIÓN TEMA 5: Estimación puntual I. Propiedades de los estimadores TEMA 6: Estimación puntual II. Métodos de estimación puntual TEMA 7: Estimación por intervalos CONTRASTES DE HIPÓTESIS TEMA 8: Contrastes paramétricos TEMA 9: Contrastes no paramétricos 1 TEMA 6: ESTIMACIÓN PUNTUAL II. MÉTODOS DE ESTIMACIÓN 6.1. Estimación por el método de los momentos 6.2. Estimación máximo-verosímil 2 1. ESTIMACIÓN POR EL MÉTODO DE LOS MOMENTOS Modelo: X→F(x;ϑ) Muestra: (X1 ,…, Xn) Momentos poblacionales (función de los parámetros) Momentos muestrales (función de la muestra) 1 αk=E(X ) i =1 Un único parámetro: • Si θ=αk • Si θ=g(αk) Varios parámetros: n ak= n ∑ X ik k ˆ k = ak θˆ = α θˆ = g(αˆ k ) = g(ak) θ1=g1(α1,α2) θ̂1 =g1(a1,a2) θ2=g2(α1,α2) θ̂2 =g2(a1,a2) Ejemplos: X→b(p) ⇒ E(X)=p; X→ε(θ) ⇒ E(X)=1/θ; X→N(μ,σ) 3 Propiedades: En general, son consistentes: 1 n Ley débil de los grandes números: a k = ∑ X ik n i =1 Sea gi función continua: Slutsky ⇒ c.p. ⎯⎯ ⎯→ E ( X k ) = α i k c.p. ϑ̂i =gi(a1,...,ak) ⎯ ⎯⎯→ θi=gi(α1,...,αk) En particular, si el parámetro a estimar es un momento poblacional: 1 n n ¾ Insesgados: E( α̂ k )=E(ak)=E( n ∑ X ik )= n ∑ E ( X ik ) =αk 1 i =1 i =1 ¾ Asintóticamente normales 1 n Teorema Central del Límite ⇒ α̂ k = n ∑ X ik i =1 ~ n →∞ Normal 4 2. ESTIMACIÓN MÁXIMO VEROSÍMIL Modelo poblacional X →b(p) X= ⎧1 ⎪ ⎨ ⎪⎩ 0 Roja → p Negra → 1 - p Posible composición de la urna Parámetro p=p(R) p=1 p= 3 Realización concreta de una muestra de tamaño n=4 (x1, x2, x3, x4) = (........,........,........,........) Probabilidad de la muestra concreta )=p( )p( )p( )p( )=(1-p) p p(X1= ,X2= ,X3= ,X4= )=p( p(X1= ,X2= ,X3= p= 1 4 p=0 ,X4= )= p(X1= ,X2= ,X3= ⎛ ⎞ ⎛ ⎞ ,X4= )= ⎜⎜ 1 ⎟⎟ ⎜⎜ 3 ⎟⎟ = p(X1= ,X2= ,X3= ⎛ ⎞ ,X4= )= ⎜⎜ 2 ⎟⎟ ⎝ 4⎠ ⎝ 4⎠ 4 p= 2 4 p(X1= ,X2= ,X3= . ⎛ 2⎞ ⎜ ⎟ ⎜ ⎟ 4 ⎝ ⎠ ⎝ 4⎠ ⎛ ⎞ ,X4= )= ⎜⎜ 3 ⎟⎟ p(X1= ,X2= ,X3= ⎛1⎞ ⎜ ⎟ ⎜ ⎟ 4 ⎝ ⎠ ⎝ 4⎠ = = ,X4= )= 5 Función de verosimilitud: ⎧ p(X1 = x1,...,Xn = xn ; θ) = p(X1 = x1; θ)...p( Xn = xn ; θ) discreto L(θ)=L(θ;x1,…,xn)= ⎨ ⎩f ( x1,..., xn ; θ) = f ( x1; θ)...f ( xn ; θ) continuo ¡ IMPORTANTE !: la muestra concreta (x1,...,xn) es conocida, el parámetro θ es lo desconocido ⇒ L(θ) depende de θ; la muestra fija. Ejemplo: (X1,...,Xn) muestra aleatoria simple de una v.a. Bernoulli b(p) L(p)=p(X=x1,…,X=xn; p)= p(X=x1)… p(X=xn)= p ∑ xi (1 − p)n − ∑ xi Problema: max imizar L (θ) θ Solución ⇒ El estimador máximo verosímil: ϑ̂MV ¡ es una v.a.! ⇒ La estimación máximo verosímil de θ = valor concreto del E.M.V. para una muestra concreta (x1,…,xn) ⇒ ϑ̂ (x1,…,xn) ¡ es un nº !. 6 0.10 Función de verosimilitud 0.06 0.08 L(p)=(1- p)p3 0.0 0.02 0.04 L(p)= (1-p)2p2 0.0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1.0 7 0.0 0.2 0.4 L(p) 0.6 0.8 1.0 FUNCION DE VEROSIMILITUD DISTRIBUCION BERNOULLI (n=4) 0.0 0.2 0.4 0.6 0.8 1.0 p 8 PROCEDIMIENTOS PARA OBTENER EL E.M.V. 1º MÉTODO: Hay condiciones de regularidad: (a) El conjunto de valores que puede tomar la v.a. X no depende de θ (b) L(θ) tiene primeras derivadas continuas; maximizar L(θ;x1,…,xn) ⇔ maximizar lnL(θ;x1,…,xn) CASO 1: Un solo parámetro: * ∂ ln L ( θ ) ∂θ = 0 ==> Solución ϑ̂ ∂ 2 lnL(θ) * ∂θ2 θˆ < 0 CASO 2: Varios parámetros: * * ∂ ln L (θ ) ∂ θ1 ∂ ln L (θ ) ∂θ 2 =0 =0 ⇒ Solución ϑ̂ =( ϑ̂ 1, ϑ̂ 2) * Hessiano definida negativa 9 Ejemplo: (X1,...,Xn) muestra aleatoria simple de una v.a. Bernoulli b(p) L(p)=p(X=x1,…,X=xn; p)= p(X=x1)… p(X=xn)= p ∑ xi (1 − p )n − ∑ xi lnL(p)= Σxi ln(p)+(n-Σxi)ln(1- p) ∂ ln L( p) Σxi n − Σxi − = =0 ∂p p (1 − p) ⇔ (1- p)Σxi - p(n-Σxi)=0 ⇔ Σxi- pn=0 ⇔ p̂ = X 1 ∂2 lnL( p) 1 ( n − Σ x ) x − Σ i i (1 − p) 2 ∂p2 p̂ = p 2 − − − (1 − X ) 2 n X n (1 − X )X 2 − (1 − X ) n n X = = X 2 (1 − X ) 2 X (1 − X ) p= X −n = X (1 − X ) <0 Observar: Si (x1, x2, x3, x4) = (1.,.1.,.0.,.0..) ==> p̂ = 2 =0.5 (¡como en el ejemplo bolas!) Si (x1, x2, x3, x4) = (1.,.0.,.1.,.1..) ==> p̂ = 3 =0.75 (¡como en el ejemplo bolas!) 4 4 10 2º MÉTODO: NO hay condiciones de regularidad: Resolver el problema geométricamente: ¾ Obtener la función de verosimilitud L(θ) ¾ Representar gráficamente L(θ) ¡como función de θ! ¾ Localizar el punto correspondiente al máximo de dicha función Ejemplo: (X1,...,Xn) muestra aleatoria simple de una v.a. Uniforme U(0,θ) L(θ)=L(θ;x1,…,xn)= f(x1,…,xn; θ) = f(x1;θ) f(x2;θ)….f(xn; θ)= 1 θn 0 si x(n)<θ, x(1)>0 resto Dibujar esta función ⇒ ϑ̂MV =X(n) 11 Propiedades del E.M.V.: INVARIANZA: si ϑ̂MV es estimador máximo verosímil de θ, g(θ) una función de θ ⇒ g( ϑ̂MV ) es el estimador máximo verosímil de g(θ); es decir : g(θ) =g( ϑ̂ ) SUFICIENCIA Y E.M.V.: Si hay un estadístico suficiente, el E.M.V. (si es único) es función de dicho estadístico; y si no es único, existe un EMV función del estadístico suficiente. EFICIENCIA Y E.M.V.: Si existe el estimador eficiente, éste es un E.M.V. (es solución de la ecuación de verosimilitud) PROPIEDADES ASINTÓTICAS: bajo ciertas condiciones c.p. ¾ Consistente: ϑ̂MV ⎯ ⎯ ⎯→ θ ( plim ϑ̂MV =θ) n→∞ ¾ Asintóticamente insesgado: lim E( ϑ̂MV )=θ n →∞ Asintóticamente normal ¾ Asintóticamente eficiente: varianza de distribución asintótica = cota Cramer-Rao ¾ d n (θˆ − θ ) ⎯ ⎯→ N ( 0, v (θ )) 12