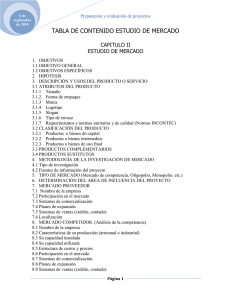

Elaboración, análisis e interpretación - RUA

Anuncio