4. Hipotesis HMMs

Anuncio

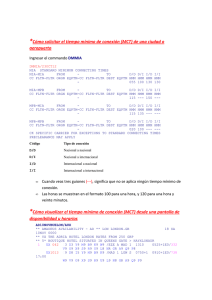

Hipótesis básicas de las HMMs, y posibles variantes. Luca Martino Tratamiento de Voz y Audio Master Interuniversitario en Comunicaciones y Multimedia luca@tsc.uc3m.es 1 INDICE 1. 2. 3. 4. 5. 6. 7. Introducción .............................................................................................................3 Definiciones previas .................................................................................................3 Hipótesis de partida.................................................................................................4 Debilidad del enfoque clásico .................................................................................5 Perceptrón Multicapa (MLP) .................................................................................6 HMM híbrida ...........................................................................................................7 Referencias ...............................................................................................................9 2 1. Introducción En este trabajo analizaremos las hipótesis fundamentales para el desarrollo clásico de las Cadenas de Markov Ocultas (HMM) para Reconocimiento de Habla, y sus posibles variantes debidas al utilizo conjunto con redes neuronales artificiales (ANN). 2. Definiciones previas Las Cadenas Ocultas de Markov (HMM) asumen que el vector de datos en estudio sea lineal y estacionario a trozos. Las HMM son maquinas compuestas por 2 procesos estocásticos concurrentes: una secuencia oculta de estados (no directamente observable) que modela la estructura temporal de la señal de voz, y un proceso de datos de salida modela las propiedades estacionarias locales de la señal. Supondremos que la señal de voz esté descrita por un números finitos de estados K cuyas transiciones están sometida a leyes estadísticas conocidas, y 2 estados inicial y final que no emiten observaciones. Cada estado emitirá con una cierta densidad de probabilidad unos datos, que serán nuestras observaciones acústicas. Generalmente, se añaden dos estados inicial y final que no emiten observaciones Q q1 , q2 ,..,qk q I estadoinicial(no emite) (1) q F estado final(no emite) Entonces, nuestro modelo estará compuesto por la probabilidades de transición de estado p( xt 1 q j | xt qi ) (será una matriz de transición), y la probabilidad de emisión p( yt 1 | xt ) . Con xt Q hemos indicado el estado corriente al tiempo t. yt y t 1 yt 2 y t 3 p( yt 1 xt 1 ) xt p( xt 1 xt ) xt 1 xt 2 xt 3 t Cada frase será representada por una secuencia M de diferentes modelos HMMs (una cada unidad de lenguaje, como palabras); dado el correspondiente vector de observaciones acústicas Y, la probabilidad de interés será P(M | Y ) . Claramente el nuestro objetivo en decodificación seria maximizar esta probabilidad respecto a M conocidos las observaciones Y (MAP, máximo a posteriori), aunque tampoco es obvio como poderla estimar. Desafortunadamente, la fase de entrenamiento no suele permitir caracterizar P(M | Y ) , sino solamente la probabilidad de generar un cierto vector acústico dado el modelo ( P(Y | M ) , verosimilitud). Podemos utilizar la formula de Bayes: 3 P( M | Y ) P(Y | M ) P( M ) P(Y ) (2) Donde se nota como la probabilidad P(M | Y ) está dividida en dos partes: la primera P(Y | M ) P(Y ) es la parte acústica, mientras la segunda P(M) se refiere al modelo de lenguaje. Cuando entrenamos maximizando P(Y | M ) , haremos referencia al criterio MLE (Maximum Likelihood Estimate), y este el caso de las HMM clásicas. Es interesante notar, que si denotamos con el conjunto de todos los posibles parámetros en el esquema planteado anteriormente (numero de estado, topología de la cadena, densidades, posibles unidades de lenguaje…) para todos los posibles modelos, si fijamos un modelo M los parámetros libres sobre los cuales podemos entrenar, estarán sensiblemente reducidos. 3. Hipótesis de partida El modelo descrito se basa sobre las hipótesis siguientes: H1: la P(M ) de una secuencia de estados puede ser calculada separadamente, sin conocimientos de los datos acústicos. El cálculo de la probabilidad P(M ) se apoya en modelos de lenguaje formulados en términos de gramática estocástica. H2: suponiendo conocida una secuencia de datos, la probabilidad P (Y ) puede ser considerada constante e independiente del modelo (esto es verdad solo si los parámetros están fijos). H3: se asume que la cadena de Markov será de primer orden; en formula: p( xt | xt 1 , xt 2 ....,x1 ) p( xt | xt 1 ) (3) Además se suele considerar las probabilidades de transición invariantes en el tiempo, es decir, estacionarias. H4: en el párrafo precedente hemos hablado de probabilidades de emisión, basándonos en esta suposición: p( yt | X t 1 , Yt ) p( yt | xt ) X t 1 xt 1 , xt 2 ,.., x1 Yt yt , yt 1 ,.., y1 (4) Es decir asumimos que la emisión de una observación no depende de las pasadas observaciones, sino solamente del estado corriente (tampoco de los estados anteriores). Merece la pena evidenciar que esto, de todas formas, no significa que los datos observados sean independientes entre si: p( yt | Yt ) p( yt ) !!!! (5) 4 H5: cuando se consideran observaciones yt continuas, las p( yt | xt ) se modelan como gaussianas multivariadas, o más en general mezclas de gaussianas. De todas formas, aunque no se utilicen exactamente estas densidades siempre tendremos que hacer alguna suposición al respecto. 4. Debilidad del enfoque clásico Hemos afirmado que típicamente para entrenar una HMM se utiliza el criterio MLE; pero hay varios problemas a respecto: 1. implícitamente asumimos que el modelo (con su relativa topología y densidad de probabilidades) se ajustaban bien a la estructura de los datos. 2. el criterio MLE no discrimina entre varios modelos (tenemos que suponer un modelo dado) mientras el criterio MAP nos ayuda en diferenciar entre modelos “rivales”. 3. También la hipótesis H3 (cadena de Markov del primer orden) puede resultar limitante. 4. La hipótesis H4 resulta restrictiva porque no tenemos en cuenta de las observaciones cercanas (pasadas y futuras). 5. Hay que suponer una densidad de emisión a priori asociadas a cada estado. En general deberíamos maximizar para todos los modelos M i : P( M i | Y ) P(Y | M i ) P( M i ) P(Y ) (6) Y en este caso, en la fase de entrenamiento P (Y ) no puede ser considerada constante porque dependiente de los parámetros de todos los posible modelos. De hecho, recordando que es el conjunto de parámetros de todos los posibles modelos y teniendo en cuenta que los modelos son mutuamente exclusivos, P (Y ) puede ser escrita: P( X | ) P( X | M k , ) P(M k | ) P( X | M k , ) P(M k ) k (7) k Claramente la suma incluye el modelo correcto; por la hipótesis H1 hemos considerado P(M k | ) P(M k ) y las verosimilitudes P(Y | M i ) dependen solamente de los parámetros i presentes en M i : P ( M i | Y , ) P(Y | M i , i ) P( M i ) P(Y | M i , i ) P( M i ) P(Y | M k , k ) P( M k ) (8) k i Si maximizamos P(M i | Y , ) restringiendo los parámetros al subespacio M i , volvemos al criterio MLE (el denominador se reduce a una constante). Si no hacemos ninguna limitación, maximizar la (8) equivale a maximizar la expresión: 5 P ( M i | Y , ) 1 1 P(Y | M k , k ) P( M k ) P(Y | M i , i ) P( M i ) k i (9) P(Y | M i , i ) P( M i ) P(Y | M k , k ) P(M k ) k i Si asumimos iguales probabilidades a-priori P(M k ) , hallamos el llamado Criterio de Máxima Mutua-Información que consiste en maximizar esta función: P(Y | M i , i ) P(Y | M k , k ) (10) k i Que es también un criterio discriminante. De todas formas, este no es el método más utilizado por razones computacionales, por que la matemática del asunto suele complicarse mucho (con muchas restricciones añadidas). Más en adelante describiremos un enfoque diferente para resolver el problema. 5. Perceptrón Multicapa (MLP) Mc Culloch y Pitts en 1943concibieron un modelo abstracto y simple de una neurona artificial: F(z) x1 w1 x i wi xm z F(z) y wm Donde F(z) es no lineal: M y F wi xi i 1 (11) La arquitectura de una red neuronal artificial (ANN) está formada da múltiples conexiones de este sistema elemental; los pesos serán ajustados según los objetivos prefijados. En general, se eligen los pesos wi en manera tal que la salida generada y por la ANN sea lo más cercana posible a la verdadera salida dada una cierta entrada (la red trata de encontrar un modelo desconocido que generó la salidas). Este “aprendizaje” se llama supervisado porque se conoce las salidas que hacen el papel de supervisor. En el aprendizaje no supervisado se utiliza con el objetivo del algoritmo es ajustar los pesos para que la red encuentre alguna estructura presente el los datos. 6 Una aplicación natural de la ANN es para clasificación: si se fuerza que la suma de las salidas de la maquina sume uno sobre todas las clases se puede considerar como un estimación de una probabilidades a posteriori ( p( xt qk | yt ) ) . El perceptrón multicapa es uno de los tipos de redes más comunes. Se basa en otra red mas simple llamada perceptrón simple solo que el número de capas ocultas puede ser mayor o igual que una. Es una red unidireccional (feedforward). La arquitectura típica de esta red es la siguiente: 1. Capa de entrada: Constituida por aquellas neuronas que introducen los patrones de entrada en la red. En estas neuronas no se produce procesamiento. 2. Capas ocultas: Formada por aquellas neuronas cuyas entradas provienen de capas anteriores y las salidas pasan a neuronas de capas posteriores. 3. Capa de salida: Neuronas cuyos valores de salida se corresponden con las salidas de toda la red. Capa de salida Capa de salida Capa de salida Capa oculta Capa oculta Capa oculta Capa de entrada Capa de entrada Capa de entrada x y1 yi yM r y1 yi yM y1 yi yM Las neuronas de la capa oculta usan como regla de propagación la suma ponderada de las entradas con los pesos y sobre esa suma ponderada se aplica una función de transferencia de tipo sigmoide, que está acotada. En unos casos se utilizan esquemas recurrentes donde la salida de una capa se realimenta en entrada. 6. HMM híbrida Hemos visto como un MLP puede proporcionar a la salida una aproximación de la probabilidad a posteriori de Bayes: si entrenamos la red neuronal para clasificar el vector de observaciones acústica podemos calcular p( xt qt | yt ) . Es decir, para cada observación tratamos de entender a cual “clase” pertenece. La idea básica de las HMM híbridas consiste en utilizar las densidades de probabilidad generada por un MLP como posibles probabilidades de una HMM. Por ejemplo podemos pensar estas posibles variaciones de la probabilidad de transición: 7 Caso 1: p( xt | X t 1 , Yt ) p( xt | xt 1 , yt ) Es la variación más simple que podemos implementar. Esta probabilidad podría ser calculada con un MLP recurrente con vector corriente la observación acústica y como feedback el estado anterior. Caso 2: p( xt | X t 1 , Yt ) p( xt | xt 1 , xt 2 ,.., xt k , yt ) A parte el dato observado al tiempo t añadimos la dependencia de varios estados antecedentes. Este enfoque conlleva varios problemas: el número de parámetros es excesivos, y el algoritmo de Viterbi no está bien pensado para probabilidades de orden mayor. Caso 3: p( xt | X t 1 , Yt ) gtk p( xt qk | g t 1 , yt ) Donde g tk representa la salida del MLP por la clase qk al tiempo t, y g t g t1 , g t2 ,...,g tK es el vector con todas las salidas del MLP. En este caso, la transición depende por la observación acústica corriente, y todas las probabilidades condicionales anteriores. Estas ultimas, puede ser generada por un verdadero MLP recurrente. Caso 4: p( xt | X t 1 , Yt ) p( xt | yt , yt 1 , yt 2 ,...yt k ) p( xt | yt c ,.., yt ,.., yt c ) Ahora la dependencia por los estados anteriores está sustituida por la dependencia de k observaciones (incluso pueden ser datos futuros). Aunque no sea más estrictamente una cadena de Markov, se puede aplicar el mismo formalismo y aplicar el algoritmo de Viterbi para entrenar y luego decodificar. Esta elección de la probabilidad de transición tiene su relevancia si se tiene en cuente que la probabilidad MAP puede ser factorizada: P( M i | Y ) .... P( x1 qL ,.....,x N qL , M i | Y ) L1 1 LN (12) N donde se suma sobre todo posibles caminos en M i . La expresión a la derecha puede ser factorizada: P( x1 q L ,.....,x N q L , M i | Y ) P( x1 q L ,.....,x N q L | Y ) N 1 N 1 P( M i | Y , x1 q L ,.....,x N q L ) (13) N 1 Que sugiere separar el cálculo en dos partes. La primera parte es la decodifica del vector acústico en una secuencia de estados. La segunda parte representa el paso fonológico y de léxico; además como conocemos la secuencia de estado asociada a las observaciones, podemos eliminar la dependencia explicita da las Y: P(M i | Y , x1 q L ,.....,x N q L ) P(M i | x1 q L ,.....,x N q L ) 1 N 1 N (14) 8 Así que a la hora de calcular la P(M i | Y ) nos quedamos solo con el primer factor. Además también el primer factor puede ser factorizado ulteriormente: P( x1 q L ,.....,x N q L | Y ) p( x1 q L | Y ) p( x 2 q L | Y , x1 q L ) 1 N 1 2 1 p( x N q L | Y , x1 q L ,.....,x N 1 q L N 1 N p(xn q Ln | X n1 , Y) N 1 ) (15) n 1 Y este factor es la probabilidad de transición modificada, como visto en los casos anteriores. 7. Referencias [1] Connectionist Speech Recognition; H.A. Bourlard, N. Morgan [2] Connectionist Probability Estimators in HMM Speech Recognition; S. Renals, N. Morgan, H.Boulard. [3] Redes Neuronales Artificiales; F. Izaurieta, C. Saavedra. [4] Redes Neuronales Artificiales; R.Salas. 9