Condicionamiento instrumental: el entrenamiento de recompensa.

Anuncio

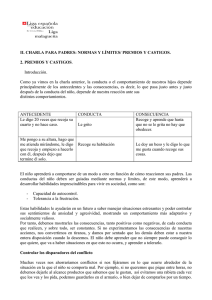

TEMA 3: CONDICIONAMIENTO INSTRUMENTAL: EL ENTRENAMIENTO DE RECOMPENSA 3.1 Concepto y tipos de reforzadores positivos Como ya se ha visto, un reforzador es un suceso que cuando sigue sistemáticamente a una respuesta, aumenta su fuerza, su probabilidad o su frecuencia futura. A estas alturas ya debe quedar claro que un refuerzo es un concepto definido a posteriori: lo es porque funciona como tal. Si probamos a reforzar una conducta con un determinado suceso y la conducta no aumenta, entonces ese suceso NO ha actuado como reforzador para ese organismo. Un refuerzo es un refuerzo porque refuerza. Los refuerzos o reforzadores pueden ser: • • • Estímulos concretos, simples (p.e., un trocito de comida, una sonrisa) Configuraciones estimulares complejas (p.e. un amplio conjunto de signos de aprobación que incluya gestos, palabras y tonos de voz) Posibilidades conductuales: p.e., permiso para usar la consola durante un tiempo, jugar con el perro un rato a su juego favorito). 3.1.1. Principio de Premack De acuerdo con este autor, de forma general, el reforzamiento se produce cuando una conducta de baja probabilidad va seguida sistemáticamente por la posibilidad de realizar una conducta de alta probabilidad. Las conductas de alta probabilidad son aquellas que un organismo tiende a realizar frecuentemente cuando puede. Por ejemplo, comer o beber son conductas de alta probabilidad en la mayoría de los animales. Comer un bombón o un caramelo es una conducta de alta probabilidad en la mayoría de los niños (no tanto comer verduras). Por el contrario, pulsar una palanca o ponerse en dos patas son conductas de baja probabilidad en los perros, y ordenar la habitación es una conducta de baja probabilidad en la mayoría de los niños. Es decir, la alta probabilidad se corresponde bastante con lo que en lenguaje ordinario diríamos “cosas que le gusta hacer”. Según Premack, pues, el refuerzo positivo consiste siempre en permitir al organismo una conducta de alta probabilidad si efectúa una de baja. Así, el refuerzo a la pulsación de palanca de la rata no es la comida en sí, sino la posibilidad de comer. No todos los psicólogos consideran acertado el principio de Premack. Por fortuna, a casi todos los efectos empíricos y prácticos, resulta bastante indiferente que pensemos que el reforzador sea la propia comida o que sea la posibilidad de comer. 3.1.2. Reforzadores primarios y secundarios Son reforzadores primarios los que actúan como reforzadores de manera general para todos los miembros normales de una especie, y lo hacen de forma esencialmente innata. Comida, bebida, sueño, sexo, etc. No son muchos ni muy fáciles de manejar. En nuestra especie están muy matizados por el aprendizaje individual, cultural, etc. 1 Condicionamiento Tema 3 Son reforzadores secundarios aquellos cuya capacidad de reforzar no se debe a razones innatas, sino a aprendizajes previos del organismo. Algunos son reforzadores condicionados: han adquirido sus propiedades reforzadoras por condicionamiento clásico. Por ejemplo, el sonido de la palanca que presagia la comida, o el clicker utilizado en el adiestramiento de animales. Otros son secundarios pero no han sido aprendidos por condicionamiento. Por ejemplo, el dinero, la victoria en un juego o deporte, etc. 3.1.3. Reforzadores particulares en Homo sapiens: Algunos reforzadores actúan especialmente bien en los seres humanos por combinación de nuestras características etológicas (somos hipersociables, jerárquicos, etc.) y el influjo de la cultura y el contexto concreto en que nos desarrollemos. Por ejemplo: Atención por parte de otros. Gestos de comprensión, interés, etc. Signos de aprecio, valoración, prestigio, jerarquía. Logro, victoria, triunfo, éxito… 3.2 Entrenamiento de recompensa: Principales factores Aunque son muchos los factores (variables independientes) que pueden influir en la efectividad del entrenamiento de recompensa, vamos a considerar sólo los más generalmente significativos. El más importante de ellos, el programa de refuerzo, lo tratamos con cierto detalle en último lugar, en punto aparte (3.3). 3.2.1. Magnitud del reforzador Aumentos en la cantidad de la recompensa mejoran la actuación del organismo en la situación de adquisición, pero no la persistencia de lo aprendido. Aumentos en la calidad producen el mismo efecto. Por ejemplo, usando como reforzador agua azucarada se mejora el nivel de ejecución respecto al uso de agua pura. Un caso extremo lo constituyen los experimentos de Olds con estimulación directa del hipotálamo. Sin embargo, en el caso general, las recompensas cuantiosas y/o de alta calidad suelen dar lugar a conductas que se extinguen más fácilmente. Para implantar conductas duraderas sólidamente, es preferible utilizar recompensas pequeñas, sobrias. 3.2.2. Demora de la recompensa Es el intervalo respuesta-recompensa. Afecta drásticamente al aprendizaje, en el sentido de que a mayor demora, menos aprendizaje. A partir de un determinado punto, el organismo no aprende. Demoras superiores a unos 30 sg. parecen no producir ya CI, aunque hay variaciones entre especies y sistemas de respuesta. Por ejemplo: con ratas, laberintos y comida, la demora tolerada por los organismos para lograr un nivel alto de aprendizaje se sitúa entre 2 sg. y 5 sg. Sin embargo, se obtienen buenos niveles de aprendizaje con demoras mayores, debido a la acción de estímulos (e.g., el 'clic' de la palanca) que actúan como reforzadores secundarios. En este caso, en realidad lo que ocurre es que la demora es mucho menor de lo que parece si sólo consideramos la R y el primario. 2 Condicionamiento Tema 3 El condicionamiento funciona idealmente cuando el refuerzo (primario o secundario) es inmediato a la conducta, y pierde eficacia rápidamente al aumentar la demora. 3.2.3 . Impulso Se refiere al estado motivacional del organismo respecto a aquello que vamos a usar como recompensa. Se define en términos de porcentaje del peso perdido, nº de horas de privación de agua, etc. El resultado general es que la actuación es tanto mejor cuanto mayor es el impulso (más peso perdido, más horas de privación, etc.), salvo en casos extremos. 3.3. Programas de refuerzo Hasta ahora hemos considerado sólo el caso en que la realización por parte del organismo de la conducta elegida va siempre seguida de la consecuencia establecida (la probabilidad del estímulo reforzador dada la respuesta operante es igual a 1). Esto (que constituye una contingencia total) es lo que se denomina refuerzo continuo. El refuerzo continuo no es la única (ni la más eficaz) alternativa para el aprendizaje por CO; por el contrario, constituye sólo un caso muy particular. Los casos en que la contingencia de refuerzo (la relación respuesta-consecuente) no es completa (es decir, no toda emisión de la respuesta va seguida del consecuente) se denominan situaciones de refuerzo parcial o intermitente. Es fácil ver que el refuerzo parcial es lo más común en situaciones naturales (ajenas al laboratorio o la clínica): en la vida real es extremadamente raro que las conductas normales de un organismo tengan éxito (=obtengan reforzador) en el 100% de los casos. Un programa de refuerzo es una regla que especifica bajo qué condiciones la emisión de la respuesta va a ser seguida del reforzador, es decir, la pauta con la que las respuestas son reforzadas. El programa de refuerzo es, según muchos autores, una de las variables independientes más poderosas de la psicología, en el sentido de que conociendo el programa concreto recibido por un organismo, se pueden predecir confiablemente muchas cosas respecto a la conducta adquirida. Como es evidente por su definición, es posible una infinidad de programas de refuerzo diferentes. Aquí veremos sólo algunos de los más importantes, que se pueden clasificar en los siguientes tipos: • Programas básicos o simples: trabajan con una sola respuesta, que se refuerza siguiendo una regla sencilla (una única exigencia). • Programas complejos: se aplican a una sola R, pero combinan las exigencias de dos programas básicos. • Programas concurrentes: se aplican a dos o más operantes en la misma, cada uno sometido a un programa de refuerzo distinto • Otros: No pertenecen a ninguna de las anteriores categorías, pero revisten importancia práctica: programas de reforzamiento diferencial de tasas bajas, programas de duración, etc. 3 Condicionamiento Tema 3 3.3.1. Programas básicos. Los programas básicos (también llamados "simples") pueden ser • • De razón: se recibe la recompensa sólo tras la emisión de un número determinado de respuestas. De intervalo: se obtiene la recompensa tras la primera respuesta que se produce una vez transcurrido un intervalo de tiempo establecido, contado desde el último reforzador. A su vez, la razón o el intervalo pueden ser • • Fijos : con el mismo valor a lo largo de toda la adquisición Variables: con distintos valores a lo largo de la sesión, que oscilan en torno a un promedio. Así obtenemos los cuatro tipos de programas básicos: RF-n, IF-n, RV-n e IV-n, donde n es el valor de la razón o del intervalo (o su promedio, si es un programa variable). En la aplicación de un programa de reforzamiento a un organismo que no ha sido objeto de aprendizaje previo, normalmente se comienza por un proceso de moldeado, luego se sigue con refuerzo continuo y finalmente se va progresivamente aumentando las exigencias hasta llegar al programa deseado. 3.3.1.1. Razón fija Se administra una recompensa por cada n respuestas. En un programa RF-5, cada quinta emisión de la R va seguida de reforzador. Programa RF-5 Ultimo R+ recibido Nuevo R+ Respuestas 5ª respuesta Tiempo Este programa produce una tasa de respuesta típicamente alta y estable. Si la razón es alta, sin embargo, esa estabilidad no es perfecta: el organismo se toma sistemáticamente pausas justo a continuación de la administración del reforzador, llamadas pausas post-reforzamiento. 4 Condicionamiento Tema 3 RF-90 RF-10 Respuestas emitidas acumuladas Pausas Tiempo --> Registro acumulativo típico de una rata sometida a entrenamiento de recompensa mediante un programa RF-10 (izda.) y un programa RF-90 (dcha). Los trazos gruesos y cortos indican los puntos en que se administró recompensa 3.3.1.2. Razón variable Los programas de razón variable son especialmente importantes, ya que (dentro de los simples) son los que más se aproximan a las situaciones naturales. Un programa RV especifica que el reforzador se administra tras un número de respuestas que varía a cada vez. Así, por ejemplo, en un RV-5 la recompensa se puede administrar tras 7, 3, 11, 2, 3, 5... respuestas, de forma que el promedio total sea 5 respuestas a lo largo de la sesión. Los programas RV son los que generan la tasa de respuesta más alta (lo que se manifiesta en el registro acumulativo por una gran pendiente) y constante (no aparecen pausas sistemáticas). Respuestas emitidas acumuladas RV-10 RV-90 Tiempo --> Registro acumulativo típico de una rata sometida a entrenamiento de recompensa mediante un programa RV-10 (izda.) y un programa RV-90 (dcha). Los trazos gruesos y cortos indican los puntos en que se administró recompensa 5 Condicionamiento Tema 3 3.3.1.3. Intervalo fijo En los programas IF se administra el reforzador a la primera emisión de la respuesta una vez transcurrido un intervalo desde la anterior emisión del reforzador, el cual intervalo tiene siempre la misma duración (de ahí lo de “fijo”). Cada reforzador, por tanto, inicia un intervalo (siempre igual) en el cual las Rs no son recompensadas. Programa IF-10” Ultimo R+ recibido Nuevo R+ Rs no reforzadas (dentro del intervalo) 1ª R tras el fin del intervalo Tiempo Intervalo de 10” El organismo aprende a anticipar cuándo aproximadamente va a estar disponible el siguiente reforzador, y progresivamente disminuye su tasa de respuestas al principio del intervalo y la aumenta hacia el final del mismo. Por ello, estos programas terminan por producir un característico efecto de festoneado en el registro acumulativo : IF-30sg. Respuestas emitidas acumuladas Pocas Rs en el principio del intervalo Muchas Rs al final del intervalo Tiempo Registro acumulativo típico de una rata sometida a IF-30sg. Los programas IF producen una tasa de respuesta global más baja que los de razón, y menos estable debido a las variaciones dentro de cada intervalo. 6 Condicionamiento 3.3.1.4. Tema 3 Intervalo variable Los programas de intervalo variable son como los anteriores, sólo que el intervalo oscila en torno a un valor promedio. IV-30sg. Respuestas emitidas acumuladas Tiempo Registro acumulativo típico de una rata sometida a IV-30sg. Dan lugar a una tasa de respuesta moderada que, globalmente, es más o menos igual que la de IF, pero mucho más estable. Al no ser predecible por el organismo la duración del intervalo, no hay diferencias locales de tasa de respuesta (el organismo responde a un ritmo sostenido). Por este motivo, es un programa idóneo para establecer Rs que se van a emplear como línea base de ulteriores tratamientos o experimentos (en particular, se emplean muy a menudo para establecer líneas base de conducta para ulteriores intervenciones). En líneas generales, cabe formular las siguientes conclusiones sobre los cuatro programas básicos: 1) Los programas de razón dan lugar a tasas de respuesta más altas (se responde rápido). 2) Los programas variables dan lugar a tasas de respuestas más estables (continuas, ininterrumpidas). 3) En general, los resultados de la investigación con los distintos programas son muy consistentes de unas especies a otras. 7