Notas sobre Epistemología. Una mecánica nueva: Teoría de los

Anuncio

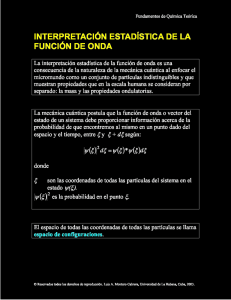

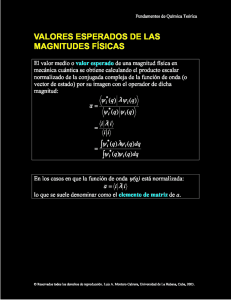

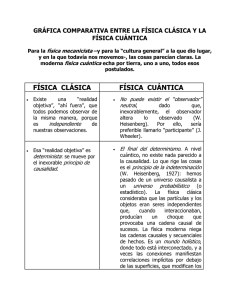

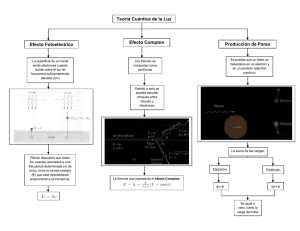

Notas sobre Epistemología. Una mecánica nueva: Teoría de los cuantos. FUENTE: PSIQUIATRIA.COM. 2004; 8(1) Fernando Ruiz Rey. Psiquiatra Wake County Human Services Raleigh, NC. USA E-mail: F5R7R0@aol.com La teoría cuántica comienza a esbozarse a fines del siglo XIX, pero su desarrollo parte en el siglo XX con los trabajos del físico alemán Max Planck (1900). Planck estudiaba los procesos naturales de cambio y equilibrio de energía en conexión con la entropía y se interesó por la absorción y emisión de energía del llamado ‘cuerpo negro’. Un cuerpo calentado al rojo vivo emite la mayor parte de su radiación en las zonas de baja frecuencia (rojo e infrarrojo), si se calienta más aún, al rojo blanco, emite proporcionalmente más radiaciones en las zonas del amarillo, verde y azul. Para estudiar estos procesos de intercambio de energía, se concibió un cuerpo o superficie ideal que absorba (sin ninguna irradiación) y emita toda la energía radiante, y que, por lo tanto, debía ser negro: El cuerpo negro. Los Físicos del siglo XIX habían determinado que existe una relación inversa entre longitud de onda y energía, incluso habían logrado ecuaciones para describir el proceso de absorción y emisión de radiación, pero estas fórmulas, o eran adecuadas para la descripción de la luz en la zona del violeta o, eran adecuadas para la descripción de la zona del rojo del cuerpo negro radiante, pero no habían logrado una fórmula para describir el proceso de intercambio de la radiación en todas las gamas de colores (diferentes frecuencias). Planck calculó las ecuaciones matemáticas que describían la distribución de la radiación del cuerpo negro en toda la gama de colores (frecuencias), pero cuando trató de entender qué significaban estas descripciones matemáticas, tuvo que concluir que para que tuvieran sentido era necesario concebir los osciladores (cuerpo negro) como solo capaces de absorber y emitir cantidades discretas de energía, en “cuantos” de energía. Planck no dio ninguna explicación por qué esta energía estaba ‘cuantificada’. Esta concepción discontinua de la energía, contradecía el supuesto básico de la física clásica proveniente de la introducción del cálculo infinitesimal por Leibniz y Newton, de que hay una continuidad de todas las cadenas causales de acontecimientos. Planck definió el cuanto de energía como la frecuencia de la oscilación, multiplicada por un pequeño número que pasó a ser conocido como la constante de Planck, y que da la relación proporcional entre cuanto, energía y frecuencia. La energía que encierra un cuanto es inversamente proporcional a su longitud de onda, o sea, a mayor longitud (menor frecuencia) menos carga energética, y vise versa (e=hv; e: energía, h constante de Planck; v: frecuencia). Max Planck resolvió el problema de la distribución de la energía en el espectro normal del calor radiante, incorporó la idea del cuanto de energía en la luz, lo que más tarde se llamará fotón, y estableció la fórmula matemática para calcular su energía. Planck sentó las bases de la teoría cuántica, pero no desarrolló más allá su descubrimiento del cuanto de energía. (1, 2) Ya en el siglo XIX se sabía que placas electrificadas y calentadas de metal emiten partículas cargadas al recibir un rayo de luz (posteriormente estas partículas se identificaron como electrones). El físico escocés James Maxwell y, otros científicos de la época habían mostrado que las ondas de la luz transportan cargas eléctricas, por lo que se pensó que era razonable esperar que estas ondas estimularan a estas partículas y las soltaran de los átomos. También parecía esperable que el aumento de la intensidad luminosa liberaría partículas con más energía cinética, pero los experimentos revelaron que solo aumentaba el número de partículas liberadas, pero no su energía. En cambio, la luz con ondas de más alta frecuencia, como la luz azul o la ultravioleta, desprendían partículas con alta energía, lo que no sucedía con la luz de baja frecuencia como la roja, no importando la intensidad de la luz, en ninguno de los dos casos. Esta situación no podía ser explicada con la concepción ondulatoria de la luz. Einstein en 1905, publicó un trabajo con su teoría del efecto “fotoeléctrico”. Siguiendo muy de cerca las ideas y los cálculos de Planck, Einstein propuso que la luz no estaba formada por ondas, sino que de partículas (más tarde fotones), con esta hipótesis se podía explicar claramente el fenómeno fotoeléctrico. Los fotones del rayo luminoso tienen una cierta energía que dependería de su frecuencia oscilatoria, a mayor frecuencia, más energía, Un fotón individual golpearía un electrón de la placa, si el fotón tenía suficiente energía estimularía al electrón de tal modo que se desprendería del átomo. La energía del cuanto de luz depende directamente de su frecuencia, por lo que la energía del electrón desprendido de la placa depende de la frecuencia de la luz. De este modo, se explica fácilmente que la luz de alta frecuencia como la azul, desprenda electrones con mayor energía, y si este rayo de luz es mas intenso, con más fotones, mayor será la cantidad de electrones liberados. (2) El razonamiento de Einstein fue que si la luz estaba constituida por ondas, la distribución de la energía de radiación tenía que ser necesariamente sobre una superficie esférica cuyo centro era la fuente luminosa. A medida que la luz se aleja de la fuente de origen, aumenta la superficie de distribución y se diluye con pérdida de energía. Sin embargo, la distancia entre la fuente luminosa y la placa eléctrica no cambia la energía de los electrones desprendidos que depende de la frecuencia de la luz (color). En cambio con la proposición corpuscular se eliminan los problemas, los fotones salen expulsados en línea recta en todas direcciones de la fuente luminosa, conservan su energía a cualquier distancia de élla, y pueden golpear firmemente la placa metálica. (2) Con este resurgimiento de la concepción corpuscular de la luz, se recrudeció también, el debate con los científicos defensores de la concepción ondulatoria, una polémica que durará un par de décadas, hasta que se llega a una reconciliación. (El proceso contrario: un haz de electrones golpeando la placa metálica produce el ‘desprendimiento’ de Rayos X, los fotones de estos rayos son 104 veces más energéticos que los de la luz). Según la “Antigua Teoría Cuántica”, la estructura del átomo, de acuerdo con el modelo atómico de Niels Bohr de 1913, está constituido por un diminuto núcleo positivo, que posee la mayor parte de la masa atómica, rodeado de electrones negativos que giran a su alrededor como planetas en torno al sol. Los electrones están sujetos a sus órbitas por cargas eléctricas; el número de electrones está dado por el “número atómico” del elemento. Basándose en el concepto de ‘cuantificación’ de la energía que había postulado Planck, Bohr propuso que el electrón en su órbita fija, constituye un sistema energético estable, su energía no se manifiesta mientras se mantenga en su órbita. Esta energía se hace manifiesta en cantidades fijas -“cuantos” de radiación- cuando el electrón salta a otra órbita. Si lo hace a una órbita periférica más energética, absorbe una cantidad discreta de energía; si salta de regreso a la órbita interior, emite la misma cantidad de energía. En cada salto del electrón se emite, o absorbe, luz de una frecuencia bien definida: Este fenómeno ‘cuántico’ explicaría el origen del espectro de absorción e emisión de los elementos con sus características distintivas (espectroscopía). Bohr postuló que cada órbita cuántica podía ser considerada como un “estado estacionario”, con ganancias y pérdidas de energía, sólo cuando los electrones saltan de una a otra órbita. Esta concepción de los cambios energéticos en cantidades fijas se llama, la “teoría cuántica” del átomo, y no solo no se ajusta a las leyes mecánicas de Newton, sino que tampoco a las leyes de la teoría electromagnética clásica del siglo XIX que tuvo éxito en la descripción de las ondas de luz y de radio; según esta teoría, el electrón debiera radiar su energía mientras gira en una órbita cuántica, pero como se ha señalado, esto no sucede. El modelo atómico de Bohr fue modificado en 1916 por Arnold Sommerfeld (3). Este científico alemán, en el espíritu de la “antigua teoría cuántica”, substituyó las órbitas circulares de los electrones del modelo de Bohr, por órbitas elípticas. Sommerfeld consideró la masa relativista del electrón moviéndose a velocidades cercanas a la de la luz, y llegó a lo que llamó la “constante de la estructura fina” del electrón, que posteriormente sirvió a Pauli para determinar el “espin” de esta partícula. El átomo de Bohr-Sommerfeld funcionaba bien para la descripción del hidrógeno, pero con elementos más complejos hubo dificultades: la espectrografía de estos elementos no coincidía con la visión establecida, tampoco se podía predecir adecuadamente las propiedades de átomos y moléculas, y no aclaraba la situación de la naturaleza de la luz: ondas o partículas. El físico y matemático alemán Werner Heisemberg en comunicación con otros colegas, se abocó al problema de desarrollar una nueva teoría cuántica que resolviera los problemas encontrados. Heisenberg consideró que como los electrones no se pueden observar, los dejó de lado en sus órbitas dando saltos, y partió de la evidencia, de lo observable: la luz emitida y absorbida por los átomos, y de sus relaciones, es decir, de las líneas espectrales de los átomos. En estos estudios utilizó las matemáticas de los números en orden conocida, como “matemática de matrices”. El resultado de esta investigación, publicada en 1925, fue una nueva avenida abierta en la mecánica cuántica. Heisenberg, Pascual Jordan y Max Born en Göttingen, continuaron desarrollando la mecánica cuántica desde la perspectiva de las matrices matemáticas, e incorporaron posteriormente, las ideas de Wolfgang Pauli (1925): el ‘espin’ del electrón y su ‘principio de exclusión’. El principio de exclusión postula que no pueden haber dos electrones con los mismos cuatro números cuánticos en un átomo. Para definir el estado energético de un electrón se necesitan cuatro números; tres números sólo se relacionan al movimiento del electrón alrededor del núcleo, con cuatro números se define su nivel energético, lo que implica que el electrón posee características especiales, además de rotar alrededor del núcleo, y que posteriormente resultó ser su “espin”. El principio de exclusión es muy importante para la comprensión de las propiedades químicas y físicas de los elementos. (4) Esta Mecánica de las Matrices fue desarrollada a fondo por Heisenberg, Jordan y Born, y fue publicada en 1926. La teoría Mecánica de las Matrices utiliza matemáticas sumamente complejas, y es realmente imposible imaginar los procesos así descritos. El físico francés Louis Victor de Broglie, considerando la extraña naturaleza dual de la luz demostrada en la radiación del cuerpo negro y en el efecto fotoeléctrico, propuso en 1924, que la materia también debería poseer propiedades, tanto ondulatorias, como corpusculares (Teoría Dual de la Materia) y, supuso que cada partícula con un momento dado, lleva asociada una onda (la partícula está localizada en un punto, la onda no) (5). De Broglie pensó que la ‘cuantificación’ observada en los experimentos realizados, y en la teoría de Bohr, era debida a la propiedad ondulatoria de la materia. De Broglie establece que la energía de los electrones, al igual que la de los fotones, es proporcional a la frecuencia de sus modos de vibración. Según De Broglie el electrón se encuentra encuadrado en el átomo, como la cuerda de una guitarra lo está en el instrumento. El modo de vibrar de un electrón es específico, como las cuerdas de la guitarra dan solo un tipo de vibración. Las variaciones de frecuencia vibratoria de los electrones se hace por unidades de acuerdo al modo específico de vibrar que tenga, su energía cuántica depende, entonces, de sus características ondulatorias. Esta teoría de la dualidad onda-corpúsculo de la materia (electrones) fue validada experimentalmente unos años más tarde (1927: C. Davison, LH Germer y GP Thomson) al demostrarse que un haz de electrones al pasar por un cristal, produce una figura de difracción característica de una onda. (6) Esta concepción del comportamiento ondulatorio de las partículas, llevó al físico austriaco Erwin Schrödinger a presentar en 1926, una Mecánica Cuántica “Ondulatoria” como alternativa a la defendida por Heisenberg y sus colegas. (7) Schrödinger dedujo la ecuación que obedece la función de onda asociada con una partícula y sostiene que la mecánica ondulatoria y la mecánica de las matrices dan resultados equivalentes (5, 8). Esta mecánica ondulatoria explicaba los mismos fenómenos que la otra, pero de una manera mucho más sencilla que la difícil matemática de las matrices, y aceptaba la visualización de las órbitas en el átomo; como resultado de estas ventajas ganó popularidad rápidamente. La teoría ondulatoria de Schrödinger permite visualizar los electrones como “ondas de materia”, cuya frecuencia determina su energía. Las órbitas cuánticas de materia serían como las cuerdas de un piano, cada una vibra con una frecuencia específica. Esta teoría presenta una continuidad ondulatoria, elimina la idea de partículas dando saltos electrónicos-energéticos, pero no puede explicar la ley de Planck. Born posteriormente, presentó la interpretación estadística de la función de onda, sosteniendo que las ecuaciones de Schrödinger no representan la ‘densidad de carga’ o ‘materia’, sino que describen solo la posibilidad de encontrar el electrón en cierto lugar (8). La mecánica ondulatoria de Schrödinger no es relativista - no sigue las ecuaciones de Lorentz-, en 1928 Paul Dirac, gran matemático y físico inglés, presenta las ecuaciones relativistas de la mecánica ondulatoria que satisfacen los requerimientos de la Teoría Especial de la Relatividad, con un tratamiento simétrico de las tres dimensiones del espacio y la del tiempo (la teoría de Schrödinger no lo hacía). Esta ecuación de Dirac permite calcular la función de onda de un electrón, y de otras partículas fundamentales, tomando en cuenta todos los efectos relativistas. Dirac pudo explicar adecuadamente el espin del electrón y dar cuenta adecuada de las estructuras finas de la espectroscopía óptica y de los Rayos X. (9) Ambas teorías daban respuesta a los mismos fenómenos, pero no podían, ninguna de las dos, dar una interpretación satisfactoria de muchos de los sucesos atómicos. Pauli en 1926 muestra la relación matemática entre la versión de Heisenberg y la de Schrödinger. El matemático alemán, David Hilbert, muestra que ambas teorías son, matemáticamente, completamente equivalentes. Paul Dirac en Cambridge, Inglaterra, y Pascual Jordan en Göttinberg, Alemania, trabajaron para solucionar la disparidad de estas teorías, y pudieron unificar matemáticamente el contenido físico de estos dos enfoques de la mecánica cuántica, creando las ecuaciones se conocen como la “teoría de la transformación”, estas constituyen la base de lo que se conoce como mecánica cuántica en la actualidad. Born fue el primero en utilizar la frase “mecánica cuántica” para designar estas teorías. Así formulada la mecánica cuántica, implica la paradójica situación de considerar ondas y partículas, no solo en relación a la luz, sino que ahora en relación a la materia misma. Con esto se plantea la necesidad de una conexión clara, libre de contradicciones, entre el mundo teórico de estas ecuaciones y el mundo de la observación experimental en los laboratorios. Heisenberg, en contacto epistolar con Pauli, encontró un problema en el cálculo matemático de la medición simultánea de dos variables físicas, posición y momento (masa X velocidad), que aparecían en las ecuaciones de Jordan y Dirac. Para describir un electrón hay que referirse a ciertas propiedades conmensurables de la partícula, como posición, momento energía y tiempo. Estas propiedades están dispuestas de tal manera en la ecuación matemática, que presentan una relación especial; el nombre técnico de este tipo de variables es, “variables canónicamente conjugadas”. Para un electrón en movimiento, las variables conjugadas vienen en pares: posiciónmomento y energía-tiempo. Heisenberg mostró que hay una “imprecisión” o “incertidumbre” en los resultados de la medición de estas variables conjugadas. Cada vez que se mide una variable, se interviene y se altera con la experimentación, por lo que se tienen resultados cercanos, pero diferentes. Con la variación (desviación estándar) de estas medidas repetidas, se puede construir una curva de distribución de Bell, cuyo centro corresponde al término medio de la “imprecisión” o “incertidumbre” de las medidas de la variable que se está evaluando. Ahora, al medir simultáneamente dos variables conjugadas -posición y momento- se encuentra una situación matemática tal, que implica una imposibilidad de lograr precisión en la medición de ambas variables. La ecuación está formulada en tal forma que debe mantenerse una constante, lo que obliga a las variables conjugadas a variar sus valores de precisión -desviación estándar- para mantenerla. Por lo que si aumenta la precisión de la medida de posición, tiene que aumentar la imprecisión de la medida del momento y, vise versa. En una situación extrema, la precisión absoluta de la medida de posición, implica la imprecisión absoluta del momento. La imprecisión no se puede disminuir a cero, como en la física clásica (al menos teóricamente), porque esta incertidumbre surge de las ecuaciones mismas, y no de las posibles fallas del experimento. (6, 8). Heisenberg pensaba que para que las nociones teóricas tuvieran realmente sentido debían poder ser comprobadas en experimentos, ya sea real o, imaginario. Por esto, Heisenberg ejemplifica el problema de incertidumbre con la situación del microscopio que utiliza rayos gamma (teóricamente posible). Para poder visualizar un objeto debe ser iluminado para que los rayos luminosos reboten y acusen su presencia. Para que esto sea posible, es necesario que la longitud de onda de la luz sea menor que el tamaño del objeto, en caso contrario, la luz lo ‘envuelve’ y no rebota bien. Los rayos gamma poseen una alta frecuencia (longitud de onda corta), y, por lo tanto tienen una alta resolución (poder de distinguir objetos del microscopio). Pero, estos rayos también pueden concebirse en forma corpuscular: fotones. El momento del fotón (masa X velocidad) es inversamente proporcional a su longitud de onda, entre menor es su longitud de onda, mayor es su momento. Así si un fotón de gran momento golpea a una partícula para determinar su posición le transmite, ineludiblemente, parte de su energía, alterando su velocidad. Si se utiliza un fotón de gran longitud de onda y un momento bajo, no se altera significativamente la velocidad de la partícula, pero no se puede visualizar bien: se genera una relación de incertidumbre. (2) Heisenberg muestra matemáticamente en este experimento imaginario con un microscopio de rayos gamma que se genera una situación de incertidumbre. Esta ilustración de Heisenberg ha sido de gran beneficio para la enseñanza de la teoría cuántica, pero los físicos en la actualidad, piensan que la verdadera interacción cuántica y una verdadera incertidumbre asociada con ella, no puede ser demostrada por ninguna imagen que se asemeje a objetos cotidianos en colisión, sino que debe ser presentada con el análisis matemático formal. (7, 8) Pero, como se ha señalado, Heisenberg llegó al principio de incertidumbre en base a sus análisis matemáticos. Bohr propuso en 1923, el Principio de correspondencia que sostiene que las predicciones que haga la teoría cuántica deben corresponder a las de la teoría clásica cuando la teoría cuántica se usa para describir la conducta de los sistemas que pueden ser descritos por la teoría física clásica, por lo que el análisis de problemas que envuelven un número cuántico muy alto (más cercano a lo tangible) deben corresponder a los de la mecánica clásica. Este principio es importante, porque, según Bohr, toda la experimentación de laboratorio se realiza fundamentalmente siguiendo los principios clásicos, lo que afecta a las interpretaciones que se hagan en la conceptuación de la teoría de los cuantos (10). Este principio funciona bien desde el punto de vista práctico, pero abre camino a serias consideraciones teóricas. Por esto, cuando Heisenberg presentó su trabajo a Bohr, éste encontró que esta perspectiva era muy estrecha. Bohr pensaba que las relaciones de incertidumbre no emergen sólo de las ecuaciones cuánticas y del uso de conceptos de partículas y discontinuidades como lo presentaba Heisenberg, sino que las representaciones de onda y partículas son esencialmente complementarias, esto es, son mutuamente exclusivas, pero ambas son necesarias para una descripción completa de los sucesos cuánticos. Por lo tanto, cualquier experimento realizado en el mundo corriente -siguiendo los principios de la física clásica- no pueden mostrar simultáneamente la onda y la partícula. La concepción de “función de onda”, no observándose directamente ningún ‘objeto’, significa que esta función de onda es una mezcla de ambos: ondas y partículas. Solo cuando el experimentador interviene y elige qué observar, surge la onda o la partícula. Pero al elegir, el experimentador perturba a la ‘naturaleza’, no hay acceso posible a “lo que realmente es”. Bohr consideró que la “incertidumbre” de Heisenberg, era un aspecto parcial (de lo corpuscular), de una situación general (corpuscular y onda) de la mecánica cuántica, y después viva polémica, Heisenberg y Bohr, lograron un acuerdo: tanto las relaciones de incertidumbre, como el principio de correspondencia, señalan un límite en el conocimiento de la naturaleza. Heisenberg publicó su descubrimiento en 1927. Esta “relación de incertidumbre” pasó a conocerse como el “principio de incertidumbre”, o más descriptivamente como, “principio de indeterminación”. Este principio tiene profundas implicaciones en la relación de causalidad y determinación de la conducta de las partículas atómicas, porque para conocer el comportamiento futuro de una partícula se debe tener un conocimiento preciso de sus variables, posición momento, o energía tiempo, y esto no es posible de acuerdo al Principio de Indeterminación. Si se considera que las partículas llevan una onda asociada, la imprecisión señalada por Heisenberg, se hace aún más clara, ya que resulta natural pensar que si una partícula está localizada se debe poder asociar con ella un paquete de ondas, pero según el análisis matemático de esta situación, el momento de la partícula y el número de ondas están relacionados, por lo que, para localizar una partícula es necesario sumar todas las contribuciones de las ondas cuyo número varía entre cero e infinito, por lo que el momento de la partícula, también varía de cero a infinito, es decir, queda completamente indeterminado. (5) Cercana a esta indeterminación está la interpretación estadística de la función de onda de Schrödinger propuesta por Born, que junto con los principios de incertidumbre y de correspondencia, forman una interpretación lógica del significado físico de la mecánica cuántica conocido como la interpretación de Copenhagen. (11) No todos los científicos concuerdan con esta interpretación, Einstein y Schrödinger estuvieron entre los más ilustres disidentes. Einstein no confiaba en la dependencia en las probabilidades y, más bien creía, que la realidad es objetiva e independiente, las partículas se mueven con un curso determinado, y la tarea del científico es encontrar las leyes que rigen esos sucesos. El hecho que la mecánica cuántica no pueda describir acertadamente esta situación es una indicación de que esta mecánica está aún incompleta. (8) Esta polémica no ha sido aún resuelta. Los análisis de Heisenberg y de Bohr han influido en la visión de la mecánica cuántica que suele aceptarse en la actualidad; así por ejemplo, el carácter ondulatorio y corpuscular de la radiación electromagnética puede interpretarse como dos propiedades complementarias de la radiación. (7, 12) En la teoría cuántica la energía y el momento tienen una relación definitiva con la longitud de onda; todas las partículas tienen propiedades ondulatorias (como interferencia) y propiedades corpusculares (como posición); según como se mida, se harán evidentes unas, u otras (5, 13). La aplicación de la teoría cuántica al campo electromagnético clásico de Maxwell, encuentra que, al ‘cuantificarlo’, describe una partícula, que en este campo en particular, corresponde al fotón de luz; otros tipos de campos se asocian a otras partículas, como el electrón para el “campo clásico” de Dirac (1). Un campo se define por las propiedades de la partícula cuántica envuelta, incluyendo carga espin, etc., se trata de una descripción matemática de una entidad irreducible. Con la teoría cuántica se puede además, determinar la intensidad del campo en distintos puntos de su espacio; aquel punto que tiene más intensidad, corresponde con el lugar con más alta probabilidad de encontrarse el electrón. El cuadrado de la amplitud de la onda en un punto, en un momento dado, se correlaciona con la probabilidad de que el electrón se encuentre en ese lugar, pero, no puede afirmarse con certeza que un electrón se encuentre en un punto determinado en un momento dado. A este cálculo de probabilidad se le llama “Densidad de Probabilidad” y fue propuesta primeramente por Born (7). Por esta situación se pueden describir los campos como ondas probabilísticas de sus partículas cuánticas. La teoría cuántica puede describir y determinar en forma absoluta la distribución de los fenómenos cuánticos siguiendo sus ecuaciones, pero no puede determinar específicamente un fenómeno concreto, hace predicciones de probabilidad relativa de varios posibles resultados, pero no puede establecer cual ocurrirá en una situación particular; por ejemplo, no puede predecir adecuadamente en que parte de la pantalla golpeará un fotón determinado. Las interpretaciones de la teoría cuántica son “estadísticas”, lo que implica una indeterminación en las leyes de la física. (1) Paul Dirac realizó estudios que abrieron un nuevo horizonte en la física moderna. Con sus ecuaciones de Mecánica Cuántica Relativista llegó a formular la idea de energía negativa y la generación de una partícula de igual características que el electrón, pero de carga positiva. Esta proposición se juzgó demasiado atrevida e, incluso Schrödinger pensó en modificar las ecuaciones para evitar tan descabelladas conclusiones. Dirac persistió en sus ideas y, en 1932 en California, Charles David Anderson, haciendo estudios de choques entre átomos y rayos cósmicos en una cámara de Wilson, notó en unas fotografías la huella, de una nueva partícula, las de un electrón de carga positiva: positrón. La confirmación de las ecuaciones de Dirac se realizó. Dirac también había previsto la formación simultánea de dos electrones, uno positivo y otro negativo a partir de lo que el llamó energía negativa, un proceso de ‘materialización’ de la energía, y lo inverso, ‘desmaterialización’ de las partículas. Aún más, la perfecta simetría del electrón y el positrón le sugirieron la posibilidad de la reversión de la carga eléctrica de cualquier clase de partículas. Ambas predicciones fueron confirmadas años más tarde con los experimentos en aceleradores de partículas. (14) Alrededor de 1930 se pensaba que el átomo estaba constituido por electrones, protones y neutrones, estas partículas se consideraban fundamentales y constitutivas de todo el mundo material. Desde ese tiempo se han descubierto más de 100 partículas compuestas, llamadas hadrones -muchos de ellos bastante inestables-, cuyos elementos formativos los constituyen los quarks y los leptones y sus respectivas antimateria. Las partículas se unen formando el núcleo por “partículas mensajeras” conocidas como “gluons” (‘gomones’), los componentes más pequeños de la materia (1, 14), además de fuerzas como la electromagnéticas, gravedad, fuerzas nucleares, etc. Estos elementos constitutivos parecen ser los bloques primarios con los que se construye lo que se conoce como materia. Pero en verdad, no son bloques, pues se considera que son más bien, puntos de acción, sin una estructura interna que les de cuerpo. (16) A grandes temperaturas, estas partículas elementales se sueltan y se forma un “plasma”, que se piensa equivale al estado en que se podría haber encontrado el universo en los primeros momentos del Big Bang. (15) La mecánica cuántica proporciona una base teórica para la comprensión de la estructura del átomo y del fenómeno de las líneas espectrales, cambia la perspectiva de los enlaces químicos e influye en muchas otras áreas de la física de los sólidos, de la física nuclear y de las partículas fundamentales, de la astrofísica y de la cosmología actual. (7) Sin embargo, como se ha ya mencionado, no se considera a la mecánica cuántica como una teoría acabada, “completa”. Se han abierto muchas interrogantes y avenidas para la reflexión física teórica y filosófica. Los intentos por generar nuevas interpretaciones continúan efervescente. La Mecánica Cuántica creada por el esfuerzo y genio de un gran grupo de científicos de varias nacionalidades, ha probado ser una de las teorías más fértiles de las ciencias físicas. La mecánica cuántica es una descripción matemática del comportamiento físico de los átomos y de las partículas atómicas y de la energía que no se da como un continuo, sino en cantidades discretas: ‘cuantos’. El mundo visualizado por esta teoría es como un vasto espacio de “campos” interactuantes, en los que se encuentran las partículas en constante movimiento e interacción. La complejidad de las ecuaciones matemáticas usadas para describir los fenómenos estudiados es tan intrincada y abstracta, que son incomprensibles para el no iniciado en estas materias, y de imposible representación intuitiva. (1) La interpretación en palabras e imágenes de este mundo submicroscópico que se mueve a velocidades cercanas a la luz, resulta en proposiciones que desafían el sentido común. Bibliografía 1) Diaz Pozos P. Astrocosmo (2002). Los cuantos. www.astrocosmo.cl/h-foton/h-foton-06_07.htm 2) Diaz Pozos P.Astrocosmo (2002). La Mecánica Cuántica. www.astrocosmo.cl/ h-foton/h-foton-06_03 3) O’Connor JJ, Robertson EF (1997). Arnold and.ac.uk/~historyMathematicians?Sommerfeld.h 4) O’Connor JJ, Robertson ac.uk/history/References/Pauli.html EF Johannes @001).Wolfgang Wilhelm Ernst Pauli. Sommerfeld. www-gap.dos.st- www-history.mes.st-andrews 5) RHS Linux User (1997). Hipótesis de De Broglie. fis.linux-chile.org/ doc/mcuant/node4.html 6) Diaz Pozos P. (1999-2002) Astrocosmo. Louis Victor Pierre Raymond duc de Broglie. www.astrocosmo.cl/ biografi/b-l_broglie.htm 7) Teoría cuántica. html://leo.worlonline.es/calambre/teocuantica.htm#partícula. htm 8) Quantum Mechanics. www.aip.org/history/heisenberg/p07.html 9) Thomas D. (1996). Rudiments of Quantum Theory: Paul Dirac Relativistic Quantum Theory. www. chembio.uogel/ph.ca/educmat/chm386/rudiment/ rudiment.htm 10) Columbia Encyclopedia www.barteby.com/65/co/correspo.html (2002). Correspondence Principle. Barteby.com. 11) García-Colín. Cuarta parte Bohr y la Fundamentación de la mecánica cuántica. IX. La contribución de Niels Bohr a la Mecánica Cuántica. Introducción. htpp:// lectura.ilce.edu.mx:3000/sites/ciencia/volumen1/ciencia2/14/htm/sec_12.htm 12) Quantum Mechanics. 1925-1927. Sound Bites. www.aip.org/history/ heisenberg/Voice1.html 13) Stanford Linear Accelarator Center: Theory (2001). Quantum Mechanic. www2.slac.stanford.edu/vvc/theory/ quantum.html 14) Diaz Pozos P (1999-2002) Astrocosmo. Paul Adrien Maurice Dirac. www .astrocosmo.cl/biografi/b-p_dirac.htm 15) Diaz Pozos P (1999-2002) http://www.astrocosmo.cl/ /antiparticulas/antiparticulas.htm Astrocosmo. Antipartículas. 16) Stanford Linear Accelarator Center: Theory (2001). Fundamental particles. www.2slac.standord.edu/ vvc/theory/ fundamental.html