Preprocesado: Selección de Atributos

Anuncio

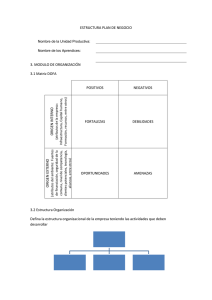

Selección de atributos Series Temporales Máster en Computación Universitat Politècnica de Catalunya Dra. Alicia Troncoso Lora 1 Contenido Introducción Clasificación de las técnicas Esquema General Evaluadores Subconjuntos Ranking Métodos de Búsqueda Referencias 2 Introducción (I) Los algoritmos de selección de características tienen dos objetivos principales: Reducir el coste computacional asociado tanto al aprendizaje como al propio modelo de conocimiento generado (eliminando atributos irrelevantes o redundantes) Aumentar la precisión de dicho modelo (eliminando atributos perjudiciales para el aprendizaje). 3 Introducción (II) Para llevar a cabo su objetivo, los métodos de selección realizan una búsqueda supervisada sobre el espacio de características, aplicando una función criterio que evalúa la calidad del subconjunto seleccionado. Dicha búsqueda suele ser heurística, ya que una búsqueda exhaustiva supone un problema combinatorio, resultando ésta enormemente costosa. Para su mejor funcionamiento precisa de una limpieza previa de los datos (outliers, valores ausentes, ruido, …) 4 Clasificación de las Técnicas Según la función criterio o Evaluador: Wrappers: la función criterio utilizada es el propio conjunto de reglas generadas por el algoritmo de aprendizaje que posteriormente se usará en la clasificación. Filtros: la función de criterio es independiente del algoritmo de aprendizaje, usando medidas de distancia, información o dependencia. Según el resultado: Individual: genera un ranking de atributos con todos Subconjunto: genera un subconjunto de atributos 5 Esquema General EVALUADOR: Individual (Ranking) Subconjunto MÉTODO DE BÚSQUEDA: En función del Evaluador 6 Esquema General (Weka [1]) Subconjuntos (-SubsetEval) Ranking (-AttributeEval) 7 Evaluadores - Subconjuntos (I) CFS [2]: Filtro Evaluador basado en correlaciones: Maximiza la correlación con la clase y minimiza la intercorrelación del subconjunto WEKA: AttributeSelection CfsSubsetEval ClassifierSubsetEval: Wrapper Usa un clasificador para evaluar los diferentes conjuntos que se obtienen con el método de búsqueda sin hacer validación cruzada WEKA: AttributeSelection ClassifierSubsetEval WrapperSubsetEval: Wrapper Igual que el anterior pero con validación cruzada de n folds (n es un parámetro que por defecto es 5) WEKA: AttributeSelection WrapperSubsetEval 8 Evaluadores - Subconjuntos (II) ConsistencySubsetEval: Filtro TODOS ATRIBUTOS DISCRETOS O DISCRETIZADOS Elige el subconjunto más consistente respecto a la clase: Inconsistencia: Quita un atributo y si hay ejemplos iguales con distinta clase, hay inconsistencia, luego el atributo es “importante”. Inconveniente: Atributos como el DNI son seleccionados por ser de consistencia máxima WEKA: AttributeSelection ConsistencySubsetEval 9 Evaluadores – Ranking RELIEF: Mira el k-vecino más cercano y el k-enemigo más cercano (10 vecinos por defecto) y pondera los atributos mediante una fórmula (depende de la versión) WEKA: AttributeSelection ReliefFAtributeEval Ganancia de Información (atributos discretos): Ganancia(Class, Atrib) = H(Class) - H(Class | Attribute) WEKA: AttributeSelection InfogainAttributeEval Razón de Ganancia (atributos discretos): GainR(Class, Attribute) = (H(Class) - H(Class | Attribute)) / H(Attribute) WEKA: AttributeSelection GainRatioAttributeEval Chi2 (atributos discretos): Usa estadístico Chi-cuadrado WEKA: AttributeSelection ChiSquaredAttributeEval 10 Métodos de Búsqueda El método de búsqueda va a depender del evaluador seleccionado previamente. Si es un Evaluador Individual (Ranking), el único método de búsqueda es Ranker Si es un Evaluador de Subconjuntos: Greedy (GreedyStepwise): Coge el mejor de todos, luego la mejor pareja que lo incluye, luego el mejor trío que incluye a los anteriores. Así hasta que no hay mejora. Primero el mejor (BestFirst): Lo mismo que Greedy pero aplicando Backtracking con un número máximo de regresos (5 por defecto) Exhaustiva (ExhaustiveSearch): Todos los posibles subconjuntos Aleatoria (RandomSearch) Algoritmo Genético (GeneticSearch) Y muchos más…. 11 Aplicación a Precios de la energía eléctrica Selección atributos-Precios 1 10 2 3 9 4 5 8 6 7 7 24 horas del dia d-1 8 9 10 6 11 12 5 13 14 4 15 16 17 18 3 19 2 20 21 1 22 23 24 1 2 3 4 5 6 7 8 9 10 11 12 13 14 24 horas del día d 15 16 17 18 19 20 21 22 23 24 0 12 24 horas del día d-2 Aplicación a Precios de la energía eléctrica 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 1 Selección de Atributos-Precios 10 9 8 7 6 5 4 3 2 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 24 horas del día d 0 13 Ejercicio 1: Glass2 Eliminar valores perdidos Ejecute los 4 evaluadores de subconjuntos con el método de búsqueda BestFirst sin validación cruzada (“Use full training set) CfsSubsetEval ClassifierSubsetEval (clasificador IB1 y UseTraining = true) WapperSubsetEval (clasificador IB1) ConsistencySubsetEval Anotar en la tabla los atributos seleccionados Clasificar con 1 vecino más cercano anotando en la tabla el error obtenido con las 5 bases de datos (la original y las cuatro nuevas). 14 Ejercicio 1: Glass2 Evaluador Atributos seleccionados IB1 (10-CV) CfsSubsetEval ClassifierSubsetEval WapperSubsetEval ConsistencySubsetEval Ninguno Todos 15 Ejercicio 2: Repetir el ejercicio 1 con las bases de datos de la UCI autos colic iris wine 16 Ejercicio 3: Demanda de energía eléctrica Descripción 24 atributos correspondientes a la demanda de energía de las 24 horas antes (h1,…,h24) a la que se quiere predecir que corresponde con el atributo clase (h25) 1) Establecer una comparación entre los atributos seleccionados usando distintos Evaluadores de subconjuntos y distintos métodos de búsqueda. 2) Obtener modelos de regresión lineal CON y SIN selección de atributos (WEKA:Classifier Functions LinearRegression) 3) Usar esos modelos para predecir, comparando los errores de predicción 17 Referencias [1] Ian H. Witten and Eibe Frank. Data Mining: Practical Machine Learning Tools and Techniques Morgan Kaufmann, June 2005. [2] Mark A. Hall. Correlation-based Feature Selection for Machine Learning. PhD thesis, Waikato University, Hamilton, NZ, 1998. [3] Kira, Kenji and Rendell, L.A.: A Practical Approach to Feature Selection. ICML International Conference on Machine Learning, pages 249-256, 1992 [4] A. Blum, P. Langley. Selection of relevant features and examples in machine learning. In: R. Greiner, D. Subramanian (Eds) Artificial Intelligence on Relevance: pp. 245-271, 1997. [5] H. Liu, L. Yu. Toward integrating feature selection algorithms for classification and clustering. IEEE Transactions on Knowledge and Data Engineering, Vol. 17, pp. 1-12, 2005. [6] R. Ruiz, J. C. Riquelme, J. S. Aguilar-Ruiz. Incremental wrapper-based gene selection from microarray expression data for cancer classification. Pattern Recognition, Vol. 39, pp. 2383-2392, 2006 18