eigenvalor

Anuncio

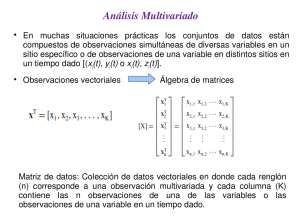

Eigenvalores y eigenvectores • Los dos problemas principales del álgebra lineal son: resolver sistemas lineales de la forma Ax = b y resolver el problema de eigenvalores. • En general, una matriz actúa sobre un vector cambiando tanto su magnitud como su dirección. Sin embargo, una matriz puede actuar sobre ciertos vectores cambiando solamente su magnitud. • Una función vectorial A es lineal si: a) A(x + y) = Ax + Ay b) A(αx) = αAx donde x y y son vectores y α es escalar. • Definición.- Dada una transformación lineal A, un vector e ≠ 0 es un eigenvector de A si satisface la ecuación: Ae = λe para algún escalar λ, llamado un eigenvalor de A correspondiente al eigenvector e. • Un eigenvalor λ y un eigenvector ē de una matriz cuadrada [A] satisfacen la ecuación: Aē = λē o de forma equivalente: (A – λI)ē = Ō • Cualquier múltiplo escalar, cē, también satisface la ecuación. En consecuencia, para definirlos con precisión es usual requerir que los eigenvectores tengan longitud unitaria: || ē || = [∑ek2]½ = 1 • En este caso, si ē satisface la ecuación, entonces -ē también la satisface. • Si además [A] es simétrica entonces los eigenvectores son ortogonales. Por lo tanto, los eigenvectores serán ortonormales: • La multiplicidad algebraica (m.a.) es el número de veces que se repite un eigenvalor (o el número de veces que se repite una raíz de la ecuación característica) y la multiplicidad geométrica (m.g.) es el número de eigenvectores linealmente independientes asociados a un eigenvalor particular. • Para cada eigenvalor distinto de una matriz n x n existe un eigenvector asociado a él, e.d., ambas multiplicidades son iguales a 1. Si la multiplicidad algebráica de un eigenvalor es r puede haber a lo más r eigenvectores l.i. asociados a él. • Los eigenvectores correspondientes a eigenvalores distintos son linealmente independientes y forman una base para Rn. • Si A es una matriz de n x n simétrica, entonces sus eigenvalores son reales. • Si A es una matriz de n x n simétrica y positiva definida, entonces sus eigenvalores son reales y mayores que cero. • Una matriz A es ortogonal si es cuadrada con elementos reales y sus columnas y renglones son vectores ortogonales unitarios. Si A es ortogonal entonces su transpuesta es igual a su inversa. • Si A es una matriz de K x K y es no-singular, habrá K parejas λK, ēK con eigenvalores distintos de cero. Si A es singular al menos uno de sus eigenvalores será cero y el eigenvector correspondiente será arbitrario. • Dada una matriz simétrica A, la matriz E cuyas columnas son los eigenvectores de A es ortogonal: ET = E-1 , EET = ETE = I • La transformación ortogonal ETx define una rotación rígida de los ejes coordenados en el espacio K-dimensional de x, llamado un eigenespacio. • Este espacio cubre el mismo “territorio” que las coordenadas originales pero usando un conjunto de ejes diferente. • Las K parejas λK, ēK contienen la misma información que la matriz [A] a partir de la cual fueron calculadas y por lo tanto pueden considerarse como una transformación de [A]. • Esta equivalencia puede expresarse como la descomposición espectral (o descomposición de Jordan) de [A], donde [A] es simétrica: • La matriz original [A] puede recuperarse mediante la suma pesada de estas matrices , donde los pesos son los eigenvalores correspondientes. La descomposición espectral de una matriz es análoga a la descomposición de Fourier de una función o serie de datos, con los eigenvalores jugando el papel de las amplitudes de Fourier y las matrices el de las funciones senoidales. f(x) = a0 + ∑an cos(nx) + ∑bn sen(nx) • La matriz de eigenvectores [E] tiene la propiedad de que diagonaliza la matriz simétrica original [A]: (también se cumple si A no es simétrica pero tiene K eigenvectores l.i.) • Los eigenvectores de una matriz simétrica no-singular son iguales a los de su inversa, , y los eigenvalores correspondientes son recíprocos: • Por lo tanto, el eigenvector de [A] asociado con su eigenvalor más grande es el mismo que el eigenvector de [A]-1 asociado con su eigenvalor más pequeño y viceversa. Descomposición en Valores Singulares • La descomposición espectral de una matriz cuadrada y simétrica puede ser extendida a cualquier matriz rectangular [A nxm] (con n ≥ m) usando la descomposición en valores singulares (SVD): • Las m columnas de L son llamadas vectores singulares izquierdos y las m columnas de R son los vectores singulares derechos. Ambos conjuntos de vectores son mutuamente ortogonales. • La matriz es diagonal y sus elementos no-negativos son llamados los valores singulares de [A]. • Si [A] es cuadrada y simétrica, la SVD se reduce a la descomposición espectral con • Los valores singulares de una matriz [A] de m x n son las raíces cuadradas de los eigenvalores de la matriz [ATA] de n x n. • Aún si [A] no es simétrica, existe una conexión entre la SVD y los eigenvalores y eigenvectores de ambas matrices , las cuales son cuadradas y simétricas (una es m x m y la otra n x n). • Específicamente las columnas de [R] son los eigenvectores (m x 1) de , las columnas de [L] son los eigenvectores (n x 1) de los valores singulares respectivos son las raíces cuadradas de los eigenvalores correspondientes, y Funciones Empíricas Ortogonales (Empirical Orthogonal Functions) • El análisis de FEOs busca estructuras que expliquen la mayor cantidad de la varianza contenida en un conjunto de datos bidimensional. Puede haber varios tipos de matrices o arreglos de datos bidimensionales: Arreglo espacio-tiempo: mediciones de una sola variable en M localidades tomadas en N tiempos diferentes. Arreglo parámetro-tiempo: Mediciones de M variables tomadas en una sola localidad en N tiempos diferentes. Arreglo parámetro-espacio: Mediciones de M variables tomadas en N localidades diferentes en un sólo tiempo. • Generalmente, al conjunto de estructuras obtenidas en la dimensión espacial se les conoce como las FEOs, mientras que al conjunto complementario de estructuras en la dimensión temporal se les conoce como Componentes Principales. • Ambos conjuntos de estructuras son ortogonales en su propia dimensión. • Objetivo: Proporcionar una descripción compacta de la variabilidad espacial y temporal de series de datos usando un número más pequeño de piezas de información independientes (en términos de funciones ortogonales o “modos” estadísticos). • El análisis mediante FEOs es un método para “particionar” la varianza de un conjunto de series de tiempo distribuidas espacialmente. • Son llamadas “empíricas” para reflejar el hecho de que están definidas mediante la covarianza del conjunto de datos que está siendo analizado. • Usualmente, la mayor parte de la varianza de las series de tiempo distribuidas espacialmente está representada por las primeras funciones ortogonales cuyos patrones pueden estar vinculados con posibles mecanismos dinámicos. • No necesariamente existe una relación física directa entre las FEOs (puramente estadísticas) y cualquier proceso dinámico con el que se les relacione. • El método de FEOs o CP utiliza el concepto de eigenvalores (valores propios o característicos) y eigenvectores (vectores propios o característicos). • Hay dos formas de calcular FEOs: 1) Se construye la matriz de covarianzas de las series de datos y después se descompone en eigenvalores y eigenvectores. 2) Se utiliza la descomposición en valores singulares (SVD) de la matriz de datos para obtener los eigenvalores, eigenvectores y amplitudes de variación temporal (componentes principales) sin calcular la matriz de covarianzas. • Las FEOs obtenidas por ambos métodos son idénticas. La diferencia está dada por el mayor grado de sofisticación, rapidez computacional y estabilidad de la SVD. Procedimiento • Consideremos un conjunto de N mapas en los tiempos t = 1...N, donde cada mapa contiene mediciones del campo en los sitios m = 1 … M. Por lo tanto, tenemos M series de tiempo todas de longitud N, con N>M. • El primer paso es remover el promedio de cada una de las series de tiempo para obtener las anomalías. Se puede trabajar con las anomalías o con las anomalías estandarizadas. La estandarización es especialmente relevante cuando se analizan dos o más campos de manera conjunta para asegurar que no domina un campo sobre los otros. • Se construye la matriz de datos FM x N Cálculo de FEOs usando la matriz de covarianzas • La matriz R es simétrica y cuadrada, aún si F no es cuadrada. Si las series de datos en F están normalizadas entonces R será la matriz de correlación en lugar de la matriz de covarianzas. • Una vez calculada R se resuelve su problema de eigenvaloreseigenvectores: • Generalmente los eigenvalores en la matriz están acomodados en orden decreciente. Como la matriz de datos F es real, la matriz de covarianzas R es positiva definida, lo que significa que todos sus eigenvalores son mayores o iguales a cero. • Aunque la dimensión de es M x M, típicamente solo los primeros K eigenvalores son distintos de cero, donde Entonces la dimensión efectiva de es de hecho K x K y por lo tanto solamente se pueden determinar K modos o FEOs. • Cada eigenvalor distinto de cero está asociado con un eigenvector columna en la matriz E. Por lo tanto, solamente se usan K eigenvectores en la descomposición y la dimensión efectiva de la matriz E será M x K. • Los eigenvectores no están correlacionados y cada uno representa el patrón espacial o FEO de modo k. • Cada eigenvalor es proporcional al porcentaje de la varianza del campo observado F que es descrito por el modo k. • La evolución temporal del k-ésimo modo o FEO se obtiene proyectando los datos originales sobre los eigenvectores, con lo que se obtienen las Componentes Principales: • es K x M, F es M x N y A es K x N, en donde se ha utilizado la matriz E reducida. Los renglones de la matriz A son series de tiempo de longitud N. • El campo original F puede reconstruirse en su totalidad multiplicando cada eigenvector por su correspondiente CP y sumando los productos: • Sin embargo, el objetivo de la descomposición en FEOs es la reconstrucción aproximada, compacta y menos ruidosa, del campo original F usando solamente los H primeros modos, con H < K: E = 0.8479 -0.5302 0.5302 0.8479 Avg. Λ = 254.7571 0 0 8.2902 • Generalmente se tienen observaciones de una variable particular en K sitios para n tiempos distintos, donde K >> n. • La matriz de covarianzas (KxK) es demasiado grande. • Como K > n la matriz de covarianzas es singular, lo cual implica que los últimos K – n eigenvalores son cero. • Intercambiando el papel de los puntos en espacio y tiempo, se calcula la matriz de covarianzas de n x n • Los eigenvalores de ambas matrices de covarianzas son los mismos. • Los eigenvectores de S*nxn son diferentes a los de SkxK pero pueden obtenerse a partir de los de S* mediante: Estadística multivariada • Un conjunto de datos univariado consiste de una colección de n observaciones escalares: • Un conjunto de datos multivariado puede acomodarse en un arreglo rectangular de números (o matriz) con n renglones y K columnas. Cada elemento corresponde a la i-ésima observación de la j-ésima variable, donde i = 1, …, n y j = 1, ..., K. (Geométricamente se puede ver como un espacio K-dimensional en donde cada renglón define un punto en dicho espacio). • Promedio muestral multivariado: vector cuyas componentes son los K promedios muestrales individuales • La extensión multivariada de la varianza muestral es la colección de covarianzas entre todas las posibles parejas de las K variables si k = l entonces la ecuación define la varianza muestral • Matriz de covarianzas o matriz de dispersión: