Transparencias de Teoría de la Estimación

Anuncio

Teoría de la estimación

Índice

Conceptos básicos

Calidad de los estimadores

Cota de Cramer Rao

Estimador de máxima verosimilitud

Estimador bayesiano

Estimador lineal de error cuadrático medio mínimo

1. Conceptos básicos

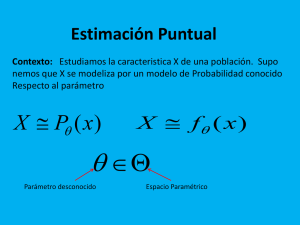

Teoría de la Estimación: Rama del procesado de señales y la

estadística, que estudia las técnicas utilizadas para proporcionar

un valor apróximado a un parámetro o variable, a partir de datos

empíricos o medidas.

Modelo de Estimación. El modelo normalmente utilizado, está

compuesto por los siguientes elementos:

Espacio de parámetros. Es un espacio no observable, cuyos

elementos son los posibles parámetros de los que depende la

generación de datos.

Espacio de observaciones. Es el espacio cuyos elementos son los

datos empíricos o medidas, que se van a utilizar en la estimación.

Regla de transición probabilística. Distribución estadística de las

observaciones, dependiendo del parámetro o parámetros.

Estimador. Función de los datos empíricos, que se utiliza para generar

la medida o estima.

1. Conceptos básicos

Estimador

Θ*(z)

Objetivo: Medir (estimar) el valor de θ utilizando un

instrumento de medida (estimador), diseñado usando

algún criterio

1. Conceptos básicos

Modelo en Teoría de la Detección (caso binario):

Objetivo: decidir si se ha enviado un “0” o un “1” dividiendo el

espacio de observaciones en regiones, asignadas a una u otra

hipótesis. Para ello se utiliza un estadístico que se compara con

un umbral

1. Conceptos básicos

Diferencias entre Teoría de la Detección y Teoría de

la Estimación:

En los problemas de detección, los parámetros

desconocidos pueden tomar un conjunto de valores finito y

numerable, de forma que el número de hipótesis posibles

es finito.

En los problemas de estimación, los valores que puede

tomar el parámetro desconocido son infinitos, por lo que no

tiene sentido aplicar la teoría de la detección. Las

observaciones (datos medidos) se utilizan para estimar o

inferir el valor del parámetro.

El parámetro a estimar puede ser determinista o

aleatorio.

1. Conceptos básicos

El parámetro θ cuyo valor desconocido queremos estimar

(medir de forma aproximada) puede ser:

Determinista. Por ejemplo, cuando queremos estimar la

media de una variable aleatoria, utilizando un número de

realizaciones de la misma.

Aleatorio. Por ejemplo, la fase desconocida de una

señal sinusoidal. Las señales observadas son

realizaciones de una señal aleatoria, cuya fase

instantánea depende de una variable aleatoria,

normamente con distribución uniforme en [0, 2π).

x ( t ) = Acos(ω 0 t + ϕ )

ϕ, es variable aleatoria

1. Conceptos básicos

Los datos se generan atendiendo a la f.d.p. definida en el

mecanismo de transición probabilística y tienen, por tanto,

carácter aleatorio.

El estimador del parámetro θ, denotado como θ*, es una

función de los datos (θ*(z)), y también tiene carácter aleatorio

(función de un vector aleatorio)

El estimador del parámetro es una variable aleatoria,

independientemente de si el parámetro es determinista o

aleatorio.

El estimador del parámetro, al ser una variable aleatoria, se

puede caracterizar por su función de densidad de

probabilidad, f(θ*(z))

1. Conceptos básicos

El estimador puede interpretarse como un instrumento de

“medida” del valor que toma el parámetro

El error es inherente al proceso de medida, por alguno de los

siguientes factores:

Defectos en el diseño del instrumento de medida, que pueden

dar lugar a errores sistemáticos. Por ejemplo, voltímetro mal

calibrado.

Es imposible obtener datos precisos. Por ejemplo, al medir una

señal contaminada con ruido, o al medir con un voltímetro real,

que “carga” al circuito en el que se mide.

No se dispone de suficientes datos, porque no es posible

obtenerlos, o porque no es práctico. Por ejemplo, estimación de

la intención de voto en base a resultados de encuestas (es

imposible encuestar a toda la población)

OBJETIVO: Diseñar instrumentos de medida donde la

influencia de los errores sea pequeña

Índice

Conceptos básicos

Calidad de los estimadores

Cota de Cramer Rao

Estimador de máxima verosimilitud

Estimador bayesiano

Estimador lineal de error cuadrático medio mínimo

2. Calidad de los estimadores

El error que se comete al estimar el valor del parámetro

desconocido (θ) mediante el estimador θ*, o “error de

estimación”, es, formalmente:

ε = θ − θ*

El error de estimación es una v.a., ya que el estimador tiene

carácter aleatorio (el parámetro también puede ser aleatorio).

Si el error de €estimación es una variable aleatoria, podría

caracterizarse estadísticamente por su f.d.p.

En general, debido a las dificultades encontradas para obtener

la f.d.p. del error de estimación, se estudian unicamente los

estadísticos de primer y segundo orden del mismo.

2. Calidad de los estimadores

SESGO (BIAS): Se define como el valor medio del error de

estimación, o la diferencia entre la media del estimador y el valor

medio del parámetro a estimar:

[

]

S(θ * ) = E θ * (z) − θ = E[θ * (z)] − E[θ ]

El sesgo nos da una idea del “error sistemático” cometido en la

medida o estimación. No informa sobre la dispersión de los

resultados de la medida o estimación.

€

Estimador insesgado: Es aquel estimador en el que el sesgo es

nulo, o lo que es lo mismo, la media del estimador coincide con el

valor medio del parámetro (si es aleatorio), o con el valor real del

parámetro, si es determinista.

2. Calidad de los estimadores

Varianza del estimador: Es una medida de la dispersión de las

estimas (resultados de la estimación), con relación al valor

medio de las mismas:

σε2

2

*

*

= E θ (z) − E(θ (z))

{

}

Valor cuadrático medio del error. Ofrece de forma conjunta,

información €sobre el valor medio del error y la dispersión del

mismo:

2

*

MSE = E θ (z) − θ

{

€

}

2. Calidad de los estimadores

Relación entre Sesgo, Varianza y MSE en la estimación de

parámetros deterministas:

[

MSE(θ * ) = E (θ * − θ ) 2

]

[ { } { } ]

MSE(θ ) = E {(θ − E {θ }) + ( E {θ } − θ )}

MSE(θ * ) = E (θ * − E θ * + E θ * − θ ) 2

*

*

*

*

2

2

*

*

*

MSE(θ ) = E θ − E θ + S(θ )

2

MSE(θ * ) = E θ * − E θ * + S 2 (θ * ) + 2S(θ * )E θ * − E θ *

*

{(

{ })

(

{ })

( )

MSE(θ * ) = var θ * + S 2 (θ * )

€

}

[

{ }]

2. Calidad de los estimadores

Ejemplo 1: Supongamos que X es una v.a. normal o gaussiana, de la que

sólo disponemos de N muestras tomadas de forma independiente. El valor

de la media (η) es desconocido y es, precisamente, el parámetro que nos

gustaría estimar. Se propone como estimador la media muestral:

El estimador es una v.a.

Normal

2.Calidad de los estimadores

En el ejemplo anterior, la varianza del estimador depende del

número de datos. Al aumentar el número de datos, la varianza

disminuye. Este hecho invita a definir una propiedad que permita

comparar los estimadores en base a la varianza de los mismos.

2. Calidad de los estimadores

Problema: En general, el estimador ideal depende del parámetro

cuyo valor se quiere estimar

Sólo es aplicable en algunos casos sencillos

2. Calidad de los estimadores

Eficiencia: Un estimador es más eficiente o preciso que otro, si

la varianza del primero es menor que la del segundo. El

estimador para el que la varianza se hace mínima se denomina

Estimador de Mínima Varianza. Si el estimador es insesgado y

de mínima varianza, recibe el nombre de Estimador Insesgado

de Mínima Varianza (MVUE).

Consistencia: Un estimador es consistente si al aumentar el

tamaño de la muestra el valor del estimador tiende a ser el valor

del parámetro. Para que ocurra eso, debe cumplirse lo siguiente:

lim S θ N* = θ

{ }

lim var{θ N* } = 0

N →∞

N →∞

Estimador asintóticamente

insesgado

2. Calidad de los estimadores

es

más

eficiente

que

2. Calidad de los estimadores

Ejercicio 2 : Estudiar si la media muestral es un estimador

consistente de la media de una variable aleatoria gaussiana

Si los datos son realizaciones independientes, se puede

demostrar que el estimador es una variable aleatoria

gaussiana, con f.d.p. N(η,σ2/N), por lo que es insesgado, y la

varianza tiende a cero al aumentar N. Es, por lo tanto, un

estimador consistente.

2. Calidad de los estimadores

Ejemplo: ¿Qué estimador es mejor?

Índice

Conceptos básicos

Calidad

Cota de Cramer Rao

Estimador de máxima verosimilitud

Estimador bayesiano

Estimador lineal de error cuadrático medio mínimo

3. Cota de Cramer-Rao

¿Se puede conseguir siempre que la varianza de un estimador

sea tan pequeña como se quiera?

¿Hasta dónde se puede reducir la varianza de un estimador?

La varianza de un estimador es siempre mayor o igual que la

cota de Cramer-Rao (CCR)

CCR =

€

−1

∂ ln[ f (z | θ )]

E

∂ 2θ

2

(

)

=

1

∂ ln[ f (z | θ )]

E

∂θ

(

)

2

3. Cota de Cramer-Rao

Ejercicio 3 (propuesto): Supongamos que X es una va normal o

gaussiana, de la que sólo disponemos de N muestras tomadas de

forma independiente. El valor de la media es desconocido y es,

precisamente, el parámetro que nos gustaría estimar. Sabiendo que

el estimador de la media es:

calcule la CCR del estimador de dicho parámetro.

Índice

Conceptos básicos

Calidad

Cota de Cramer Rao

Estimador de máxima verosimilitud

Estimador bayesiano

Estimador lineal de error cuadrático medio mínimo

4. Estimador de Máxima Verosimilitud

Se considera una familia de funciones de densidad de

probabilidad parametrizadas, dependientes del parámetro θ

(puede extenderse fácilmente a la estimación de vectores). El

parámetro θ puede ser determinista o aleatorio.

Se conoce un vector de datos generados con un modelo

probabilístico descrito por la familia de funciones de densidad de

probabilidad parametrizadas.

El objetivo de la estima de máxima verosimilitud es encontrar un

estimador del parámetro θ, dependiente de los datos conocidos.

Conociendo un vector de datos y el modelo probabilístico

subyacente, la estima de máxima verosimilitud toma el valor del

parámetro que da lugar a la distribución con la que los datos son

más probables.

4. Estimador de Máxima Verosimilitud

A) Si el parámetro es determinista

4.Estimador de Máxima Verosimilitud

Dada la observación, zobs, el objetivo es calcular el valor del parámetro

θj para el cual la fdp alcanza el valor máximo. Ese valor es

precisamente la estima de máxima verosimilitud.

4. Estimador de Máxima Verosimilitud

Método: Para calcular el máximo de la funcion f(z|θ) se aplica el

método general para el cálculo del máximo de una función. En este

caso, la variable dependiente es el parámetro desconocido:

∂

f ( z θ )} = 0 → θ = θˆML

{

∂θ

€

2

∂ { f ( z θ )}

<

0

⇒

máximo

∂θ 2

θ =θ ML

Puede ser conveniente aplicar una función monótona para facilitar

el cálculo, teniendo en cuenta que el valor del parámetro que

maximiza la función no varía al aplicar este tipo de transformación:

€

∂

Tmono ( f ( z θ ))} = 0 → θ = θˆML

{

∂θ

4. Estimador de Máxima Verosimilitud

B) Si el parámetro es una variable aleatoria, es necesario

caracterizar de forma conjunta al parámetro y a los datos, que

tienen carácter aleatorio.

f ( z,θ ) = f ( z θ ) ⋅ f (θ )

Si se aplica la función logaritmo, que es monótona creciente:

€

ln[ f ( z,θ )] = ln[ f ( z θ )] + ln[ f (θ )]

En estos casos, es común el suponer que el parámetro tiene

distribución uniforme (p.e. la fase de una portadora se supone

con€distribución uniforme en [0,2π) ), o tiene variación lenta en θ

comparada con f(z|θ).

4. Estimador de Máxima Verosimilitud

∂

Tmono ( f ( z,θ ))} = 0 → θ = θˆML

{

∂θ

€

∂

∂

∂

ln f ( z, θ ) =

ln f z θ +

ln f (θ )

∂θ

∂θ

∂θ

[

[ ( )]

]

[

]

Suponiendo que se cumple:

∂

∂

ln f (θ ) <<

ln f z θ

∂θ

∂θ

[

€

]

[ ( )]

El estimador de Máxima Verosimilitud se obtendría a partir de:

€

∂

ln[ f ( z θ )] ≈ 0 → θ = θˆML

∂θ

4. Estimador de Máxima Verosimilitud

Ventaja

Se puede aplicar tanto para estimar parámetros

deterministas como aleatorios

Desventaja

No tiene en cuenta los criterios de calidad (sesgo,

varianza)

Solución: Estimador bayesiano

5. Estimador bayesiano

Consideramos el parámetro a estimar como una realización de

una variable aleatoria θ, de la cual se tiene cierto conocimiento

a priori, reflejado en la función de densidad de probabilidad de

dicho parámetro, f(θ)

El vector de datos observado tiene, asimismo, carácter

aleatorio, y su comportamiento probabilístico depende del

parámetro a estimar a través de f(x|θ).

La estimación bayesiana se basa en la minimización del riesgo

bayesiano, o coste medio. Es necesario, por lo tanto, definir un

coste asociado a la estima, que normalmente dependerá del

error de estimación.

5. Estimador bayesiano

Objetivo: minimizar una función de coste medio asociado al error

de estimación. En primer lugar, es necesario definir la función de

coste cuyo valor medio queremos minimizar:

C (ε ) = C ( y − y ) = C ( y, y )

ε = y − yˆ

El coste

€ medio del error de estimación es, formalmente:

€

E [C (ε )] =

+∞

∫

∫ C ( y, y ) ⋅ f ( y, x) ⋅ dx ⋅ dy

−∞ x

Es necesario conocer la f.d.p. conjunta del estimador y de los datos

€

5. Estimador bayesiano

+∞

E [C (ε )] =

∫

∫ C ( y, y ) ⋅ f ( y, x) ⋅ dx ⋅ dy

−∞ x

Problema: Es difícil conocer la f.d.p. CONJUNTA de las N+1

variables aleatorias (Y, X1, …, XN). Una solución es expresarla en

función de la f.d.p. CONDICIONAL y de la MARGINAL:

€

+∞

E [C (ε )] =

∫

∫ C ( y, y ) ⋅ f ( y x) ⋅ f (x) ⋅ dx ⋅ dy

−∞ x

+∞

E [C (ε )] =

€

C

y,

y

∫ [ ( ) ⋅ f ( y x) ⋅ dy] ⋅ f (x) ⋅ dx

∫

x −∞

=

∫

x

I ( y ) ⋅ f (x) ⋅ dx

5. Estimador bayesiano

Al ser f(x) una función no negativa, para minimizar el coste

medio, es suficiente minimizar I(ŷ).

¿Qué propiedades debe tener la función de coste?

De ser nula en el origen, es decir, el coste asociado al error

cero debe ser nulo.

Debe ser una función no negativa.

En general, conviene que sea simétrica.

Ejemplos de funciones de coste:

Valor cuadrático del error:

Valor absoluto del error:

C(y, yˆ (x)) = (y − yˆ(x))2

C(y, yˆ (x)) = y − yˆ(x)

Coste uniforme:

0 | y €

− yˆ (x) |≤ Δ / 2

C(y − y(x)) =

− yˆ (x) |> Δ / 2

1 | y €

5. Estimador Bayesiano

Estimador bayesiano de error cuadrático medio mínimo:

+∞

E [C (ε )] =

∫

x

C

y,

y

∫ [ ( ) ⋅ f ( y x) ⋅ dy] ⋅ f (x) ⋅ dx

−∞

con I ( y ) =

+∞

2

y

−

y

∫ ( ) ⋅ f ( y x) ⋅ dy

−∞

Como f(x) es una fdp (por definición, no negativa), minimizar el

coste medio es equivalente a minimizar I(ŷ(x)):

€

∞

∂

I ( y ) = 0 ⇒ yopt = ∫ y ⋅ f ( y x) ⋅ dy = E [ y x]

∂y

−∞

5. Estimador Bayesiano

yopt =

∞

∫ y ⋅ f ( y x) ⋅ dy = E [ y x]

−∞

• €

• Este estimador es difícil de obtener pues requiere conocer

f(y|x), la fdp de la variable a estimar dependiente de los datos.

Una alternativa más práctica consiste en construir un estimador

sub-óptimo que sea más fácil de calcular: por ejemplo,

obligando a que sea una combinación lineal de los datos.

6. Estimador LINEAL de error cuadrático

medio mínimo

Para evitar los problemas mencionados, se propone un estimador

que sea una combinación lineal de los datos conocidos.

N

y = ∑ ai xi

i=1

OBJETIVO: encontrar el valor de los coeficientes ai que minimizan

el error cuadrático medio:

€

2

N

∂

E y − ∑ ai xi = 0,

∂a j i=1

j = 1,2,, N ⇒

6. Estimador LINEAL de error cuadrático

medio mínimo

N

⇒ E y − ∑ ai xi x j = 0, 1 ≤ j ≤ N

i=1

y− y=ε

[ ]

E ε x j = 0, 1 ≤ j ≤ N

€

€

Rε x j = 0, 1 ≤ j ≤ N

Principio de ortogonalidad:

El error (de estimación) debe

ser ortogonal (en el sentido

estadístico) a los datos, es

decir, la correlación entre las

variables aleatorias ε y xj

debe ser nula

6. Estimador LINEAL de error cuadrático

medio mínimo

N

E y − ∑ ai xi x j = 0, 1 ≤ j ≤ N ⇒

i=1

y− y =ε

N

∑ ai E [ xi x j ] = E [ y x j ] = 0, 1 ≤ j ≤ N

€

i=1

o, equivalentemente,

N

∑€ai Rx x

i

i=1

j

= Ry x j , 1 ≤ j ≤ N

Ecuaciones

normales o de

Wiener-Hopf

6. Estimador LINEAL de error cuadrático

medio mínimo

N

∑ RX X ai = RY X ,

i

i=1

j

j

1≤ j ≤ N

Ecuaciones

normales o de

Wiener-Hopf

RX X …RX X a RYX

1 1

1 N

1

1

=

RX X …RX X a N RYX

N 1

N

N N

€

€

6. Estimador LINEAL de error cuadrático

medio mínimo

U.lizando

esta

propiedad

2

+E y

[ ] = E[ε ] [ ]

E y

2

2

y

teniendo

en

cuenta

las

ecuaciones

de

Wiener

Hopf

€

[

[

E y x j = ∑ ai E xi x j

se

llega

a

que:

€

]

N

i=1

]

1≤ j ≤ N

€

Estimador LINEAL de error cuadrático

medio mínimo

N

[ ] = E[ y ] − ∑ a E[ y x ]

E ε

2

2

i=1

i

i

R y xi

¡ Para disminuir el error de este estimador hay que

añadir datos (xi) que estén correlados con la v.a. (y) a

estimar!

Si añadimos nuevos datos ortogonales (correlación

nula), no se disminuye el€

error de estimación

Estimador LINEAL de error cuadrático

medio mínimo

Aplicación 1: Filtro de Wiener-Kolmogorov

La señal (s) y el ruido

(n) son procesos

estacionarios con

autocorrelación y

correlación cruzada

conocidas

El objetivo es calcular los

coeficientes del filtro que

estiman la “señal limpia”

El

criterio

de

diseño

es

minimizar

el

valor

cuadrá.co

medio

del

error

de

es.mación

Ello es equivalente a resolver

las ecuaciones normales

Estimador LINEAL de error cuadrático

medio mínimo

Aplicación 2: Predicción lineal

es la muestra de X cuyo valor desconocido estamos interesados en

estimar. Los datos disponibles son los p muestras anteriores

El predictor lineal de la muestra x[n] tiene la forma

y

sus

p

coeficientes

se

calculan

u.lizando

las

ecuaciones

normales,

o

lo

que

es

lo

mismo,

minimizando

el

valor

cuadrá.co

medio

del

error

de

es.mación

(predicción):