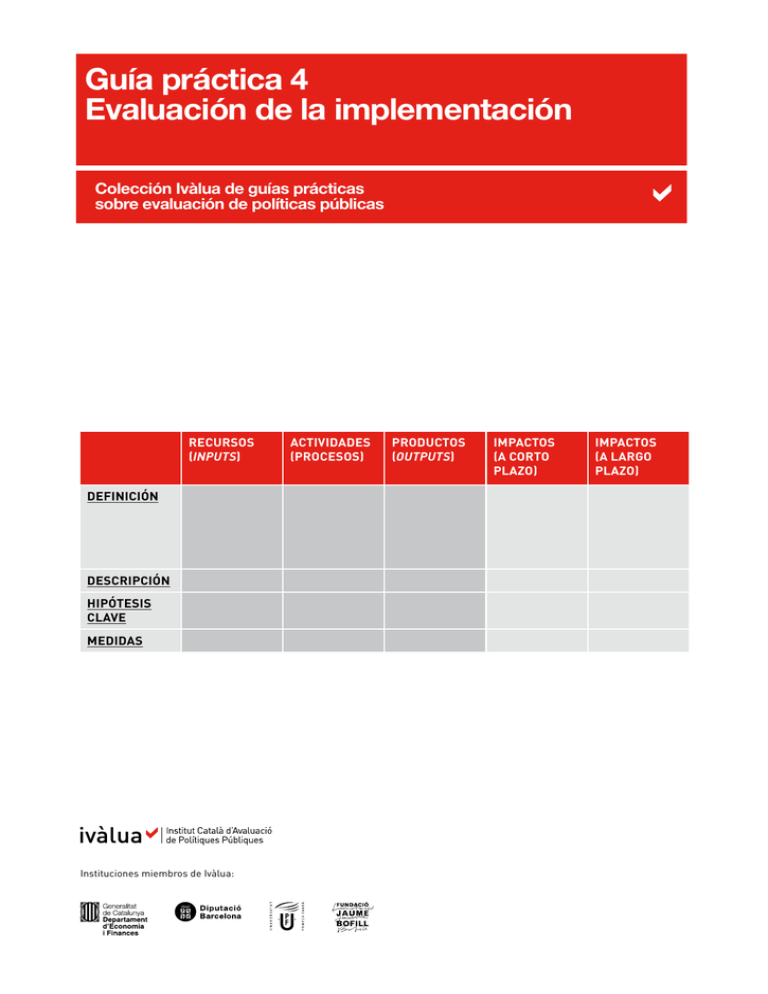

Guía práctica 4 Evaluación de la implementación

Anuncio