La mediamorfosis nunca termina A.Piscitelli _español_

Anuncio

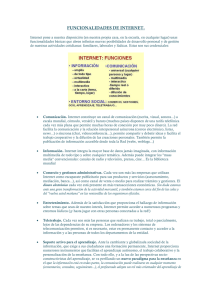

La Mediamorfosis nunca termina 1. ¿El panorama del libro es el que se resumen en los informes recibidos? Si bien la información brindada por los informes es muy parcial, y seguramente estudios mas detallados como los que hace CERLALC permitirían afinar y relativizar el análisis que se incluye a continuación mi primera reacción es de sorpresa e incredulidad frente a un futuro que se considera rosa, un escenario que se visualiza como tendencialmente "mas de lo mismo", y una certeza frente a la profesión, las prácticas de lectura y los mecanismos de socialización de la información que se consideran mas o menos "eternos" y que con leves retoques se sospecha (o mas bien imagina y desea) que no verán grandes transformaciones en el futuro cercano y de mediano plazo. El material analizado se centró en tres temáticas diferenciadas y concatenadas: a) comportamiento lector y el consumo de libros en Centroamérica; b) Percepción sobre el clima empresarial y tendencias a corto plazo; 3) Perfiles de la edición en América Latina Muchos datos del informe son interesantes (y también preocupantes para cualquier hipótesis de futuro sin sorpresa que es el que predomina en ellos). Entre ellos señalemos algunos que mas nos llamaron la atención respecto del comportamiento lector y el consumo de libros en Centroamérica - en América Latina solo un país (y son datos de 2002 que seguramente hoy no son válidos) supera el 70% de población lectora. Además la edad de mayor participación en la lectura es la de los estudiantes (14 a 25 años, algo muy importante para nuestro análisis como se vera mas abajo). - También interesa que según las encuestas el principal motivo de la lectura en AL es el entretenimiento. - Es llamativa la enorme distancia que hay de lectura promedio en España (11 libros) y en América Latina (con un promedio de 3). También que el acceso al libro sea privado y por compra - Como en otros lados el tiempo libre es utilizado (y mucho mas por los jóvenes) para ver TV y escuchar música y solo en tercer lugar x leer - Las mediciones realizadas en la región no indagan de manera directa por la lectura en otros soportes De por si el tono optimista, edulcorado y autosatisfactorio de los informes no condice con numerosos datos y con análisis de naturaleza epistemológica y de ecología de los medios acerca de la nueva dieta cognitiva de los así llamados nativos digitales, de como está variando el tipo de lector generado por la cultura interneteana, y de la profunda modificación en términos de la aparición de prosumidores y remixadores culturales (la post-producción analizada y teorizada por Nicolás Bourriaud) de una parte significativa de la población. Trabajos como los realizados por Michael Wesch y su grupo de trabajo Etnografía Digital acerca de la etnografía de Youtube ponen en cuestión muchas de las platitudes expuestas en los infomes recibidos y llevan a hacernos preguntas e imaginar escenarios muy diferenets de los sin sorpresa ahi contenidos 2.Sumando lecto/escritores a troche y moche Para relativizar la tranquilidad exhibida por esos informes (sin caer en el catastrofismos ni en las utopías anti-libro no menos ingenuas) queremos recobrar la idea de mediamorfosis (de Roger Fiedler), la certeza de la solidaridad que existe entre las transformaciones en los lenguajes, los cambios de soporte, la interdependencia entre continente y contenido. Pero lo que no hemos tratado con el debido respeto es la relación que existe entre esos medios, soportes, lenguajes o formatos expresivos y la historia concordante de distribución de los contenidos que los mismos permiten. Porque la voluntad de ampliar los receptores es consubstancial al intento de comunicarnos. Somos/fuimos muchos los que siempre queremos anoticiarnos de lo nuevo, ahora y en la época de Colon, en las Cruzadas o en el Imperio Romano y mucho mas atrás en la historia seguramente. Pero tradicionalmente hubo una enorme dificultad para llegar a la comunicación en tiempo real -algo que solo se alcanzo casi a principios del siglo XIX con la invención del telégrafo. En el comienzo fueron los manuscritos, una tarea demencial que requería de las habilidades casi sobrenaturales de los escribas, y que insumia en la época pregutenberguiana todo el año de trabajo de una persona para generar un solo ejemplar de la Biblia. Una vez terminado el volumen se necesitaba de un sistema de distribución que estaba sometido a todos los imponderables del momento, falta de caminos, velocidad de los caballos, riesgos de saqueo, dificultades para llegar a los monasterios, ausencia de sistema de clasificación, etc. Los costos de ingreso a un sistema de distribución eran tan altos que tan solo una organización casi atemporal como la Iglesia Católica podía darse el lujo de financiar tamaños emprendimientos. Aun así la distribución era tremendamente costosa y los ahorros de escala desconocidos. Si se quería llegar al doble de gente había que hacer exactamente el doble de trabajo y se debía consumir el doble de recursos. Por eso fue tan importante la imprenta, que transformó a Europa y al resto del planeta. La primera línea de montaje de la historia -como acuño memorablemente Marshall Mc Luhan - hizo posible la automatización de las copias. Comparada con los manuscritos, la imprenta bajaba costos y aseguraba la noreplicacion de errores. Sin embargo las primeras imprentas eran caras, difíciles de construir y sus insumos (incluyendo al papel y la tinta) implicaban costos variables significativos. En esa época la impresión no era tarea para PYMES y solo las grandes empresas podían afrontar los costos de escala que este trabajo suponía -algo que solo vario recientemente, primero con la introducción de la composición en frío, y mas recientemente con la impresora láser en 1986 Mas tarde la radio y la televisión emergieron como nuevos mecanismos de irradiación. Por primera vez el consumo de recursos no fue linealmente proporcional al publico al que se querría llegar. Las antenas emisoras usan una cantidad finita y constante de energía independientemente de la variación en la cantidad de receptores. Pero también aquí hay un factor de escala, porque el consumo del recurso es equivalente al tamaño de la tarea a la que se quiere llegar. Para alcanzar objetivos mas amplios hace fácil invertir mas recursos. Sin contar que obtener el equipamiento y la licencia original era costosisimo y de vuelta solo accesible a unos pocos ricos y poderosos. 3. El tiempo de Internet Después vino el tiempo de Internet que trajo como novedad la comunicación punto a punto a costos bajisimos y sin necesidad de licencia alguna. Salvo.. .que para usar la red hacian falta maquinas, y hasta hace pocos años atrás, éstas eran carisimas, difíciles de manejar y terriblemente arduas en cuanto a su configuracion. Fue entonces que se invento la web y simultáneamente (en una operación de causalidad mutua magistral y oportuna) los precios de las maquinas cayeron significativamente -aunque no tanto como seria menester, ya que una computadora para ser verdaderamente masiva no debía acostar mas que un televisor (100 dólares aproximadamente). Como esto paso ayer nomás (1991/3) muchos de nosotros tenemos en nuestras manos los testimonios de esa época en donde la Web era aclamada como la revolución en la comunicación. Y de hecho lo fue mas que ningún otro medio previamente. Cualquiera podía publicar cualquier cosa, y cualquiera podía leer cualquier cosa. Aparentemente las barreras que impedían una circulación masiva de los mensajes, y una distribución auténticamente global parecian haber desaparecido como por arte de magia. Pero a lo mejor aquí había algún espejismo. Porque si bien durante todos estos años cualquiera en principio podía publicar cualquier cosa que cualquiera otra persona podía también potencialmente acceder- siempre fue bastante mas dudoso que alguien pudiera publicar algo y que todos lo pudieran ver (a excepción de columnas sindicadas de periodistas hiperfamosos) Pero aun así eso de publicar de unos a muchos empezó a depender de factores totalmente externos. como la nunca tan bien ponderada y siempre necssito ancho de banda. 4. Los métodos tradicionales, de distribución, no alcanzan Tomemos un caso mas que emblemático que demuestra la debilidad de los métodos tradicionales para llegar a una distribucion masiva de contenidos ocurrido hace un par de años atras. Debo tener mas de cuarente grupos de trabajo en Yahoo. Contento con ello mande un pundonoroso Power Point de 1.2Mb y me fue devuelto por el señor Yahoo quien soberbio me dijo, que no se permite enviar a una lista archivos que tengan mas de 1 Mb. O sea que lo libre no es tan libre. Lo mismo pasa con el almacenamiento en disco. Si 20Mb o 100 Mb parecen ser importantes para una lista, en el caso de la que tenemos en la Catedra de Procesamiento de Datos en nuestra materia en la UBA que despacha centenares de mails mensuales, hace rato que deberíamos estar subiendo y bajando archivos si no hubiésemos encontrado la alternativa del weblog -que por otro lado no distribuye información sino que la fija en un solo espacio -siendo la posibilidad de la sindicacion poco útil hasta ahora -también por limitaciones técnicas. Claro que existen espacios de almacenamiento ilimitados (aunque su confiabilidad no es de las mejores), pero son cada vez mas costosos e inexplicablemente- tienden a aumentar exponencialmente a medida que se sobrepasan los limites inferiores. Lo que vuelve impensable imaginar un sitio que podría ser (como los diarios mas visitados de la Argentina Clarín o La Nacion) visitado por centenares de miles de personas diariamente, y mucho menos por millones como sucede con algunos sitios como Yahoo, MSn, Amazon, Google, etc. Pero tan o mas complejo que esto fue hasta hace muy poco poder poner las propias ideas, impresiones o ilusiones en la red. Ni siquiera para aquellos que tenemos direcciones de e-mail que datan de una o dos décadas atrás esa tarea se nos hacia fácil. Es cierto que aparecieron programas que supuestamente deberían simplificar nuestras tareas de legos como Frontpage o PageMill, pero el resultado era pobre, y la posibilidad de actualizar la información una vez subida a la red, realmente dantesca. Como siempre los poderosos podrían pagar el ancho de banda que fuera necesario (en una época tener una T1 (1.44 Mb/s) era el sueño de todo nuevo rico, hoy conozco organizaciones en México por ejemplo que disponen de 4 OC3 o sea de cerca de 622Mb y en Corea los 2 Gb se consiguen en las casas departamentos nuevos). Además poseyendo legiones de expertos se pueden armar los sitios mas sofisticados y entrelazados entre si que quieran, sin ningún problema Para paliar esas limitaciones, con vistas a hacer de la debilidad una fuerza, se inventaron los sistemas de archivos compartidos par a par que hicieron trizas muchas de las limitaciones anteriores, cuando de compartir archivos de tamaño significativo se trataba. Lamentablemente los sistemas P2P apuntaban tan solo a la búsqueda y tenían por objeto bajar los archivos de modo tal que no estaba muy encausados a la distribución deliberada de contenido. Al revés, las grandes empresas y compañías no tenían el mas mínimo interés en que este tipo de tecnología se desarrollase o tomara estado publico y, menos aun, que fuera apropiada por el comun de los mortales. De allí los ingentes esfuerzos que se realizaron para matar al bebe en la cuna. Aunque hubo algunos esfuerzos como Freenet (un sistema gratuito que permite publicar y obtener información en la red sin miedo a la censura ya que la red es totalmente decentralizada y tanto los editores como los lectores se reflejan en ella como anónimos), se trata de un sistema bastante complejo y difícil de usar. Convertirnos en Clarín -como imaginábamos al principio de la aparición de nuestro News- estaba totalmente fuera de nuestro alcance 5. La invención de los weblogs Por eso nos alegro sobremanera -aunque nunca hicimos el traspaso propiamente dicho- la invención de los weblogs, que por fin removieron las barreras técnicas a la publicación para cantidades impresionantes depersonas. Desde que existen los weblogs somos nuestros propios contenidistas, editores, soportes técnicos, diseñadores, etc. -con mayor o menor fortuna. Sin embargo las limitaciones del ancho de banda siguen estando allí, y por eso -a excepción de un puñado de best-sellers bien posicionados- el resto de los weblogs tiene el status de un periódico de provincia de segunda o de tercera, mas emparentados con los usos escolares que con los profesionales -sin animo de ofender a nadie, aunque probablemente haciendolo con todos. La invención de los weblogs no subsano el problema básico que consiste en poder distribuir magnitudes significativas de contenido (por ejemplo la totalidad de un diario, una biblioteca digital sobre un tema, o un producto multimedio empaquetado) en escala masiva. Si lo que queremos es distribuir ese tipo de información (infografias, animaciones, didáctica gráfica, etc) tal terreno sigue estando minado y al mismo solo acceden proveedores de contenido multimedia como son CNN, la BBC, Clarín o La Nación. Es impensable para juniors como nosotros disponer de nuestros propios programa de radio o de TV, y mucho menos aun poseer canales o radios nacionales. Aunque tengamos una impresora láser no controlamos el sistema de distribución (øacaso un compañero de trabajo nuestro no sacaba una revista de calidad profesional y la hacia llegar personalmente con un carrito a los puestos Florida apena s unos meses atrás?). Es aquí donde entra una nueva pieza de software que pudiera tener consecuencias duraderas tal como acontecio hace poco con la web, el par a par y los weblogs. Se trata de un nuevo tipo de software del cual konspire2b es un buen ejemplo. Se trata de herramientas que permiten distribuir contenido de alta calidad. 5. Weblogs de ancho de banda ilimitada Al principio no resulta fácil darse cuenta en que consiste exactamente konspire o los programas de la misma familia. Una definición muy rápida los caracteriza como weblogs de ancho de banda ilimitada. Porque convengamos que lo que se puede almacenar en un weblog, aunque es potencialmente infinito (ya hemos hecho pruebas de streaming de video en nuestros pequeños emprendimientos), en la practica está enormemente comprometido por la limitaciones de almacenamiento y costos de irradiación. Konspire se parece a un weblog en el sentido de que se lo puede utilizar para “postear” contenido nuevo a un grupo de lectores. Pero al poder irradiar a otros sitios cantidades ingentes de información en vez de dejar ver tan solo la imagen del día, en principio hace posible diseminar la cola de la película de un día o la distribución gnu/linux del día. El gran aporte de este tipo de sistemas es indudablemente el levantamiento del restricción que imponia el costo del almacenamiento. Como el programa usa ademas una interfaz web se pueden poner comentarios en html para describir cada mensaje irradiado, así como establecer links a información relevante en la red. Además la cara de la interfaz de recepción de konspire se parece muchisimo a un weblog. He aquí pues convertido en realidad un anhelo y una promesa que hace años que acosa a la web. Se trata del supuesto teóricamente cierto pero prácticamente inalcanzado hasta ahora, de que un sitio web podría convertirse ipso facto en un canal multimedia que llega al gran publico. Para que ello suceda los destinatarios (redistribuidores de señales) deben estar sintonizados y haberse suscrito previamente. Sin embargo no es necesario que los receptores finales estén conectados en el momento de la emisión. Por eso alguien dijo acertadamente que este sistema se parece mucho mas a TiVo (ese disco duro gigantesco que almacena mas de 12 horas de television= que a una transmision regular por aire o por cable. 6. Sistemas de irradiación de costo casi nulo La diferencia obvia entre la radio y la TV tradicionales (y mucho mas aun con la DAB y la HDTV que están llegando) es que mientras que sistemas con ese poder de irradiación son carisimos en el mundo real, en Internet se trata de un software libre. Operativamente konspire trabaja como una de esas (detestables) cartas en cadena, aunque esta vez con el marketing de permiso (y no el de no intromisión como es el caso de esas cartas) a su favor. Todos los que periodicamente recibimos ese espanto sabemos muy bien como funcionan. Alguien recibe una carta y reenvía copia de la misma a un puñado de amigos, estos hacen lo propio y eventualmente las cartas deberían llegar al resto del mundo (yo debo ser un incordio para ese sistema porque jamás devolví una ni en papel y mucho menos en la red). Sin embargo si quisiéramos mandar una carta a 100 amigos el método no estaría nada mal. Porque en vez de tipear 100 veces la carta y de mandarla nosotros mismos, podríamos dividir el peso entre una cadena de amigos, enviando solo 5 y ellos a otros 5 hasta alcanzar la cifra de los 100 que originalmente queríamos alcanzar. Konspire trabaja de este modo con una precaución que será mas que bienvenida por todos. Especialmente los que odiamos esas cartas embusteras. El programa usa firmas digitales lo que permite asegurarle a cualquiera de los que reenvien las cartas que el emisor es el que dice ser y no corremos el riesgo de ser embaucados como novicias. Lo anticipamos mas arriba, konspire no cayo del cielo como una bendición, sino que pertenece a la familia de los sistema par-a-par. Por eso comparte con Gnutella, y otros sistemas similares (como, KaZaA), búsquedas masivas a través de una red de nodos. Los nodos que poseen archivos que responden adecuadamente a los criterios de búsqueda las rerutean al nodo que las está buscando. En terminología/bableta informática los data sinks (downloaders) buscan fuentes de datos (nodos con archivos) mandando queries. Según sus hacedores konspire2b es un “Gnutella que corre al revés”: las fuente de datos buscan activamente piletas para sus archivos. En vez de enviar pedidos de búsqueda, las fuentes irradian anuncios de contenidos, y los nodos que quieren el contenido devuelven a las fuentes las respuestas. Dado que la distribución está del lado de la fuente, y no hay modo en que los receptores la activen, es fácil controlar el flujo e impedir todo tipo de spamming. Una de las limitaciones notorias de konspire es que los receptores solo pueden recibir lo que les envían las fuentes. De este modo lo bueno del sistema es que puede actualizar permanentemente lo novedoso, pero no resulta bueno para almacenar lo ya recibido -de allí que se sea complementario con Gnutella o los weblogs y no sirve empero para reemplazarlos. Viendo las ventajas/desventajas de sistemas como Freenet respecto de Konspire queda claro que el fuerte de este ultimo esta en la distribución en el día uno de archivos muy buscados, que perderán actualidad al día siguiente. Resumiendo como cada vez que aparece un sistema nuevo de distribución sus dueños creen haber redescubierto la imprenta. A lo mejor no es tan así pero seguramente este mecanismo puede traer cola y aunque todavía no le vemos demasiado los usos ni académicos, ni comerciales, por ahí los debe tener. Mientras investiguemos mas la cosa. 7. Archivos OPML, Google y lo que vendrá Por distintos motivos sistema scomo los anteriores no se difundieron con la fuerza y la energía que creíamos pero en direcciones similares s aparecieron los lectores de feeds capaces de leer centenares de weblogs en tiempo practicamente nulo. Hoy en día la mas poderosa herramienta de información y transmisión de datos provenientes de los weblogs (hay censados mas de 100 millones en el mundo) son los lectores de feeds (yo uso en mac en el netnewswire) y la información que recibimos por este canal no son meramente noticias sino también reflexiones provenientes de sitios de libros de autores cada vez mas sofisticados y renombrados en el mundo en papel y on line en un hibridaje magistral. Por otra parte es inimaginable adentrarnos en el mundo del futuro de la edición (y de la circulación de libros y del reformateo de lectores sin seguir cuidadosamente lo que viene haciendo Google en los últimos 4 años, por lo que supone de amenaza y de reinvención de la industria. Este tipo de preocupaciones (que para nuestra region muchas veces pueden parecer utopias o ciencia-ficcion) son las que vemos ausentes en los planteos recibidos. Tambien nos sorprende la ausencia de reflexion psicosociologicas acerca de las matrices de lectura de los adolescenets digitales, de los cambios en la forma de leer que paso de ser de en profundida a lectura mosaico o de navegacion textual (simulando la red), asi como de la insatisfaccion que muchos de estos jovens experimentan ante la simulacion curricular que la escuela les brinda hoy. A continuacion algunas referencias a articulos en la web x profundizar en el tema http://www.filosofitis.com.ar/2008/07/02/los-barbaros-de-google-educando-con-sentidoa-la-generacion-einstein-primera-parte/ http://www.filosofitis.com.ar/2008/07/08/los-barbaros-de-google-educando-con-sentidoa-la-generacion-einstein-segunda-parte/ http://www.filosofitis.com.ar/2008/06/23/la-estupidizacion-de-las-multitudes-el-dia-quepedro-barcia-se-agencio-de-un-aliado-de-ley-sin-saberlo/ http://www.filosofitis.com.ar/2008/01/21/si-no-hablamos-de-nativos-digitales-¿dequienes-estamos-hablando/