LHC: Gran Colisionador de Hadrones

Anuncio

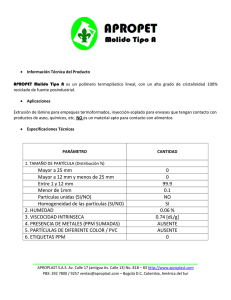

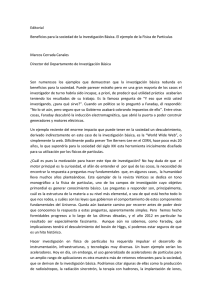

AUTORES CIENTÍFICO-TÉCNICOS Y ACADÉMICOS LHC: Gran Colisionador de Hadrones Antonio Rincón Córcoles Para apuntar a los fragmentos más pequeños del Universo ha sido preciso construir la mayor máquina de la Tierra. The Guardian, diario británico E l 20 de noviembre de 2009, la comunidad científica internacional celebró con alborozo la puesta en marcha de uno de sus proyectos más preciados. El Gran Colisionador de Hadrones, también conocido por sus siglas inglesas LHC (Large Hadron Collider), comenzó a registrar los primeros choques entre protones de altísima velocidad, esas partículas elementales que anidan comúnmente en el centro de los átomos. Muchas son las esperanzas que se han depositado en la capacidad de este acelerador de partículas para extender las fronteras del conocimiento de la ciencia. Y no menores han sido las controversias suscitadas por el enorme desembolso económico que supone y por la posibilidad de que sus experimentos produzcan consecuencias inesperadas. ¿Qué estímulo ha llevado a la construcción de un proyecto cuyo presupuesto inicial ascendía nada menos que a 7.500 millones de euros? La Organización Europea para la Investigación Nuclear, institución que lo patrocina y más conocida por sus antiguas siglas, CERN, el principal laboratorio de investigación del mundo en física de partículas, tiene sobrados motivos para impulsar la empresa. Tras un esfuerzo de décadas por componer un modelo básico del funcionamiento del mundo físico, los científicos han llegado a una conclusión clara: en nuestro ámbito cotidiano, nos movemos en un entorno de bajas energías que limita nuestra aptitud para investigar y comprender la esencia del universo y de la realidad física. Es preciso elevar al máximo las energías de trabajo de los experimentos para descubrir fenómenos nuevos y para someter a pruebas definitivas las mejores teorías científicas vigentes de que se dispone. 9 ACTA LHC: Gran Colisionador de Hadrones Para este fin se construyen los aceleradores de partículas. Estas máquinas existen desde la década de 1930 y se han construido con una potencia creciente de funcionamiento. En esencia, utilizan campos electromagnéticos de alta intensidad para proyectar partículas cargadas (electrones, protones, núcleos atómicos) a velocidades elevadísimas. En el LHC, el último representante de esta saga, los protones serán acelerados hasta una velocidad del 99,99% de la de la luz. La teoría de la relatividad y la mecánica cuántica han sido inspiradoras y objeto de estos experimentos. La investigación en los laboratorios de partículas de alta energía ha sustentado un extraordinario avance de la ciencia y la tecnología durante el siglo XX. Ha permitido además componer un mapa creíble de la composición de la materia, de las interacciones que rigen los fenómenos que observamos en la naturaleza. Este mapa ha sido denominado modelo estándar de la física de partículas. Relatividad, cuántica y modelo estándar son los tres pilares en los que se asienta la ciencia básica actual. Sus preceptos y predicciones han sido convalidados en multitud de experimentos de notable precisión que les otorgan verosimilitud y un gran valor para el progreso tecnocientífico. Pero el mapa que componen no está completo. En ocasiones resulta ambiguo e incluso contradictorio. Deja entrever espacios de terra incognita que alientan la propuesta de soluciones aventuradas y especulativas por parte de los científicos más osados. En definitiva, no satisface plenamente el ansia intelectual de sus descubridores. El LHC es la herramienta más poderosa con que se cuenta en la busca de este conocimiento. Más de diez mil científicos e ingenieros de un centenar de países trabajan en él. Cientos de universidades y laboratorios de todo el mundo realizan en paralelo investigaciones situadas dentro de su ámbito. Todo con la perspectiva de encontrar una respuesta para las preguntas pendientes de la física, de componer el puzzle definitivo del modelo de partículas y promover así una nueva era del desarrollo científico y tecnológico y del progreso social. à El modelo estándar de partículas La física contemporánea describe la naturaleza como un entorno definido por la interacción de cuatro fuerzas y doce partículas elementales de materia. Dos de las fuerzas son muy conocidas para los legos en el asunto: la gravitación que nos aferra al suelo y que dibuja los movimientos de los objetos celestes, 10 desde las galaxias a los planetas; y el electromagnetismo, que gobierna los fenómenos eléctricos y magnéticos tan utilizados en las tecnologías actuales y que da consistencia y estabilidad a los átomos. Las otras dos fuerzas fundamentales actúan predominantemente en la escala subatómica. La interacción fuerte cohesiona las partículas que están presentes en los núcleos de los átomos. La fuerza nuclear débil da cuenta de ciertos fenómenos subatómicos de gran trascendencia, como es la desintegración beta que marca las pautas del intercambio entre protones y neutrones. El estudio de la gravitación es objeto de la teoría de la relatividad general postulada por Albert Einstein en la década de 1910. La descripción de las otras tres fuerzas fundamentales entra dentro del marco del modelo estándar de partículas. Interacción Partícula mediadora Electromagnética Fotón Nuclear fuerte Gluón Nuclear débil Bosón W, Z Gravitatoria Gravitón Tabla 1. Las cuatro fuerzas fundamentales de la naturaleza y sus partículas mediadoras. Este modelo propugna asimismo la existencia de doce tipos de partículas elementales de materia. Las doce partículas se agrupan en tres grandes familias o generaciones, que presentan grandes semejanzas entre sí y que se diferencian básicamente por la magnitud de su masa. La familia más modesta y asequible es la del electrón, tipo de partícula que circula en la corteza exterior de los átomos y cuya carga negativa se toma como unidad mínima natural. A la familia del electrón pertenecen el neutrino electrónico, de carga eléctrica nula, y dos clases de quarks (up, o arriba, y down, o abajo), integrantes de las partículas presentes en los núcleos atómicos y que se caracterizan por poseer una carga eléctrica fraccionaria. Según los experimentos realizados en aceleradores de partículas, los quarks no pueden existir como partículas libres más allá de un periodo de 10-24 segundos. Por ello se unen unos con otros para formar partículas compuestas como los protones y los neutrones. Históricamente, el descubrimiento de la composición de la materia siguió un orden distinto al indicado. Tras largos siglos de ciencia en los que se creía que la materia era un ente continuo, durante el siglo XIX se extendió la convicción de que está compuesta LHC: Gran Colisionador de Hadrones por entidades mínimas a las que se llamó átomos. Actualmente se conoce la existencia de más de un centenar de clases distintas de átomos, desde el hidrógeno y el helio al plomo, el hierro y el oro, el radio y el uranio, el nobelio y el laurencio. Generación En las primeras décadas del siglo XX se propuso un modelo de átomo construido a semejanza de un sistema solar en miniatura: en el centro se ubicaría el núcleo, integrado por un conglomerado de partículas de carga eléctrica positiva (protones) y neutra (neutrones). Alrededor del núcleo atómico circularían los electrones en órbitas de mayor o menor estabilidad. 2 La realidad descubierta en los años siguientes demostró ser mucho más compleja. Los electrones no ocupan órbitas, sino regiones de probabilidad denominadas orbitales. Las partículas presentes en los núcleos no son elementales, sino que están compuestas por otros corpúsculos. El protón es un conglomerado de tres quarks: dos up o arriba y uno down o abajo. Un neutrón está compuesto por dos quarks down y uno up. La estabilidad de los protones y los neutrones está garantizada por la acción de la fuerza nuclear fuerte, a la que se asocia una partícula mensajera o intermediaria: el gluón (de glue, pegar en inglés). Con estos datos se llegó a completar la primera generación de partículas elementales: electrón, neutrino electrónico y quarks up y down. La colección se enriquece con la presencia de las correspondientes antipartículas: el positrón o antielectrón es formalmente idéntico al electrón, aunque tiene carga eléctrica positiva en lugar de negativa. De forma análoga, existen antineutrinos electrónicos y antiquarks up y down. La segunda familia de partículas elementales tiene como base el muón, que es una especie de hermano mayor del electrón. Se distingue por poseer propiedades muy semejantes a él, aunque una masa unas 200 veces mayor. La cohorte del muón, detectado en fuentes de alta energía como los rayos cósmicos, se completa con el neutrino muónico y los quarks charm (encanto) y strange (extrañeza), además de sus correspondientes antipartículas. Hipotéticamente, sería posible formar átomos con combinaciones de estas partículas pesadas, aunque resultarían altamente inestables. Por último, el tauón o partícula tau es el protagonista de la tercera generación, superpesada, de partículas. Sus parientes son el neutrino tauónico y los quarks top (cima) y bottom (fondo). Estas partículas se han detectado también en fuentes cósmicas de alta energía. 1 3 Partículas Electrón Quark arriba (up) Neutrino electrónico Quark abajo (down) Muón Quark encanto (charm) Neutrino muónico Quark extrañeza (strange) Partícula tau Quark cima (top) Neutrino tauónico Quark fondo (bottom) Leptones Hadrones Tabla 2. Según el modelo estándar, existen tres familias o generaciones de partículas elementales. Electrón, muón y tauón, con sus neutrinos y antipartículas, se llaman leptones, porque no se ven afectados por la fuerza nuclear fuerte. Los seis tipos de quarks, y sus antiquarks, son hadrones, cuyo movimiento está regido por la interacción fuerte. Las partículas de este modelo están definidas por tres propiedades: carga, masa y espín. Electrón, muón y tauón tienen carga eléctrica 1. Sus antipartículas respectivas poseen carga eléctrica +1. Los neutrinos carecen de carga, mientras que a los quarks se les asigna una carga fraccionaria: +2/3 para los quarks up, charm y top y 1/3 para los quarks down, strange y bottom (con signo contrario en sus antiquarks respectivos). La carga eléctrica determina la naturaleza de las interacciones electromagnéticas y provoca, por ejemplo, que los electrones (negativos) sean atraídos a los átomos por los núcleos atómicos (de carga neta positiva). La masa es una noción asimilada a la materia desde antiguo y se relaciona con el movimiento y con la gravitación. Sin embargo, aunque conocida cotidianamente, para la física teórica constituye un enigma cuya solución espera alcanzarse con los experimentos del LHC. Por último, el espín es un concepto importante para la descripción de los estados cuánticos de las partículas y los núcleos atómicos y se relaciona clásicamente con el momento angular o de giro de las partículas. Puede tomar valores enteros (en cuyo caso las partículas asociadas se denominan bosones) o semienteros (en los fermiones, como el electrón). Estas son, a grandes rasgos, las características y descripciones esquemáticas del modelo estándar de partículas. Aunque razonablemente acorde con los experimentos, este modelo presenta algunos puntos débiles y oscuros a los que se ha intentado dar respuesta con ideas atrevidas e innovadoras. Una de ellas, el denominado mecanismo de Higgs, que pretende explicar el significado de la masa, es objeto directo de investigación en los experimentos del LHC y su comprobación, o falsación, pondrá a prueba la validez de todo el entramado. 11 ACTA à LHC: Gran Colisionador de Hadrones Las preguntas pendientes La misión declarada del LHC es convalidar o refutar las afirmaciones más controvertidas del modelo estándar de partículas. Se acompaña asimismo de otros proyectos de gran envergadura cuyo estudio se sitúa en la frontera última de los desarrollos actuales de la ciencia. ¿Existen en torno nuestro dimensiones ocultas que no somos capaces de percibir? ¿A qué se debe el sesgo de presencia de materia, frente a la antimateria, que ha hecho posible nuestro mundo? ¿De qué están hechas las misteriosas materia y energía oscuras que, según la cosmología más avanzada, componen más del 95% del universo? La descripción técnica del LHC ayuda a hacerse idea de la enorme ambición de la empresa científica impulsada por el CERN. El Gran Colisionador de Hadrones, el mayor acelerador de partículas construido en la historia, es un inmenso laboratorio extendido a lo largo de un túnel de 26.659 metros de circunferencia, situado bajo tierra en la frontera franco-suiza cercana a la ciudad de Ginebra. El túnel, que había sido construido previamente para albergar a un anterior acelerador de partículas del CERN, alcanza en sus puntos más bajos hasta 175 metros de profundidad y en él las colisiones entre haces de partículas alcanzarán una energía de 7 teraelectrón-voltios (TeV), aproximadamente 1,12 microjulios (µJ), por partícula. El LHC contiene 9.300 imanes que han de enfriarse previamente a su entrada en funcionamiento a unos 193 °C bajo cero con la ayuda de 10.000 toneladas de nitrógeno líquido. Posteriormente, la temperatura de los imanes debe descender hasta unos 271 °C bajo cero con ayuda de unas sesenta toneladas de helio líquido. En su fase de pleno funcionamiento transitarán por el sistema billones de protones que recorrerán el anillo del LHC más de 11.000 veces por segundo, al 99,99% de la velocidad de la luz. El número de colisiones por segundo se acercará a unos 600 millones. Cabe imaginar la potencia de cálculo de los superordenadores necesarios para procesar toda esta información. Unos diez mil científicos, algunos de los mejores talentos del mundo, de un centenar de nacionalidades trabajan en sus experimentos. Varios miles más desarrollan proyectos asociados en laboratorios de todo el planeta. Cabe imaginar la decepción que sufrieron cuando las primeras pruebas del acelerador fallaron en septiembre de 2008. Una importante avería entre dos imanes superconductores produjo un 12 retraso de catorce meses en la inauguración del LHC. Hoy funciona a buen rendimiento y acoge experimentos cuyos resultados serán base de estudios y esperados avances en los años venideros. El problema de la masa El inglés Isaac Newton (1643-1727) es considerado por muchos el más influyente científico de la historia. A él se deben dos obras fundamentales, que sentaron las bases de la mecánica y la óptica, el estudio de la luz. Describió la gravedad como un fenómeno universal que afecta por igual a los astros del firmamento y a los objetos de la superficie terrestre. Como una fuerza de atracción entre los cuerpos que es directamente proporcional a sus masas respectivas e inversamente proporcional al cuadrado de la distancia que los separa. La idea de gravedad fue refinada con extrema elegancia por Albert Einstein con su teoría de la relatividad general enunciada en 1915. Después de establecer la equivalencia entre masa y energía mediante su célebre fórmula E = mc2 (la energía es igual al producto de la masa por la velocidad de la luz elevada al cuadrado), explicó la gravedad como una deformación del espacio-tiempo provocada por la presencia de los cuerpos dotados de masa-energía. La curvatura resultante en el espacio-tiempo obliga a los cuerpos masivos próximos a seguir trayectorias curvas como hacen, por ejemplo, los planetas en sus órbitas alrededor del Sol. En ambas proposiciones, la teoría de Newton y su ampliación según la relatividad general, aparece la masa como una magnitud fundamental. Asimismo, la masa es uno de los valores básicos de las partículas elementales, uno de los descriptores de su comportamiento. Todos los electrones poseen la misma masa, determinada aproximadamente como 9,019 x 10-31 kilogramos. La masa de los protones es superior en cuatro órdenes de magnitud, de 1,672 x 10-27 kg. No obstante, la inmensa mayoría de este valor corresponde a la energía cinética de movimiento de los quarks up y down que los componen; la masa en reposo de los quarks individuales es comparable a la minúscula del electrón. Una de las debilidades del modelo estándar proviene de la necesidad de asignar valores empíricos a las masas en reposo de las doce partículas elementales. Valores como los expresados en el párrafo anterior distan llamativamente de la elegancia y sencillez de los que se asignan a las otras dos cualidades básicas de dichas partículas: la carga eléctrica y el espín. LHC: Gran Colisionador de Hadrones La masa aparece como una propiedad enigmática, cuyos efectos son fáciles de percibir en el mundo macroscópico, por ejemplo, como una medida de la oposición que presentan los cuerpos a ponerse en movimiento. Pero su origen y esencia íntima resultan desconocidos según las bases de la teoría. En el contexto del modelo estándar se ha apuntado una idea que podría explicar la procedencia de la masa de las partículas. Se denomina mecanismo de Higgs y preconiza la existencia de una partícula aún no descubierta, que ha sido bautizada con el nombre de bosón de Higgs. Este bosón se entiende como un ente surgido de la excitación del vacío ante la presencia de un campo de su mismo nombre. Su búsqueda constituye uno de los objetivos principales del LHC, dado que se estima que esta partícula estaría al alcance de los experimentos para los rangos de energías y temperaturas manejados en este acelerador. El mecanismo en cuestión fue propuesto por primera vez en 1964 por Robert Brout y Francois Englert, aunque Peter Higgs trabajaba de forma contemporánea en un desarrollo similar. Así, este físico teórico inglés fue agraciado con el nombre del supuesto bosón implicado cuando otro puñado de investigadores habrían sido igualmente merecedores del honor. Sea como fuere, la idea parte de la conjetura de que el espacio en el que acontecen los fenómenos subatómicos está impregnado de un campo cuántico especial, que se ha dado en llamar campo de Higgs. La relación de cada partícula elemental con ese campo provoca la aparición de su masa en reposo, según un mecanismo que genera el valor concreto para esta magnitud medido en los laboratorios. La propuesta del campo de Higgs fue necesaria para solventar un problema de inconsistencia del modelo estándar. En ausencia de este campo, para que el modelo fuera consistente todas las partículas habrían de moverse a la velocidad de la luz. Pero esto sucede tan sólo para los fotones, las partículas sin masa mediadoras del electromagnetismo consideradas como cuantos de luz. El campo de Higgs, a modo de un espacio de barro cuántico con el que ha sido comparado, actuaría para frenar a las demás partículas hasta velocidades sublumínicas acordes con los valores de sus masas en reposo. A las partículas más masivas les costaría más recorrer el espacio por el efecto del farragoso campo de Higgs. La coherencia matemática del modelo estándar, que comprende el concepto de campo y mecanismo de Higgs, sólo es posible si se le asocia una partícula, hasta ahora hipotética, de espín entero: el bosón de Higgs. El valor mínimo estimado de masa-energía del bosón de Higgs se sitúa en el orden de 100 gigaelectrón-voltios (GeV), en el límite superior del alcance de los aceleradores de partículas anteriores al LHC. Algunos de estos aceleradores han mostrado atisbos de fenómenos que podrían apuntar a la detección del anhelado bosón. Como estos órdenes de energía se sitúan ampliamente dentro del margen de trabajo del LHC, es de esperar que este acelerador aporte una respuesta al enigma. Así pues, si el LHC demostrara la existencia del bosón de Higgs y la validez del mecanismo asociado de formación de la masa, daría un espaldarazo extraordinario al modelo estándar de partículas. En caso contrario, indicaría que algo importante no funciona, abriría nuevas líneas de investigación y serviría para extender hacia el futuro los horizontes de la ciencia. Una cuestión de simetría El modelo estándar propone que a cada una de las doce partículas elementales de materia existentes le corresponde una antipartícula, que comparte todas sus características (masa y espín) salvo el signo de la carga eléctrica, que es el opuesto. Existen así antielectrones (o positrones, que son electrones positivos), antiquarks, antimuones, antineutrinos, etc. Tales partículas han sido detectadas fugazmente en los experimentos. La razón de lo efímero de su naturaleza es fácil de comprender: cuando una antipartícula se topa con su partícula, ambas chocan entre sí para aniquilarse y producir otras partículas. Por ejemplo, un positrón creado en un laboratorio de partículas encontrará pronto un electrón en su camino. Ambos colisionarán y se generarán dos fotones. Los escritores de ciencia-ficción, y los propios científicos, han fantaseado en torno a la posibilidad de descubrir regiones de antimateria, formadas por antinúcleos atómicos de antiprotones y antineutrones con positrones ligados para formar antiátomos. Teóricamente sería posible. Pero no se han detectado en la naturaleza por la rapidísima aniquilación de los pares de partículas-antipartículas, que haría tales estructuras extremadamente inestables. Debe quedar claro que la existencia de la antimateria no es una hipótesis, sino una realidad contrastada en los experimentos. Según los postulados de la mecánica cuántica, del vacío cuántico brotan espontáneamente pares de partículas-antipartículas de vida muy corta, pero con interesantes connotaciones para la física y para la cosmología. 13 ACTA LHC: Gran Colisionador de Hadrones Ahora bien, en este contexto surge una pregunta: ¿por qué vivimos en un mundo de materia que excluye la antimateria, cuando no se conocen motivos fundados que eviten que ambas clases sean igualmente probables? La cosmología propone que, durante los primeros instantes del big bang, la mayoría de la materia-antimateria se aniquiló por los mecanismos explicados anteriormente, aunque quedó un residuo material que dio origen a las estructuras (núcleos atómicos, átomos, estrellas, galaxias) que observamos en el cosmos. Ello implica que, desde un principio, existió un ligero excedente de materia que desequilibró la balanza. ¿A qué se debe este sesgo, esta asimetría en las condiciones iniciales del universo? En una aproximación imaginativa al problema, Richard Feynman explicó las antipartículas como partículas que recorren el tiempo en sentido inverso. Es decir, un positrón podría entenderse como un electrón viajando hacia el pasado. Los planteamientos de este tipo se encuadran dentro de conceptos más complejos manejados cotidianamente por los físicos dentro del dominio de las simetrías. El modelo estándar de partículas define tres clases de simetrías naturales según las cuales, si se cumplieran, el universo que percibimos sería para nosotros indistinguible de otro en el que se aplicaran ciertos cambios. Por ejemplo, existiría simetría C (de conjugación de carga) si no encontráramos diferencias en el universo al sustituir todas las partículas por sus correspondientes antipartículas. La simetría P, o de paridad, se daría en un universo que fuera equivalente a sí mismo si todo sucediera como reflejado en un espejo, con sustitución de la izquierda por la derecha y viceversa. Finalmente, en caso de que existiera simetría T (temporal), el universo seguiría pareciéndonos el mismo si se invirtiera la dirección del tiempo y evolucionara hacia el pasado. (La simetría T contradice claramente a la intuición, si bien ha de tenerse en cuenta que se ha planteado en un contexto de propiedades locales, microscópicas, y no tiene en cuenta parámetros de carácter global, macroscópico, como es la entropía, magnitud que marca la dirección de la flecha del tiempo.) El modelo estándar constata que, en su generalidad, estas simetrías están rotas en el universo actual. Es decir, se infringen. La inversión aislada en la dirección del tiempo, en la orientación derechaizquierda o en el signo de la carga eléctrica no produce universos equivalentes al nuestro. En cambio, las tres se cumplen de forma combinada. El modelo valida la simetría CPT, lo que hace plausible la existencia 14 de un universo especular formado por antipartículas que viajen hacia el pasado. Semejante entelequia resulta perfectamente válida desde el punto de vista de la física. En algunas disquisiciones sobre el modelo estándar se ha planteado una simetría adicional a las anteriores. Se trata de la supersimetría, que habla de la equivalencia entre partículas que sólo difieran en el valor de su espín. Más en concreto, la supersimetría establece una correspondencia entre bosones (partículas de espín entero) y fermiones (de espín fraccionario), para lo cual se inventa una nueva familia de supuestas partículas elementales bautizadas con los nombres de selectrón, squark (up, down, etc.), sneutrino, smuón, etc., además de las asociadas con las cuatro partículas mediadoras de las interacciones fundamentales: fotino, wino y zino (para los bosones W y Z), gluino y gravitino. Es decir, según esta hipótesis, a cada una de las partículas elementales de materia y mediadoras debería asociársele una supercompañera equivalente en todos los aspectos salvo en el valor del espín. El modelo estándar propone asimismo que la supersimetría está rota, se viola en la naturaleza, como resultado de lo cual las masas de las supercompañeras han de ser muy superiores a las de las partículas originales, del orden del teraelectrón-voltio. Históricamente, los aceleradores de partículas trabajaban lejos de este valor límite. Pero no sucede así con el LHC. Por sus altas energías operativas, este acelerador de partículas podría aportar una respuesta interesante a la cuestión de la supersimetría. La cara oscura Si se constatara en el laboratorio la existencia de partículas supersimétricas, dotadas de una masa muy elevada y hasta ahora indetectables para los aparatos experimentales, se avanzaría hacia la resolución de uno de los problemas pendientes, y más acuciantes, de la cosmología: la materia oscura. Según los datos observacionales obtenidos de los más modernos satélites de investigación, el universo está constituido aproximadamente por un 5% de materia ordinaria, la enclaustrada en los átomos que integran nuestra realidad cotidiana. El 95% restante es desconocido: un 23% es materia oscura; el 72% restante, energía oscura. Presumiblemente, la materia oscura estaría compuesta por partículas exóticas, nunca encontradas en los detectores y los experimentos. Como queda dicho, la familia de supercompañeras de las partículas ele- LHC: Gran Colisionador de Hadrones mentales podría orientar hacia una respuesta. Como también otras partículas hipotéticas muy masivas, denominadas genéricamente WIMP (en inglés, partículas masivas débilmente interactivas). El neutralino, cuya masa teórica multiplica por varios centenares la del protón, es una de las candidatas. Existen otras cuya masa-energía se encuentra al alcance de los experimentos del LHC. Los astrónomos aguardan expectantes los datos que aporte este acelerador para profundizar en el estudio de la materia oscura. La energía oscura representa un problema más espinoso. Se define como una especie de antigravedad causante de la expansión acelerada del universo. El descubrimiento de sus efectos, hace apenas unos años, ha auspiciado una profunda revolución en la astronomía y la cosmología y tal vez exija un replanteamiento radical de algunos de sus principios fundamentales. Como el campo de Higgs, la energía oscura parece impregnar todo el espacio-tiempo, de manera que algunos investigadores confían en lograr establecer, con ayuda del LHC, algún tipo de relación entre energía oscura, mecanismo de Higgs y supersimetría. Aun si fuera plausible, tal vinculación obligaría a un esfuerzo colectivo para mejorar, y ampliar, los desarrollos de las teorías en vigor. ¿Dimensiones ocultas? Un asunto que planea sobre algunos de los desarrollos teóricos más recientes de la física es la posibilidad de que vivamos inmersos en un universo con dimensiones insospechadas. Según la teoría de la relatividad de Einstein, el cosmos se despliega en un contexto de cuatro dimensiones, tres espaciales (altura, anchura y profundidad) y una temporal, que evolucionan en relación mutua indisoluble. Pero la imposibilidad de conciliar de un modo plenamente satisfactorio los hallazgos de esta teoría con los de la no menos exitosa mecánica cuántica ha inducido a varias generaciones de científicos a investigar nuevas hipótesis de unificación. Una de las más conocidas es la teoría de cuerdas. En esencia, esta teoría propone que las partículas elementales no son puntos, tal y como plantea el modelo estándar, sino filamentos vibrantes que se despliegan en una dimensión. La vibración de estos filamentos emite, como las cuerdas de un violín, distintos estados de excitación que se corresponden con las diferentes partículas elementales observadas en los experimentos. De este modo, de la oscilación de una cuerda en determinada frecuencia surgirá un electrón, pero si su frecuencia fuera otra el resultado podría ser, por ejemplo, un muón, un quark down, etc. En torno a esta idea fundacional se han construido intrincados sistemas físico-matemáticos que pretenden describir sólidamente las propiedades que aparecen en el modelo estándar. El acierto de la teoría de cuerdas ha residido en su capacidad para integrar en un sistema global los preceptos del modelo estándar, los principios cuánticos y la gravitación acorde con el enfoque original de Einstein. De ahí la intensa divulgación que la ha acompañado en los medios de comunicación, como promesa de futura teoría del todo. Sin embargo, los inconvenientes que se le asocian no son baladíes. Las predicciones de la teoría de cuerdas no han podido ser constatadas por el experimento y, de momento, no pasan de ser meras conjeturas indemostradas. Además, la consistencia matemática de sus desarrollos abstractos exige dos condiciones muy controvertidas: es imperativa la existencia de partículas supersimétricas y se ha de considerar que el espacio-tiempo está integrado en realidad por nueve (o diez, según las versiones) dimensiones espaciales más una temporal. Para dar verosimilitud a este modelo multidimensional, los defensores de la teoría de cuerdas exponen que las dimensiones adicionales son imperceptibles para nosotros y nuestros detectores porque están arrolladas en una longitud minúscula. En el inicio del universo, todas las dimensiones habrían estado igualmente confinadas; sin embargo, en los primeros instantes del big bang tres de las espaciales se desplegaron para conformar la estructura perceptible de espacio-tiempo, mientras que las restantes permanecieron férreamente compactadas. Es poco probable que los experimentos del LHC ofrezcan resultados claros sobre las dimensiones adicionales previstas por la teoría de cuerdas. No obstante, en los resultados de sus experimentos podrían asomar indicios que apuntaran en esta dirección y otorgaran mayor credibilidad a las predicciones de un esquema teórico tan altamente especulativo. à Las respuestas del LHC En una guía oficial resumida sobre el LHC (http://cdsmedia.cern.ch/img/CERN-Brochure-2009003-Eng.pdf), el CERN declara como objetivos principales del proyecto los siguientes: n Explicar el origen de la masa, con la atención dirigida a la convalidación del mecanismo de Higgs. 15 ACTA LHC: Gran Colisionador de Hadrones n Facilitar una descripción unificada de las fuerzas fundamentales, en un principio a través de la comprobación de la hipótesis de la supersimetría. n Buscar partículas o fenómenos hasta ahora des- conocidos que permitan profundizar en el conocimiento de la materia y la energía oscuras. n Investigar el misterio de la antimateria. n Indagar en la física de altísimas energías para emular las condiciones en que tuvo lugar el primer desarrollo del universo a partir de la Gran Explosión primigenia, en particular el estado de materia primordial bautizado con el nombre de plasma de quarks-gluones. Para lograr tales propósitos, el LHC, como todo acelerador de partículas, actúa como un inmenso tubo de vacío por el que circulan partículas guiadas y aceleradas por dispositivos electromagnéticos. Imanes de tipo dipolo (1.232 en total) dirigen los haces de partículas en órbitas casi circulares, mientras los cuadrupolos (392 imanes), sextupolos y demás sirven para enfocar dichos haces. Las partículas se aceleran en resonadores electromagnéticos denominados cavidades de radiofrecuencia (RF, ocho por haz), y después se aplica un procedimiento de compensación de pérdidas energéticas para mantener una energía de haz constante. Con este esquema, cada haz de protones circula por el túnel durante unas diez horas casi a la velocidad de la luz, con lo cual recorre una distancia equivalente a un viaje de ida y vuelta hasta el planeta Neptuno. Este entramado encuentra los puntos esenciales en la colección de seis grandes experimentos de detección instalados en el LHC. Sus siglas y nombres se recogen en la tabla 3. Los grandes detectores asociados a estos experimentos tienen como finalidad primordial identificar los subproductos de las colisiones, las partículas secundarias que se producen en las mismas. Tras su detección, han de medir la posición que ocupan en el espacio y Experimento el valor de sus propiedades, como velocidad, masaenergía y carga eléctrica. Este cometido obliga a dividir los detectores en una amplia colección de subdetectores en un sistema de capas de cebolla, auxiliados por imanes que separan unas partículas de otras en virtud de sus propiedades electromagnéticas. El objetivo declarado de dos de los grandes experimentos reseñados, ATLAS y CMS, es la búsqueda del bosón de Higgs y de las supuestas partículas supersimétricas, y de indicios que ayuden a ampliar y enriquecer el modelo estándar de partículas. El primero, el ATLAS, es una estructura cilíndrica de un peso equivalente al de la torre Eiffel en unas dimensiones bastante reducidas: 25 m de altura por 46 m de longitud. Está provisto de un inmenso sistema toroidal de imanes. Más de 1.900 científicos e ingenieros de centenar y medio de institutos distribuidos por una treintena de países se encargan de su control y manejo en colaboración. El CMS persigue, en esencia, los mismos fines científicos que el ATLAS aunque a través de un diseño técnico sustancialmente diferente. En cierto sentido, ATLAS y CMS son redundantes, si bien su trabajo coordinado permitirá dotar a los resultados de la investigación de un grado de fiabilidad muy elevado. Una dotación de unas dos mil personas supervisa el funcionamiento del sistema y extrae y analiza las informaciones más relevantes. LHCb y ALICE son los otros dos grandes módulos experimentales del LHC. El primero está especializado en indagar en los matices de las partículas del modelo estándar que podrían arrojar cierta luz sobre las ligeras asimetrías observadas entre creación de materia y antimateria en ciertas interacciones de laboratorio relacionadas con los quarks down. Tal vez en estas asimetrías se esconda el secreto de la aniquilación total de la antimateria y de la formación de un universo sólo de materia. En el detector ALICE se induce otro tipo de colisión conceptualmente diferente, el que tiene lugar tras Significado ALICE A Large Ion Collider Experiment (gran experimento colisionador de iones) ATLAS Aparato toroidal CMS Compact Muon Solenoid (solenoide de muones compacto) LHCb Large Hadron Collider beauty LHCf Large Hadron Collider forward TOTEM Total Elastic and diffractive cross-section measurement (medida en sección transversal difractiva y elástica total) Tabla 3. Los seis grandes experimentos del LHC. 16 LHC: Gran Colisionador de Hadrones la aceleración de iones de plomo hasta una energía cercana a los 600 TeV. La finalidad del experimento es recrear las condiciones que, supuestamente, dominaron en los primeros instantes del universo, y estudiar el magma primordial constituido por un plasma de quarks y gluones sometidos a un entorno de densidades y temperaturas extraordinariamente altas. El detector ALICE se ha hecho merecedor al nombre que se le atribuye de forma coloquial: máquina del big bang. Los dos últimos experimentos son de menor envergadura. El LHCf sirve para el estudio de haces de partículas que emulan los rayos cósmicos de altas energías, mientras que el experimento TOTEM está destinado a analizar propiedades especiales de los haces de hadrones producidos en el acelerador. Este breve repaso a los experimentos y dimensiones del LHC permite hacerse una idea de la enorme magnitud de la empresa científica. La cantidad de datos en bruto medidos en los detectores necesitaría, para su almacenamiento, unos diez mil DVD de doble capa por cada segundo. Evidentemente, es impensable un almacenamiento físico de estos datos. Su estudio y tratamiento se lleva a cabo en una extensa red de instituciones distribuida por todo el mundo y dotada de ordenadores de cómputo de máximas prestaciones. à Riesgos y beneficios En algunos foros se han planteado cuestiones relativas a la seguridad de los experimentos realizados en el ámbito del LHC. Innegablemente, este acelerador emite una radiación potencialmente peligrosa para la salud que es preciso confinar. No obstante, las dimensiones del LHC no añaden un riesgo significativamente mayor en este sentido al de otros aceleradores de partículas más convencionales o incluso al de las centrales nucleares. La ubicación subterránea de los dispositivos de aceleración y del túnel por el que transitan las partículas favorece el filtro natural para las radiaciones. Se han previsto sistemas estrictos de control de los índices de radiactividad que cumplen con las normativas internacionales al respecto. Es de esperar que todos estos mecanismos funcionen de la forma prevista. Los valores de energía de las colisiones que se alcanzarán en el acelerador a pleno rendimiento constituyen otro motivo de preocupación. Cierto es que valores de esta índole se alcanzarán por primera vez en los experimentos de laboratorio, pero las ener- gías manejadas no nos son en modo alguno desconocidas. Desde su formación hace 4.500 millones de años, la Tierra ha sufrido el continuo bombardeo de partículas de rayos cósmicos de altísima energía originarias de fenómenos turbulentos como son las supernovas o los agujeros negros. La llegada a la Tierra de los rayos cósmicos, muy superior en volumen a las radiaciones que puedan producirse en el seno del LHC, no ha dado lugar en el pasado a ninguna consecuencia devastadora para el planeta y para sus habitantes. Algo semejante puede decirse de la posibilidad de que durante los experimentos del LHC puedan formarse miniagujeros negros como subproducto de las altas concentraciones de energía. En este contexto, se han presentado incluso demandas judiciales contra el CERN y sus socios en el proyecto para intentar frenar la entrada en funcionamiento del acelerador. Según los temores expresados por los demandantes, habría una posibilidad no nula de que alguno de estos miniagujeros engullera el planeta y provocara un cataclísmico fin del mundo. Los científicos sostienen que tal riesgo es virtualmente inexistente. De nuevo viene al caso el ejemplo de los rayos cósmicos. Estas radiaciones de fuentes astronómicas llegan a la Tierra con energías superiores a las que se alcanzarán en el LHC, por lo cual tienen capacidad para engendrar miniagujeros negros. Sin embargo, en la historia del planeta no se ha constatado, evidentemente, ningún efecto relacionado con este fenómeno. Con argumentos semejantes se ha rebatido la idea de que la creación de partículas extrañas (por ejemplo, en el ámbito de la supersimetría) pudiera producir algún efecto catastrófico. En sentido contrario, los patrocinadores y los responsables de los equipos científicos proclaman la importancia del proyecto LHC para propiciar un avance no sólo de la ciencia y el conocimiento, sino de la sociedad en su conjunto. Con ello pretenden acallar algunas voces que critican no ya los riesgos hipotéticos ligados al acelerador, sino la ingente inversión económica que ha acaparado. Entre los disidentes hay quienes lamentan que estos fondos no se destinen a otros muchos campos de investigación que pugnan por abrirse camino en el competitivo mundo de los proyectos científicos y que se encuentran escasos de financiación. La ciencia básica, exponen los responsables del LHC en su defensa, ha sido siempre un impulsor decisivo en el avance tecnológico y el bienestar social. Un ejemplo muy evidente de esta afirmación tiene que ver con los desarrollos de la mecánica cuántica. 17 ACTA LHC: Gran Colisionador de Hadrones Esta disciplina nació de un impulso básicamente intelectual, no de una necesidad tecnológica, y se desarrolló durante décadas inmersa en un dominio de alta complejidad teórica y matemática alejada de las fábricas y de los hogares. Sin embargo, la lista de innovaciones tecnológicas obtenidas a partir de sus propuestas teóricas demuestra la influencia que la cuántica ha ejercido en todos los ámbitos de la vida moderna. La explicación del ferromagnetismo, los láseres, la superconductividad, la superfluidez o los cristales líquidos emana directamente de sus conclusiones. Transistores, microchips y ordenadores no habrían podido desarrollarse sin sus enseñanzas. Como tampoco los paneles solares, los microscopios electrónicos o los equipos médicos de resonancia magnética nuclear, por citar sólo algunos ejemplos. Tanto la resonancia magnética como la tomografía por emisión de positrones (TEP) de uso médico son igualmente deudoras de las tecnologías desarrolladas en aceleradores de partículas para fines científicos. Como orientación, sirva una cifra: en la actualidad, en el mundo existen unos 17.000 aceleradores de partículas en funcionamiento; más de la mitad se destinan a la medicina, y apenas un centenar sirven a proyectos de investigación en ciencia básica. Esta digresión pone el acento únicamente en la punta del iceberg de los beneficios directos que se derivan de la investigación científica. A ellos se añaden otros muchos pluses intangibles que cooperan 18 para surtir de mejoras globales a la sociedad. La plétora de científicos e ingenieros que trabajan en el LHC y sus proyectos asociados constituye una rica fuente de talento y formación. Muchos de ellos continuarán su labor investigadora. Otros emprenderán posteriormente carreras profesionales en otros campos a los que trasladarán el know-how adquirido, desde la enseñanza hasta la banca o los negocios. Naturalmente, los adelantos en ingeniería de diseño, en fabricación y en telecomunicaciones son valores añadidos a la rentabilidad del LHC. La complejidad y exigencia de los componentes del acelerador impone a las empresas industriales colaboradoras un nivel de calidad óptimo, y al hacerlo les dota de un activo muy rentable. Estas empresas, y su personal, adquirirán así aptitudes que les permitirán participar en proyectos de alta tecnología de muy diverso rango. Finalmente, con su compleja arquitectura y funcionalidades, la red de ordenadores y centros de cálculo necesaria para el procesamiento de los datos obtenidos por los detectores no se limita en exclusiva a las actividades del LHC. Al contrario, compone un elemento muy interesante para los desarrollos de la comunidad científica y académica en su conjunto. No debe olvidarse que un invento tan laureado como la World Wide Web fue concebido en las entrañas del CERN, inicialmente para la compartición de hallazgos entre equipos científicos. Acaso la estructura de la red ligada al nuevo superacelerador, coloquialmente conocida como Grid, llegue a aportar en un futuro ventajas comparables para la sociedad del conocimiento.