Introducción a la Informática

Anuncio

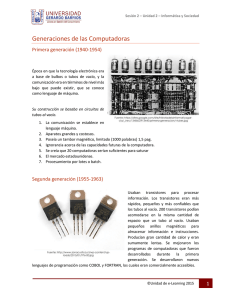

INTRODUCCION A LA INFORMATICA GENERALIDADES Según el diccionario de la Real Academia Española informática es el "conjunto de conocimientos científicos y técnicas que hacen posible el tratamiento automático de la información por medio de computadoras". La definición que propone la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (UNESCO, por sus siglas en inglés) es mucho más amplia, al referirse a la informática como la ciencia que tiene que ver con los sistemas de procesamiento de información y sus implicaciones económicas, políticas y socioculturales. El término informática proviene del francés "informatique", que a su vez se deriva de la contracción de dos palabras: "INFORmación" y "autoMATICA", y se define como el conjunto de disciplinas y técnicas que se encargan del tratamiento automático de la información. . El concepto de información es muy reciente y además sumamente sencillo. Fue desarrollado en la década de los 40`s por el matemático Claude Shannon, para referirse a todo aquello que está presente en un emisor o señal cuando se establece un proceso de comunicación entre el emisor y el receptor. HISTORIA DE LA COMPUTACION Aunque era capaz de realizar 5.000 sumas y 360 multiplicaciones por segundo, su programación resultaba tediosa. INTRODUCCION A LA INFORMATICA 2 fue la ENIAC, creada a mediados de 1940. Se utilizó para fines científicos: como la predicción climática, cálculos de energía atómica y estudios de rayos cósmicos. Se usaron cientos de tubos al vacío para almacenar información y programar las instrucciones. Hace un siglo John Ambrose Fleming inventó el tubo de vacío, la "lámpara" que hizo funcionar radios y televisores (y computadoras) durante décadas. Cuando en 1948 se inventó el transistor, se reemplazaron los cientos de tubos al vacío; lo que produjo una mayor velocidad de procesamiento y menor costo de fabricación. A fines de 1950 se crearon los circuitos integrados (circuitos electrónicos en miniatura sobre pequeñas pastillas de silicio) y se reemplazaron cientos de transistores. Los microchips aumentaron más aún la velocidad, confiabilidad y densidad de las computadoras. La mayoría de los circuitos integrados son pequeños trozos, o chips, de silicio, de entre 2 y 4 mm2, sobre los que se fabrican los transistores. La fotolitografía permite al diseñador crear centenares de miles de transistores en un solo chip situando de forma adecuada las numerosas regiones tipo n y p. Durante la fabricación, estas regiones son interconectadas mediante conductores minúsculos, a fin de producir circuitos especializados complejos. El invento del primer microprocesador a comienzos de 1970, dio origen a una nueva generación de computadoras. Las microcomputadoras (conocidas como computadoras personales) se presentaron en 1975. 1971: Intel 4004. Nota: Fue el primer microprocesador comercial. Salió al mercado el 15 de noviembre de 1971. En 1977, Apple presentó su computadora Apple II por US$ 1,300. En el transcurso de los tres años siguientes, la mitad de las personas que tenía una computadora personal tenía un sistema Apple. En 1981 IBM presentó su PC, con un precio de venta de US$ 3,000 aproximadamente. Un equipo completo a color costaba US$ 6,000. El lenguaje de programación BASIC se distribuyó con las computadoras que se vendían en esos momentos. INTRODUCCION A LA INFORMATICA 3