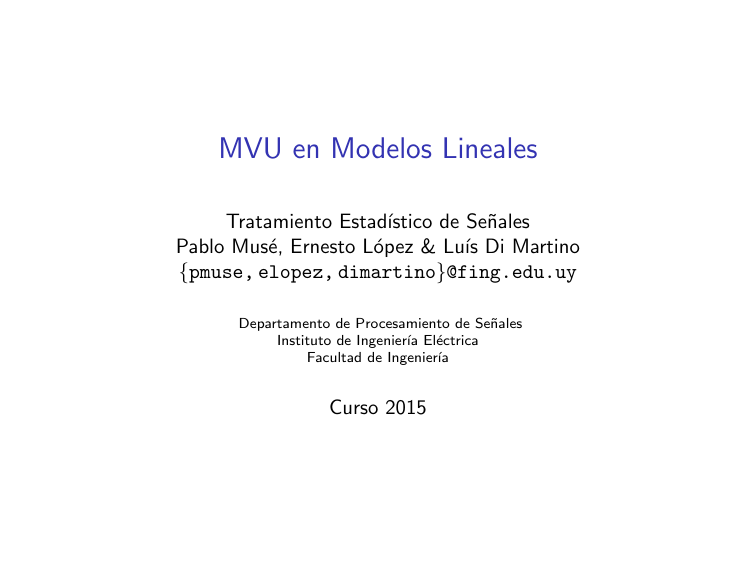

MVU en Modelos Lineales

Anuncio

MVU en Modelos Lineales

Tratamiento Estadı́stico de Señales

Pablo Musé, Ernesto López & Luı́s Di Martino

{pmuse, elopez, dimartino}@fing.edu.uy

Departamento de Procesamiento de Señales

Instituto de Ingenierı́a Eléctrica

Facultad de Ingenierı́a

Curso 2015

Repaso

Cota inferior de Cramer-Rao

◮

La varianza de todo estimador insesgado no puede ser menor que el

inverso de la información de Fisher,

◮

1

=

I(θ)

1

∂ 2 ln p(x; θ)

−E

∂θ2

Un estimador insesgado que alcanza la cota se dice eficiente.

var(θ̂) ≥

◮

En ese caso, es el estimador de varianza mı́nima entre todos los

estimadores insesgados (MVU).

◮

Además, su error cuadrático medio también es mı́nimo entre todos los

estimadores insesgados existentes.

Cálculo del estimador

◮

Existe un estimador que alcanza la cota para todo θ si y solo si

∂ ln p(x; θ)

= I(θ)(g(x) − θ)

∂θ

◮

para alguna función I y g

Este estimador, que es el MVU, es θ̂ = g(x) y su varianza es

1

.

I(θ)

(1)

Introducción

Estimación MVU

◮

En muchas situaciones, no es posible encontrar el estimador MVU

con la técnica de Cramer-Rao.

◮

◮

◮

Ejemplo: estimación de la fase de una sinusoide (ejemplo III, en

CRLB).

Como alternativa, es posible emplear la técnica de estadı́sticos

suficientes: tampoco asegura encontrar el estimador MVU.

En muchos problemas el estimador MVU existe, pero ninguna

técnica sirve para encontrarlo.

Modelos lineales

◮

El estimador MVU siempre se puede determinar si los datos pueden

representarse con un modelo lineal,

x = Hθ + w

Ejemplo

Ajuste de recta

◮

Se considera el problema de ajustar una recta a partir de datos

contaminados con WGN,

x[n] = A + Bn + w[n]

◮

con

n = 0, 1, . . . , N − 1,

donde w[n] ∼ N (0, σ 2 ) para todo n y se quiere estimar la pendiente

B y la intersección A.

El modelo, expresado en notación matricial es

x = Hθ + w

x = [x[0] x[1] . . . x[N − 1]]

T

w = [w[0] w[1] . . . w[N − 1]]

θ = [A B]

◮

T

T

H=

1

1

..

.

0

1

..

.

1

N −1

El problema de estimación del nivel de DC en WGN también es un

modelo lineal.

Definición y propiedades

Definición

◮

◮

x = Hθ + w

◮

x: datos observados. Vector columna de largo N .

H: matriz de observación, conocida. Dimensión

N × p, con p la cantidad de parámetros

desconocidos.

En la definición del modelo lineal el ruido se

asume gaussiano, w ∼ N (0, σ 2 I)

Propiedad

◮

◮

Siempre es posible encontrar el estimador MVU eficiente en el caso

de modelos lineales.

Según el teorema de Cramer-Rao, hay que probar que para los

modelos lineales siempre se cumple la ecuación 1,

∂ ln p(x; θ)

= I(θ)(g(x) − θ) (2)

∂θ

para alguna función g : RN → Rp y

alguna matriz I p × p.

Definición y propiedades

CRLB en Modelos Lineales

◮

La función de verosimilitud es

N

−1

Y

1 2

√

p(w) =

exp − 2 w [n]

2σ

2πσ 2

n=0

#

"

N −1

1

1 X 2

w [n]

=

− 2

N exp

2σ n=0

(2πσ 2 ) 2

1

1 T

w

w

.

=

exp

−

N

2σ 2

(2πσ 2 ) 2

p(x; θ) =

◮

1

1

N

(2πσ 2 ) 2

1

exp − 2 (x − Hθ)T (x − Hθ)

2σ

Tomando el logaritmo queda,

N

ln p(x; θ) = − ln(2πσ 2 ) 2 −

1

(x − Hθ)T (x − Hθ)

2σ 2

Definición y propiedades

CRLB en Modelos Lineales

◮

Derivando respecto al parámetro desconocido,

∂

1

∂ ln p(x; θ)

2 N

T

2

− ln(2πσ ) − 2 (x − Hθ) (x − Hθ)

=

∂θ

∂θ

2σ

1 ∂ T

T

x x − 2 |xT{zH} θ + θ T H

=− 2

| {zH} θ .

2σ ∂θ

bT

◮

Usando que

que

A

∂θ T Aθ (a)

∂bT θ

= 2Aθ (ver pag. 24) se tiene

=by

∂θ

∂θ

∂ ln p(x; θ)

1 = − 2 −2HT x + 2HT Hθ

∂θ

2σ

1 T

= 2 H x − HT Hθ

σ

h

i

T

−1 T

(b) H H

=

HT H

H x−θ .

2

σ

(a) A simétrica.

(b) HT H invertible.

Definición y propiedades

CRLB en Modelos Lineales

◮

El modelo cumple la condición del teorema de Cramer-Rao dado por

la ecuación 2,

HT H T −1 T

∂ ln p(x; θ)

H x −θ .

=

H H

2

∂θ

{z

}

| σ{z } |

I(θ)

Estimador MVU

−1 T

θ̂ = g(x) = HT H

H x

g(x)

Matriz de Covarianza

−1

Cθ̂ = I−1 (θ) = σ 2 HT H

◮

Además, el estimador θ̂ es eficiente.

◮

El problema es equivalente al problema de mı́nimos cuadrados lineal.

Definición y propiedades

Teorema: Estimador MVU en modelos lineales

Hipótesis:

◮

Los datos observados pueden

ser modelados como

◮

◮

x = Hθ + w

(3)

◮

x: N × 1 vector de observaciones

H: N × p matriz de observación

conocida, con N > p y rango p

θ: p × 1 vector de parámetros a

estimar

w: N × 1 vector de ruido con

PDF N (0, σ 2 I)

Tésis:

El estimador MVU es

−1 T

θ̂ = HT H

H x

(4)

La matriz de covarianza del

estimador es

−1

Cθ̂ = σ 2 HT H

(5)

Además, el estimador es eficiente ya que alcanza la CRLB para todo θ.

Definición y propiedades

Teorema: Estimador MVU en modelos lineales

◮

El estimador es insesgado,

−1 T

θ̂ = H H

H x

(a)

−1

= HT H

HT (Hθ + w)

−1

= θ + HT H

HT w

T

−1 T E(θ̂) = E θ + HT H

H w

−1 T

= θ + HT H

H E(w)

(b)

=θ

donde en (a) se sustituyó el modelo (ec. 3) y en (b) se tuvo en

cuenta que el ruido es de media nula, E(w) = 0.

◮

Además, como θ̂ es una tranformación lineal del vector Gaussiano x

su PDF está completamente especificada,

θ̂ ∼ N (θ, σ 2 (HT H)−1 )

Esto implica que su desempeño como estimador está completamente

especificado.

Ejemplo I: Análisis de Fourier

Modelo

◮

◮

Muchas señales tienen un comportamiento periódico

La presencia de componentes sinusoidales puede ser detectada

mediante el análisis de Fourier

◮

◮

Grandes coeficientes indican la presencia de fuertes componentes

sinusoidales.

Se considera como modelo la superposición de sinusoides en AWGN,

x[n] =

M

X

k=1

◮

◮

◮

αk cos

2πkn

+ ϕk

N

+ w[n]

n = 0, 1, . . . , N − 1

Las amplitudes y las fases son desconocidas

Las frecuencias se encuentran en relación armónica con frecuencia

fundamental f1 = 1/N (frecuencia normalizada)

¿Es lineal?

αk cos (2πfk n + ϕk ) = αk cos ϕk cos (2πfk n) −αk sin ϕk sin (2πfk n)

| {z }

| {z }

ak

bk

Ejemplo I: Análisis de Fourier

Modelo

El modelo es

◮

x[n] =

M

X

ak cos

k=1

2πkn

N

+

M

X

bk sin

k=1

θ = [a1 a2 . . . aM b1 b2 . . . bM ]

H=

1

cos

cos

◮

+ w[n],

donde las amplitudes ak y bk son desconocidas.

El modelo expresado de esta forma es lineal, x = Hθ + w, con

◮

2πkn

N

..

.

...

...

..

.

2π

N

2π(N −1)

N

...

1

cos

cos

0

2πM

..

.

T

sin

N

2πM (N −1)

N

sin

..

.

...

...

..

.

2π

N

2π(N −1)

N

...

0

sin

2πM

..

.

sin

θ es de dimensión 2M × 1 y H es de dimensión N × 2M .

N

2πM (N −1)

N

Ejemplo I: Análisis de Fourier

Determinación del MVU

◮

◮

−1 T

El estimador MVU es θ̂ = HT H

H x.

Los cálculos se simplifican notando que las columnas de H son

ortogonales. Si se representa H en columnas,

H = [h1 h2 . . . h2M ] ,

donde hi es la columna i-ésima de H, se cumple que

hTi hj = 0

para i 6= j

Esto implica que HT H es diagonal, haciéndola fácil de invertir,

T

T

h1 h1

hT1 h2 . . . hT1 h2M

h1

hT2 h1

hT2

hT2 h2 . . . hT2 h2M

HT H = . [h1 h2 . . . h2M ] =

..

..

..

..

..

.

.

.

.

hT2M h1 hT2M h2 . . . hT2M h2M

hT2M

◮

Ejemplo I: Análisis de Fourier

Determinación del MVU

◮

Ortogonalidad de las columnas

N

−1

X

2πin

N

cos

2πjn

N

=

N

δij

2

sin

2πin

N

sin

2πjn

N

=

N

δij

2

cos

2πin

N

sin

2πjn

N

=0

cos

n=0

N

−1

X

n=0

N

−1

X

n=0

◮

A partir de esta propiedad,

N

2

HT H =

0

..

.

0

0

N

2

..

.

0

(ver pag 25)

∀i, j

...

...

..

.

0

0

..

.

...

N

2

N

= I

2

Ejemplo I: Análisis de Fourier

Determinación del MVU

◮

El estimador MVU queda entonces

−1 T

2

2

θ̂ = HT H

H x = IHT x =

N

N

◮

Finalmente

N −1

2πkn

2 X

x[n] cos

N n=0

N

N −1

2 X

2πkn

b̂k =

x[n] sin

N n=0

N

âk =

◮

La matriz de covarianza es

Cθ̂ = σ

2

−1

2σ 2

H H

=

I

N

T

hT1

hT2

..

.

hT2M

x =

2 T

N h1 x

2 T

N h2 x

..

.

2 T

N h2M x

âk y b̂k son los

coeficientes de

Fourier de x[n]

Como la matriz de covarianza es

diagonal, los estimadores son

independientes

Modelo lineal general

Modelo lineal con ruido gaussiano coloreado

x = Hθ + w,

◮

w ∼ N (0, C)

◮

◮

El ruido es coloreado: las muestras no son

independientes.

C no es una matriz identidad escalada.

Para encontrar el estimador MVU, se puede proceder de forma

análoga al caso con ruido blanco.

◮

◮

En este caso, la pdf del ruido es normal multivariada

1

1

exp − wT C−1 w ,

p(w) = p

2

(2π)N |C|

La pdf paramétrica de los datos es

1

1

T

−1

exp − (x − Hθ) C (x − Hθ) .

p(x; θ) = p

2

(2π)N |C|

(6)

Modelo lineal general

Determinación del MVU usando enfoque de blanqueado

◮

C es una matriz de covarianza,

T

= E wwT ,

C = E (w − E(w)) (w − E(w))

por lo tanto es simétrica y definida positiva (ver apéndice en pag.

26).

◮

◮

Además, C−1 también es simétrica y definida positiva [Ejercicio].

Teorema de Descomposición de Cholesky

Si A es una matriz simétrica y definida positiva,

entonces ∃!L matriz triangular inferior con Lii > 0 ∀i tal que A = LT L

Modelo lineal general

Determinación del MVU usando enfoque de blanqueado

◮

Según el teorema de Cholesky, C−1 puede ser factorizada como

C−1 = DT D,

con D matriz invertible N × N.

La matriz D actúa como una transformación de blanqueado sobre el

ruido. El ruido transformado es no correlacionado.

C′ = E w′ w′T

= E (Dw)(Dw)T

= DE wwT DT

µ′ = E(w′ )

w′ = Dw

= DCDT

= DE(w)

◮

=0

= D(DT D)−1 DT

= DD−1 DT

=I

◮

Se concluye que

w′ = Dw ∼ N (0, I)

−1

DT

Modelo lineal general

Determinación del MVU usando enfoque de blanqueado

◮

Transformación del modelo lineal con la operación de blanqueado

x = Hθ + w

◮

x′ = Dx

= DHθ + Dw

◮

= H′ θ + w′

◮ H′ = DH

El estimador MVU y su matriz de covarianza son

−1

T

T

θ̂ = H′ H′

H′ x′

−1 T T

= HT DT DH

H D Dx

−1

= HT C−1 H

HT C−1 x

◮

Como w′ ∼ N (0, I), se

obtiene el modelo lineal usual

con WGN.

−1

T

Cθ̂ = H′ H′

−1

= HT C−1 H

Si C = σ 2 I se obtiene el resultado para el caso con WGN (ecs 4 y 5).

Ejercicio: demostrar que se obtiene el mismo resultado a partir de la derivada de la función de

verosimilitud (ecuación 6), como se hizo en el caso de WGN.

Ejemplo II

Nivel de DC en ruido coloreado

Como generalización del ejemplo anterior, en este caso se observan N

muestras del nivel de continua en ruido coloreado,

x[n] = A + w[n]

con

n = 0, 1, . . . , N − 1 y w ∼ N (0, C)

Se quiere determinar el MVU de A y su varianza.

◮ El modelo es lineal,

x = 1A + w,

◮

Empleando los resultados del modelo lineal con ruido coloreado, el

estimador MVU y la varianza son

−1 T −1

= HT C−1 H

H C x

=

◮

H = 1 = [1 1 . . . 1]T

1T C−1 x

1T C−1 1

−1

var(Â) = HT C−1 H

1

= T −1

1 C 1

En el caso en que el ruido es blanco y gaussiano, el MVU es la

media muestral con varianza σ 2 /N [Ejercicio].

Ejemplo II

Nivel de DC en ruido coloreado

◮

Interpretación. Considerando la factorización de C−1 como DT D,

=

N

−1

X

(D1)T x′

1T DT Dx

dn x′ [n],

=

=

1T DT D1

(D1)T (D1)

n=0

◮

◮

◮

con dn =

[D1]n

(D1)T (D1)

El estimador consiste en primero blanquear los datos y luego hacer

un promedio ponderado de los datos blanqueados.

El blanqueado tiene el efecto de decorrelacionar e igualar las

varianzas de las muestras de ruido.

Caso particular: muestras no correlacionadas pero de varianza

distinta

2

C = diag(σ02 , σ12 , . . . , σN

−1 )

NP

−1

x[n]

T −1

1 C x

σn2

= T −1 = n=0

N

−1

P 1

1 C 1

2

n=0 σn

◮

El estimador le da mas

importancia a las muestras

con ruido con menor varianza.

◮

¿Qué sucede si alguna muestra

tiene ruido con varianza nula?

Estimador MVU en el modelo lineal general

Teorema

Hipótesis:

◮

Los datos observados

pueden ser modelados

como

x = Hθ + s + w (7)

◮

x: N × 1 vector de observaciones

H: N × p matriz de observación conocida,

con N > p y rango p

◮

θ: p × 1 vector de parámetros a estimar

◮

s: N × 1 vector de muestras de señal conocida

◮

w: N × 1 vector de ruido con PDF N (0, C)

Tésis:

El estimador MVU es

−1 T −1

θ̂ = HT C−1 H

H C (x − s)

(8)

La matriz de covarianza

del estimador es

−1

Cθ̂ = HT C−1 H

(9)

Además, el estimador es eficiente ya que alcanza la CRLB para todo θ.

Ejemplo III

Nivel de DC y exponencial en ruido coloreado

Como un paso mas en la generalización, ahora las muestras observadas

son,

x[n] = A + rn + w[n]

con

n = 0, 1, . . . , N − 1 y w ∼ N (0, C)

donde r es conocido y se quiere determinar el MVU de A y su varianza.

◮

El modelo es,

x = 1A + s + w

y por lo tanto

H = 1 = [1 1 . . . 1]T

s = [1 r . . . rN −1 ]T

◮

El estimador y su varianza se obtiene sustituyendo H y s en las

ecuaciones 8 y 9.

Apéndice I

Derivadas de funciones básicas respecto a un vector

∂f (θ)

∂θ

1

∂f (θ)

..

=

.

∂θ

∂f (θ)

∂θp

∂bT θ

∂θ

Expansión de Taylor para funciones de varias

variables

∂f (θ)

∂θ

1 T ∂ 2 f (θ)

+ dθ

dθ + O(kdθk3 )

2

∂θ 2

f (θ + dθ) = f (θ) + dθ T

f (θ + dθ) = b (θ + dθ)

T

=b

θ +dθ T |{z}

b

|{z}

T

f (θ) = b θ

f (θ)

∂θ T Aθ

∂θ

f (θ) = θ T Aθ

∂bT θ

=b

∂θ

2

∂ f (θ)

=0

∂θ 2

T

∂f (θ)

∂θ

f (θ + dθ) = (θ + dθ)T A(θ + dθ)

= |θ T{z

Aθ} +dθ T |{z}

A dθ

2Aθ +dθ T |{z}

f (θ)

∂f (θ)

∂θ

1 ∂ 2 f (θ)

2 ∂θ 2

∂θ T Aθ

= 2Aθ

∂θ

∂ 2 θ T Aθ

= 2A

∂θ 2

Apéndice II

Ortogonalidad de la base de la DFT

N

−1

X

cos

n=0

N

−1

X

n=0

cos

2πkn

N

cos

2πM n

N

2πln

N

= Re

(a)

=

"N −1

X

N −1

N −1

2π(k + l)n

2π(k − l)n

1 X

1 X

cos

cos

+

2 n=0

N

2 n=0

N

exp

n=0

j2πM n

N

#

1 − ej2πM

= Re

1 − ej2πM/N

"

(b)

N −1 sin (πM )

ejπM − e−jπM

= Re ejπM N

jπM/N

jπM/N

e

e

− e−jπM/N

sin πM

N

πM (N − 1) sin (πM )

N si M = 0

= cos

=

0

si M ∈ N, M 6= 0

N

sin πM

N

= Re

N

−1

X

n=0

(a) cos ω1 cos ω2 =

1

2

ejπM

cos

2πkn

N

cos(ω1 + ω2 ) +

1

2

cos

2πln

N

cos(ω1 − ω2 )

=

N

δkl

2

(b)

PN −1

n=0

rn =

1−r N

1−r

#

Apéndice III

Propiedades de la matriz de covarianza

◮

◮

◮

Una matriz de covarianza C, con

T

C = E (w − E(w)) (w − E(w)) ,

es simétrica y semi-definida positiva.

Sin perder generalidad, se asume que w tiene media nula, y por lo

tanto

C = E wwT .

Para demostrar que C es semi-definida positiva, hay que demostrar

que ∀v 6= 0, vT Cv ≥ 0,

vT Cv = vT E wwT v

= E vT wwT v

= E vT w(vT w)T

= E |vT w|2

≥0

Referencias I

Kay, S. M. (1993).

Fundamentals of Statistical Signal Processing, Volume I: Estimation

Theory, chapter 4.

Prentice Hall, 1st edition.