estudios, notas, textos y comentarios el lenguaje de las ciencias

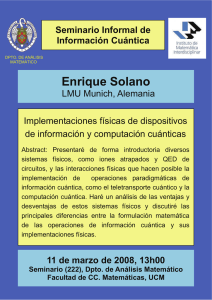

Anuncio