Revista Invenio Nº 13

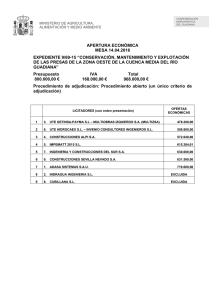

Anuncio