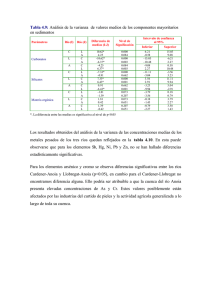

Notas de clase

Anuncio